/portcast%20logo%402x.15ef66a2fd613131199d6eececc53631c6564600.png)

Portcast scala i modelli di machine learning in mare utilizzando Amazon SageMaker

2021

Promuovere l'efficienza della catena di approvvigionamento con il Machine Learning (ML)

Il trasporto marittimo di merci è la principale modalità di trasporto per il commercio globale e rappresenta il 90% del volume degli scambi. La capacità di prevedere e pianificare l'arrivo delle merci nei porti determina notevolmente l'efficienza della catena di approvvigionamento, nonostante le perturbazioni meteorologiche, i ritardi doganali e altri fattori.

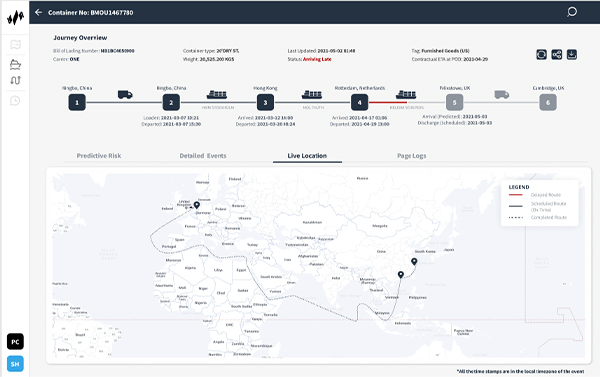

La startup Portcast, con sede a Singapore, offre un software-as-a-service (SaaS) predittivo per la supply chain attraverso la sua piattaforma di machine learning (ML), aiutando le compagnie di navigazione e i produttori a prevedere i tempi di arrivo delle merci nei porti. Portcast vuole ridurre il lavoro manuale e i costi di tracciamento dei container dei suoi clienti rispettivamente dell'80% e del 20%. I modelli di ML proprietari dell'azienda utilizzano i modelli storici dei movimenti di spedizioni e container e i dati in tempo reale, come le condizioni meteorologiche, il traffico portuale e la posizione delle navi, per migliorare l'efficienza della catena di approvvigionamento.

Con Amazon SageMaker, possiamo costruire una piattaforma scalabile a livello globale per la logistica predittiva con uno storage cloud e un calcolo dei dati efficienti".

Lingxiao Xia

Cofounder and CTO, Portcast

Isolare le previsioni ML per scalare in modo indipendente

Portcast utilizza una serie di servizi Amazon Web Services (AWS) per supportare l'infrastruttura sottostante e la capacità di eseguire modelli di ML su scala. Per archiviare i dati raccolti per l'elaborazione ML, utilizza Amazon Relational Database Service (Amazon RDS) e Amazon Simple Storage Service (Amazon S3). Utilizza anche Amazon Elasticsearch Service per i log di ricerca e l'analisi. "L'interazione tra i servizi su AWS è seamless, il che ci permette di sperimentare costantemente idee diverse", afferma Lingxiao Xia, cofondatore e chief technology officer di Portcast.

Fino al 2019, Portcast ha addestrato e distribuito i suoi modelli di ML utilizzando istanze bare metal di Amazon Elastic Compute Cloud (Amazon EC2) e cluster self-hosted. Questo approccio ha funzionato bene all'inizio, quando l'azienda seguiva poche centinaia di container alla volta. Tuttavia, con la crescita dell'azienda, scalare le previsioni di ML è diventato complesso e costoso, dato che ogni nave trasportava spesso fino a 20.000 container. Ad aumentare la complessità era la necessità di fornire previsioni di arrivo aggiornate due volte al giorno per container.

Con una configurazione bare-metal, Portcast ha dovuto scalare l'intera infrastruttura di ML, compresa l'elaborazione, le previsioni e gli endpoint, in modo collettivo, generando requisiti di memoria molto elevati. Portcast aveva bisogno di isolare l'aspetto predittivo dei suoi modelli ML per scalare in modo indipendente; ha risolto la sfida utilizzando Amazon SageMaker.

Esecuzione di processi in parallelo con memoria illimitata

Prima di scegliere Amazon SageMaker, Portcast ha richiesto una sessione di formazione pratica con i solution architect AWS. Il team che si occupa dei dati di Portcast ha utilizzato Amazon SageMaker per ottimizzare i carichi di lavoro ML separando la formazione del modello dalle previsioni e dall'elaborazione, iniziando con poche istanze che eseguono la formazione del modello ML. Ora Portcast utilizza Amazon SageMaker per accelerare l'automazione del ciclo di ML end-to-end, dalla formazione all'elaborazione fino alle previsioni.

"Togliendo le previsioni dal modello di ML e rendendole quindi un servizio separato, siamo in grado di scalare i modelli in modo indipendente e di ridurre i requisiti di memoria", spiega Xia.

In precedenza, Portcast era limitato dal numero di processi che poteva eseguire in parallelo, poiché ogni modello doveva essere caricato in memoria. "Con tutti i nostri modelli ospitati su Amazon SageMaker, possiamo eseguire centinaia di processi in parallelo senza limiti di memoria. Abbiamo il potenziale per generare milioni di previsioni al giorno", aggiunge Xia. Portcast sfrutta inoltre la funzione di endpoint multi-modello di Amazon SageMaker per ridurre i costi ospitando più modelli su ciascuna istanza, con un risparmio di almeno il 60% sull'implementazione del ML.

Accelerare l'implementazione e automatizzare il monitoraggio

Attualmente Portcast monitora decine di migliaia di container al giorno, una scala non tecnicamente possibile sull'infrastruttura precedente. "Con Amazon SageMaker, possiamo costruire una piattaforma scalabile a livello globale per la logistica predittiva con uno storage cloud e un calcolo dei dati efficienti" afferma Xia.

In qualità di servizio completamente gestito, Amazon SageMaker gestisce l'infrastruttura sottostante che forma ed esegue i modelli di ML, quindi Portcast deve solo determinare la configurazione iniziale. I modelli ML scalano automaticamente e Amazon CloudWatch invia avvisi quando vengono rilevate anomalie. Il team che si occupa di dati di Portcast dispone di un'interfaccia utente che consente un'elevata visibilità dei lavori di elaborazione e del loro stato senza interventi manuali. In questo modo il team risparmia almeno 2-3 ore a settimana, precedentemente dedicate al monitoraggio dell'infrastruttura.

Oltre al risparmio di tempo, Xia sottolinea il valore della riduzione del cambio di contesto. "Se i nostri data scientist devono passare dall'analisi dei modelli alle attività di monitoraggio, il costo del cambio di contesto è superiore al tempo dedicato a tale attività", spiega.

Migliorare i flussi di lavoro di data science e dello sviluppo

L'introduzione di Amazon SageMaker ha anche ridotto la dipendenza tra i team di Portcast che si occupano di data science e di sviluppo. Gli sviluppatori non devono più configurare l'infrastruttura prima che il team che si occupa di dati possa aggiornare i modelli di ML o aggiungere nuove funzionalità. I data scientist possono creare autonomamente l'infrastruttura necessaria per il loro lavoro all'interno di Amazon SageMaker.

Alcuni data scientist esperti in Amazon SageMaker sono diventati campioni interni. Suggeriscono o avviano regolarmente progetti per contribuire alla risoluzione di problemi comuni come i colli di bottiglia nell'elaborazione. Il team che si occupa di dati arricchisce inoltre attivamente la propria conoscenza di Amazon SageMaker attraverso sessioni mirate e discussioni con i solution architect AWS sulle strategie di ottimizzazione per scalare controllando i costi.

Scalare per supportare l'espansione

Nidhi Gupta, cofondatore e amministratore delegato di Portcast, ritiene che il meglio debba ancora venire per l'innovazione logistica. "I prossimi due anni rappresentano il punto di inflessione per il nostro settore e prevediamo una crescita di 10-20 volte nei prossimi mesi", afferma l'esperta. "Con Amazon SageMaker possiamo gestire più container sulla stessa piattaforma man mano che cresciamo. Questo ci permette di esplorare più opportunità di business, ottimizzando le nostre risorse e, in ultima analisi, migliorando i nostri profitti".

Ulteriori informazioni

Ulteriori informazioni su Machine Learning su AWS.

Informazioni su Portcast

Portcast offre una tecnologia di visibilità predittiva e di previsione della domanda per le aziende logistiche e i produttori. I clienti possono ridurre la pianificazione manuale fino all'80% e determinare con maggiore precisione la domanda di merci e i tempi di arrivo per controllare i costi.

Vantaggi di AWS

- Esegue centinaia di processi di ML in parallelo senza limiti di memoria

- Permette di risparmiare almeno 2-3 ore alla settimana per il monitoraggio dell'infrastruttura.

- Scala dal monitoraggio di centinaia a migliaia di container in 2 anni

- Riduce i costi di implementazione del ML di almeno il 60%.

- Riduce la dipendenza tra team di sviluppatori e team di data science

- Promuove una cultura del self-service per risolvere i colli di bottiglia interni.

Servizi AWS utilizzati

Amazon SageMaker

Amazon SageMaker aiuta sviluppatori e data scientist a preparare, creare, addestrare e implementare rapidamente modelli di machine learning (ML) di alta qualità combinando un’ampia gamma di funzionalità create ad hoc per il ML.

Amazon CloudWatch

Amazon CloudWatch è un servizio di monitoraggio e osservabilità creato per ingegneri, sviluppatori, ingegneri responsabili dell'affidabilità del sito (SRE) e manager IT DevOps.

Amazon Relational Database Service (RDS)

Amazon Relational Database Service (Amazon RDS) semplifica l'impostazione, il funzionamento e il dimensionamento di database relazionali nel cloud.

Amazon Elasticsearch Service

Amazon Elasticsearch Service è un servizio completamente gestito che semplifica distribuzione, protezione ed esecuzione di Elasticsearch con costi ridotti e su vasta scala.

Nozioni di base

Le aziende di tutte le taglie e di tutti i settori stanno trasformando ogni giorno la propria attività grazie ad AWS. Contatta i nostri esperti e inizia subito il tuo viaggio in AWS Cloud