Amazon SageMaker를 사용해야 하는 이유는 무엇인가요?

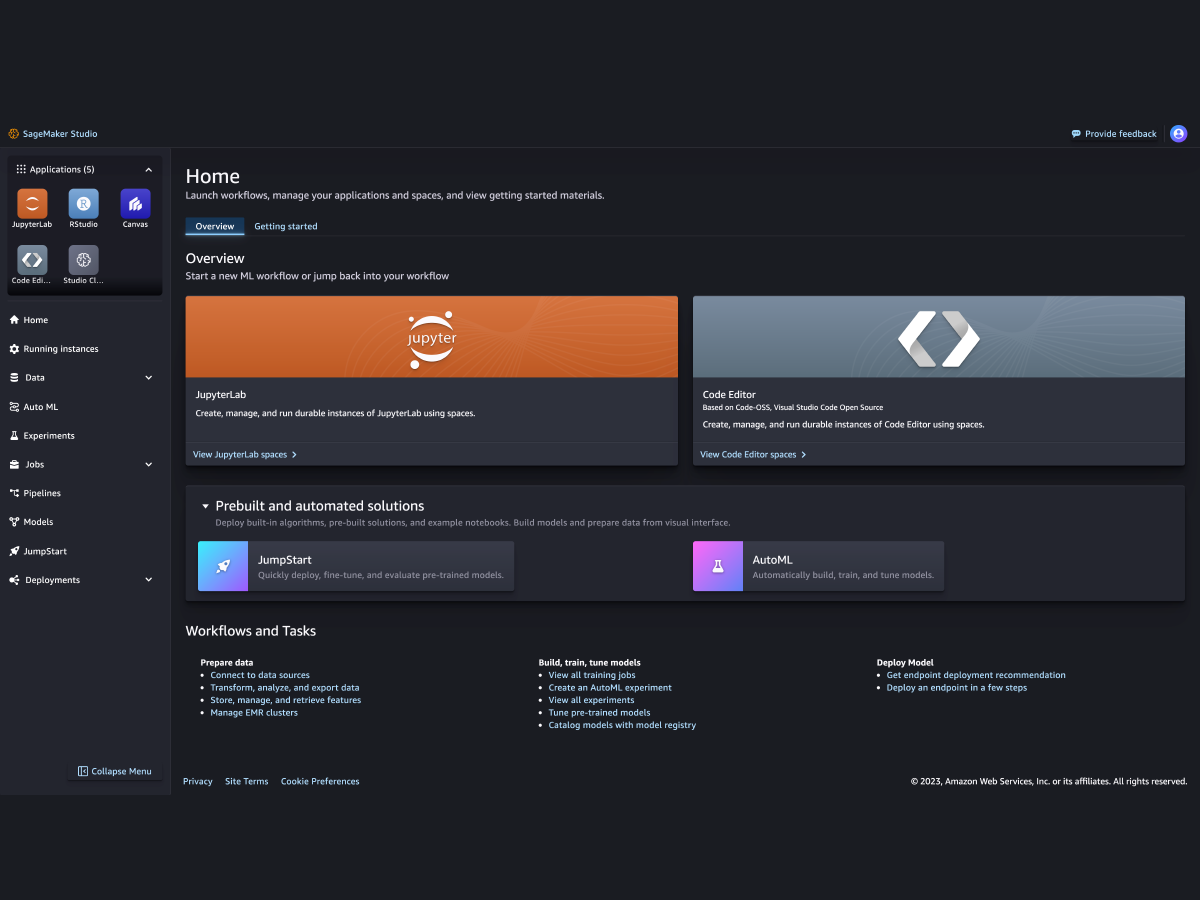

Amazon SageMaker는 모든 사용 사례에서 저비용 고성능 기계 학습(ML)을 지원하는 다양한 도구 세트를 한데 결합한 완전관리형 서비스입니다. SageMaker를 사용하면 단일 통합 개발 환경(IDE)에서 노트북, 디버거, 프로파일러, 파이프라인, MLOP 등의 도구를 사용하여 대규모로 ML 모델을 구축, 훈련 및 배포할 수 있습니다. SageMaker는 ML 프로젝트에 대한 간소화된 액세스 제어 및 투명성을 통해 거버넌스 요구 사항을 지원합니다. 또한 FM을 미세 조정, 실험, 재훈련 및 배포하는 목적별 도구를 사용하여 대규모 데이터 세트로 훈련된 대규모 모델인 자체 FM을 구축할 수 있습니다. SageMaker는 일반에 공개된 FM을 비롯하여, 클릭 몇 번으로 배포할 수 있는 수백 개의 사전 훈련된 모델에 대한 액세스를 제공합니다.

Amazon SageMaker를 사용해야 하는 이유는 무엇인가요?

Amazon SageMaker는 모든 사용 사례에서 저비용 고성능 기계 학습(ML)을 지원하는 다양한 도구 세트를 한데 결합한 완전관리형 서비스입니다. SageMaker를 사용하면 단일 통합 개발 환경(IDE)에서 노트북, 디버거, 프로파일러, 파이프라인, MLOP 등의 도구를 사용하여 대규모로 ML 모델을 구축, 훈련 및 배포할 수 있습니다. SageMaker는 ML 프로젝트에 대한 간소화된 액세스 제어 및 투명성을 통해 거버넌스 요구 사항을 지원합니다. 또한 FM을 미세 조정, 실험, 재훈련 및 배포하는 목적별 도구를 사용하여 대규모 데이터 세트로 훈련된 대규모 모델인 자체 FM을 구축할 수 있습니다. SageMaker는 일반에 공개된 FM을 비롯하여, 클릭 몇 번으로 배포할 수 있는 수백 개의 사전 훈련된 모델에 대한 액세스를 제공합니다.

SageMaker의 이점

더 많은 사람이 기계 학습을 통해 혁신할 수 있도록 지원

-

비즈니스 분석가

-

데이터 사이언티스트

-

기계 학습 엔지니어

-

비즈니스 분석가

-

-

데이터 사이언티스트

-

-

기계 학습 엔지니어

-

선도적인 기계 학습 프레임워크, 도구 키트 및 프로그래밍 언어 지원