MLflow가 포함된 Amazon SageMaker를 사용해야 하는 이유는 무엇인가요?

Amazon SageMaker는 기계 학습(ML) 및 생성형 AI 실험을 위한 관리형 MLflow 기능을 제공합니다. 이 기능을 통해 데이터 과학자는 SageMaker에서 MLflow를 모델 훈련, 등록, 배포에 쉽게 사용할 수 있습니다. 관리자는 AWS에서 안전하고 확장 가능한 MLflow 환경을 신속하게 설정할 수 있습니다. 데이터 과학자와 ML 개발자는 ML 실험을 효율적으로 추적하고 비즈니스 문제에 적합한 모델을 찾을 수 있습니다.

MLflow가 포함된 Amazon SageMaker의 이점

어디서나 실험을 추적

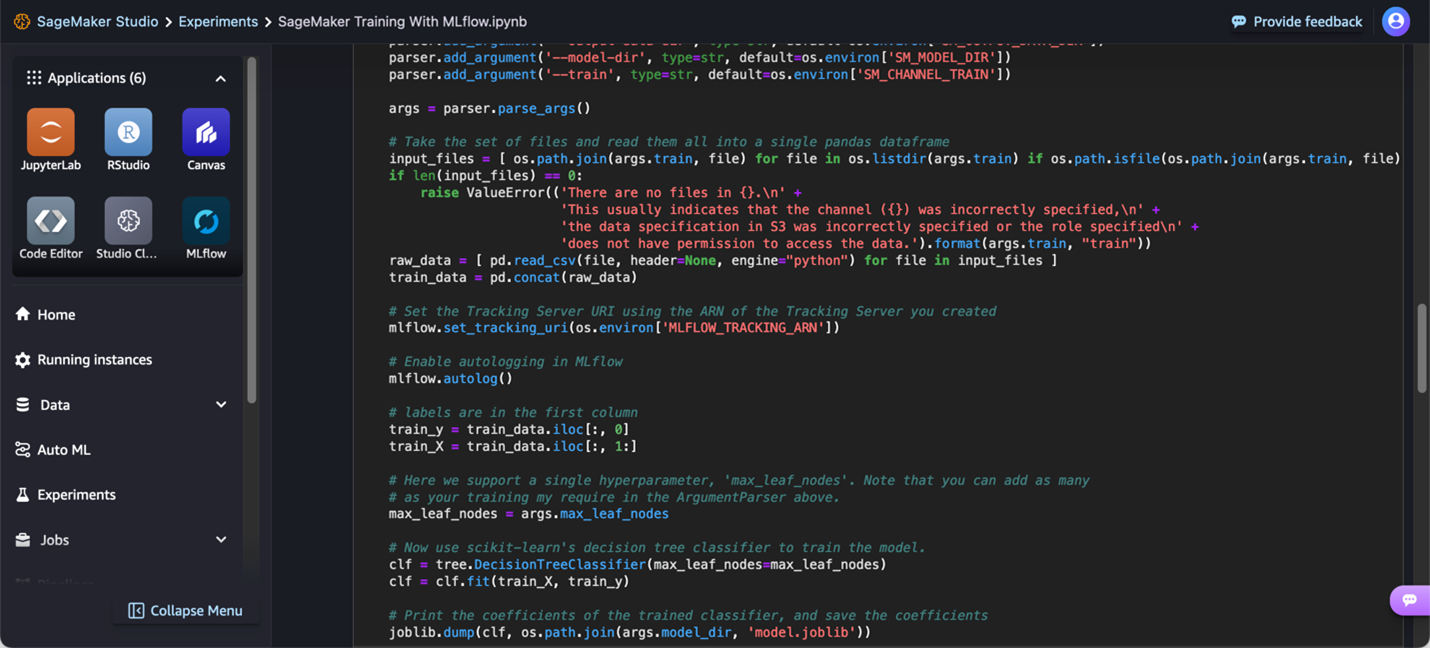

ML 실험은 로컬 노트북, IDE, 클라우드 기반 훈련 코드 또는 Amazon SageMaker Studio의 관리형 IDE 등 다양한 환경에서 수행됩니다. SageMaker와 MLflow를 사용하면 선호하는 환경을 사용하여 모델을 훈련하고, MLflow에서 실험을 추적하고, MLflow UI를 직접 또는 SageMaker Studio를 통해 실행하여 분석할 수 있습니다.

모델 실험을 위한 협업

효과적인 팀 협업은 성공적인 데이터 과학 프로젝트에 필수적입니다. SageMaker Studio를 사용하면 MLflow 추적 서버 및 실험을 관리하고 액세스할 수 있으므로 팀원이 정보를 공유할 수 있고 일관된 실험 결과를 보장하여 협업이 더 쉬워집니다.

실험 평가

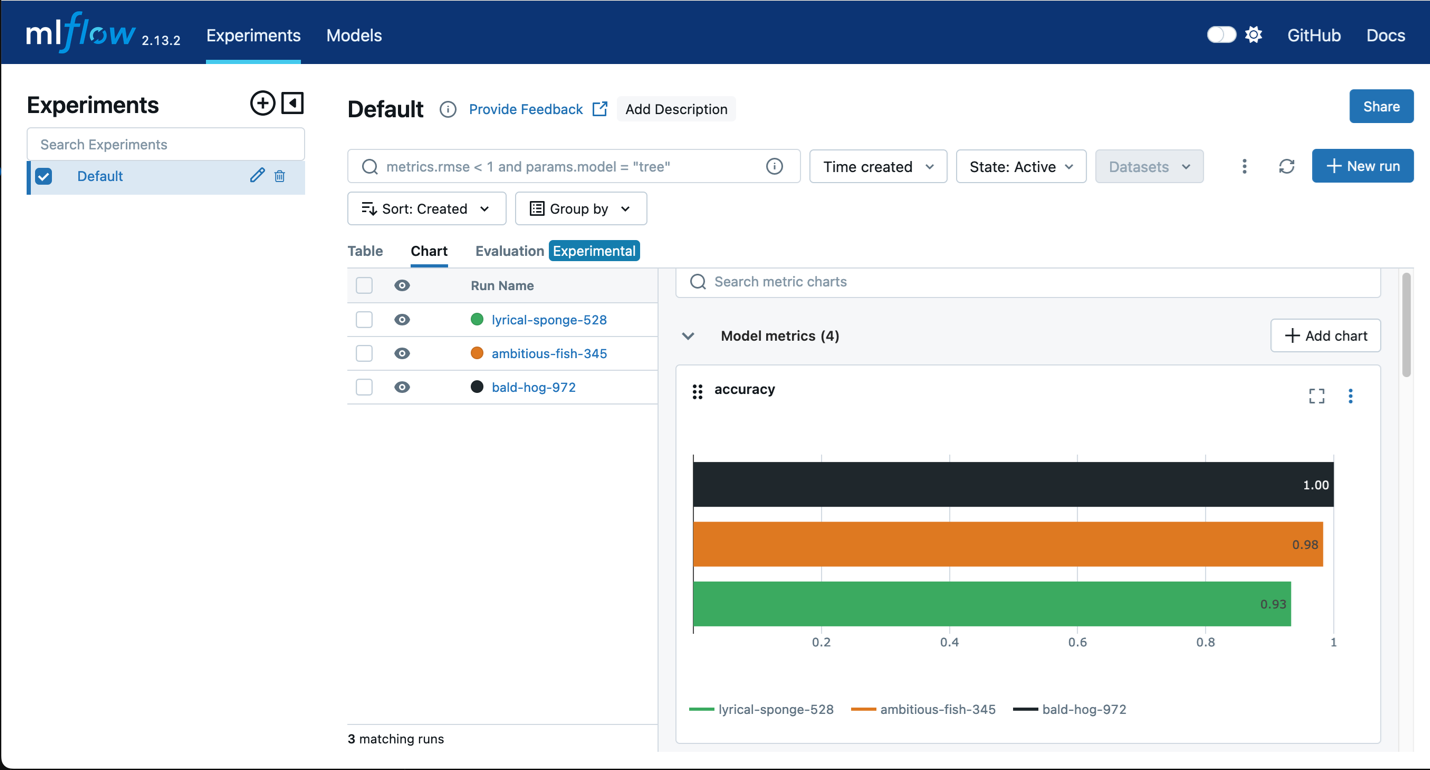

여러 번의 반복을 통해 최상의 모델을 식별하려면 모델 성능을 분석하고 비교해야 합니다. MLflow는 훈련 반복을 비교할 수 있도록 산점도, 막대 차트, 히스토그램과 같은 시각화를 제공합니다. 또한 MLflow를 사용하면 모델의 편향성과 공정성을 평가할 수 있습니다.

MLflow 모델을 중앙에서 관리

여러 팀이 MLflow를 사용하여 실험을 관리하는 경우가 많고 일부 모델만 프로덕션 후보가 됩니다. 조직은 어떤 모델을 프로덕션으로 진행할지 정보에 입각한 결정을 내리기 위해 모든 후보 모델을 추적할 수 있는 간편한 방법이 필요합니다. MLflow는 SageMaker 모델 레지스트리와 원활하게 통합되므로 조직은 MLflow에 등록된 모델이 SageMaker 모델 레지스트리에 거버넌스를 위한 SageMaker 모델 카드와 함께 자동으로 표시되는 것을 볼 수 있습니다. 이 통합을 통해 데이터 과학자와 ML 엔지니어는 각자의 작업에 고유한 도구를 사용할 수 있습니다. 즉, 실험에 MLflow를 사용하고 포괄적인 모델 계보를 통한 프로덕션 수명 주기 관리에 SageMaker 모델 레지스트리를 사용할 수 있습니다.

SageMaker 엔드포인트에 MLflow 모델 배포

모델을 MLflow에서 SageMaker 엔드포인트로 원활하게 배포할 수 있으므로 모델 스토리지용 사용자 지정 컨테이너를 구축할 필요가 없습니다. 이 통합을 통해 고객은 SageMaker의 최적화된 추론 컨테이너를 활용하면서 MLflow의 사용자 친화적인 모델 로깅 및 등록 환경을 유지할 수 있습니다.