Présentation de la mise en cache

La mise en cache aide les applications à fonctionner beaucoup plus rapidement et coûte bien moins chère à l’échelle

Qu'est-ce que la mise en cache ?

En informatique, un cache est une couche de stockage de données grande vitesse qui stocke un sous-ensemble de données, généralement transitoires, de sorte que les demandes futures pour ces données sont traitées le plus rapidement possible en accédant à l'emplacement de stockage principal des données. La mise en cache vous permet de réutiliser efficacement des données précédemment récupérées ou traitées.

Comment fonctionne la mise en cache ?

Les données mises en cache sont généralement stockées sur du matériel à accès rapide comme de la RAM (mémoire vive) et peuvent également être utilisées en corrélation avec un composant logiciel. L'objectif principal d'un cache est d'augmenter les performances de récupération des données en réduisant le besoin d'accès à la couche de stockage sous-jacente plus lente.

En délaissant la capacité au profit de la vitesse, un cache stocke généralement un sous-ensemble de données transitoires, contrairement aux bases de données dont les données sont généralement complètes et durables.

Présentation de la mise en cache

RAM et moteurs en mémoire : en raison des taux élevés de demande ou d'IOPS (opérations d'entrée/sortie par seconde) pris en charge par la RAM et les moteurs en mémoire, la mise en cache améliore les performances de récupération de données et réduit les coûts à l'échelle. Pour prendre en charge la même mise à l'échelle avec des bases de données classiques et du matériel sur disques, il faudrait des ressources supplémentaires. Ces ressources supplémentaires augmentent les coûts et ne parviennent jamais à atteindre les performances de faible latence affichées par un cache en mémoire.

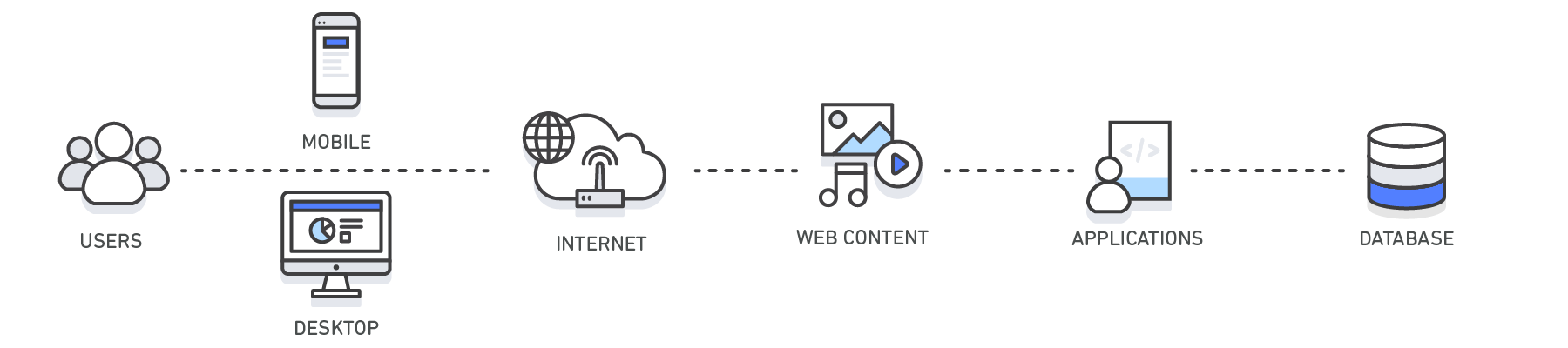

Applications : les caches peuvent s'appliquer et être exploités dans différentes couches de technologie, y compris les systèmes d'exploitation, les couches de mise en réseau dont les réseaux de diffusion de contenu (CDN) et les DNS, des applications Web et des bases de données. Vous pouvez utiliser la mise en cache pour réduire considérablement la latence et améliorer les IOPS pour de nombreuses charges de travail d'application exigeantes, comme les portails de questions-réponses, les jeux, le partage multimédia et les réseaux sociaux. Les informations mises en cache peuvent inclure les résultats d'interrogations de bases de données, les calculs exigeants, les requêtes/réponses d'API et les artéfacts Web tels que HTML, JavaScript, et les fichiers image. Les charges de travail exigeantes en puissance de calcul qui manipulent des ensembles de données, comme les moteurs de recommandation et les simulations de calcul haute performance, tirent également parti d'une couche de données en mémoire agissant comme un cache. Dans ces applications, de très grands ensembles de données doivent être accessibles en temps réel sur des clusters de machines pouvant s'étendre sur des centaines de nœuds. Du fait de la vitesse du matériel sous-jacent, la manipulation de ces données sur un disque de stockage est un goulot d'étranglement considérable pour ces applications.

Modèles de conception : dans un environnement informatique distribué, une couche de mise en cache dédiée permet aux systèmes et applications de s'exécuter de manière indépendante à partir du cache avec leurs propres cycles de vie sans le risque d'affecter le cache. Le cache sert de couche centrale pouvant être accessible à partir de systèmes hétérogènes avec sa propre topologie d'architecture et son cycle de vie. Cela est particulièrement pertinent dans un système où les nœuds d'application peuvent être dynamiquement mis à l'échelle. Si le cache réside sur le même nœud que l'application ou les systèmes l'utilisant, le dimensionnement peut affecter l'intégrité du cache. En outre, lorsque les caches locaux sont utilisés, ils ne profitent qu'à l'application locale consommant les données. Dans un environnement de mise en cache distribuée, les données peuvent être réparties sur plusieurs serveurs cache et être stockées dans un emplacement central pour que tous les consommateurs de ces données puissent en profiter.

Bonnes pratiques de mise en cache : lors de la mise en place d'une couche de cache, il est important de comprendre la validité des données mises en cache. Un cache réussi génère rapidement des résultats, ce qui signifie que les données étaient présentes lors de la récupération. Un cache manqué se produit lorsque les données récupérées n'étaient pas présentes dans le cache. Des contrôles, tels que les valeurs TTL (Time to Live), peuvent être appliqués pour entraîner l'expiration des données en conséquence. Une autre considération peut être de savoir si l'environnement de cache doit être hautement disponible, condition pouvant être remplie par des moteurs en mémoire comme Redis. Dans certains cas, une couche en mémoire peut être utilisée comme couche de stockage de données autonome, contrairement à la mise en cache des données à partir d'un emplacement principal. Dans ce scénario, il est important de définir un RTO (Recovery Time Objective), le temps nécessaire pour récupérer d'une panne, et un RPO (Recovery Point Objective), le dernier point ou la dernière transaction capturés dans la récupération, sur les données résidant dans le moteur en mémoire pour déterminer si elles sont adaptées. Les stratégies et caractéristiques personnalisées de différents moteurs en mémoire peuvent s'appliquer pour répondre à la plupart des exigences en matière de RTO et de RPO.

| Couche | Côté client | DNS | Web | Application | Base de données |

| Cas d'utilisation | Accélérer la récupération du contenu Web à partir de sites Web (navigateur ou appareil) |

Domaine pour résolution d'IP | Accélérer la récupération de contenu Web depuis des serveurs Web/d'application. Gérer les sessions Web (côté serveur) | Accélérer les performances d'application et l’accès aux données | Réduire la latence associée à des requêtes d'interrogation de base de données |

| Technologies | En-têtes de cache HTTP, navigateurs | Serveurs DNS | En-têtes de cache HTTP, CDN, proxys inversés, accélérateurs Web, magasins de clés/valeurs | Magasins de données de clés/valeurs, caches locaux | Mémoires tampons de bases de données, magasins de données de clés/valeurs |

| Solutions | Propre au navigateur | Amazon Route 53 | Amazon CloudFront, ElastiCache for Redis, ElastiCache for Memcached, Solutions de partenaires | Frameworks d'application, ElastiCache for Redis, ElastiCache for Memcached, Solutions de partenaires | ElastiCache for Redis, ElastiCache for Memcached |

Mise en cache avec Amazon ElastiCache

Amazon ElastiCache est un service Web qui facilite le déploiement, l'utilisation et la mise à l'échelle d'un magasin ou cache de données en mémoire dans le cloud. Ce service améliore les performances des applications Web en vous permettant de récupérer des informations depuis des magasins de données en mémoire gérés rapides, au lieu de vous en remettre entièrement à des bases de données sur disques, qui sont plus lentes. Découvrez comment mettre en place une stratégie de mise en cache efficace avec ce livre blanc technique sur la mise en cache en mémoire.

Avantages de la mise en cache

Amélioration des performances de l'application

Comme la mémoire est beaucoup plus véloce que le disque (magnétique ou SSD), la lecture des données à partir du cache en mémoire est extrêmement rapide (infra-milliseconde). Cet accès aux données significativement plus rapide améliore les performances globales de l'application.

Réduction des coûts de base de données

Une seule instance de cache peut fournir des centaines de milliers d'IOPS (opérations d'entrée/sortie par seconde), remplaçant potentiellement un certain nombre d'instances de base de données, ce qui permet de réduire le coût total. Cela est particulièrement important si la base de données primaire facture au débit. Dans ces cas, les économies pourraient s'élever à des dizaines de pour cent.

Réduction de la charge sur le backend

En redirigeant d'importantes parties de la charge de lecture de la base de données de backend vers la couche en mémoire, la mise en cache peut réduire la charge sur votre base de données et la protéger contre les baisses de performances sous charge, ou même contre le plantage pendant les périodes de pics.

Performances prévisibles

Un défi courant dans les applications modernes est la gestion des périodes de pics dans l'utilisation des applications. Parmi les exemples, on trouve des applications sociales pendant le Super Bowl ou le jour des élections, les sites Web d'e-commerce pendant le Black Friday, etc. Une augmentation de la charge sur la base de données génère des latences plus élevées pour obtenir les données, ce qui rend les performances d'application imprévisibles. En utilisant un débit élevé de cache en mémoire, ce problème peut être atténué.

Élimination des hotspots de base de données

Dans la plupart des applications, il est probable qu'un petit sous-ensemble de données, tel qu'un profil de célébrité ou un produit populaire, soit accessible plus fréquemment que d'autres. Cela peut provoquer des points chauds dans votre base de données et nécessiter un surprovisionnement de ressources de base de données en fonction des exigences en matière de débit pour les données les plus fréquemment utilisées. Le stockage de clés courantes dans un cache en mémoire diminue le besoin de surprovisionner tout en fournissant des performances élevées et prévisibles pour les données les plus fréquemment consultées.

Augmentation du débit de lecture (E/S par seconde)

En plus d'une latence plus faible, les systèmes en mémoire proposent également des taux de demande (IOPS) beaucoup plus élevés par rapport à une base de données basée sur disques comparable. Une instance unique utilisée comme côte cache distribué peut servir des centaines de milliers de requêtes par seconde.

Cas d'utilisation et secteurs

-

Cas d'utilisation

-

Secteurs

-

Cas d'utilisation

-

En savoir plus sur les différents cas d'utilisation de mise en cache

Mise en cache de base de données

Les performances de vitesse et de débit fournies par votre base de données peuvent constituer le facteur le plus important pour vos performances globales d’application. Et malgré qu’aujourd’hui de nombreuses bases de données délivrent de relativement bonnes performances, vos applications peuvent en nécessiter de meilleures dans beaucoup de cas d’utilisation. La mise en cache de base de données vous permet de considérablement augmenter votre débit et de réduire la latence de récupération des données associée aux bases de données backend. Résultat, cela améliore les performances globales de vos applications. Le cache agit comme une couche d'accès adjacente aux données pour votre base de données que vos applications peuvent utiliser pour accroître leurs performances. Une couche de cache de base de données peut être appliquée devant tout type de base de données, y compris relationnelle et NoSQL. Les techniques courantes utilisées pour charger des données dans votre cache incluent un mode de chargement progressif, ou « lazy loading », et des méthodes de double écriture. Pour en savoir plus, cliquez ici.

Réseau de diffusion de contenu (CDN)

Lorsque votre trafic Web est géographiquement dispersé, il n’est pas toujours possible et certainement pas économique de répliquer la totalité de votre infrastructure à travers le monde. Un CDN (Content Delivery Network) vous offre la possibilité d'utiliser son réseau mondial d'emplacements périphériques pour déployer une copie en cache du contenu Web comme des vidéos, des pages Web, des images et autres vers vos clients. Pour réduire le temps de réponse, le CDN utilise l'emplacement périphérique le plus proche du client ou de l'emplacement de la demande d'origine. Le débit augmente considérablement du fait que les ressources Web sont déployées à partir du cache. Pour les données dynamiques, un grand nombre de CDN peuvent être configurés pour récupérer les données depuis les serveurs d’origine.

Amazon CloudFront est un service de CDN mondial qui accélère la diffusion de vos sites Web, de vos API, de votre contenu vidéo et des autres ressources Web. Il s'intègre à d'autres solutions Amazon Web Services afin de permettre aux développeurs et aux entreprises de distribuer facilement et rapidement du contenu aux utilisateurs finaux sans aucun engagement minimum en matière d'utilisation. Pour en savoir plus au sujet des CDN, cliquez ici.

Mise en cache de système de noms de domaine (DNS)

Chaque demande de domaine effectuée sur Internet nécessite essentiellement des serveurs de cache DNS (Domain Name System) pour la résolution de l'adresse IP associée au nom de domaine. La mise en cache de DNS peut survenir à de nombreux niveaux, notamment le système d'exploitation, via les FAI et les serveurs DNS.

Amazon Route 53 est un service Web DNS dans le cloud hautement disponible et évolutif.

Gestion de session

Les sessions HTTP contiennent les données utilisateur échangées entre les utilisateurs de votre site et vos applications Web telles que les informations de connexion, les listes de panier, les articles précédemment consultés, etc. Pour fournir d'excellentes expériences utilisateur sur votre site Web, il vous faut efficacement gérer vos sessions HTTP en enregistrant les préférences de vos utilisateurs et fournir un contexte utilisateur riche. Avec des architectures d'application modernes, l'utilisation d'un magasin de données de gestion de session centralisé est la solution idéale pour un certain nombre de raisons, y compris l’offre d'une expérience cohérente sur tous les serveurs Web, une meilleure durabilité de session lorsque votre parc de serveurs Web est élastique et une plus grande disponibilité lorsque les données de session sont répliquées sur les serveurs de cache.

Pour en savoir plus, cliquez ici.

Interfaces de programmation d’application (API)

Aujourd'hui, la plupart des applications Web sont conçues sur des API (Application Programming Interface). En général, une API est un service Web RESTful qui est accessible via HTTP et affiche des ressources permettant à l'utilisateur d'interagir avec l'application. Lorsque vous créez une API, il est important de prendre en compte, entre autres, la charge attendue sur l'API, l'autorisation liée, les effets des modifications apportées à la version de l'API pour les consommateurs et, plus important encore, la facilité d'utilisation de l'API. Une API n'a pas toujours besoin d'instancier la logique commerciale et/ou d'effectuer des demandes backend vers une base de données sur chaque demande. Parfois, fournir un résultat en cache de l'API offrira la réponse la plus optimale et la plus économique. Ceci est particulièrement vrai lorsque vous êtes en mesure de mettre en cache la réponse de l'API pour adapter le taux de modification des données sous-jacentes. Supposons, par exemple, que vous avez exposé une API de listing produit pour vos utilisateurs et que vos catégories de produits ne changent qu'une fois par jour. Étant donné que la réponse à une demande de catégorie de produits sera identique tout au long de la journée à chaque fois qu'un appel à votre API est effectué, il serait suffisant de mettre en cache votre réponse d'API pour la journée. En mettant en cache votre réponse d'API, vous éliminez la pression sur votre infrastructure, y compris vos serveurs d'application et bases de données. Vous pouvez également profiter de temps de réponse plus rapides et déployer une API plus performante.

Amazon API Gateway est un service entièrement géré qui permet aux développeurs de créer, publier, gérer, surveiller et sécuriser facilement des API à n'importe quelle échelle.

Mise en cache pour les environnements hybrides

Dans un environnement cloud hybride, vous pouvez avoir des applications présentes dans le cloud et nécessitant un accès fréquent à une base de données sur site. Il existe de nombreuses topologies de réseau pouvant être employées pour créer une connectivité entre votre cloud et l'environnement sur site, y compris VPN et Direct Connect. Et alors que la latence du VPC vers votre centre de données sur site peut être faible, il peut s'avérer optimal de mettre en cache vos données sur site dans votre environnement cloud pour accélérer les performances globales de récupération des données.

Mise en cache Web

Lors du déploiement de contenu Web pour vos utilisateurs, une grande partie de la latence impliquée dans la récupération des ressources Web comme les images, les documents html, les vidéos, etc. peut être considérablement réduite en mettant en cache ces artéfacts et en éliminant les lectures de disque et la charge de serveur. Plusieurs techniques de mise en cache Web peuvent être utilisées à la fois sur le serveur et du côté du client. En général, la mise en cache Web du côté du serveur implique l'utilisation d'un proxy Web qui retient les réponses Web des serveurs Web devant lesquels il se trouve, ce qui réduit efficacement leur chargement et la latence. La mise en cache Web du côté du client peut inclure une mise en cache basée sur navigateur qui retient une version mise en cache du contenu Web visité précédemment. Pour en savoir plus sur la mise en cache Web, cliquez ici.

Cache général

L'accès aux données depuis la mémoire est beaucoup plus rapide que l'accès aux données depuis le disque ou le SSD, donc l'exploitation des données en cache présente beaucoup plus d'avantages. Pour de nombreux cas d'utilisation ne nécessitant pas la prise en charge de données transactionnelles ni de fiabilité de disque, l'utilisation d'un magasin de clés-valeurs en mémoire sous la forme d'une base de données autonome est un excellent moyen de créer des applications hautement performantes. Outre la vitesse, l'application bénéficie d'un débit élevé à moindre coût. Les données référençables comme les regroupements de produits, les listes de catégories, les informations de profil, etc. constituent de parfaits cas d'utilisation d'un cache général. Pour en savoir plus sur le cache général, cliquez ici.

Cache intégré

Un cache intégré est une couche en mémoire qui met automatiquement en cache les données fréquemment consultées à partir de la base de données d'origine. Plus généralement, la base de données sous-jacente utilisera le cache pour fournir la réponse à la demande de la base de données entrante, vu que les données résident dans le cache. Cela augmente considérablement les performances de la base de données en réduisant la latence de demande ainsi que l'utilisation de CPU et de mémoire sur le moteur de base de données. L'une des caractéristiques importantes d'un cache intégré, c'est la mise en cache des données cohérente avec les données stockées sur disques par le moteur de base de données.

-

Secteurs

-

Découvrez différents secteurs et les nombreux cas d'utilisation de la mise en cache

Mobile

Les applications mobiles constituent un segment de marché à très forte croissance du fait de l'adoption de périphériques rapides par les consommateurs et de la baisse de l’utilisation du matériel informatique traditionnel. Que ce soit pour les jeux, les applications commerciales, les applications de santé et autres, pratiquement chaque segment de marché aujourd'hui dispose d'une application adaptée au mobile. Du point de vue du développement d'une application, la création d'applications mobiles est très similaire à la création de toute autre forme d'applications. On retrouve les mêmes préoccupations, le même niveau de présentation, le même niveau commercial et le même niveau de données. Même si vos outils d'affichage immobilier et de développement sont différents, l'excellente expérience utilisateur reste un objectif commun pour l'ensemble des applications. Avec des stratégies de mise en cache efficaces, vos applications mobiles peuvent fournir les performances que vos utilisateurs attendent, se redimensionner massivement et réduire vos coûts globaux.

AWS Mobile Hub est une console qui vous fournit une expérience intégrée pour découvrir, configurer et accéder aux services cloud AWS dans le but de développer, tester et surveiller l'utilisation d'applications mobiles.

Internet des objets (IoT)

L'Internet des objets (IoT) est un concept à l'origine de la collecte et de la diffusion d'informations à partir d'un appareil et le monde physique via des capteurs d'appareils vers Internet ou une application consommant des données. La valeur d'IoT est en mesure de comprendre les données collectées en temps quasi réel, ce qui donne au final au système consommant les données et aux applications la possibilité de répondre rapidement à ces données. Prenons, par exemple, un appareil transmettant ses coordonnées GPS. Votre application IoT pourrait répondre en suggérant des points d'intérêt relatifs à la proximité de ces coordonnées. De plus, si vous aviez stocké les préférences liées à l'utilisateur de l'appareil, vous pouvez ajuster ces recommandations adaptées à cette personne. Dans ce cas précis, la vitesse à laquelle l'application peut répondre aux coordonnées est essentielle pour obtenir une excellente expérience utilisateur. La mise en cache peut ici jouer un rôle important, par exemple, avec les points d'intérêt ainsi que les coordonnées géographiques qui pourraient être stockées dans un magasin de clés-valeurs comme Redis pour permettre une récupération rapide. Du point de vue du développement d'applications, vous pouvez essentiellement coder votre application IoT pour qu'elle réponde à n'importe quel événement étant donné qu'il existe un moyen de le faire par la programmation. Parmi les considérations importantes à prendre en compte lors de la création d'une architecture IoT, on trouve les temps de réponse impliqués dans l'analyse des données ingérées, l'architecture d'une solution pouvant mettre à l'échelle N nombre d'appareils et offrant une architecture rentable.

AWS IoT est une plateforme cloud gérée qui permet aux appareils connectés d'interagir de manière simple et sécurisée avec d'autres appareils et des applications cloud.

Lecture complémentaire : Gestion d'IdO et des données chronologiques avec Amazon ElastiCache for Redis

Technologie publicitaire

Les applications AdTech modernes sont particulièrement exigeantes en termes de performances. Un exemple d'un domaine de croissance significatif dans l’AdTech est l'enchère en temps réel (RTB pour real-time bidding), qui est l'approche basée sur les enchères pour les transactions d'affichage des publicités numériques en temps réel au niveau d'impression le plus précis. La RTB était la méthode de transaction dominante en 2015, comptabilisant 74 % des publicités achetées par programme, soit 11 milliards de dollars aux États-Unis (d'après eMarketer Analysis). Lors de la création d'une application d'enchères en temps réel, une milliseconde peut faire la différence entre l'envoi de l'enchère dans les temps et le fait de devenir impertinente. Cela signifie que l'obtention des informations d'enchère à partir de la base de données doit être extrêmement rapide. La mise en cache de base de données, qui peut accéder aux détails d'enchère en moins d'une milliseconde, est une excellente solution pour atteindre ces performances élevées.

Jeux

L'interactivité est une nécessité essentielle pour pratiquement n'importe quel jeu moderne. Il n'y a rien de plus frustrant pour les joueurs qu'un jeu lent ou non réactif et généralement, ce genre de jeu ne fait pas long feu. Les exigences sur les performances sont encore plus grandes pour les jeux multi-joueurs sur mobile, où chaque action effectuée par un joueur doit être partagée avec d'autres en temps réel. La mise en cache joue un rôle crucial dans la fluidité d'un jeu en fournissant des temps de réponse aux demandes de moins d'une milliseconde pour les données fréquemment consultées. Elle est également utile pour atténuer les problèmes de clé à chaud lorsque les mêmes données sont demandées plusieurs fois, comme « qui sont les 10 meilleurs joueurs par score ? »

Pour en savoir plus sur le développement de jeux sur AWS, cliquez ici.

Multimédia

Les entreprises du secteur multimédia doivent souvent faire face à la nécessité de transmettre une grande quantité de contenu statique à leurs clients avec un nombre de lecteurs/visionneurs en constante évolution. Un bon exemple serait un service de diffusion vidéo comme Netflix ou Amazon Video, qui diffuse une grande quantité de contenu vidéo pour les utilisateurs. C'est la solution idéale pour un réseau de diffusion de contenu, où les données sont stockées sur un ensemble de serveurs de mise en cache distribué dans le monde entier. Un autre aspect des applications multimédia est la charge qui tend à être irrégulière et imprévisible. Imaginez un blog sur un site Web sur lequel une célébrité vient de tweeter ou le site Web d'une équipe de football américain pendant le Super Bowl. Un tel pic de demande pour un petit sous-ensemble de contenu est un défi pour la plupart des bases de données, car elles sont limitées dans leur débit par clé. Étant donné que la mémoire dispose d'un débit beaucoup plus élevé que le disque, un cache de base de données permettrait de résoudre le problème en redirigeant les lectures vers le cache en mémoire.

E-commerce

Les applications e-commerce modernes sont de plus en plus sophistiquées et offrent une expérience d'achat personnalisée comprenant des recommandations en temps réel basées sur l'historique d'achat et les données de l'utilisateur. Ces derniers éléments comprennent également souvent la consultation d'un réseau social d'utilisateur et le fait de fournir une recommandation en fonction de ce que ses amis ont aimé ou acheté. Alors que la quantité de données nécessaires à traiter augmente, la patience du client, elle, reste la même. Par conséquent, le maintien des performances de l'application en temps réel n'est pas un luxe, mais une nécessité ; une stratégie de mise en cache bien exécutée est un aspect essentiel des performances de l'application et elle peut faire la différence entre la réussite ou l'échec d'une application, entre la concrétisation d'une vente ou la perte d'un client.

Réseaux sociaux

Les applications de réseaux sociaux ont déferlé sur le monde. Les réseaux sociaux comme Facebook, Twitter, Instagram et Snapchat ont un grand nombre d'utilisateurs qui consomment toujours plus de contenu. Lorsqu'un utilisateur ouvre son flux, il s'attend à voir le dernier contenu personnalisé en temps quasi réel. Il ne s'agit pas de contenu statique car chaque utilisateur a différents amis, images, intérêts, etc., ce qui augmente la complexité des besoins en matière d'ingénierie de la plateforme sous-jacente. Les applications de réseaux sociaux sont également très sujettes aux pics d'utilisation autour du divertissement, des sports et des événements politiques majeurs. Ce type de résilience de pic et les performances en temps réel sont obtenus grâce à plusieurs couches de mise en cache, y compris le réseau de diffusion de contenu pour le contenu statique comme les images d'arrière-plan, le cache de session pour assurer le suivi des données de session actuelles d'un utilisateur et le cache de base de données pour conserver à portée les données fréquemment consultées comme les dernières actualités des amis les plus proches et les dernières images.

Santé et bien-être

Le secteur de la santé traverse une révolution numérique, ce qui rend le soin à la fois disponible et à la portée de plus en plus de patients dans le monde entier. Certaines applications permettent aux patients de voir des médecins par le biais de consultations vidéo, et la plupart des principaux fournisseurs disposent d'applications qui permettent aux patients de voir les résultats de leurs tests et d'interagir avec le personnel médical. Pour ce qui est du bien-être, il existe pléthore d'applications allant du suivi de l'activité des capteurs spécifiques d'un utilisateur (par ex., FitBit et Jawbone) à un coaching et des données complets sur le bien-être. Compte tenu de la nature interactive de ces applications, il faut répondre au besoin en termes d'applications, d'entreprise et de niveaux de données rapides. Avec une stratégie de mise en cache efficace, vous serez en mesure de fournir des performances rapides, de réduire les coûts globaux d'infrastructure et de dimensionner à mesure que votre utilisation évolue.

Pour en savoir plus sur la création d'applications de santé sur AWS, cliquez ici.

Finance et technologie financière

La façon dont nous consommons les services financiers a considérablement évolué au cours de ces dernières années. Les applications incluent l'accès aux services bancaires et d'assurance, à la détection des fraudes, aux services d'investissement, à l'optimisation des marchés de capitaux via des algorithmes en temps réel, et bien plus encore. La garantie d'un accès en temps réel aux données financières d'un client lui permettant d'effectuer des transactions comme des virements des paiements est difficile. Tout d'abord, des contraintes similaires s’appliquent comme dans d'autres applications où un utilisateur souhaite interagir avec l'application en temps quasi réel. En outre, les applications financières peuvent imposer des exigences supplémentaires telles qu'une sécurité renforcée et la détection des fraudes. Une architecture efficace, comprenant une stratégie de mise en cache multicouche, est essentielle pour atteindre les performances attendues par les utilisateurs. En fonction des besoins de l'application, les couches de mise en cache comprennent un cache de session pour stocker les données de session d'un utilisateur, un réseau de diffusion de contenu pour la diffusion de contenu statique et un cache de base de données pour les données fréquemment consultées comme les 10 derniers achats du client.

Pour en savoir plus sur les applications de services financiers sur AWS, cliquez ici.

Démarrer avec Amazon ElastiCache

Ressources de mise en cache supplémentaires