Pourquoi choisir Amazon SageMaker ?

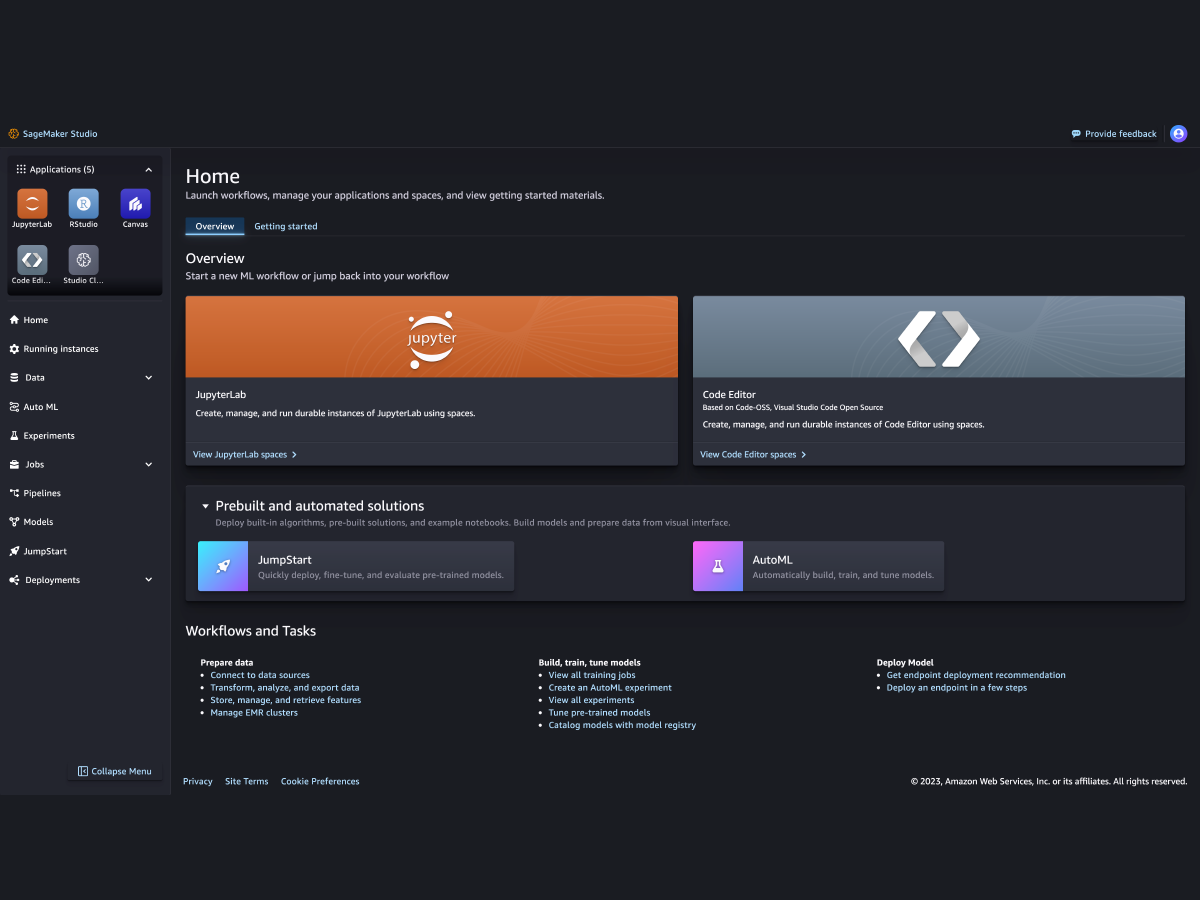

Amazon SageMaker est un service entièrement géré qui réunit un large éventail d'outils pour permettre un machine learning (ML) à hautes performances et à faible coût, quel que soit le cas d'utilisation. Avec SageMaker, vous pouvez créer, entraîner et déployer des modèles de ML à grande échelle à l'aide d'outils tels que des blocs-notes, des débogueurs, des profileurs, des pipelines, des MLOP, etc., le tout dans un environnement de développement intégré (IDE) unique. SageMaker répond aux exigences de gouvernance grâce à un contrôle d'accès simplifié et à la transparence de vos projets de ML. En outre, vous pouvez créer vos propres FM, de grands modèles qui ont été entraînés sur des jeux de données volumineux, à l'aide d'outils spécialement conçus pour ajuster, expérimenter, ré-entraîner et déployer des FM. SageMaker donne accès à des centaines de modèles pré-entraînés, y compris des FM disponibles publiquement, que vous pouvez déployer en quelques clics.

Pourquoi choisir Amazon SageMaker ?

Amazon SageMaker est un service entièrement géré qui réunit un large éventail d'outils pour permettre un machine learning (ML) à hautes performances et à faible coût, quel que soit le cas d'utilisation. Avec SageMaker, vous pouvez créer, entraîner et déployer des modèles de ML à grande échelle à l'aide d'outils tels que des blocs-notes, des débogueurs, des profileurs, des pipelines, des MLOP, etc., le tout dans un environnement de développement intégré (IDE) unique. SageMaker répond aux exigences de gouvernance grâce à un contrôle d'accès simplifié et à la transparence de vos projets de ML. En outre, vous pouvez créer vos propres FM, de grands modèles qui ont été entraînés sur des jeux de données volumineux, à l'aide d'outils spécialement conçus pour ajuster, expérimenter, ré-entraîner et déployer des FM. SageMaker donne accès à des centaines de modèles pré-entraînés, y compris des FM disponibles publiquement, que vous pouvez déployer en quelques clics.

Les avantages de SageMaker

Offrez à davantage d'utilisateurs la possibilité d'innover avec le ML

-

Analystes métier

-

Scientifiques des données

-

Ingénieurs ML

-

Analystes métier

-

Analystes métier

Faites des prédictions ML à l'aide d'une interface visuelle avec SageMaker Canvas. -

Scientifiques des données

-

Experts en science des données

Préparez les données et créez, entraînez et déployez des modèles de ML. -

Ingénieurs ML

-

Ingénieurs ML

Déployez et gérez des modèles à grande échelle avec SageMaker MLOps.

Prenez en charge les cadres, boîtes à outils et langages de programmation de ML majeurs