Istanze Inf1 di Amazon EC2

Aziende di vari settori stanno esaminando la trasformazione potenziata dall'intelligenza artificiale (IA) per guidare l'innovazione aziendale, migliorare l'esperienza cliente e i processi. I modelli di machine learning (ML) che potenziano le applicazioni di IA stanno divenendo sempre più complessi, con il risultato di aumentare i costi sottesi all'infrastruttura di computazione. Fino al 90% dell'infrastruttura della spesa per sviluppare ed eseguire applicazioni ML è spesso destinata all'inferenza. I clienti sono alla ricerca di soluzioni economiche a livello di infrastruttura per distribuire le loro applicazioni ML nella produzione.

Le istanze Inf1 di Amazon EC2 offrono un'inferenza ML ad alte prestazioni e a basso costo. Queste istanze garantiscono una velocità di trasmissione effettiva fino a 2,3 volte superiore e costi fino al 70% più bassi per inferenza rispetto alle istanze di Amazon EC2 paragonabili. Le istanze Inf1 vengono sviluppate da zero per supportare le applicazioni di inferenza di ML. Presentano fino a 16 chip AWS Inferentia, chip di inferenza di ML ad alte prestazioni progettati e realizzati da AWS. Inoltre, le istanze Inf1 includono processori scalabili Intel Xeon di seconda generazione e una rete fino a 100 Gb/s per consegnare un'inferenza a throughput elevato.

I clienti possono usare le istanze Inf1 per eseguire applicazioni di inferenza di ML su larga scala come motori di raccomandazione e di ricerca, visione computerizzata, riconoscimento vocale, elaborazione del linguaggio naturale, personalizzazione e rilevamento di frodi.

Gli sviluppatori possono implementare i propri modelli di ML alle inferenze Inf1 con l'utilizzo dell'SDK AWS Neuron, che si integra con framework di ML diffusi come TensorFlow, PyTorch e Apache MXNet. Possono continuare a usare gli stessi flussi di lavoro ML e migrare senza problemi le applicazioni su istanze Inf1 con modifiche minime al codice e senza alcun legame con soluzioni specifiche del fornitore.

Inizia a utilizzare facilmente le istanze Inf1 con Amazon SageMaker, AWS Deep Learning AMI (DLAMI) preconfigurate con SDK Neuron o Amazon Elastic Container Service (Amazon ECS) o Amazon Elastic Kubernetes Service (Amazon EKS) per applicazioni ML containerizzate.

Vantaggi

Costo per inferenza fino al 70% inferiore

Usando Inf1 gli sviluppatori possono ridurre in modo significativo i costi di implementazioni in produzione ML. La combinazione di bassi costi per istanza e velocità di trasmissione effettiva delle istanze Inf1 offre un costo per inferenza inferiore fino al 70% rispetto alle istanze Amazon EC2 paragonabili.

Facilità d'uso e portabilità del codice

Neuron SDK è integrato con framework di ML comuni come TensorFlow, PyTorch e MXNet. Gli sviluppatori possono continuare a usare gli stessi flussi di lavoro ML e migrare senza problemi le applicazioni su istanze Inf1 con modifiche minime al codice. Questo fornisce la libertà di usare il framework di scelta per il ML, la piattaforma di computazione che meglio risponde alle loro richieste e sfrutta le ultime tecnologie senza bisogno di essere legata alle soluzioni specifiche dei fornitori.

Velocità di trasmissione effettiva fino a 2,3 volte superiore

Le istanze Inf1 forniscono una velocità di trasmissione effettiva fino a 2,3 volte superiore rispetto alle istanze Amazon EC2 paragonabili. I chip di AWS Inferentia che potenziano le istanze Inf1 sono ottimizzati per le prestazioni di inferenza per dimensioni piccole di batch, consentendo alle applicazioni in tempo reale di massimizzare la velocità di trasmissione effettiva e rispettare le condizioni di latenza.

Latenza estremamente bassa

I chip AWS Inferentia sono muniti di un'ampia memoria on-chip che consente la memorizzazione nella cache dei modelli di ML direttamente sul chip. Puoi implementare i tuoi modelli usando capacità come la pipeline NeuronCore che elimina la necessità di accedere a risorse di memoria esterne. Con le istanze Inf1 puoi implementare le applicazioni di inferenza in tempo reale alle latenze in tempo reale senza impatto sulla larghezza di banda.

Supporto per vari modelli ML e tipi di dati

Le istanze Inf1 supportano numerose architetture di modello di ML comunemente usate come SSD, VGG e ResNext per il riconoscimento/la classificazione delle immagini, nonché Transformer e BERT per l'elaborazione del linguaggio naturale. Inoltre il supporto per il repository del modello HuggingFace in Neuron offre ai clienti la possibilità di compilare ed eseguire l'inferenza utilizzando modelli preaddestrati oppure ottimizzati, facilmente, modificando solo una singola riga di codice. Più tipi di dati, tra cui BF16 e FP16 con precisione mista, sono supportati per un'ampia gamma di modelli e esigenze in termini di prestazioni.

Funzionalità

Con tecnologia AWS Inferentia

AWS Inferentia è un chip di ML realizzato appositamente da AWS per offrire inferenza ad alte prestazioni a costi contenuti. Ogni chip AWS Inferentia ha quattro NeuronCore di prima generazione e fornisce fino a 128 tera operazioni al secondo (TOPS) di prestazioni e supporto per i tipi di dati FP16, BF16 e INT8. I chip AWS Inferentia dispongono anche di una notevole quantità di memoria su chip che può essere utilizzata per il caching di grandi modelli, una possibilità particolarmente vantaggiosa per i modelli che richiedono un accesso frequente alla memoria.

Implementazione con framework di ML diffusi con AWS Neuron

L'SDK AWS Neuron è composto da un compilatore, un driver di runtime e strumenti di profilazione. Consente la distribuzione di modelli di rete neurale complessi, creati e addestrati in framework diffusi come TensorFlow, PyTorch e MXNet, da eseguire utilizzando le istanze Inf1. Con la pipeline NeuronCore puoi anche suddividere modelli di grandi dimensioni per l'esecuzione su più chip Inferentia utilizzando un'interconnessione fisica da chip a chip ad alta velocità e assicurando velocità di trasmissione effettiva ad alta inferenza e costi a bassa inferenza.

Reti e archiviazione ad alte prestazioni

Le istanze Inf1 offrono fino a 100 Gb/s di velocità di trasmissione effettiva di rete per applicazioni che richiedono l'accesso alle reti ad alta velocità. La tecnologia di nuova generazione dell’adattatore elastico di rete (ENA) e NVM Express (NVMe) fornisce alle istanze Inf1 una velocità di trasmissione effettiva elevata, interfacce a bassa latenza per le reti e Amazon Elastic Block Store (Amazon EBS).

Basate su AWS Nitro System

Il sistema Nitro AWS è una ricca raccolta di elementi costitutivi che consente di scaricare molte delle tradizionali funzioni di virtualizzazione su hardware e software dedicati per offrire elevate prestazioni, alta disponibilità e alta sicurezza riducendo al contempo il sovraccarico della virtualizzazione.

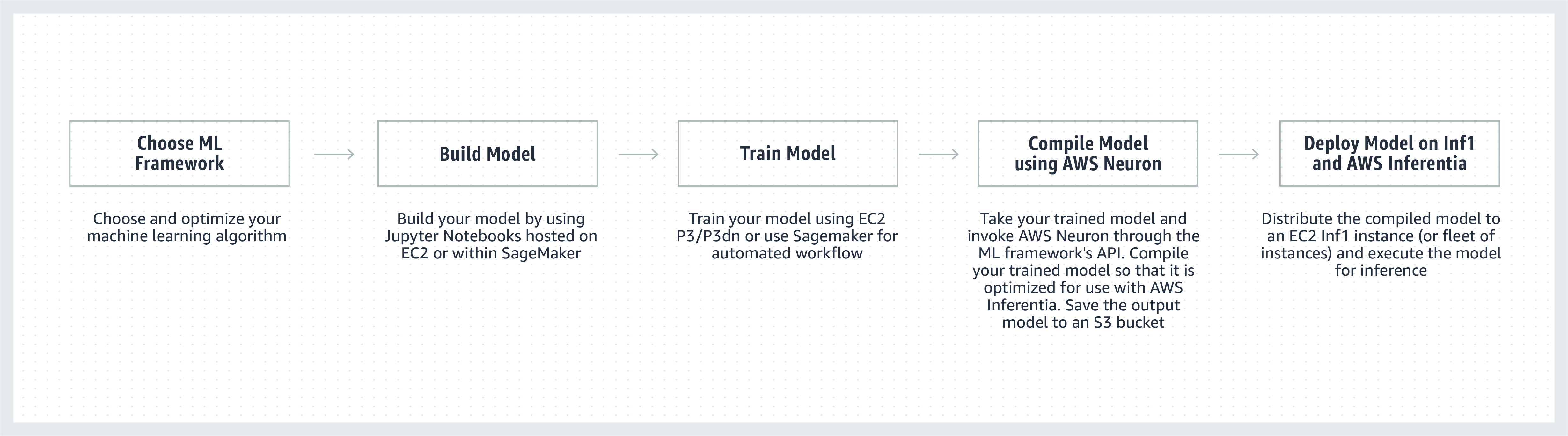

Come funziona

Testimonianze dei clienti

Fondato nel 2008, Airbnb con sede a San Francisco è un marketplace di comunità con oltre 4 milioni di host che hanno accolto più di 900 milioni di ospiti in arrivo in quasi tutti i paesi del mondo.

"La Community Support Platform di Airbnb offre esperienze di servizio intelligenti, scalabili ed eccezionali alla nostra community di milioni di ospiti e host in tutto il mondo. Siamo costantemente alla ricerca di modi per migliorare le prestazioni dei nostri modelli di elaborazione del linguaggio naturale utilizzati dalle nostre applicazioni di chatbot di supporto. Con le istanze Inf1 di Amazon EC2 basate su AWS Inferentia, osserviamo un miglioramento di 2 volte della velocità di trasmissione effettiva rispetto alle istanze basate su GPU per i nostri modelli BERT basati su PyTorch. Non vediamo l'ora di sfruttare le istanze Inf1 per altri modelli e casi d'uso in futuro".

Bo Zeng, Engineering Manager, Airbnb

"Integriamo il machine learning (ML) in molti aspetti di Snapchat, ed esplorare le opportunità di innovazione in questo campo è una delle nostre massime priorità. Dopo avere sentito parlare di Inferentia, abbiamo iniziato a collaborare con AWS per adottare le istanze Inf1/Inferentia per aiutarci con la distribuzione del ML, anche sotto il profilo di costi e prestazioni. Siamo partiti dai nostri modelli di raccomandazione e progettiamo di adottare le istanze Inf1 per altri modelli in futuro".

Nima Khajehnouri, VP Engineering, Snap Inc.

"La piattaforma unificata per la gestione dell'esperienza cliente (Unified-CXM) di Sprinklr, guidata dall'intelligenza artificiale, permette alle aziende di raccogliere e tradurre i feedback in tempo reale dei clienti provenienti da canali multipli e trasformarli in informazioni dettagliate da utilizzare per le proprie operazioni: il risultato è una risoluzione dei problemi proattiva, uno sviluppo dei prodotti migliorato, un marketing dei contenuti più puntuale, una migliore assistenza al cliente e tanto altro. Con Amazon EC2 Inf1, siamo stati in grado di migliorare in maniera significativa le prestazioni di uno dei nostri modelli di elaborazione del linguaggio naturale (NLP), nonché di migliorare le prestazioni di uno dei nostri modelli di visione artificiale. Non vediamo l'ora di continuare a utilizzare Amazon EC2 Inf1, in modo da poter servire al meglio i nostri clienti in tutto il mondo".

Vasant Srinivasan, Senior Vice President of Product Engineering, Sprinklr

"Il nostro prodotto all'avanguardia per l'elaborazione del linguaggio naturale (NLP), Finch for Text, offre agli utenti la possibilità di estrarre, disambiguare e arricchire diversi tipi di entità in enormi volumi di testo. Finch for Text richiede risorse di calcolo significative per fornire ai nostri clienti arricchimenti a bassa latenza su feed di dati globali. Ora utilizziamo le istanze Inf1 di AWS nei nostri modelli di elaborazione del linguaggio naturale (NLP), traduzione e disambiguazione delle entità PyTorch. Siamo riusciti a ridurre i costi di inferenza di oltre l'80% (rispetto alle GPU) con ottimizzazioni minime, mantenendo la velocità di inferenza e le prestazioni. Questo miglioramento consente ai nostri clienti di arricchire i loro testi in francese, spagnolo, tedesco e olandese in tempo reale su feed di dati in streaming e su scala globale, un aspetto fondamentale per i nostri servizi finanziari, gli aggregatori di dati e i clienti del settore pubblico".

Scott Lightner, Chief Technology Officer, Finch Computing

"Avvisiamo su molti tipi di eventi in tutto il mondo in molte lingue, in diversi formati (immagini, video, audio, sensori di testo, combinazioni di tutti questi tipi) da centinaia di migliaia di fonti. L'ottimizzazione della velocità e dei costi, data tale scalabilità, è assolutamente fondamentale per la nostra attività. Con AWS Inferentia, abbiamo ridotto la latenza del modello e ottenuto una velocità di trasmissione effettiva per dollaro fino a 9 volte superiore. Questo ci ha permesso di aumentare la precisione dei modelli e ampliare le capacità della nostra piattaforma implementando modelli DL più sofisticati ed elaborando un volume di dati 5 volte superiore, mantenendo i costi sotto controllo".

Alex Jaimes, Chief Scientist and Senior Vice President of AI, Dataminr

"Autodesk sta sviluppando la tecnologia cognitiva del nostro assistente virtuale basato su IA, Autodesk Virtual Agent (AVA), utilizzando Inferentia. AVA risponde a oltre 100.000 domande dei clienti ogni mese utilizzando tecniche di riconoscimento del linguaggio naturale (NLU) e deep learning (DL) per estrarre il contesto, l'intento e il significato delle richieste. Sfruttando Inferentia, siamo riusciti a ottenere una velocità di trasmissione effettiva di 4,9 volte superiore rispetto a G4dn per i nostri modelli di NLU, e progettiamo di eseguire altri carichi di lavoro sulle istanze Inf1 basate su Inferentia."

Binghui Ouyang, Sr. Data Scientist, Autodesk

I servizi Amazon utilizzano le istanze Inf1 di Amazon EC2

Amazon Advertising aiuta le aziende di qualsiasi dimensione a connettersi con i clienti in ogni fase dell'esperienza di acquisto. Ogni giorno milioni di annunci, inclusi testi e immagini, vengono moderati, classificati e serviti per un'esperienza cliente ottimale.

"Per l'elaborazione dei nostri annunci testuali implementiamo modelli BERT basati su PyTorch a livello globale su istanze Inf1 basate su AWS Inferentia. Passando dalle GPU a Inferentia, siamo stati in grado di ridurre i nostri costi del 69% con prestazioni comparabili. Compilare e testare i nostri modelli per AWS Inferentia ha richiesto meno di tre settimane. L'utilizzo di Amazon SageMaker per implementare i nostri modelli sulle istanze Inf1 ha fatto sì che la nostra implementazione fosse scalabile e facile da gestire. Quando ho analizzato per la prima volta i modelli compilati, le prestazioni con AWS Inferentia sono state talmente impressionanti che ho dovuto rieseguire i benchmark per assicurarmi che fossero corretti! In futuro vogliamo migrare i nostri modelli di elaborazione degli annunci con immagini a Inferentia. Abbiamo già valutato una latenza inferiore del 30% e un risparmio sui costi del 71% rispetto a istanze comparabili basate su GPU per questi modelli."

Yashal Kanungo, Applied Scientist, Amazon Advertising

Leggi il blog sulle ultime novità »

"L'intelligenza basata su IA e ML di Amazon Alexa, con tecnologia AWS, è disponibile oggi su oltre 100 milioni di dispositivi e la nostra promessa ai clienti è che Alexa diventi sempre più intelligente, che ami conversare, che sia più proattiva e persino più gradevole. Rispettare questa promessa richiede miglioramenti continui nei tempi di risposta e nei costi dell'infrastruttura di ML, ed è per questo che siamo entusiasti di utilizzare Inf1 di Amazon EC2 per abbassare la latenza di inferenza e il costo per inferenza della sintesi vocale di Alexa. Con Inf1 di Amazon EC2, possiamo migliorare ulteriormente il servizio per le decine di milioni di clienti che utilizzano Alexa ogni mese".

Tom Taylor, Senior Vice President, Amazon Alexa

"Continuiamo a innovare per migliorare ulteriormente l'esperienza dei nostri clienti e per ridurre i costi delle infrastrutture. Spostando i nostri carichi di lavoro di web-based question answering (WBQA) dalle istanze P3 basate su GPU alle istanze Inf1 basate su AWS Inferentia, non solo abbiamo ridotto i costi di inferenza del 60%, ma abbiamo anche migliorato la latenza end-to-end di oltre il 40%, contribuendo a migliorare l'esperienza di D&R dei clienti con Alexa. L'utilizzo di Amazon SageMaker per il nostro modello basato su TensorFlow ha reso il processo di passaggio alle istanze Inf1 semplice e facile da gestire. Ora stiamo usando istanze Inf1 a livello globale per eseguire questi carichi di lavoro WBQA e stiamo ottimizzando le loro prestazioni per AWS Inferentia per ridurre ulteriormente i costi e la latenza".

Eric Lind, Software Development Engineer, Alexa AI

"Amazon Prime Video utilizza modelli ML di visione artificiale per analizzare la qualità video degli eventi dal vivo, al fine di garantire un'esperienza di visione ottimale per gli iscritti a Prime Video. Abbiamo distribuito i nostri modelli ML di classificazione delle immagini su istanze Inf1 EC2 e siamo riusciti a ottenere un miglioramento delle prestazioni di 4 volte e un risparmio fino al 40% sui costi. Stiamo ora cercando di sfruttare questi risparmi sui costi per innovare e costruire modelli avanzati in grado di rilevare difetti più complessi, come le lacune di sincronizzazione tra i file audio e video, per offrire un'esperienza di visione migliore agli iscritti a Prime Video".

Victor Antonino, Solutions Architect, Amazon Prime Video

"Amazon Rekognition è un'applicazione di analisi di video e immagini semplice e intuitiva che aiuta i clienti a identificare oggetti, persone, testi e attività. Amazon Rekognition richiede un'infrastruttura di deep learning ad alte prestazioni in grado di analizzare quotidianamente miliardi di immagini e video per i nostri consumatori. Con le istanze Inf1 basate su AWS Inferentia, l'esecuzione di modelli di Amazon Rekognition, come ad esempio la classificazione degli oggetti, ha riscontrato una latenza di 8 volte inferiore e una velocità di trasmissione effettiva di 2 volte maggiore rispetto all'esecuzione degli stessi modelli su GPU. Sulla base di questi riscontri, stiamo trasferendo Amazon Rekognition su Inf1, per consentire ai nostri clienti di ottenere risultati più precisi in un tempo inferiore".

Rajneesh Singh, Director, SW Engineering, Amazon Rekognition and Video

Prezzi

* I prezzi sono calcolati per la regione AWS Stati Uniti orientali (Virginia settentrionale). Per quanto riguarda le istanze che non prevedono pagamenti anticipati parziali, i prezzi per le istanze riservate di 1 anno e di 3 anni si applicano alle opzioni di pagamento "parzialmente anticipato" o "nessun anticipo".

Le istanze Inf1 di Amazon EC2 sono disponibili nelle regioni AWS Stati Uniti orientali (Virginia) e Stati Uniti occidentali (Oregon) come istanze on demand, riservate o Spot.

Nozioni di base

Uso di Amazon SageMaker

SageMaker semplifica la compilazione e distribuzione del modello addestrato di machine learning nella produzione sulle istanze Inf1 di Amazon, consentendoti di iniziare a generare previsioni in tempo reale a bassa latenza. AWS Neuron, il compilatore per AWS Inferentia, è integrato con Amazon SageMaker Neo e ti consente di compilare i modelli di machine learning addestrati affinché vengano eseguiti in modo ottimale sulle istanze Inf1. Con SageMaker puoi eseguire agevolmente i tuoi modelli su cluster con dimensionamento automatico di istanze Inf1 che sono distribuite su più zone di disponibilità, per offrire inferenza in tempo reale sia a prestazioni elevate che a disponibilità elevata. Scopri come distribuire su Inf1 utilizzando SageMaker con esempi su GitHub.

Utilizzo di DLAMI

DLAMI fornisce agli esperti di ML e ai ricercatori l'infrastruttura e gli strumenti nel cloud necessari per velocizzare i processi di deep learning su qualsiasi scala. L'SDK AWS Neuron è preinstallato in DLAMI per compilare ed eseguire i modelli ML in modo ottimale su istanze Inf1. Per una guida alle operazioni di base del processo, visita la guida alla selezione delle AMI e ulteriori risorse di deep learning. Consulta la Guida Nozioni di base su AWS DLAMI per ulteriori informazioni su come utilizzare DLAMI con Neuron.

Uso dei container di deep learning

Gli sviluppatori possono ora implementare le istanze Inf1 in Amazon EKS, un servizio Kubernetes interamente gestito, e in Amazon ECS, un servizio di orchestrazione di container interamente gestito di Amazon. Scopri come iniziare a utilizzare Inf1 su Amazon EKS o con Amazon ECS. Ulteriori dettagli su come eseguire container sulle istanze Inf1 sono disponibili alla pagina del tutorial sugli strumenti container Neuron. Neuron è disponibile anche preinstallato nei container AWS per il deep learning.

Blog e articoli

In che modo Amazon Search ha ridotto dell'85% i costi di inferenza ML con AWS Inferentia

a cura di Joao Moura, Jason Carlson, Jaspreet Singh, Shaohui Xi, Shruti Koparkar, Haowei Sun, Weiqi Zhang e Zhuoqi Zhangs, 22/09/2022

High-performance, low-cost machine learning infrastructure is accelerating innovation in the cloud (Il ricorso a infrastrutture di machine learning a basso costo e ad elevate prestazioni sta accelerando il processo di innovazione nel cloud)

a cura di MIT Technology Review Insights, 01/11/2021

a cura di Davide Galliteli e Hasan Poonawala, 19/10/2021

L’utilizzo del machine learning nel cloud sta aiutando le aziende ad innovarsi

a cura di MIT Technology Review Insights, 15/10/2021

Servi 3.000 modelli di deep learning su Amazon EKS con AWS Inferentia a meno di 50 USD all’ora

a cura di Alex Iankoulski, Joshua Correa, Mahadevan Balasubramaniam e Sundar Ranganatha, 30/09/2021

di Fabio Nonato de Paula e Mahadevan Balasubramaniam, 04/05/2021

a cura di Binghui Ouyang, 07/04/2021

Majority of Alexa now running on faster, more cost-effective Amazon EC2 Inf1 instances (La maggior parte dei dispositivi Alexa ora esegue istanze Inf1 di Amazon EC2 in modo più rapido ed economico)

di Sébastien Stormacq, 12/11/2020

Amazon ECS ora supporta le istanze Inf1 di EC2

di Julien Simon, 14/08/2020

Di Fabio Nonato De Paula e Haichen Li, 22/07/2020

Amazon EKS ora supporta le istanze Inf1 di EC2

di Julien Simon, 15/06/2020