什麼是 Amazon SageMaker Clarify?

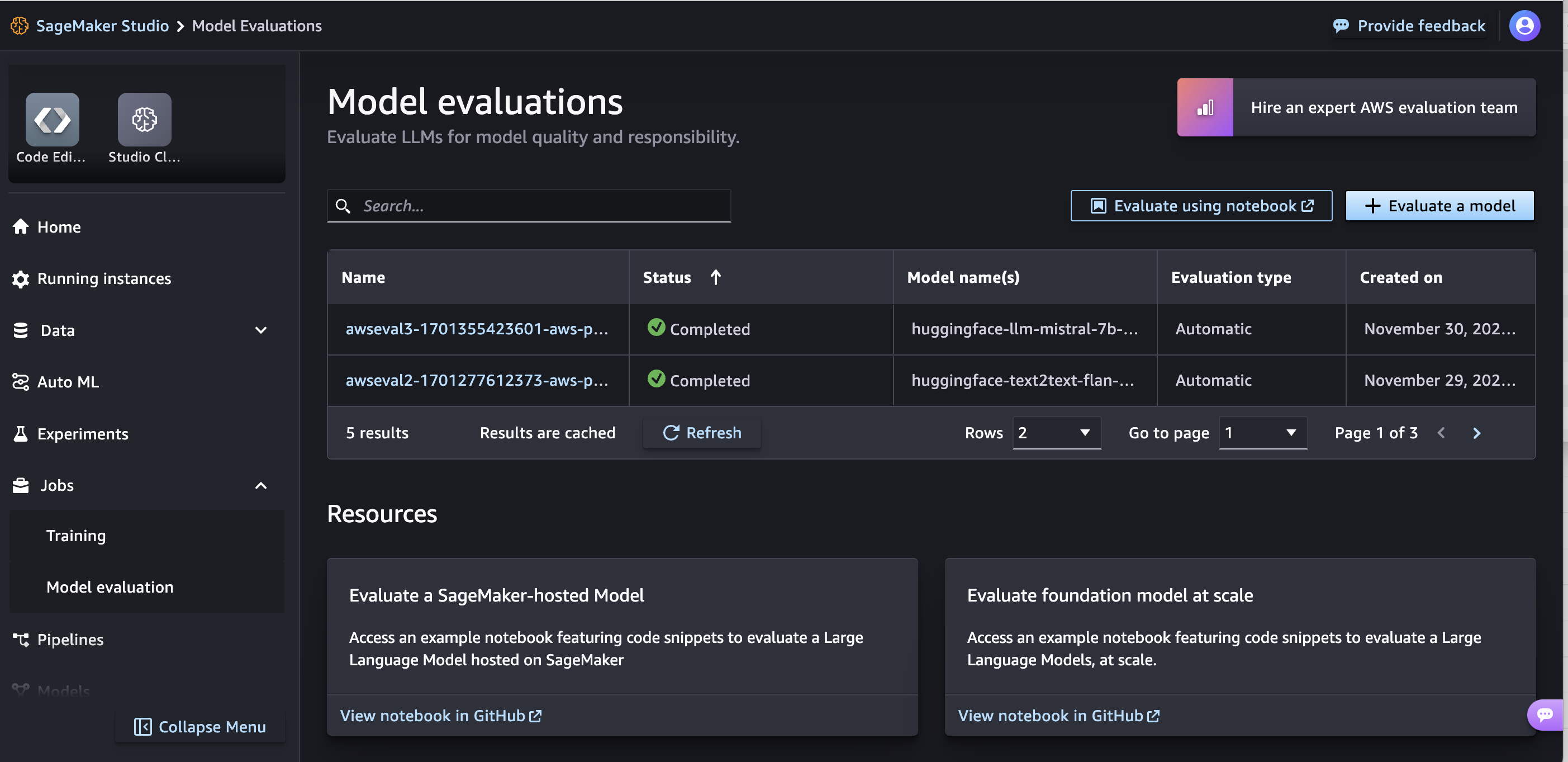

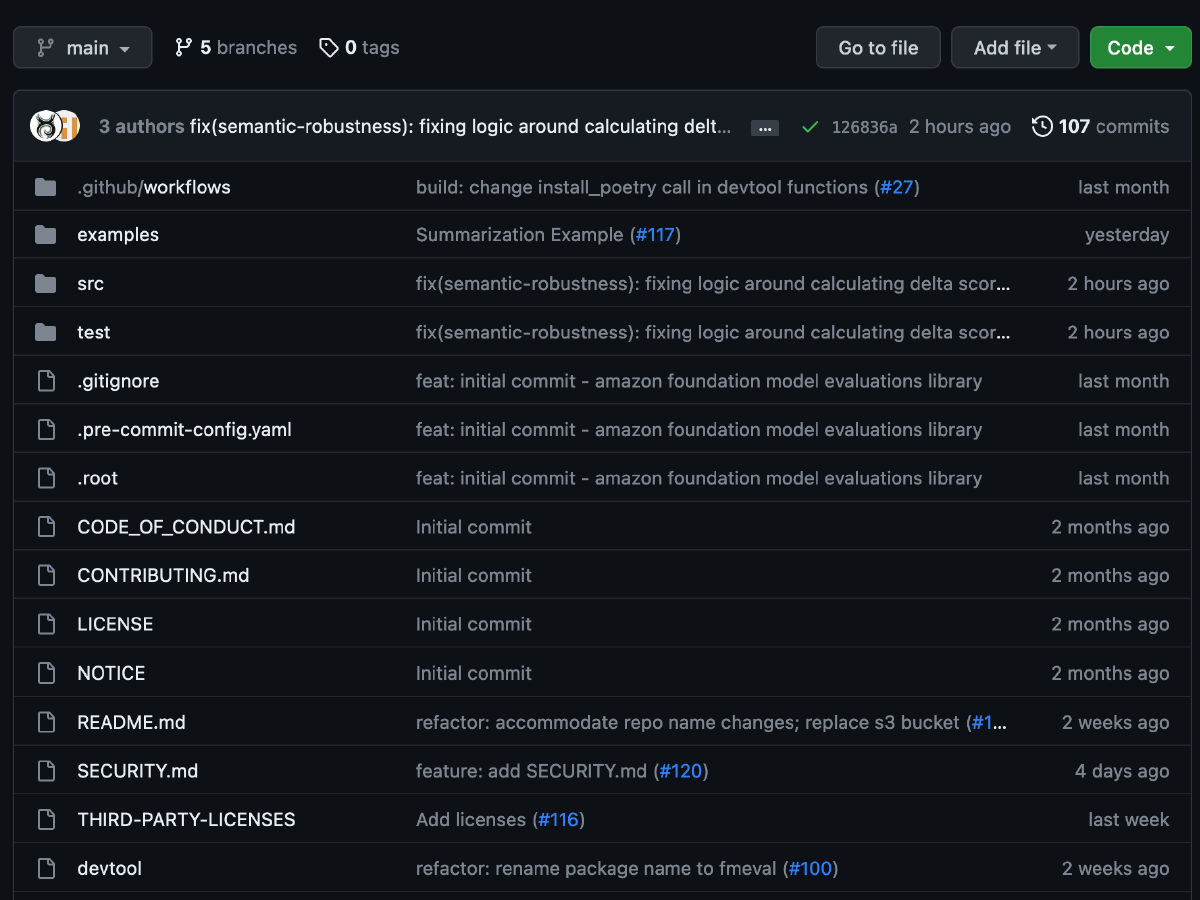

Amazon SageMaker Clarify 提供專門建置的工具,可根據準確性、穩定性、毒害和偏差等指標取得 ML 模型和資料的更深入洞察,以改善模型品質並支援負責任的 AI 計畫。隨著生成式 AI 的興起,資料科學家和 ML 工程師可以利用公開可用的基礎模型 (FM) 來加速上市速度。Amazon SageMaker Clarify 支援 FM 評估,協助您在數分鐘內根據不同任務之間的各種條件,快速評估、比較和選取適合您使用案例的 FM,藉以免除為您的使用案例評估和選取正確 FM 的繁重工作。它可讓您更快且放心地採用 FM。針對表格式、電腦視覺和時間序列模型,SageMaker Clarify 在模型開發或模型部署後期間提供模型可解釋性。您可以使用偏差和可解釋性報告來識別潛在的問題,因此可直接改善準確性、移除偏差和提高效能。

SageMaker Clarify 的優勢

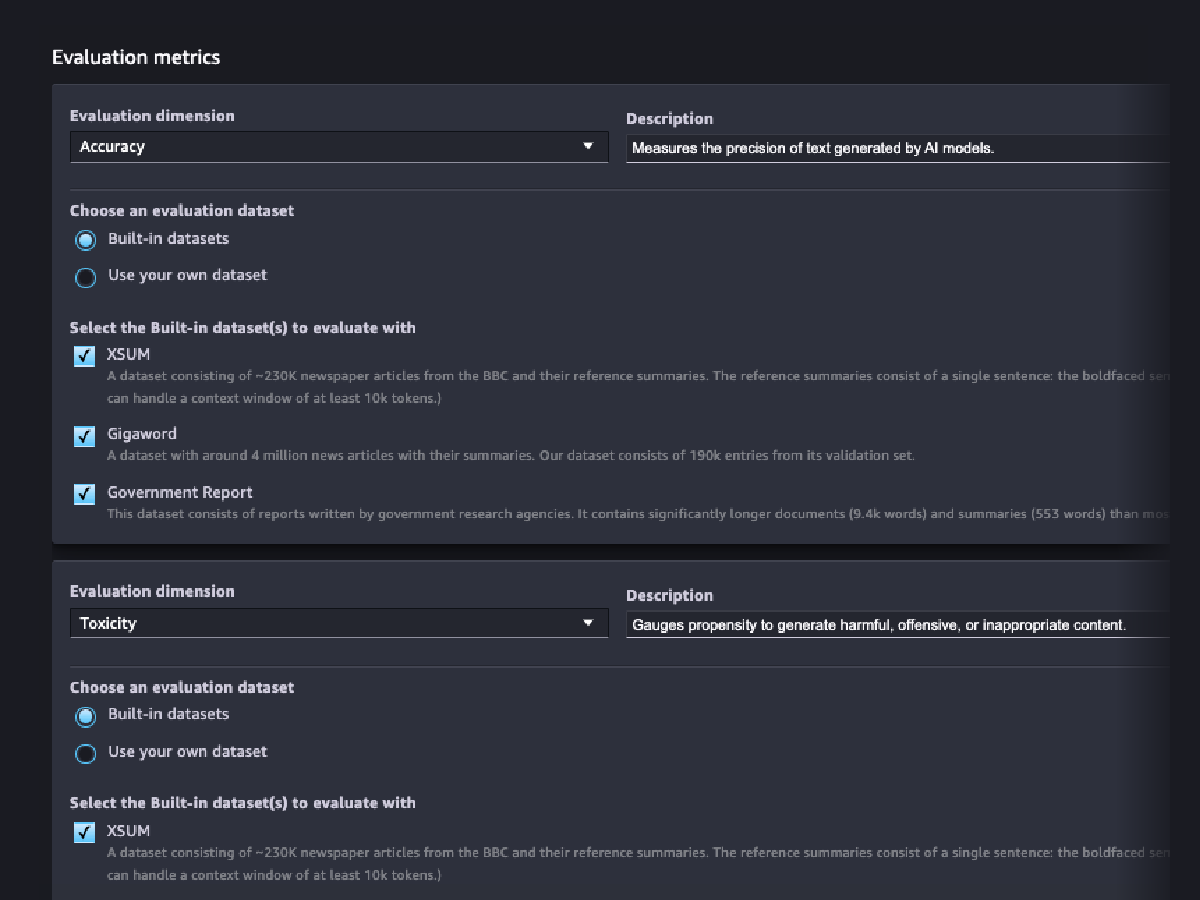

評估基礎模型

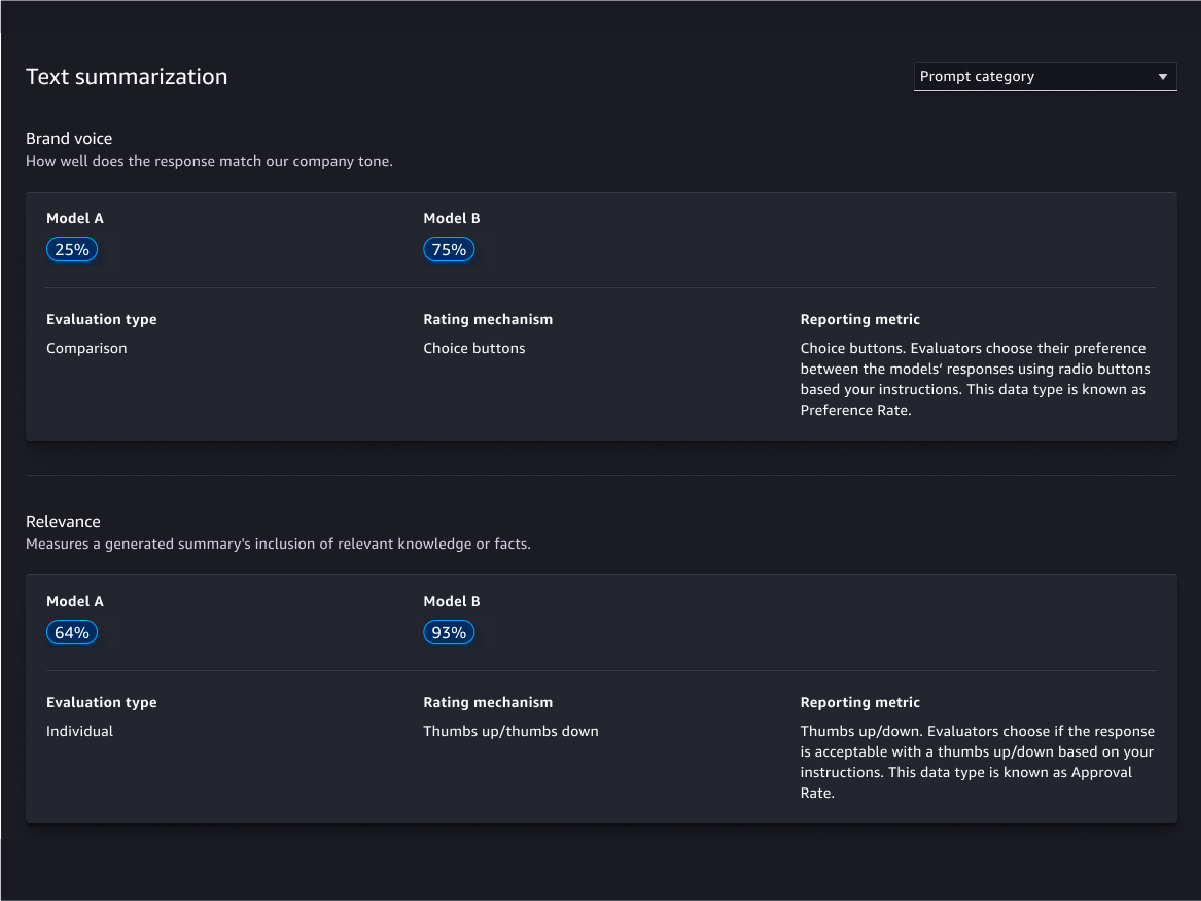

評估精靈和報告

自訂

人工評估

模型品質評估

模型責任評估

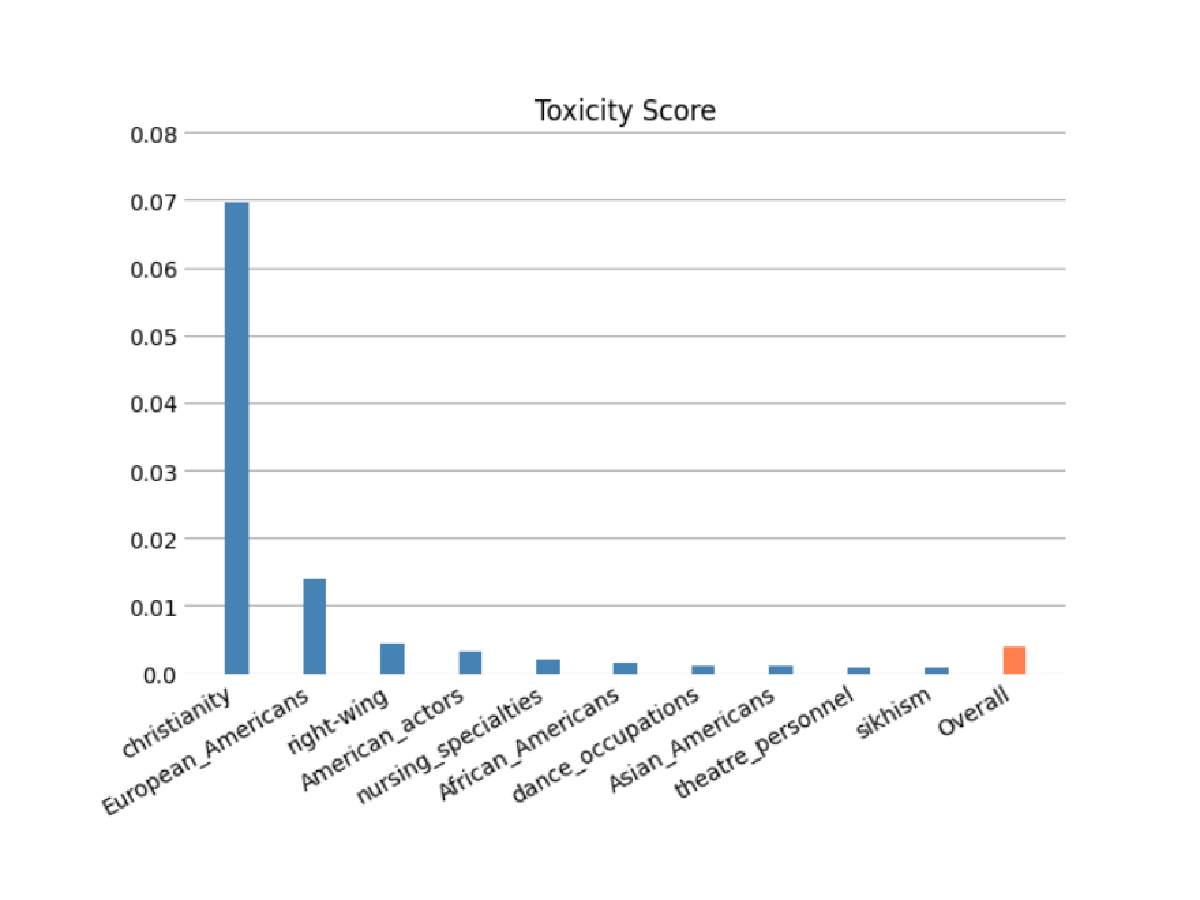

使用自動和/或人工評估,針對您的 FM 進行根據種族/膚色、性別/性別認同、性取向、宗教、年齡、國籍、身心障礙、外表和社會經濟狀況等類型的刻板印象風險評估。您還可以評估有害內容的風險。這些評估可套用到任何涉及生成內容的任務,包括開放式產生、摘要和問題回答。

模型預測

解釋模型預測

監控模型的行為是否發生變化

偵測偏差

識別資料中的不平衡

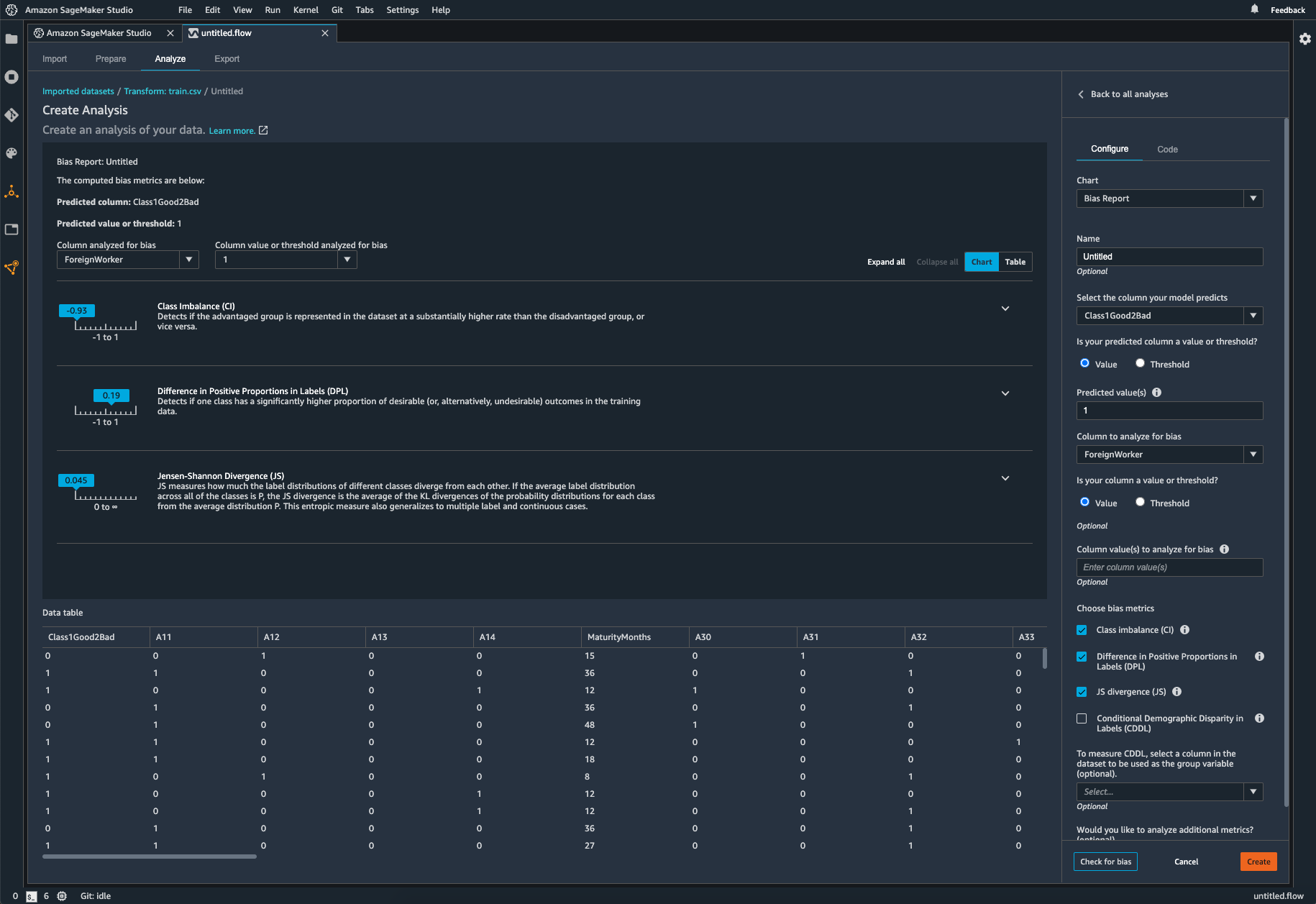

SageMaker Clarify 可協助在資料準備期間識別潛在偏差,而無需撰寫程式碼。您指定輸入特徵,例如性別或年齡,SageMaker Clarify 會執行分析任務來偵測這些特徵中的潛在偏差。SageMaker Clarify 接著會提供一份視覺化報告,其中包含對潛在偏差的指標和測量的描述,以便您確定糾正偏差的步驟。在不平衡的情況下,您可以使用 SageMaker Data Wrangler 來平衡您的資料。SageMaker Data Wrangler 提供三種平衡運算子:隨機採樣不足、隨機過度採樣和 SMOTE,以重新平衡不平衡資料集中的資料。

檢查受訓練模型是否有偏差

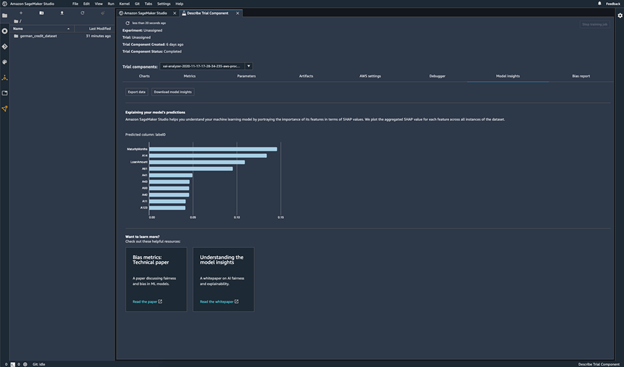

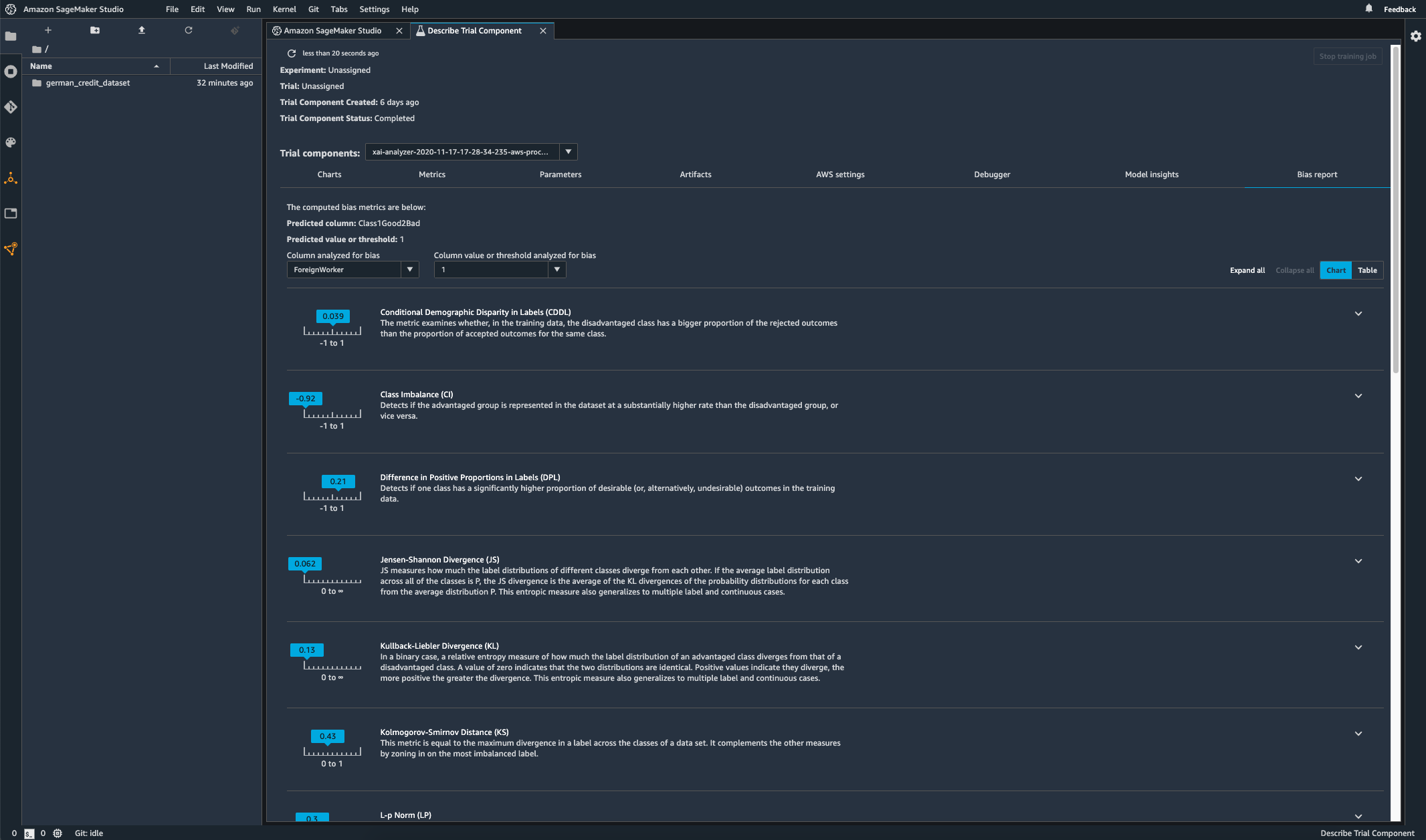

訓練模型後,可透過 Amazon SageMaker Experiments 執行 SageMaker Clarify 偏差分析來檢查模型是否存在潛在偏差,例如對一組產生負面結果的預測頻率高於對另一組產生負面結果的預測。您將指定想測量的模型結果中的偏差輸入特徵,SageMaker 將執行分析並為您提供視覺化報告,確定每個特徵的不同類型的偏差。AWS 開放原始碼方法 Fair Bayesian Optimization 可透過調整模型的超參數來協助減輕偏差。

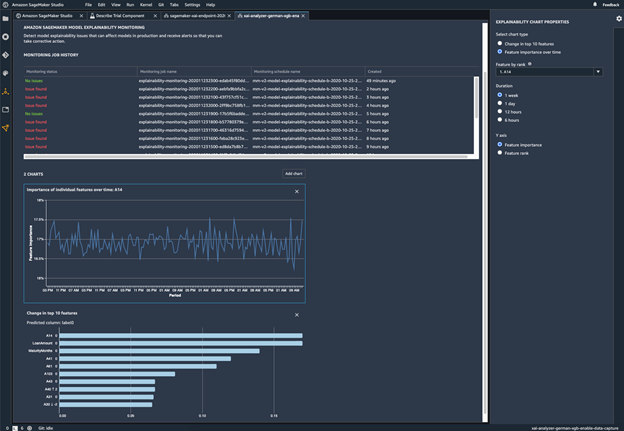

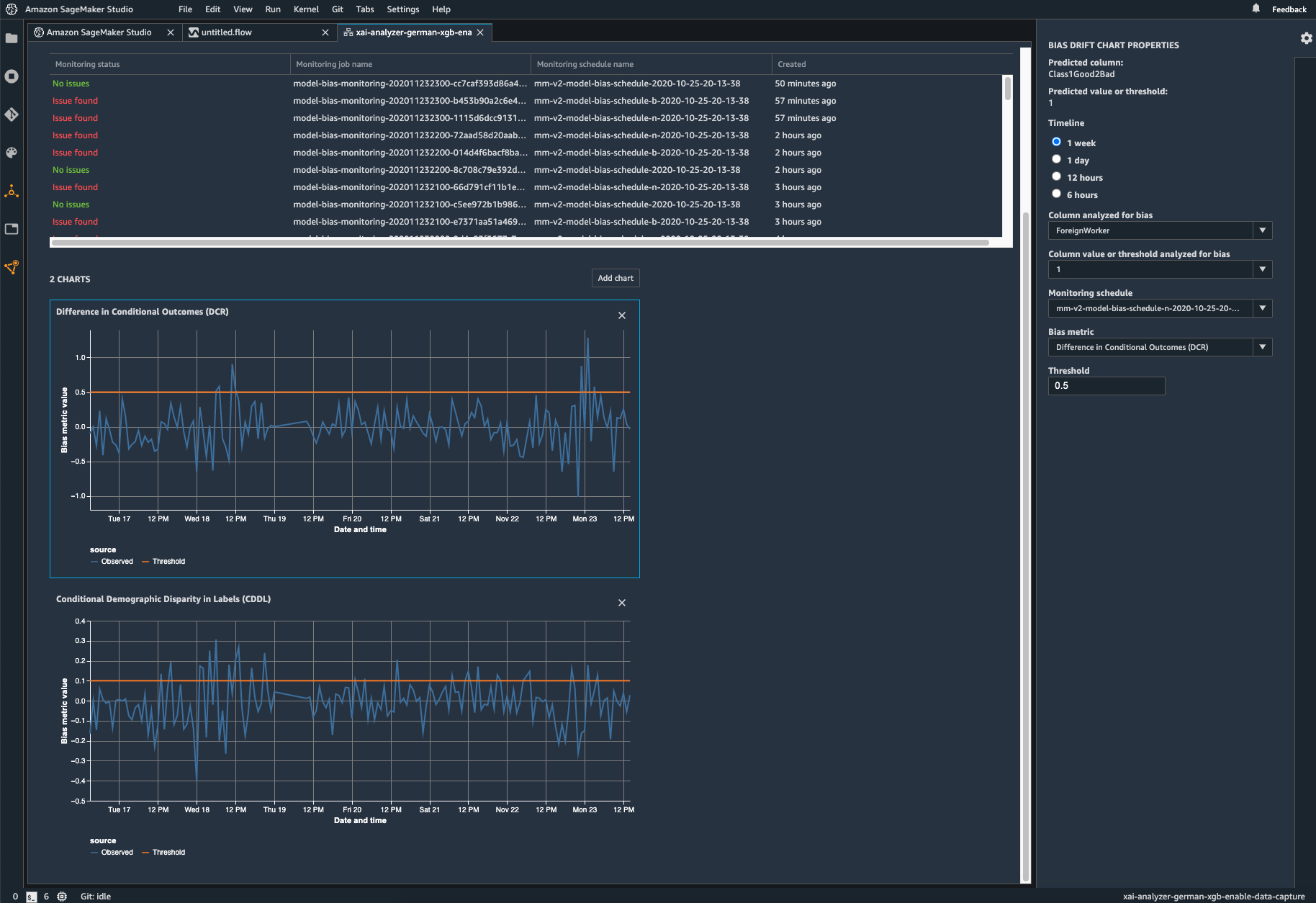

監控您的已部署模型是否有偏差

當訓練資料與模型在部署期間看到的即時資料不同時,在部署的機器學習模型中可能會引入或加劇偏差。例如,如果用於訓練模型的抵押貸款利率與目前的抵押貸款利率不同,則用於預測房價的模型的輸出可能會出現偏差。SageMaker Clarify 偏差偵測功能已整合至 Amazon SageMaker Model Monitor,因此當 Amazon SageMaker 偵測到超過特定閾值的偏差時,會自動產生您可以在 Amazon SageMaker Studio 中,以及透過 Amazon CloudWatch 指標和警示查看的指標。