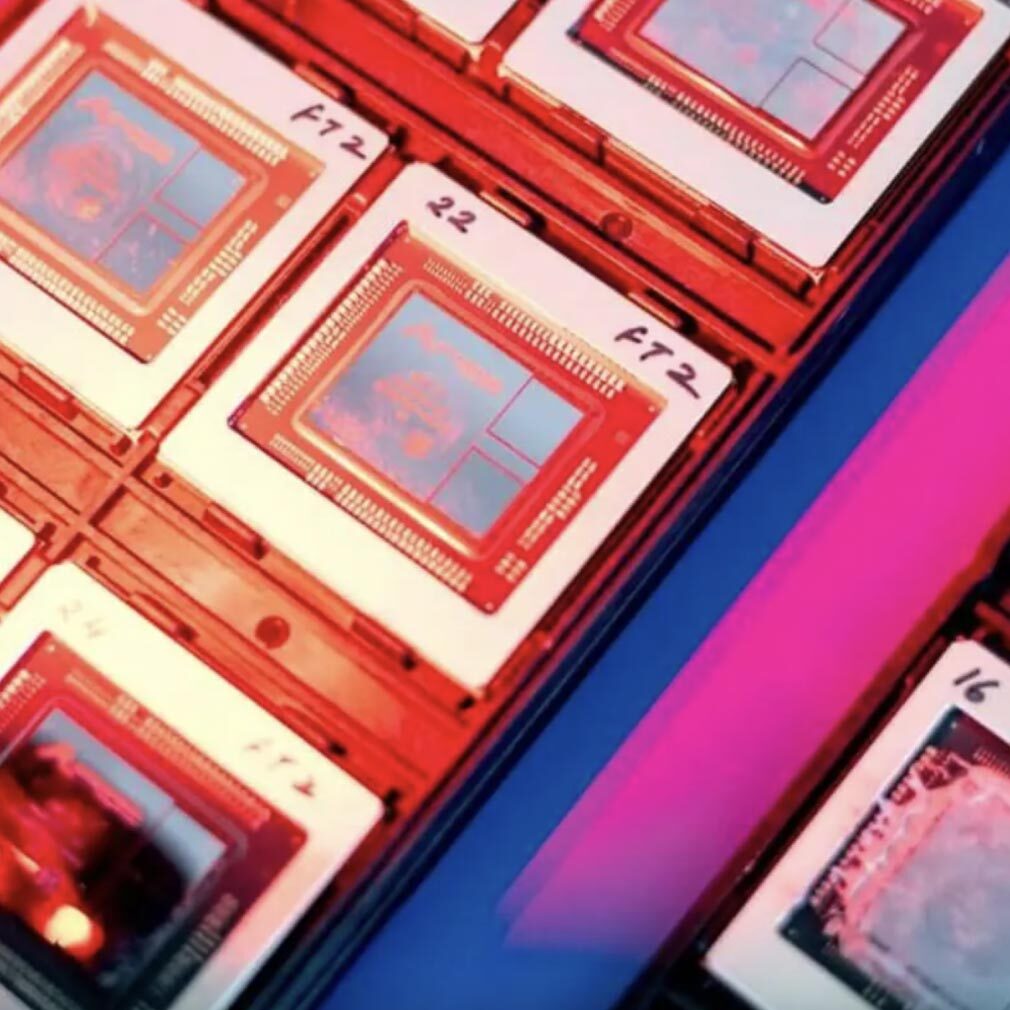

AWS 人工智能基础设施

AWS 提供全面、安全、高性价比的人工智能基础设施,可满足您的所有训练和推理需求。利用计算、网络和存储领域广泛、深入的人工智能和机器学习功能集进行构建。通过托管服务,使用最新的专用芯片或 GPU 运行分布式训练作业。

最新资讯

正在加载

正在加载

正在加载

正在加载

正在加载

AWS 人工智能基础设施的优势

-

通过广泛、深入的可持续功能集加速人工智能创新。

-

保护您的数据,并使用治理控制进行构建,从而在整个人工智能基础设施中打造安全的体验。

-

使用高性价比基础设施进行构建,在降低成本的同时提供出色性能。

使用全面、安全的高性价比基础设施进行构建

在基础模型训练和部署到生产环境期间,识别和选择正确的计算基础设施,对于最大化性能、降低成本、减少高能耗以及避免复杂性而言至关重要。