Deployment Model Amazon SageMaker

Lakukan deployment dan kelola model machine learning (ML) dengan mudah untuk inferensi

Amazon SageMaker memudahkan dalam melakukan deployment model ML, termasuk model fondasi (FM) untuk membuat prediksi (juga dikenal sebagai inferensi) dengan performa harga terbaik untuk kasus penggunaan apa pun. Dari latensi rendah (beberapa milidetik) dan throughput tinggi (jutaan transaksi per detik) hingga inferensi yang berjalan lama untuk kasus penggunaan, seperti pemrosesan bahasa alami dan penglihatan komputer, Anda dapat menggunakan SageMaker untuk semua kebutuhan inferensinya. SageMaker adalah layanan terkelola penuh dan terintegrasi dengan alat MLOps sehingga Anda dapat menskalakan deployment model Anda, mengurangi biaya inferensi, mengelola model secara lebih efektif dalam produksi, dan mengurangi beban operasional.

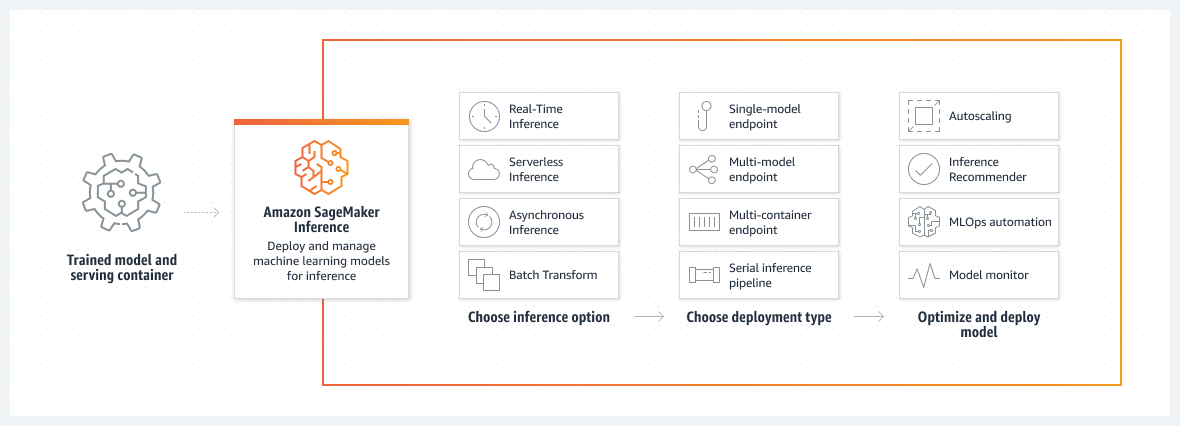

Cara kerjanya

Berbagai opsi untuk setiap kasus penggunaan

Berbagai opsi inferensi

Dari latensi rendah (beberapa milidetik) dan throughput tinggi (ratusan ribu permintaan per detik) hingga inferensi yang berjalan lama untuk kasus penggunaan, seperti pemrosesan bahasa alami dan penglihatan komputer, Anda dapat menggunakan Amazon SageMaker untuk semua kebutuhan inferensi Anda.

Inferensi Waktu Nyata

Latensi rendah dan throughput ultratinggi untuk kasus penggunaan dengan pola lalu lintas stabil.

Inferensi Nirserver

Latensi rendah dan throughput tinggi untuk kasus penggunaan dengan pola lalu lintas intermiten.

Inferensi Asinkron

Latensi rendah untuk kasus penggunaan dengan muatan besar (hingga 1 GB) atau waktu pemrosesan yang lama (hingga 15 menit).

Batch Transform

Inferensi offline pada batch data untuk kasus penggunaan dengan set data besar.

Opsi titik akhir deployment yang fleksibel

Amazon SageMaker menyediakan cara yang dapat diskalakan dan hemat biaya untuk melakukan deployment sejumlah besar model ML. Dengan titik akhir multimodel SageMaker dan titik akhir multikontainer, Anda dapat melakukan deployment ribuan model pada infrastruktur bersama, yang meningkatkan efektivitas biaya sekaligus memberikan fleksibilitas untuk menggunakan model sesering yang Anda butuhkan. Titik akhir multimodel mendukung tipe instans CPU dan GPU sehingga dapat membantu Anda mengurangi biaya inferensi hingga 90%.

Titik akhir model tunggal

Satu model pada konteiner yang di-hosting pada instans khusus atau nirserver untuk latensi rendah dan throughput tinggi.

Titik akhir multimodel

Beberapa model berbagi satu kontainer yang dilakukan hosting pada infrastruktur bersama untuk efektivitas biaya. Hal ini mengurangi biaya hosting dengan meningkatkan pemanfaatan titik akhir dibandingkan menggunakan titik akhir model tunggal.

Titik akhir multikontainer

Beberapa kontainer berbagi instans khusus untuk model yang menggunakan kerangka kerja berbeda.

Alur inferensi serial

Beberapa kontainer berbagi instans khusus dan melakukan eksekusi secara berurutan. Anda dapat menggunakan alur inferensi untuk menggabungkan tugas ilmu data prapemrosesan, prediksi, dan pascapemrosesan.

Dukung sebagian besar kerangka kerja machine learning dan server model

Inferensi Amazon SageMaker mendukung algoritma bawaan dan citra Docker bawaan untuk beberapa kerangka kerja machine learning yang paling umum, seperti TensorFlow, PyTorch, ONNX, dan XGBoost. Jika tidak ada citra Docker bawaan yang memenuhi kebutuhan Anda, Anda dapat membuat kontainer Anda sendiri untuk digunakan dengan titik akhir multimodel yang didukung CPU. Inferensi SageMaker juga mendukung server model paling populer, seperti TensorFlow Serving, TorchServe, NVIDIA Triton, dan server multimodel AWS. Anda juga dapat mendukung model besar dengan penyajian DJL menggunakan kerangka kerja paralelisasi model DeepSpeed dan Hugging Face Accelerate. Dengan opsi ini, Anda dapat melakukan deployment model termasuk model fondasi (FM) dengan cepat untuk hampir semua kasus penggunaan.

Capai performa inferensi tinggi dengan biaya rendah

Lakukan deployment model pada infrastruktur beperforma paling tinggi atau beroperasilah secara nirserver

Amazon SageMaker menawarkan lebih dari 70 tipe instans dengan berbagai tingkat komputasi dan memori, termasuk instans Inf1 Amazon EC2 berbasis AWS Inferentia, chip inferensi ML beperforma tinggi yang dirancang dan dibuat oleh AWS, dan instans GPU, seperti G4dn Amazon EC2. Atau, pilih Inferensi Nirserver Amazon SageMaker untuk dengan mudah menskalakan ke ribuan model per titik akhir, jutaan throughput transaksi per detik (TPS), dan latensi biaya tambahan sub10 milidetik.

Uji bayangan untuk memvalidasi performa model ML

Amazon SageMaker membantu Anda mengevaluasi model baru dengan pengujian bayangan pada performanya terhadap model yang saat ini dilakukan deployment menggunakan permintaan inferensi langsung. Pengujian bayangan dapat membantu Anda menangkap potensi kesalahan konfigurasi dan masalah performa sebelum berdampak pada pengguna akhir. Dengan SageMaker, Anda tidak perlu menginvestasikan waktu berminggu-minggu untuk membangun infrastruktur pengujian bayangan Anda sendiri, yang berarti Anda dapat merilis model agar lebih cepat diproduksi. Cukup pilih model produksi yang ingin Anda uji dan SageMaker secara otomatis melakukan deployment model baru dalam mode bayangan dan merutekan salinan permintaan inferensi yang diterima oleh model produksi ke model baru secara langsung. SageMaker lalu membuat dasbor langsung yang menunjukkan metrik performa, seperti latensi dan tingkat kesalahan, model baru dan model produksi dengan perbandingan berdampingan. Setelah Anda meninjau hasil pengujian dan memvalidasi model, Anda dapat mempromosikannya ke produksi.

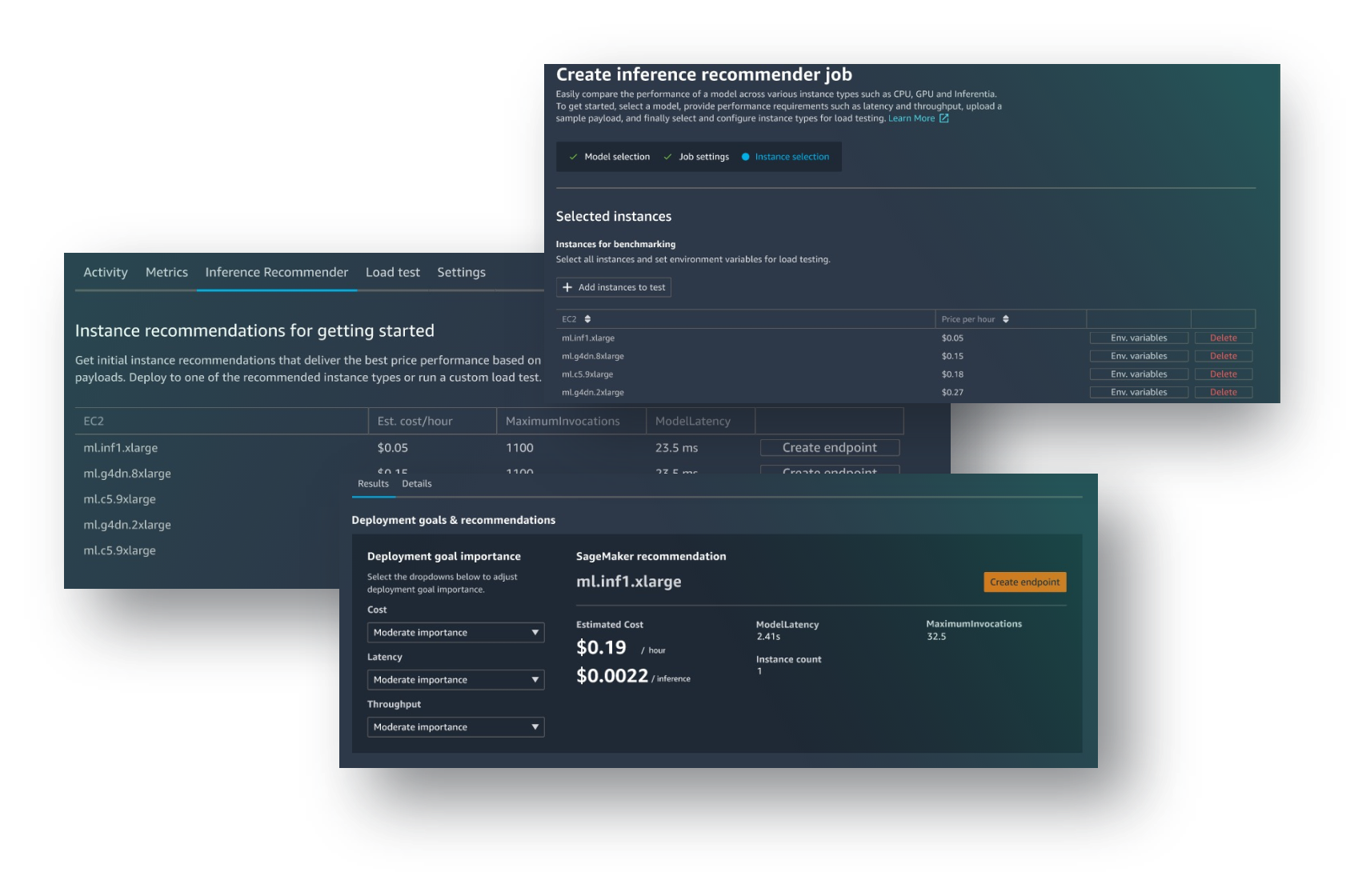

Pemilihan instans inferensi otomatis dan pengujian beban

Amazon SageMaker Inference Recommender membantu Anda memilih instans dan konfigurasi komputasi terbaik yang tersedia untuk melakukan deployment model machine learning demi performa dan biaya inferensi yang optimal. SageMaker Inference Recommender secara otomatis memilih tipe instans komputasi, jumlah instans, parameter kontainer, dan optimisasi model untuk inferensi guna memaksimalkan performa dan meminimalkan biaya.

Penskalaan otomatis untuk elastisitas

Anda dapat menggunakan kebijakan penskalaan untuk secara otomatis menskalakan sumber daya komputasi yang mendasarinya guna mengakomodasi fluktuasi permintaan inferensi. Dengan penskalaan otomatis, Anda dapat menonaktifkan instans ketika tidak digunakan untuk mencegah kapasitas diam dan mengurangi biaya inferensi.

Kurangi beban operasional dan percepat waktu untuk menilai

Hosting dan manajemen model yang terkelola penuh

Sebagai layanan yang terkelola penuh, Amazon SageMaker menangani penyiapan dan pengelolaan instans, kompatibilitas versi perangkat lunak, dan versi tambalan. Amazon SageMaker juga menyediakan metrik dan log bawaan untuk titik akhir yang dapat Anda gunakan guna memantau dan menerima peringatan.

Integrasi bawaan dengan fitur MLOps

Fitur deployment model Amazon SageMaker terintegrasi secara native dengan kemampuan MLOps, termasuk SageMaker Pipelines (otomatisasi dan orkestrasi alur kerja), Proyek SageMaker (CI/CD untuk ML), SageMaker Feature Store (manajemen fitur), SageMaker Model Registry (model dan katalog artefak untuk melacak silsilah dan mendukung alur kerja persetujuan otomatis), SageMaker Clarify (deteksi bias), dan Model SageMaker Monitor (deteksi penyimpangan model dan konsep). Akibatnya, meskipun Anda melakukan depolyment satu atau puluhan ribu model, SageMaker membantu mengurangi biaya tambahan operasional pelaksanaan untuk melakukan deployment, menskalakan, dan mengelola model ML sekaligus membuatnya lebih cepat berproduksi.

Keberhasilan pelanggan

AT&T Cybersecurity meningkatkan deteksi ancaman yang membutuhkan prediksi hampir waktu nyata menggunakan titik akhir multimodel Amazon SageMaker. “Titik akhir multimodel Amazon SageMaker tidak hanya hemat biaya, tetapi juga memberi kami sedikit peningkatan performa yang bagus yang dimulai dari penyederhanaan cara menyimpan model kami.”

Matthew Schneid Chief Architect - AT&T

Forethought Technologies, penyedia solusi AI generatif untuk layanan pelanggan, mengurangi biaya hingga 80 persen menggunakan Amazon SageMaker. “Dengan bermigrasi ke titik akhir multimodel Amazon SageMaker, kami mengurangi biaya hingga 66% sekaligus memberikan latensi yang lebih baik dan waktu respons yang lebih baik bagi pelanggan.”

Jad Chamoun, Director of Core Engineering - Forethought Technologies

Bazaarvoice mengurangi biaya inferensi ML sebesar 82% menggunakan Inferensi Nirserver SageMaker. “Dengan Inferensi Nirserver SageMaker, kami dapat melakukan ML secara efisien dalam skala besar, dengan cepat mengeluarkan banyak model dengan biaya yang wajar dan dengan biaya tambahan operasional yang rendah.”

Lou Kratz, Rekayasawan Riset Utama (Principal Research Engineer), Bazaarvoice

Tapjoy menggunakan Amazon SageMaker untuk melakukan deployment Model ML dalam hitungan hari, alih-alih bulan. “Kami telah beralih dari proses yang memakan waktu sekitar tiga hingga enam bulan untuk melatih, membangun, dan melakukan deployment model. Sekarang dengan SageMaker, kami bisa melakukannya hanya dalam waktu satu minggu, atau bahkan mungkin lebih cepat.”

Nick Reffitt, Vice President of Data Science and Engineering - Tapjoy

Amazon SageMaker dan Hugging Face telah berkolaborasi untuk menyederhanakan dan mempercepat adopsi model transformator dengan Hugging Face DLC, integrasi dengan SageMaker Training Compiler, dan pustaka terdistribusi SageMaker.

Zendesk melakukan hosting ribuan model ML di titik akhir multimodal Amazon SageMaker (MME) untuk fitur Makro yang Direkomendasikan dan mencapai penghematan biaya sebesar 90% dalam hal inferensi jika dibandingkan dengan titik akhir khusus. “Kami melakukan deployment ribuan model ML yang disesuaikan untuk lebih dari 100 rb pelanggan kami menggunakan titik akhir multimodel Amazon SageMaker (MME). Dengan SageMaker MME, kami membangun kemampuan inferensi multipenghuni dan ramah SaaS untuk meng-host beberapa model per titik akhir sehingga mengurangi biaya inferensi hingga 90% dibandingkan dengan titik akhir khusus.”

Chris Hausler, Kepala AI/ML (Head of AI/ML), Zendesk

Sumber daya

AWS re:Invent 2022 - Lakukan deployment model ML untuk inferensi dengan performa tinggi & biaya rendah, ft AT&T (AIM302)

Ikuti tutorial langkah demi langkah ini untuk melakukan deployment model untuk inferensi menggunakan Amazon SageMaker.

Di lab praktis ini, pelajari cara menggunakan Amazon SageMaker untuk membangun, melatih, dan melakukan deployment model ML.