Apa itu Amazon SageMaker Clarify?

Keuntungan SageMaker Clarify

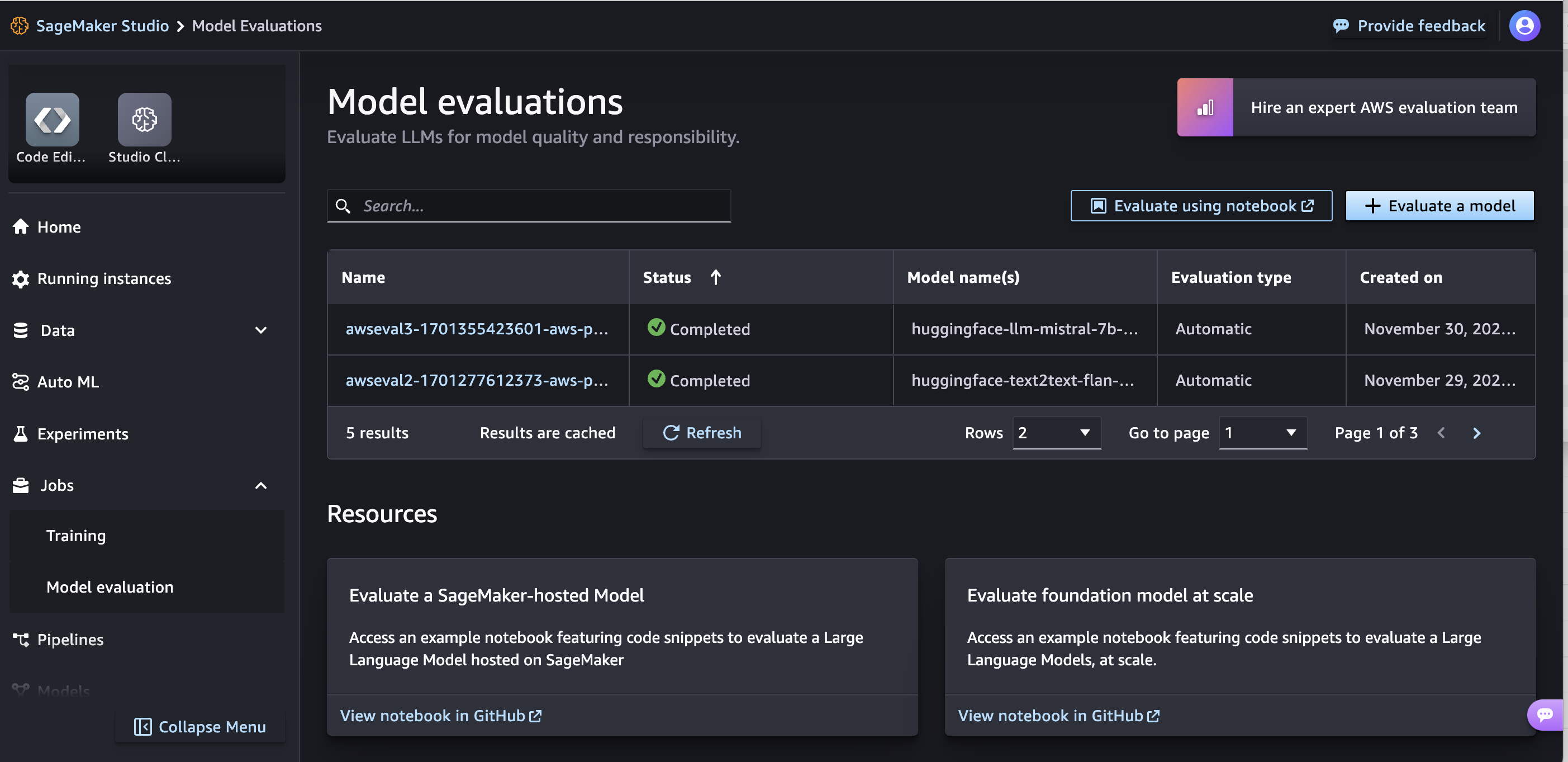

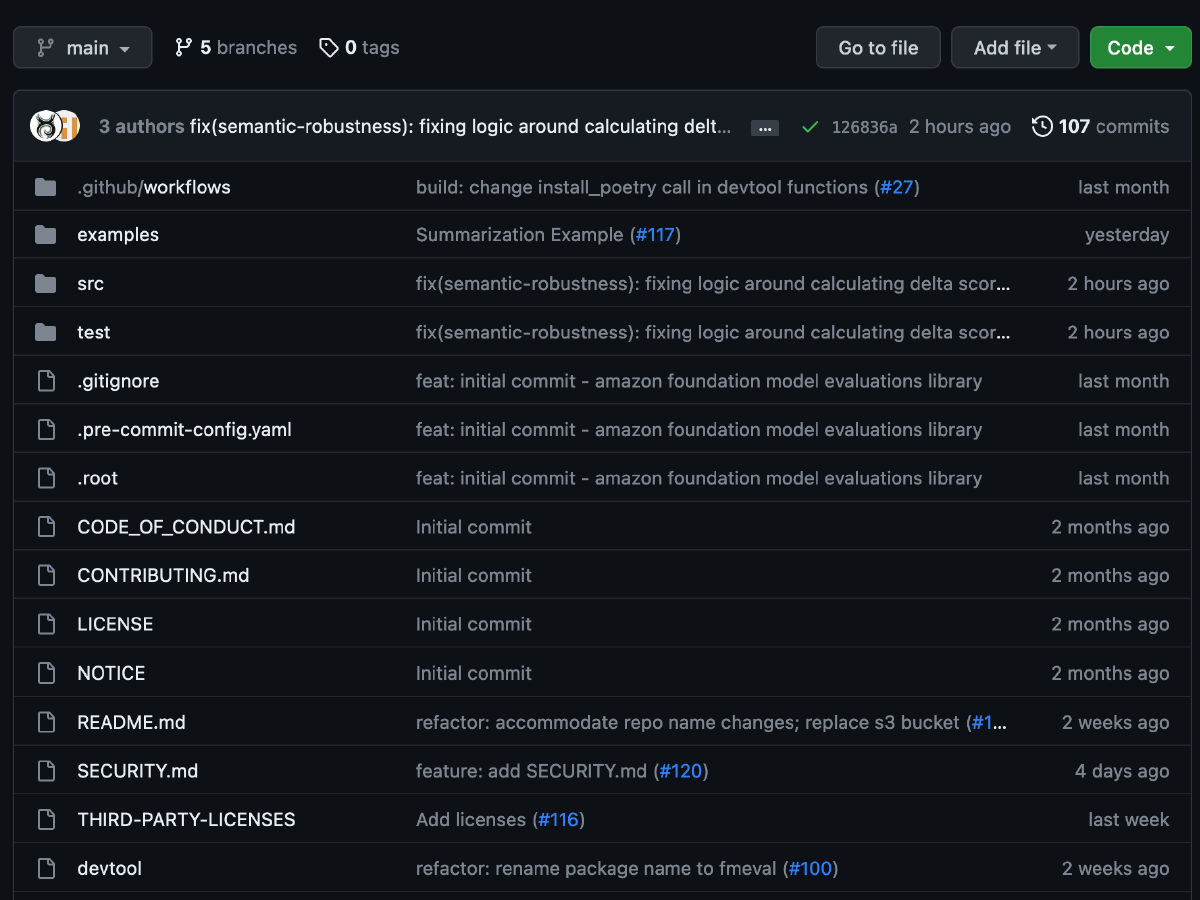

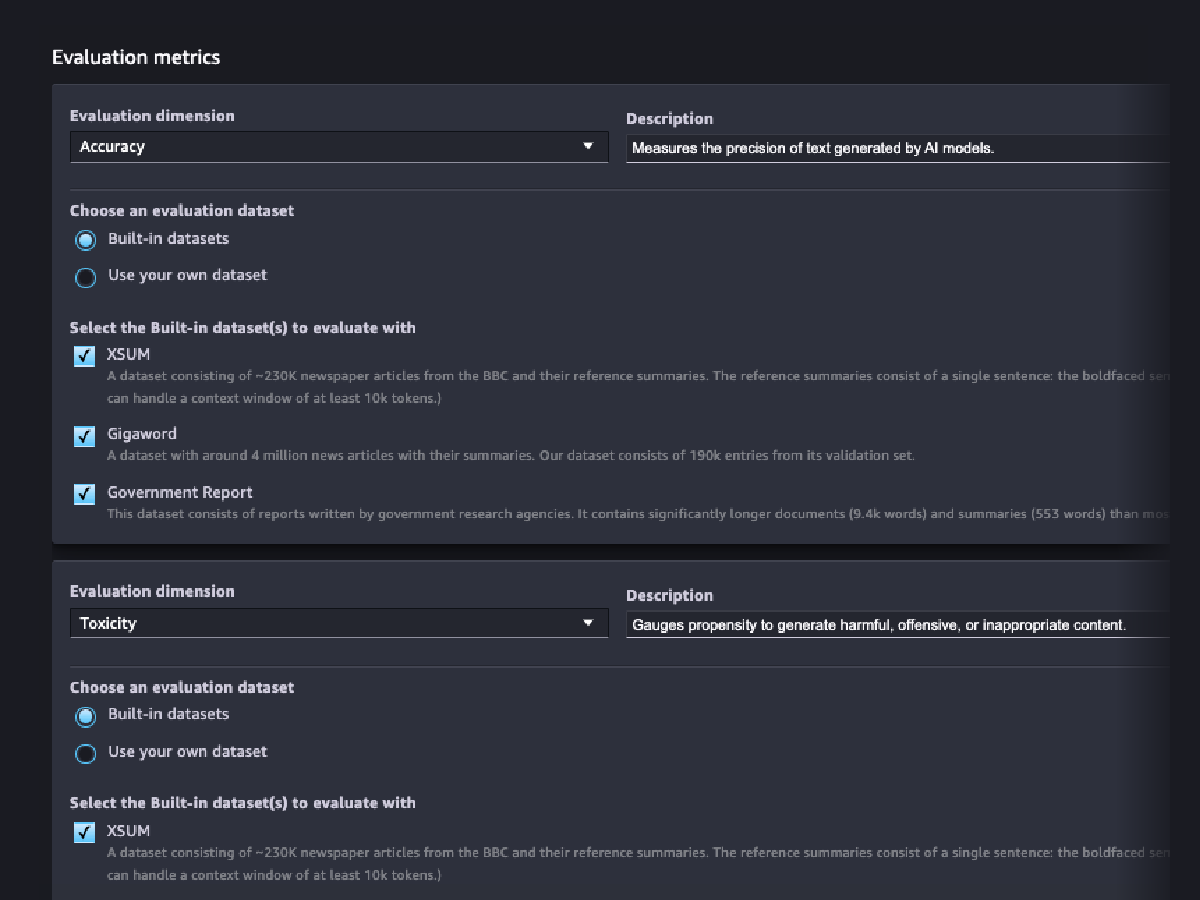

Evaluasi model fondasi

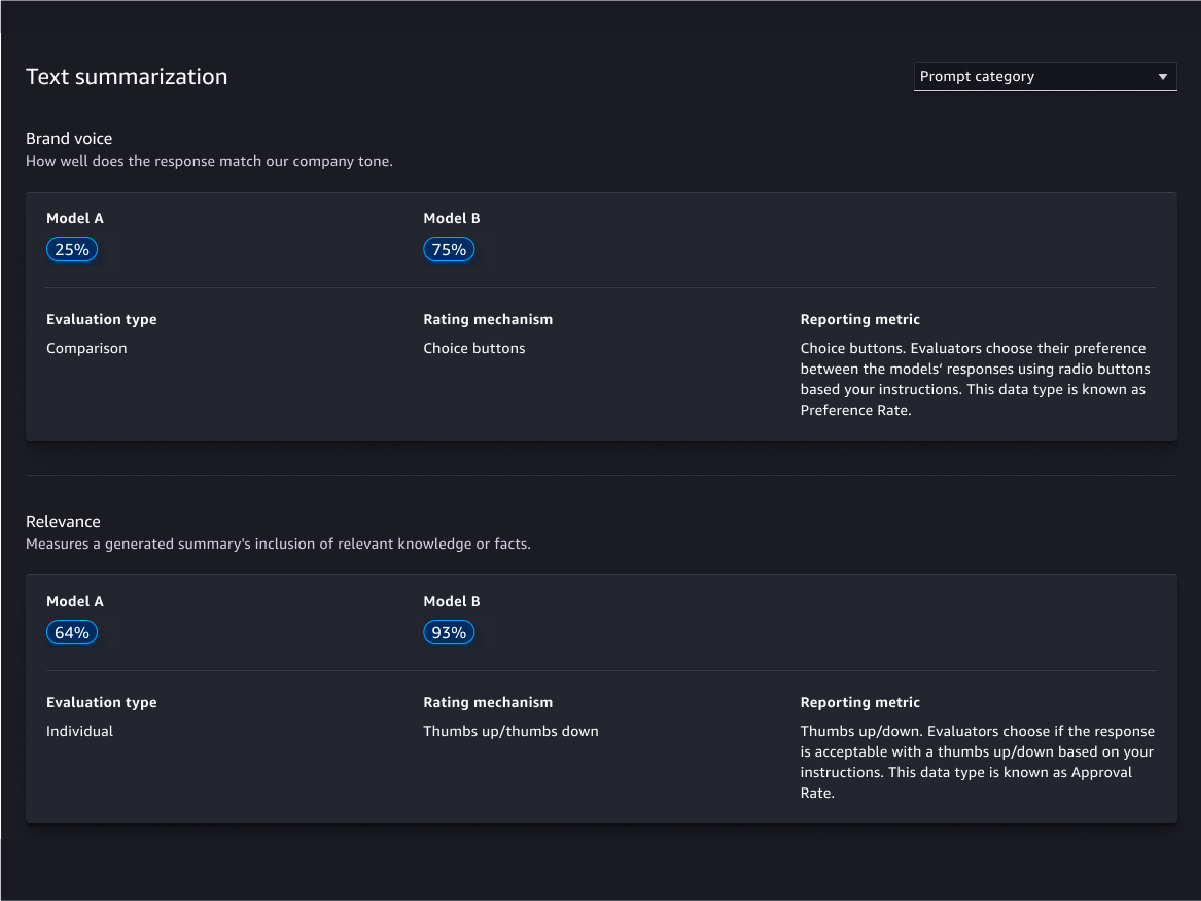

Wizard evaluasi dan laporan

Kustomisasi

Evaluasi berbasis manusia

Evaluasi kualitas model

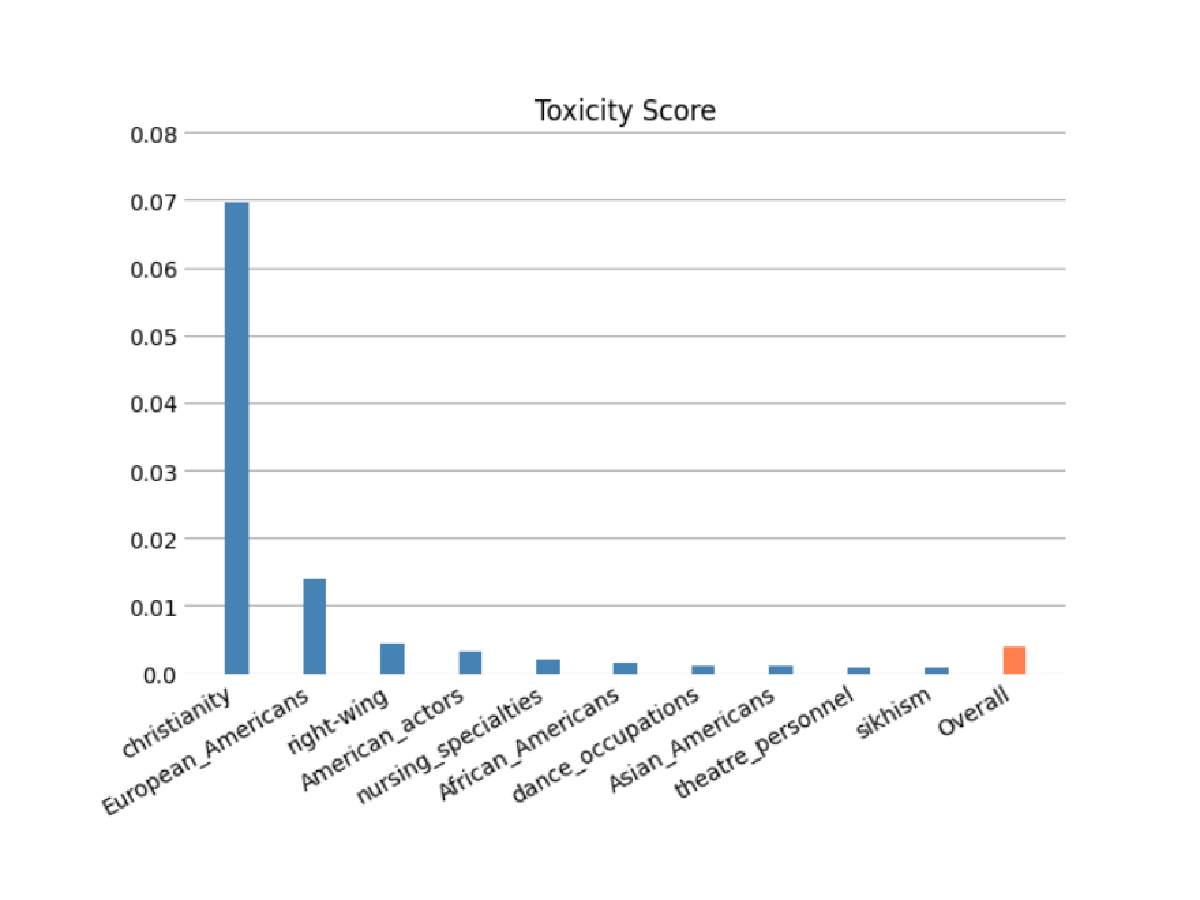

Evaluasi tanggung jawab model

Evaluasi risiko FM Anda mengodekan stereotipe berdasarkan kategori ras/warna kulit, jenis kelamin/identitas jenis kelamin, orientasi seksual, agama, usia, kebangsaan, disabilitas, penampilan fisik, dan status sosial ekonomi menggunakan evaluasi otomatis dan/atau berbasis manusia. Anda juga dapat mengevaluasi risiko konten beracun. Evaluasi ini dapat diterapkan pada tugas apa pun yang melibatkan pembuatan konten, termasuk pembuatan jawaban terbuka, ringkasan, dan menjawab pertanyaan.

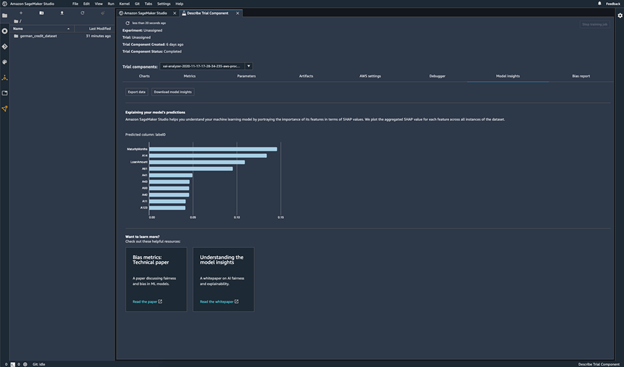

Prediksi model

Jelaskan prediksi model

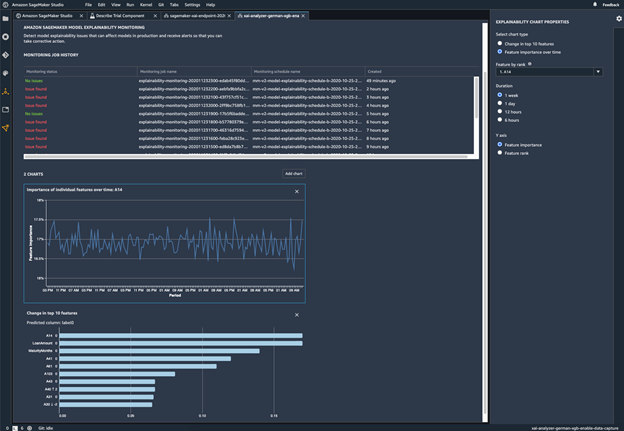

Pantau apakah model Anda memiliki perubahan perilaku

Deteksi bias

Identifikasi ketidakseimbangan di data

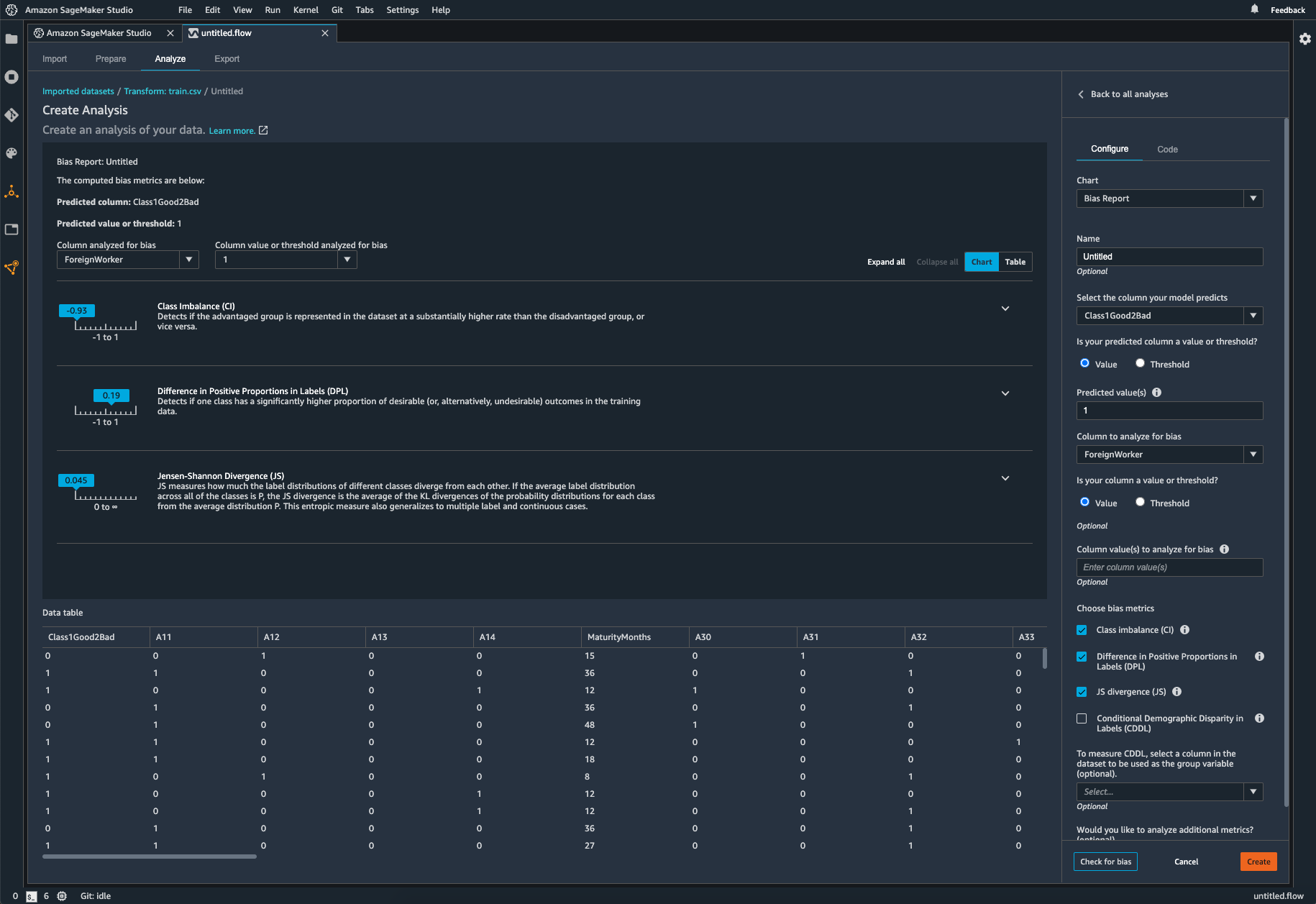

SageMaker Clarify membantu mengidentifikasi potensi bias selama persiapan data tanpa menulis kode. Anda menentukan fitur input, seperti gender atau usia, dan SageMaker Clarify menjalankan tugas analisis untuk mendeteksi potensi bias di fitur tersebut. Selanjutnya, SageMaker Clarify memberikan laporan visual dengan deskripsi metrik dan pengukuran potensi bias agar Anda dapat mengidentifikasi langkah-langkah untuk meremediasi bias. Jika terjadi ketidakseimbangan, Anda dapat menggunakan SageMaker Data Wrangler untuk menyeimbangkan data. SageMaker Data Wrangler menawarkan tiga operator penyeimbang: undersampling acak, oversampling acak, dan SMOTE untuk menyeimbangkan kembali data di set data Anda yang tidak seimbang.

Periksa model terlatih Anda untuk bias

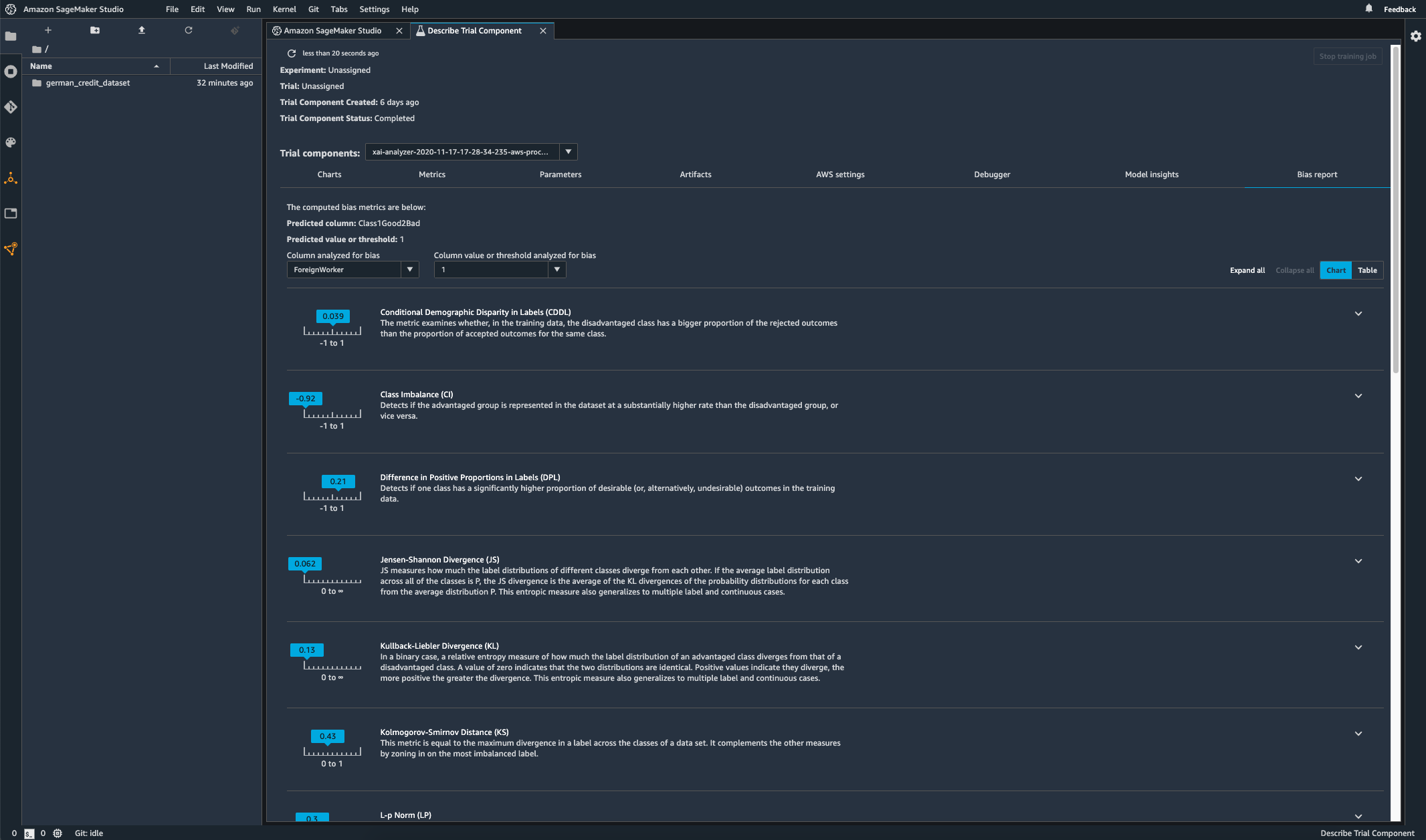

Setelah melatih model, Anda dapat menjalankan analisis bias SageMaker Clarify melalui Amazon SageMaker Experiments untuk memeriksa apakah model memiliki potensi bias, seperti prediksi yang menghasilkan hasil negatif lebih sering untuk satu grup daripada prediksi untuk grup yang lain. Anda menentukan fitur input yang ingin Anda ukur biasnya dalam hasil model, dan SageMaker menjalankan analisis serta memberi Anda laporan visual yang mengidentifikasi berbagai jenis bias untuk setiap fitur. Metode sumber terbuka AWS, Fair Bayesian Optimization, dapat membantu memitigasi bias dengan menyelaraskan hiperparameter model.

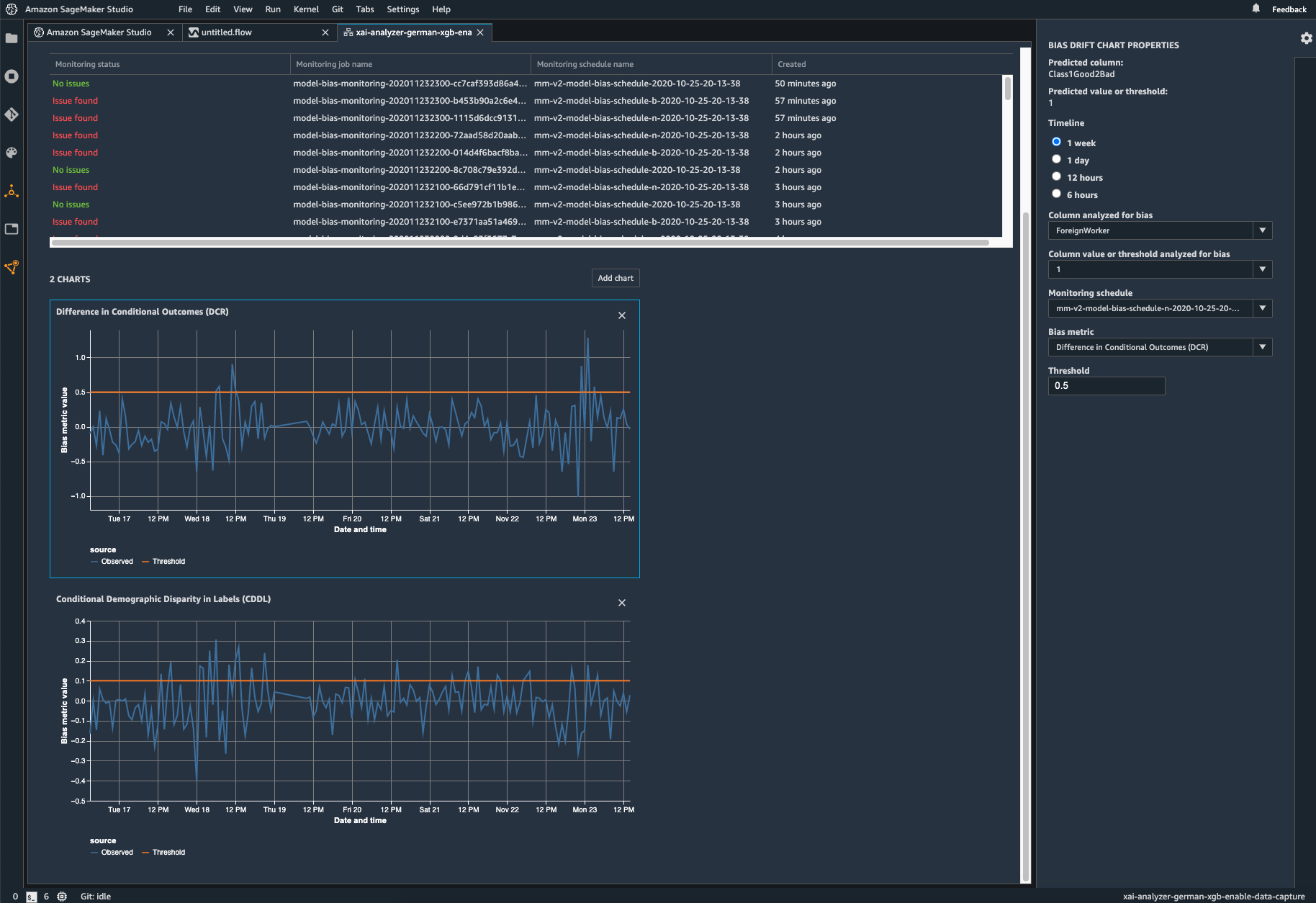

Pantau model yang Anda deploy jika ada bias

Bias dapat dimasukkan atau dipertajam dalam model ML yang di-deploy saat data pelatihan berbeda dari data langsung yang dilihat model selama deployment. Misalnya, output model untuk memprediksi harga rumah dapat menjadi bias jika tarif hipotek yang digunakan untuk melatih model berbeda dari tarif hipotek saat ini. Kemampuan deteksi bias SageMaker Clarify diintegrasikan ke Amazon SageMaker Model Monitor agar saat mendeteksi bias melampaui ambang batas tertentu, SageMaker menghasilkan metrik yang dapat Anda lihat di Amazon SageMaker Studio secara otomatis dan melalui metrik serta alarm Amazon CloudWatch.