Cos'è Amazon SageMaker Clarify?

Amazon SageMaker Clarify fornisce strumenti personalizzati per ottenere maggiori informazioni sui tuoi modelli e dati di ML, basati su metriche quali precisione, robustezza, tossicità e distorsioni per migliorare la qualità del modello e supportare un'iniziativa di intelligenza artificiale responsabile. Con l'avvento dell'IA generativa, i data scientist e gli ingegneri ML possono sfruttare i modelli di fondazione (FM) disponibili al pubblico per accelerare la velocità di commercializzazione. Per eliminare il problema della valutazione e della selezione dell'FM giusto per il tuo caso d'uso, Amazon SageMaker Clarify supporta la valutazione dei FM per aiutarti a valutare, confrontare e selezionare rapidamente l'FM migliore per il tuo caso d'uso in base a una varietà di criteri e diverse attività in pochi minuti. Ti consente di adottare i FM più velocemente e con sicurezza. Per i modelli tabulari, di visione artificiale e di serie temporali, SageMaker Clarify offre la spiegabilità del modello durante lo sviluppo del modello o l'implementazione post-modello. È possibile utilizzare i report sulle distorsioni e sulla spiegabilità per identificare potenziali problemi e quindi indirizzare gli sforzi per migliorare la precisione, eliminare le distorsioni e aumentare le prestazioni.

Vantaggi di SageMaker Clarify

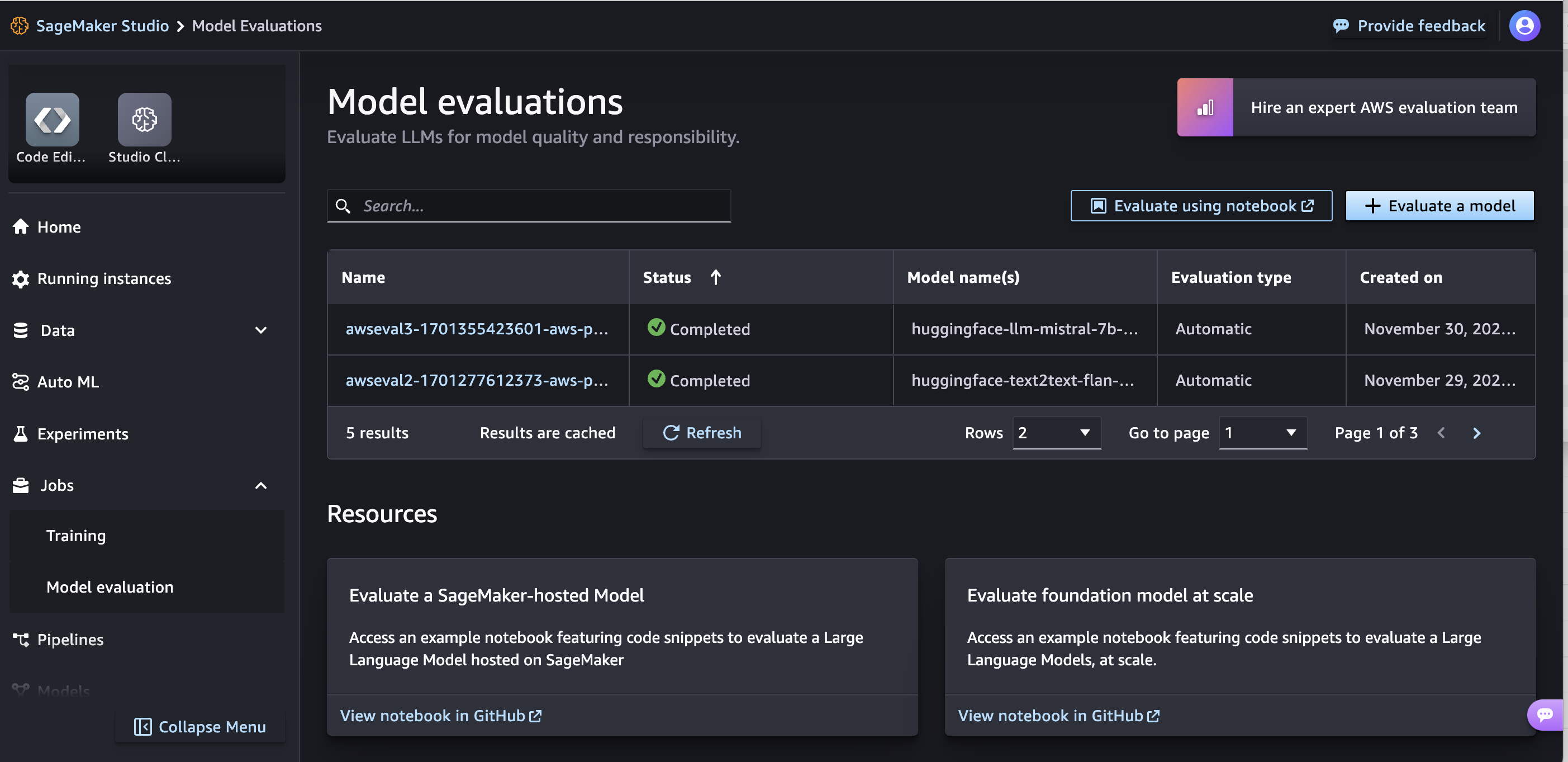

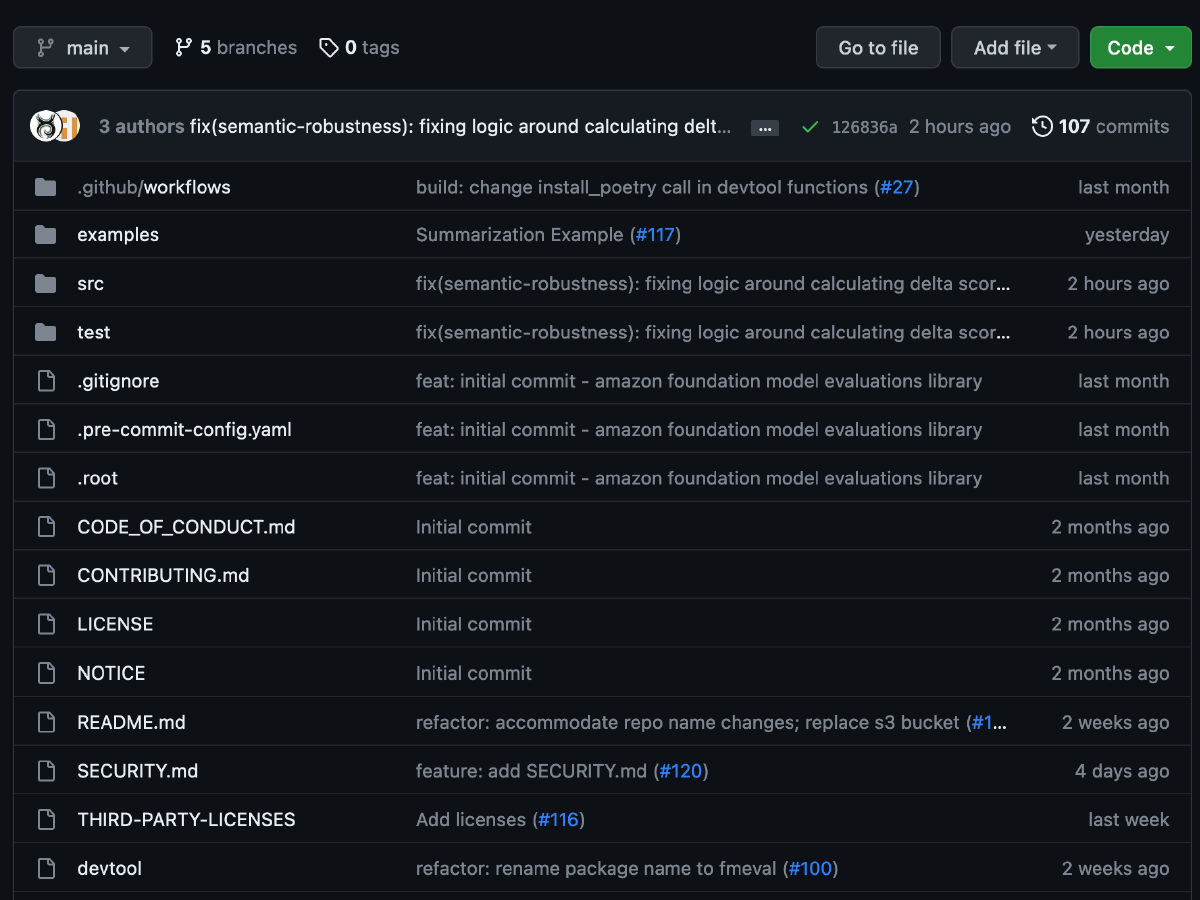

Valuta i modelli di fondazione

Procedura guidata e report di valutazione

Personalizzazione

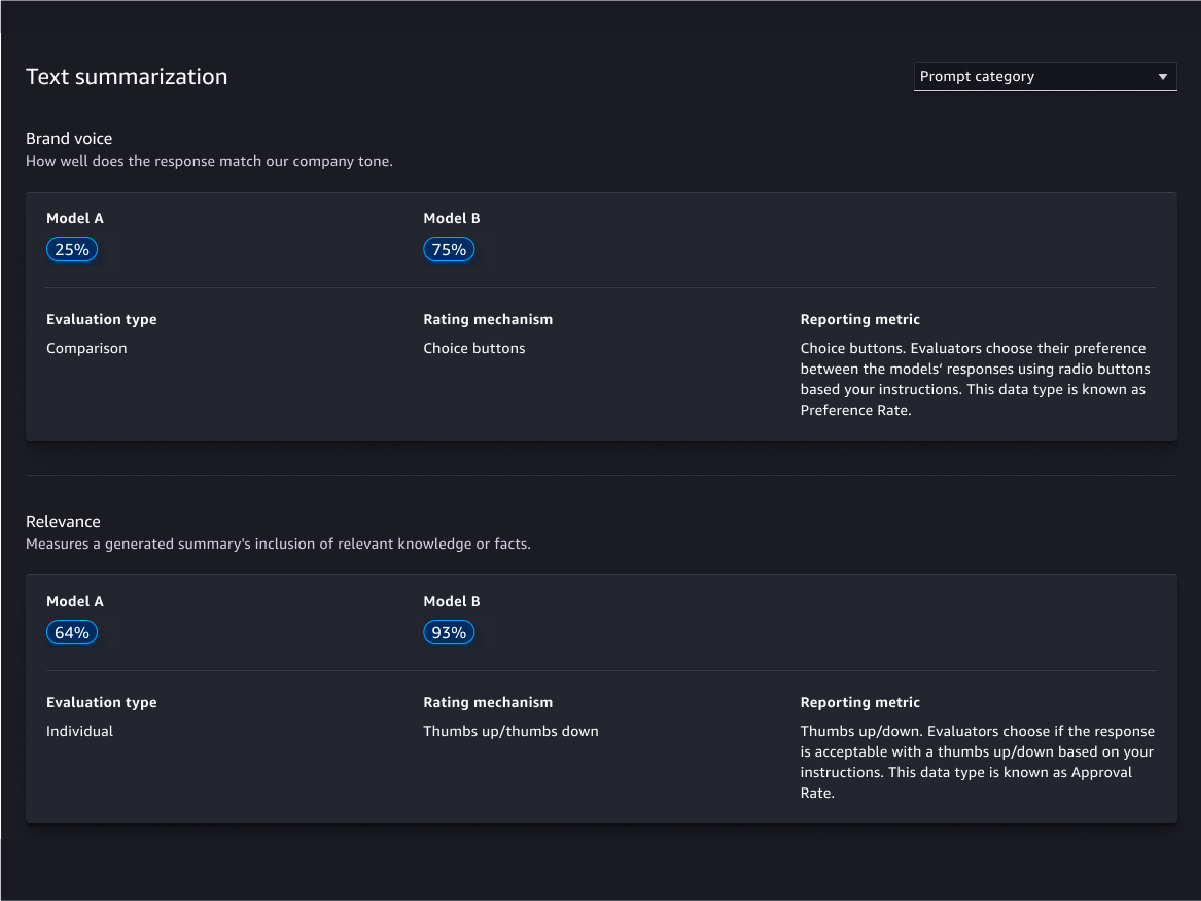

Valutazioni su base umana

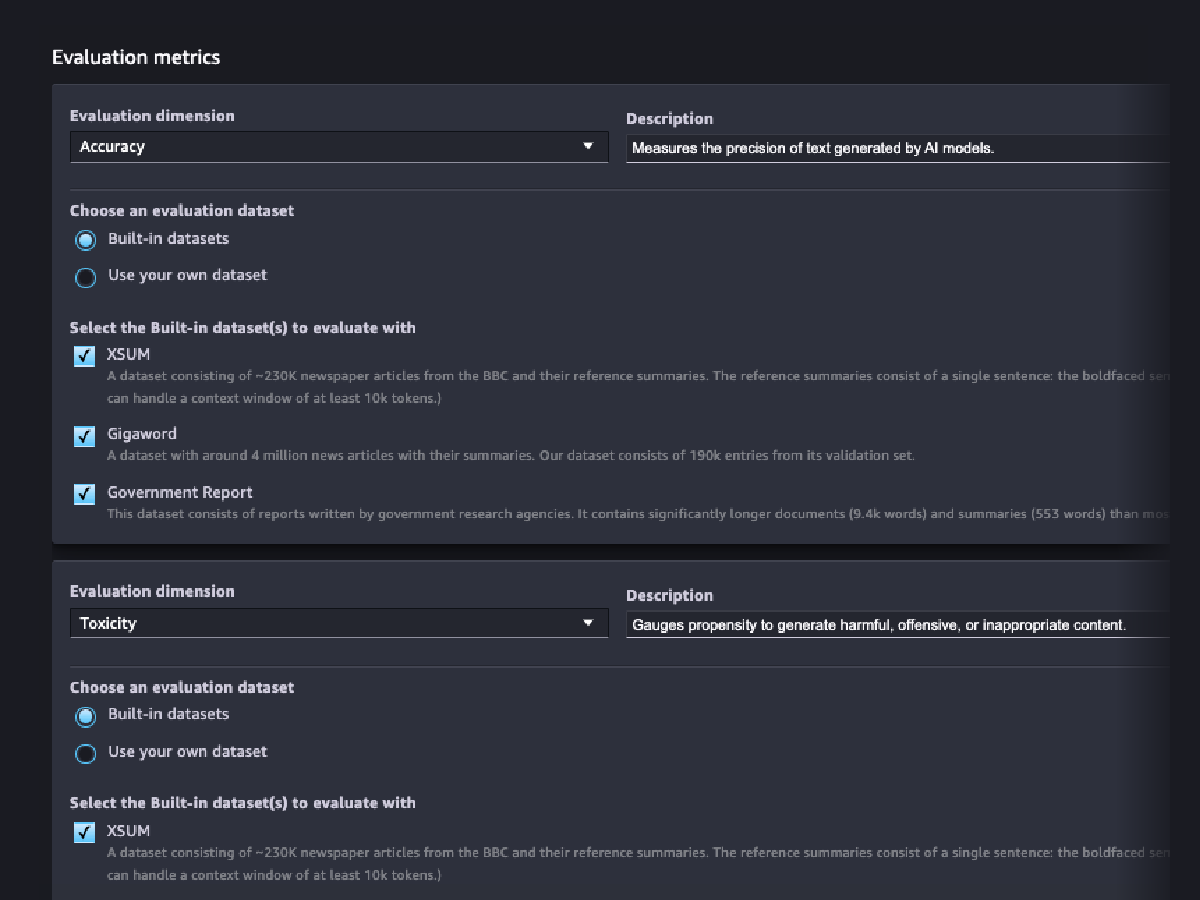

Valutazioni della qualità del modello

Valutazioni della responsabilità del modello

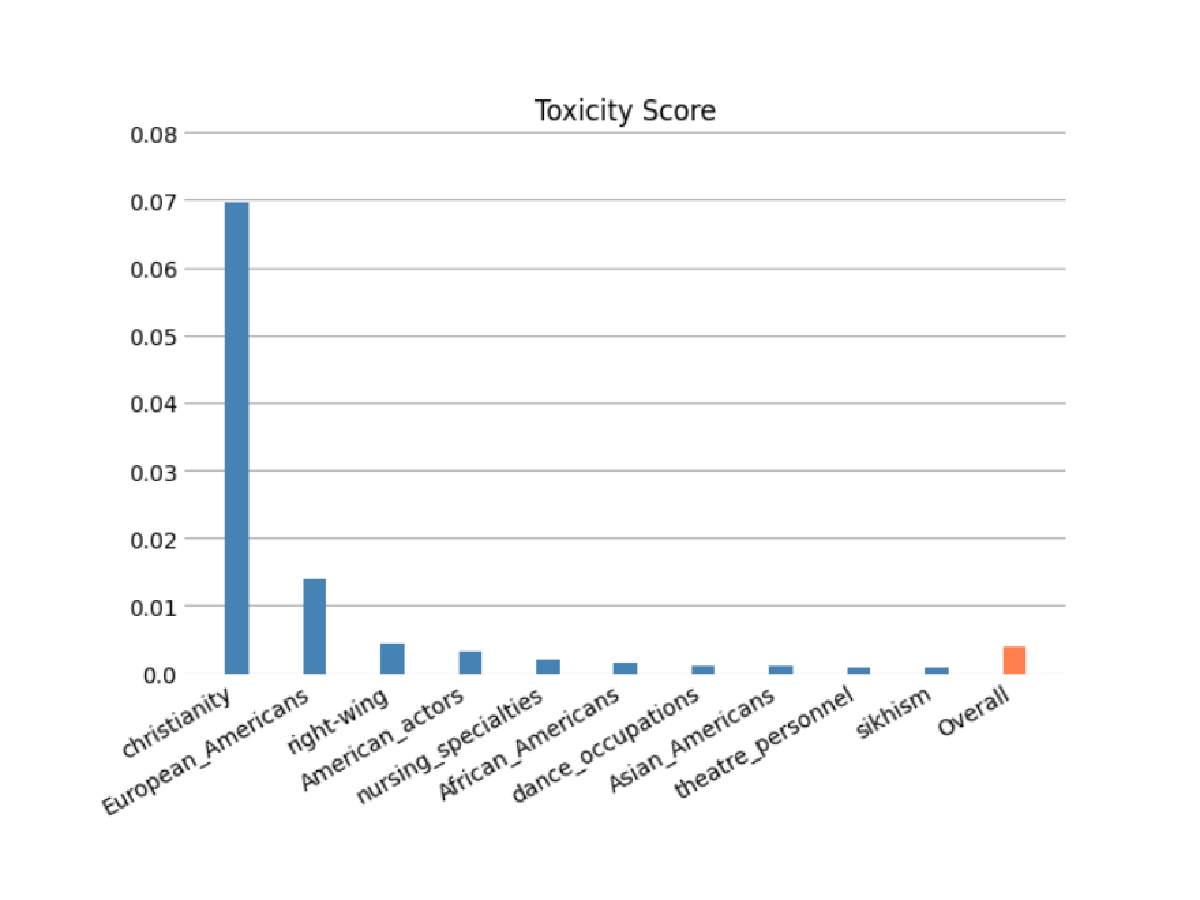

Valuta il rischio che il FM possa aver codificato degli stereotipi nelle categorie di razza/colore, genere/identità di genere, orientamento sessuale, religione, età, nazionalità, disabilità, aspetto fisico e condizione socioeconomica utilizzando valutazioni automatiche e/o eseguite a umani. Inoltre, è possibile valutare il rischio della presenza di contenuti inappropriati. Queste valutazioni possono essere applicate a qualsiasi attività che implichi la generazione di contenuti, tra cui la generazione aperta, la sintesi e la risposta alle domande.

Previsioni del modello

Spiega le previsioni del modello

Monitora il modello per rilevare cambiamenti nel comportamento

Rilevamento dei bias

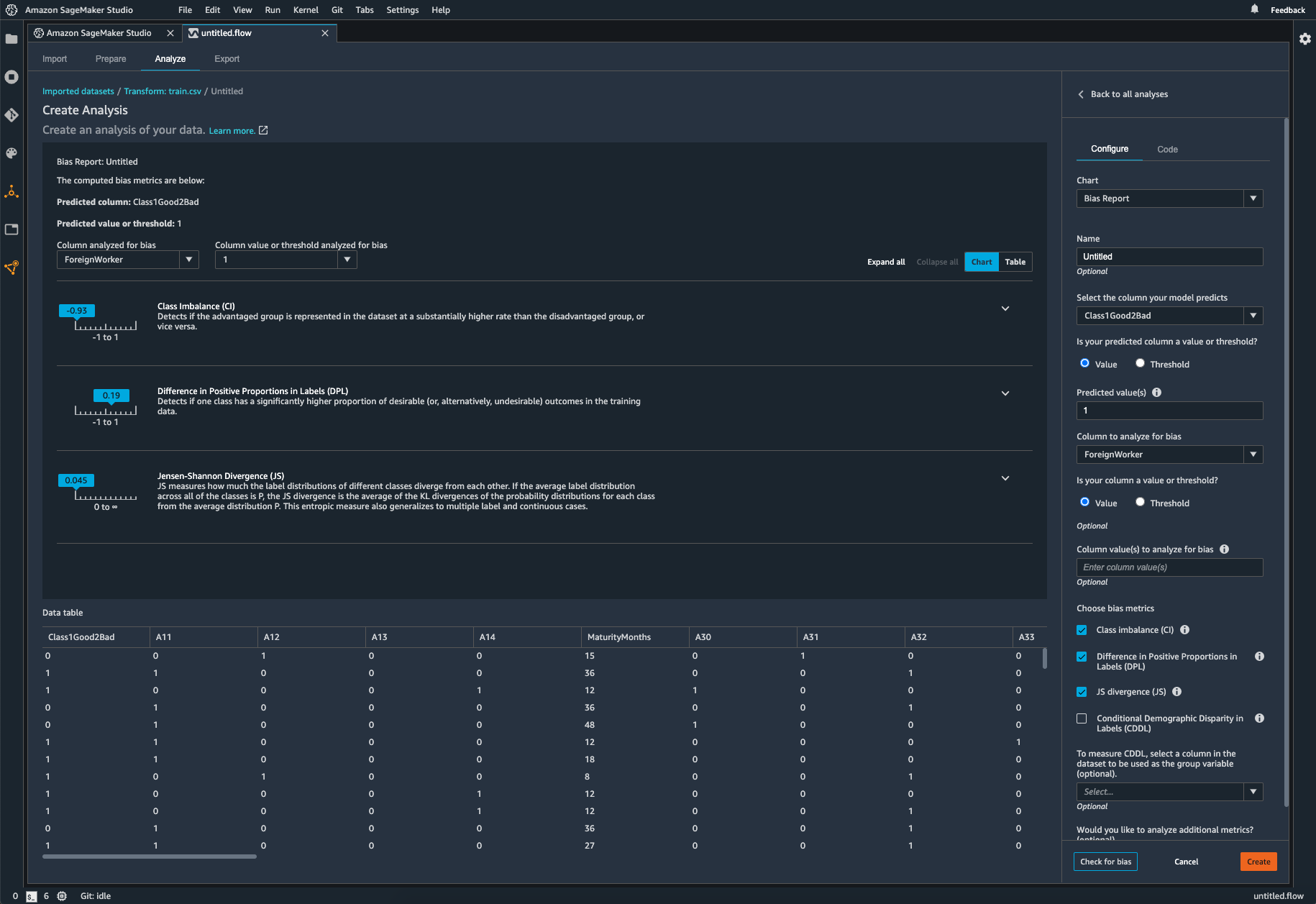

Identificazione degli squilibri nei dati

SageMaker Clarify aiuta a identificare potenziali distorsioni durante la preparazione dei dati senza scrivere codice. Specifica le funzioni di input, come il sesso o l'età, e SageMaker Clarify esegue un processo di analisi per rilevare potenziali distorsioni in tali funzioni. SageMaker Clarify fornisce quindi un rapporto visivo con una descrizione dei parametri e delle misurazioni di possibili distorsioni, in modo da poter identificare i passaggi per correggere tali distorsioni. In caso di squilibri, puoi utilizzare SageMaker Data Wrangler per bilanciare i tuoi dati. SageMaker Data Wrangler offre tre operatori per il bilanciamento: sottocampionamento casuale, sovracampionamento casuale e SMOTE per ribilanciare i dati nei set di dati sbilanciati.

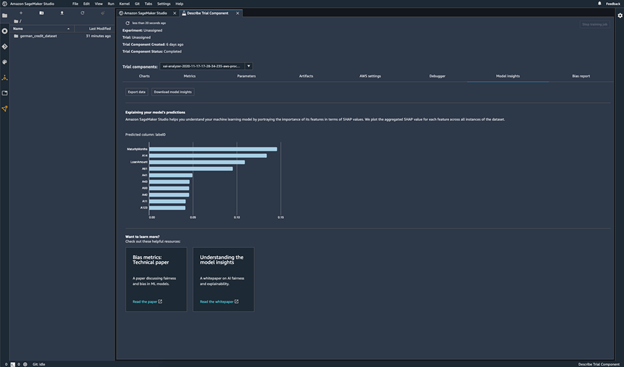

Controlla il modello addestrato per rilevare le distorsioni

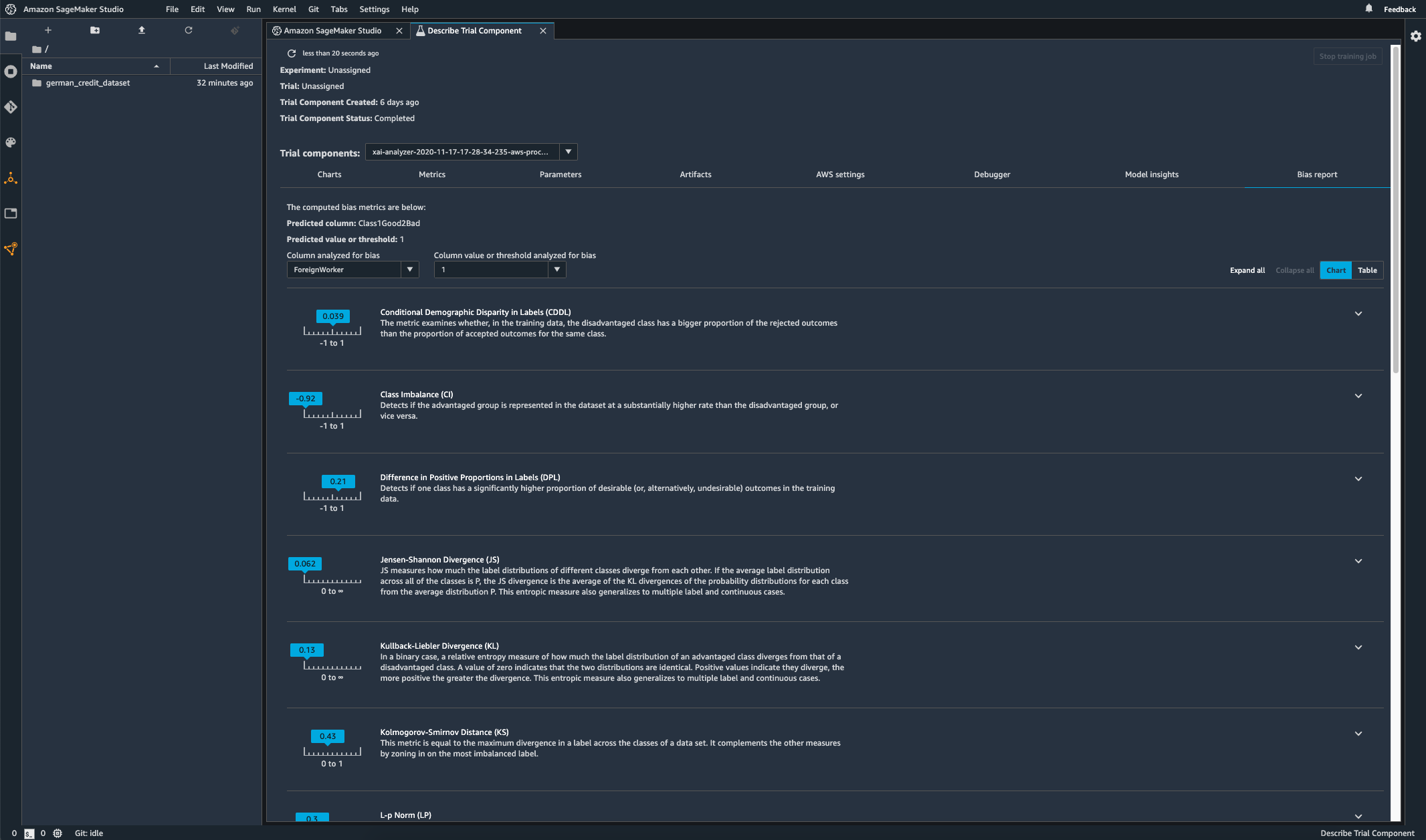

Dopo aver addestrato il modello, potrai eseguire un'analisi della distorsione di SageMaker Clarify tramite Esperimenti Amazon SageMaker per controllare la presenza di potenziali distorsioni nel tuo modello, come ad esempio le previsioni che producono un risultato negativo più frequentemente per un gruppo che per un altro. Specifichi le caratteristiche di input rispetto alle quali desideri misurare la distorsione nei risultati del modello, e SageMaker esegue un'analisi e fornisce un rapporto visivo che identifica i diversi tipi di distorsione per ciascuna caratteristica. Il metodo open source di AWS Fair Bayesian Optimization può aiutare a mitigare le distorsioni ottimizzando gli iperparametri di un modello.

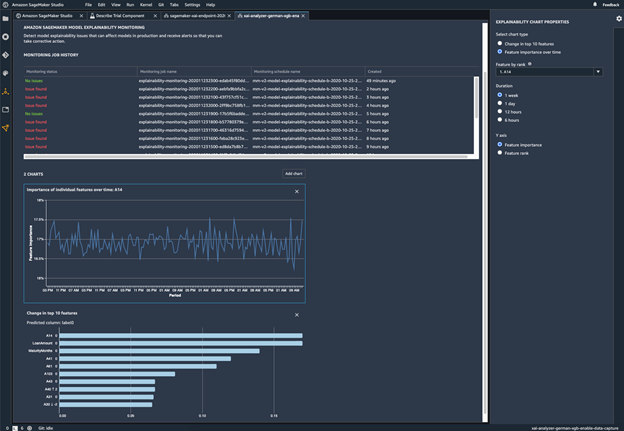

Monitora il modello implementato per individuare eventuali distorsioni

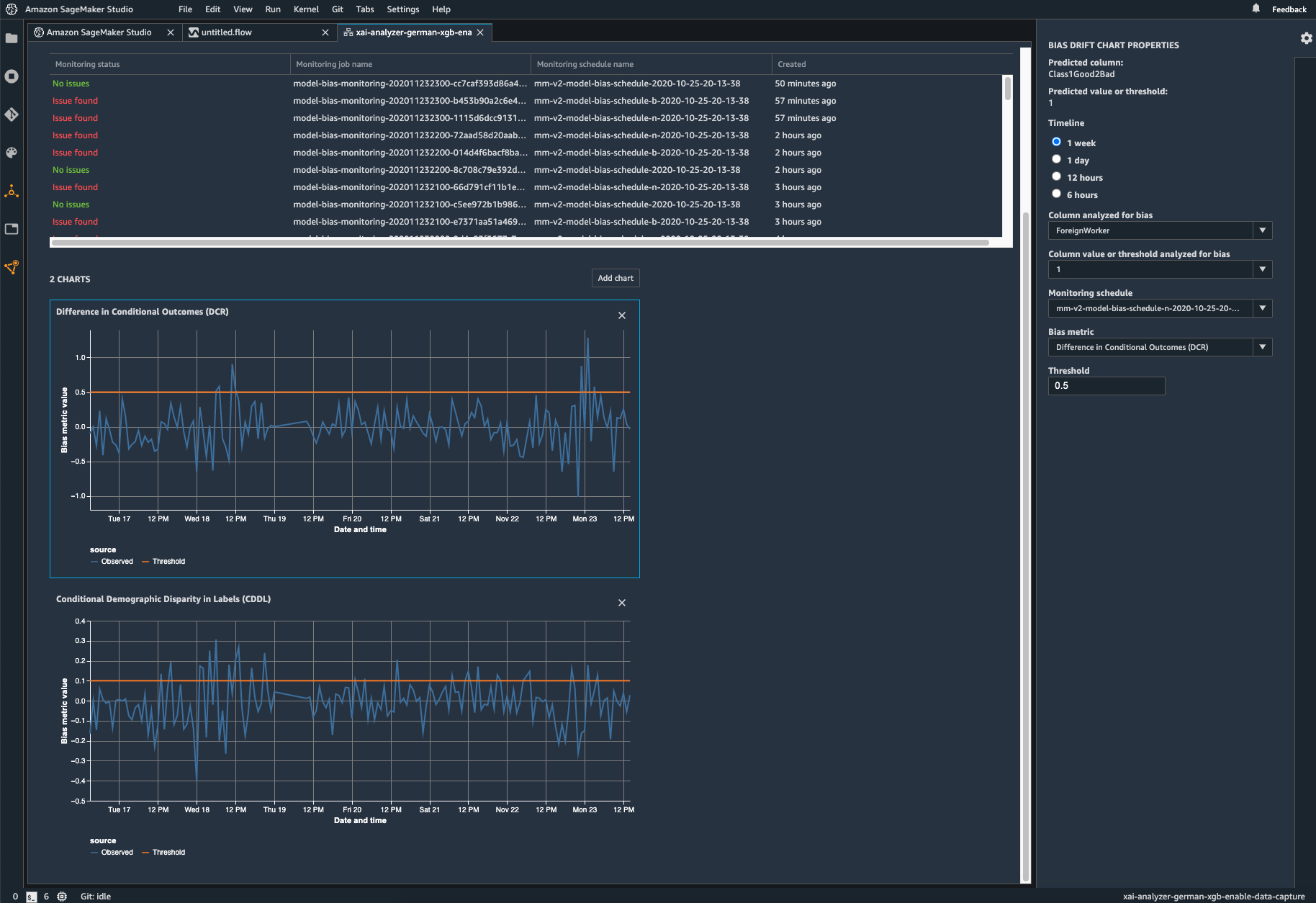

La distorsione può essere introdotta o esacerbata nei modelli ML distribuiti quando i dati di addestramento differiscono dai dati in tempo reale che il modello vede durante l'implementazione. Ad esempio, i risultati di un modello per la previsione dei prezzi delle case possono diventare distorti se i tassi ipotecari utilizzati per addestrare il modello differiscono dai tassi ipotecari attuali. Le funzionalità di rilevamento delle distorsioni di SageMaker Clarify sono integrate in Amazon SageMaker Model Monitor, in modo che quando SageMaker rileva distorsioni oltre una certa soglia, generi automaticamente delle metriche che possono essere visualizzate in Amazon SageMaker Studio e tramite metriche e avvisi Amazon CloudWatch.

Risorse

Novità

- Data (dalla più alla meno recente)