Amazon Web Services ブログ

AWS で DER アグリゲーター向けのスケーラブルな DERMS ソリューションを構築する

エネルギー環境が分散型モデルへと進化する中、分散型エネルギーリソース (DER) は、エネルギー市場のさまざまなプレーヤー (電力会社、立法機関、アグリゲーター、消費者、サービスプロバイダー) に課題と機会の両方をもたらしています。

さまざまな関係者が Amazon Web Services (AWS) を活用して DER を最大限に活用する方法について、一連のブログを計画しています。最初のブログでは、アグリゲーターが事業の成長に合わせて拡張できる堅牢な分散型エネルギーリソース管理システム (DERMS) を構築するために、AWS サービスがどのように役立つかを探ります。

Amazon RDS for SQL Server での追加のストレージボリューム設定

この投稿では、Amazon RDS for SQL Server インスタンス向けの追加ストレージボリューム機能を紹介し、実用的な実装シナリオを説明します。追加ストレージボリュームは、ワークロードタイプ別にデータを整理する柔軟性を提供し、専用の IOPS 割り当てによってパフォーマンスを向上させ、高可用性と耐久性を維持しながらストレージを独立してスケールすることができます。

Amazon Aurora PostgreSQL および Amazon RDS for PostgreSQL のバージョン 13 からのアップグレード戦略

本記事は 2026 年 1 月 27 日 に公開された「Strategies for upgrading Am […]

AWS Entity Resolution でのルールベース・機械学習ベースマッチングの精度測定方法

本記事では、AWS Entity Resolution でルールベース・機械学習ベースのマッチング精度を測定する方法を解説します。企業が顧客データを統合する際、アイデンティティマッチングの精度を客観的に評価する手法が不足しているという課題に対し、F1 スコアを用いた評価フレームワークとオープンソースの BPID データセットを活用した実践的な測定方法を紹介します。

教育者を支援: Innovation Sandbox on AWS が学習目標の達成を加速する方法

生成 AI がテクノロジーの世界を変える中、教育機関は学生にサンドボックス環境を提供し、イノベーションを推進しています。本記事では、Innovation Sandbox on AWS を使用して、安全でコスト効率に優れた再利用可能なサンドボックス環境を大規模に管理し、数週間の管理時間を節約しながら、学生と教員が AWS でイノベーションを起こす自由を提供する方法を紹介します。

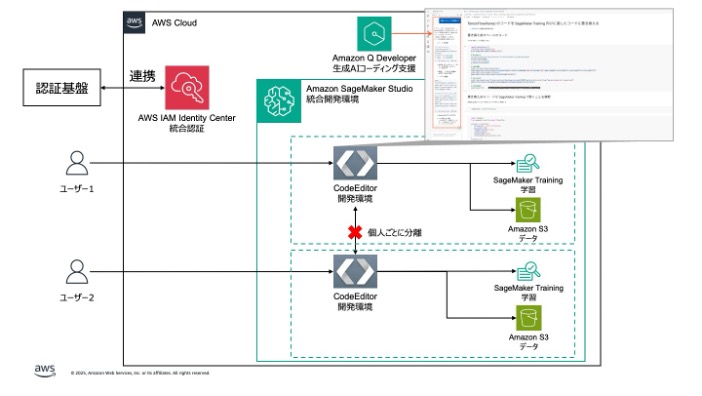

寄稿: JFE スチールが挑むインテリジェント製鉄所への道 – Amazon SageMaker AI による CPS 開発実行基盤の構築

JFE スチール株式会社における Amazon SageMaker AI を中核とした CPS 開発実行基盤の構築事例をご紹介します。ブログの中では、プロジェクトの背景、開発体制、AWS の活用方法、そして今後の AWS IoT Greengrass によるエッジ配信基盤の展開についても解説します。

Amazon Redshift Serverless のキューベース QMR できめ細かなリソース制御を実現する

Amazon Redshift Serverless のキューベース Query Monitoring Rules (QMR) を使用して、ワークロードごとに専用キューを作成し、リソース使用量をきめ細かく制御する方法を学びます。クエリの自動中止、ログ記録、制限により、ビジネスクリティカルなクエリを保護し、コストを管理できます。

テスト時間を最大 90% 削減 – Amazon Connect のテストとシミュレーション機能

Amazon Connect はネイティブのテストとシミュレーション機能を発表しました。外部ツールや手動での電話テストなしでコンタクトフローを自動的にテストでき、検証時間を削減します。直感的なビジュアルデザイナーでテストケースを作成し、イベント駆動型モデルで自然な顧客インタラクションをシミュレートできます。このブログ記事ではテストの概要、実践例とベストプラクティスを紹介します。

Amazon Connect の裏側: イノベーターとしての進化

Amazon Connect は 2017 年のローンチ以来、AI を活用したカスタマーエクスペリエンスソリューションのリーダーとして進化し、年間売上高 10 億ドルのランレートを達成しました。内部プロジェクトから始まり、現在では AI が 120 億分の顧客インタラクションを最適化する、業界をリードするサービスとなっています。このブログ記事では Amazon の内部ソリューションから AI のパイオニアとなるまでの Amazon Connect のストーリーを探ります。

RDS for Db2 でトラブルシューティングに必要な情報を収集する

本記事では、Amazon Relational Database Service (Amazon RDS) f […]