ما المقصود بالتعليم بواسطة التعزيز من الملاحظات البشرية (RLHF)؟

التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF) هو أسلوب من أساليب تعلّم الآلة (ML) يستخدم الملاحظات البشرية لتحسين نماذج تعلّم الآلة من أجل التعلم الذاتي بشكل أكثر كفاءة. تعمل تقنيات التعليم بواسطة التعزيز (RL) على تدريب البرامج على اتخاذ القرارات التي تحصل على أكثر قدر ممكن من المكافآت، مما يجعل نتائجها أكثر دقة. في أسلوب التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF)، تُدمَج الملاحظات البشرية في دالة المكافآت، لذلك يمكن لنموذج تعلّم الآلة أداء مهام أكثر تماشيًا مع الأهداف والرغبات والاحتياجات البشرية. يُستخدَم أسلوب التعليم بواسطة التعزيز من الملاحظات البشرية في جميع تطبيقات الذكاء الاصطناعي المولّد، بما في ذلك نماذج اللغة الكبيرة (LLM).

القراءة عن التعليم بواسطة التعزيز

لماذا يعد التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF) مهمًا؟

تطبيقات الذكاء الاصطناعي (AI) واسعة النطاق، من السيارات ذاتية القيادة إلى معالجة اللغة الطبيعية (NLP)، وعوامل تنبؤ سوق الأوراق المالية، وخدمات تخصيص في تجارة التجزئة. بغض النظر عن التطبيق المحدد، فإن هدف الذكاء الاصطناعي هو في نهاية المطاف محاكاة الاستجابات والسلوكيات وعمليات صنع القرار البشرية. يجب أن يشفر نموذج تعلُّم الآلة الإدخالات البشرية كبيانات التدريب بحيث يحاكي الذكاء الاصطناعي البشر إلى حد كبير عند إكمال المهام المعقدة.

التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF) هو تقنية محددة تُستخدم في تدريب أنظمة الذكاء الاصطناعي لتبدو أكثر بشرية، إلى جانب تقنيات أخرى مثل التعلم الخاضع للإشراف وغير الخاضع للإشراف. أولاً، تتم مقارنة استجابات النموذج باستجابات الإنسان. يقيم الإنسان جودة الاستجابات المختلفة من الآلة، ما يشير إلى أي الاستجابات تبدو بشرية أكثر. يمكن أن تستند الدرجة إلى الصفات البشرية الفطرية، مثل الود، والدرجة الصحيحة من تحديد السياق، والحالة المزاجية.

التعليم بواسطة التعزيز من الملاحظات البشرية مهم في فهم اللغة الطبيعية، ولكنه يستخدم أيضًا في تطبيقات الذكاء الاصطناعي المولّد الأخرى.

القراءة عن معالجة اللغة الطبيعية

القراءة عن الفرق بين التعلُّم الخاضع للإشراف وغير الخاضع للإشراف

يعزز أداء الذكاء الاصطناعي

يجعل التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF) نموذج تعلّم الآلة (ML) أكثر دقة. يمكنك تدريب نموذج يمكن تدريبه على البيانات البشرية المنشأة مسبقًا، ولكن وجود حلقات ملاحظات بشرية إضافية يعزز أداء النموذج بشكل كبير مقارنة بحالته الأولية.

على سبيل المثال، عند ترجمة نص من لغة إلى أخرى، قد ينتج النموذج نصًا صحيحًا تقنيًا ولكنه يبدو غير طبيعي للقارئ. يمكن لمترجم محترف تنفيذ الترجمة أولاً، مع تقييم الترجمة المنشأة آليًا مقابل تلك الترجمة، ومن ثم تقييم مجموعة من الترجمات المنشأة آليًا من حيث الجودة. إن إضافة المزيد من التدريب إلى النموذج يجعله أفضل في إنتاج ترجمات تبدو طبيعية.

يقدم معايير تدريب معقدة

في بعض الحالات في الذكاء الاصطناعي المولّد، قد يكون من الصعب تدريب النموذج بدقة على معلمات معينة. على سبيل المثال، كيف تحدد الحالة المزاجية لمقطوعة موسيقية؟ قد تكون هناك معلمات فنية مثل المفتاح والإيقاع تشير إلى حالة مزاجية معينة، ولكن روح المقطوعة الموسيقية تكون أكثر ذاتية وأقل تحديدًا من مجرد مجموعة من الجوانب التقنية. بدلاً من ذلك، يمكنك تقديم إرشادات بشرية ينشأ من خلالها المؤلفين مقطوعات موسيقية حزينة، وبعد ذلك يمكنك تسمية القطع المنشأة آليًا وفقًا لمستوى مزاجها. يتيح ذلك للآلة تعلم هذه المعلمات بسرعة أكبر.

يعزز رضا المستخدمين

على الرغم من أن نموذج تعلُّم الآلة يمكن أن يكون دقيقًا، فإنه قد لا يبدو بشريًا. هناك حاجة إلى التعليم بواسطة التعزيز (RL) لتوجيه النموذج نحو الاستجابة الأفضل والأكثر جاذبية للمستخدمين البشريين.

على سبيل المثال، إذا سألت أحد روبوتات المحادثة عن حالة الطقس في الخارج، فقد يجيب: "إنها 30 درجة مئوية مع وجود سحب ورطوبة عالية" أو قد يجيب، "درجة الحرارة حوالي 30 درجة في الوقت الحالي. الجو غائم في الخارج ورطب، لذلك قد يبدو الهواء أكثر كثافة!" على الرغم من أن كلتا الاستجابتين تقول الشيء نفسه، فإن الاستجابة الثانية تبدو طبيعية أكثر وتوفر مزيدًا من السياق.

نظرًا لأن المستخدمين البشريين يقيّمون استجابات النماذج التي يفضلونها، يمكنك استخدام التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF) لجمع الملاحظات البشرية وتحسين نموذجك لخدمة أشخاص حقيقيين على أفضل وجه.

ما آلية عمل التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF)؟

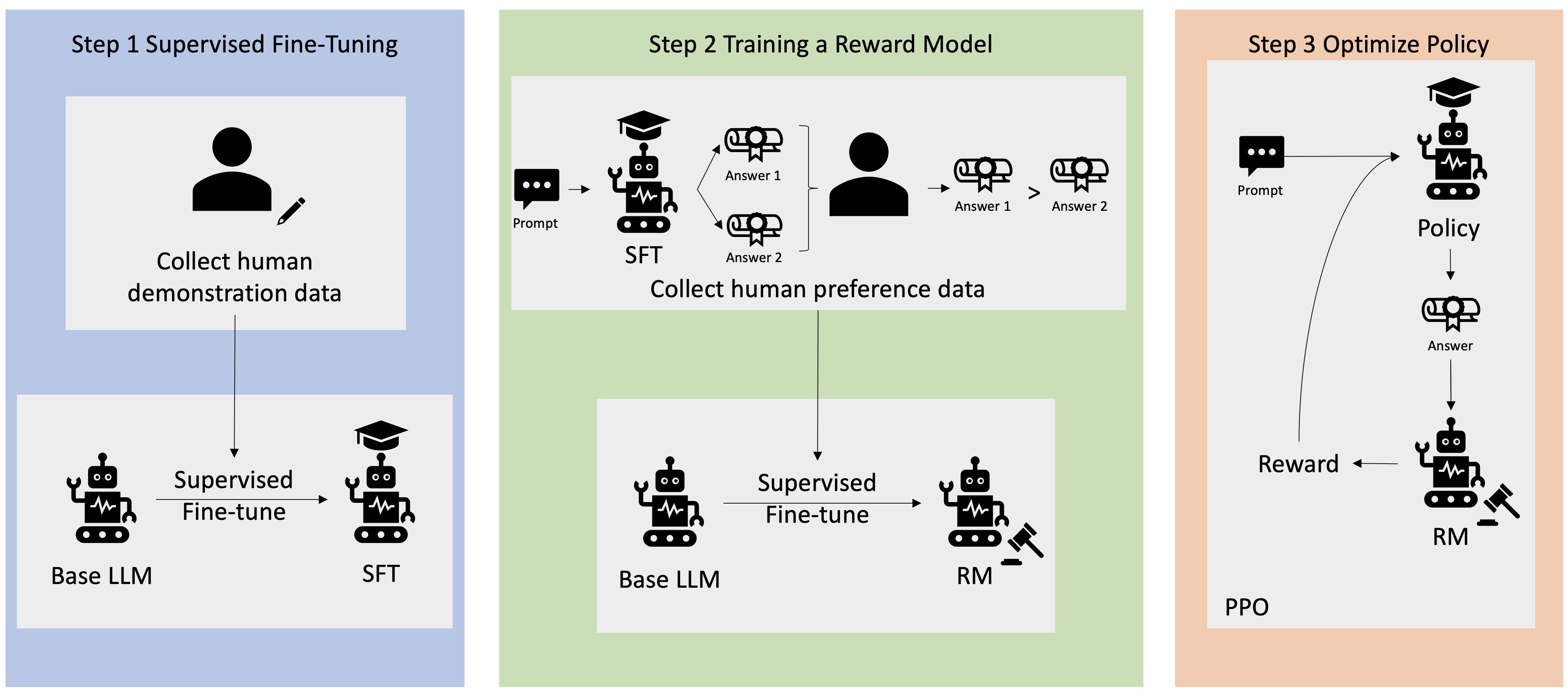

يتم تنفيذ التعليم بواسطة التعزيز من الملاحظات البشرية على أربع مراحل قبل اعتبار النموذج جاهزًا. هنا، نستخدم مثال نموذج اللغة - روبوت محادثة داخلي لقاعدة معارف الشركة - يستخدم التعليم بواسطة التعزيز من الملاحظات البشرية بهدف التحسين.

نقدم فقط نظرة عامة عن عملية التعلُّم. ثمة تعقيد رياضي مهم في تدريب النموذج وتحسين سياسته من أجل استخدام التعليم بواسطة التعزيز من الملاحظات البشرية. ومع ذلك، فإن العمليات المعقدة محددة جيدًا في التعليم بواسطة التعزيز من الملاحظات البشرية وغالبًا ما تحتوي على خوارزميات مُعدة مسبقًا تحتاج فقط إلى إدخالاتك الفريدة.

جمع البيانات

قبل تنفيذ مهام تعلم الآلة باستخدام نموذج اللغة، يتم إنشاء مجموعة من المطالبات والاستجابات من إنتاج الإنسان لبيانات التدريب. تُستخدم هذه المجموعة لاحقًا في عملية تدريب النموذج.

على سبيل المثال، قد تكون المطالبات كالتالي:

- "أين يقع قسم الموارد البشرية في بوسطن؟"

- "ما عملية الموافقة على منشورات وسائل التواصل الاجتماعي؟"

- "إلامَ يشير التقرير الربع السنوي الأول عن المبيعات مقارنةً بالتقارير الريع سنوية السابقة؟"

ثم يجيب مسؤول المعرفة في الشركة عن هذه الأسئلة بإجابات دقيقة وطبيعية.

الضبط الدقيق الخاضع للإشراف لنموذج اللغة

يمكنك استخدام نموذج تجاري مُدرَّب مسبقًا كنموذج أساسي للتعليم بواسطة التعزيز من الملاحظات البشرية. يمكنك ضبط النموذج وفقًا لقاعدة المعرفة الداخلية للشركة باستخدام تقنيات مثل التوليد المعزز بالاسترداد (RAG). عندما يُضبط النموذج بدقة، يمكنك مقارنة استجابته للمطالبات المحددة مسبقًا مع الاستجابات البشرية المجمَّعة في الخطوة السابقة. يمكن للتقنيات الرياضية حساب درجة التشابه بين الاستجابتين.

على سبيل المثال، يمكن تعيين درجة للاستجابات المُنشأة آليًا بين 0 و1، بحيث يشير 1 إلى الاستجابة الأكثر دقة و0 إلى الاستجابة الأقل دقة. باستخدام هذه الدرجات، أصبح لدى النموذج الآن سياسة مصممة لتشكيل استجابات تسجل درجات أقرب إلى الاستجابات البشرية. تشكل هذه السياسة الأساس لجميع عمليات صنع القرار المستقبلية للنموذج.

القراءة عن التوليد المعزز بالاسترداد (RAG)

إنشاء نموذج مكافأة منفصل

يتمثل جوهر التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF) في تدريب نموذج ذكاء اصطناعي مكافأة منفصل استنادًا إلى الملاحظات البشرية، ثم استخدام هذا النموذج كدالة مكافأة لتحسين السياسة من خلال التعليم بواسطة التعزيز (RL). بالنظر إلى مجموعة من الاستجابات المتعددة من النموذج الذي يجيب عن المطالبة نفسها، يمكن للبشر الإشارة إلى تفضيلهم فيما يتعلق بجودة كل استجابة. يمكنك استخدام تفضيلات تصنيف الاستجابات هذه لإنشاء نموذج المكافأة الذي يقدر تلقائيًا مدى ارتفاع الدرجة التي يعطيها الإنسان لأي استجابة معينة لمطالبة ما.

تحسين نموذج اللغة باستخدام النموذج القائم على المكافآت

ثم يستخدم نموذج اللغة نموذج المكافأة لتحسين سياسته تلقائيًا قبل الاستجابة للمطالبات. باستخدام نموذج المكافأة، يقيم نموذج اللغة داخليًا مجموعة من الاستجابات ثم يختار الاستجابة التي من المرجح بشكل كبير أن تؤدي إلى أكبر مكافأة. هذا يعني أنه يلبي التفضيلات البشرية بطريقة محسنة أكثر.

تعرض الصورة التالية نظرة عامة عن عملية التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF).

كيف يُستخدم التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF) في مجال الذكاء الاصطناعي المولّد؟

يُعتبر التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF) تقنية متوافقة مع معايير الصناعة لضمان إنتاج نماذج لغة كبيرة (LLM) لمحتوى حقيقي وغير ضار ومفيد. ومع ذلك، فإن التواصل البشري هو عملية ذاتية وإبداعية - وتتأثر فائدة مخرج نموذج اللغة الكبير (LLM) بشدة بالقيم والتفضيلات الإنسانية. يدرَّب كل نموذج بشكل مختلف قليلاً ويستخدم مستجيبين بشريين مختلفين، لذلك تختلف المخرجات حتى بين نماذج اللغة الكبيرة (LLM) التنافسية. إن درجة تضمن القيم البشرية في كل نموذج متروكة تمامًا للمبدع.

تتجاوز تطبيقات التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF) حدود نماذج اللغة الكبيرة إلى أنواع أخرى من الذكاء الاصطناعي المولّد. إليك بعض الأمثلة:

- يمكن استخدام التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF) في إنتاج الصور بالذكاء الاصطناعي: على سبيل المثال، قياس درجة الواقعية أو التقنية أو الحالة المزاجية العمل الفني

- في مجال إنتاج الموسيقى، يمكن للتعليم بواسطة التعزيز من الملاحظات البشرية المساعدة في إنشاء موسيقى تتناسب مع بعض حالات مزاجية والموسيقى التصويرية للأنشطة

- يمكن استخدام التعليم بواسطة التعزيز من الملاحظات البشرية في مساعد صوتي، لتوجيه الصوت ليبدو أكثر ودية وإثارة للفضول وجدارة بالثقة

كيف يمكن أن تساعدك AWS في تلبية متطلبات التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF)؟

تقدم Amazon SageMaker Ground Trut المجموعة الأكثر شمولًا من إمكانات العناصر البشرية في حلقة العمل، ما يسمح لك بتضمين الملاحظات البشرية عبر دورة حياة تعلُّم الآلة لتحسين دقة النموذج وملاءمته. يمكنك إكمال العديد من مهام العناصر البشرية في حلقة العمل، بدءًا من إنشاء البيانات والتعليقات التوضيحية وحتى إنشاء نموذج المكافآت ومراجعة النموذج والتخصيص من خلال الخدمة الذاتية أو العروض المُدارة من AWS.

تتضمن SageMaker Ground Truth معلقًا للبيانات لإمكانيات التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF). يمكنك تقديم ملاحظات وتوجيهات مباشرة حول المخرجات التي أنتجها النموذج من خلال الترتيب أو التصنيف أو القيام بالأمرين معًا في استجاباته المتعلقة بنتائج التعليم بواسطة التعزيز (RL). البيانات، التي يشار إليها باسم بيانات المقارنة والتصنيف، هي بشكل فعال نموذج المكافأة أو دالة المكافأة، والتي تُستخدم بعد ذلك لتدريب النموذج. يمكنك استخدام بيانات المقارنة والتصنيف لتخصيص نموذج موجود لحالة الاستخدام أو لضبط نموذج تنشئه من البداية.

ابدأ استخدام أساليب التعليم بواسطة التعزيز من الملاحظات البشرية (RLHF) على AWS من خلال إنشاء حساب اليوم.