Instancias Inf1 de Amazon EC2

Empresas de diversos sectores aspiran a transformarse gracias a la inteligencia artificial (IA) para impulsar la innovación empresarial, mejorar la experiencia del cliente y procesar las mejoras. Los modelos de machine learning (ML) que permiten ejecutar aplicaciones de IA son cada vez más complejos, lo que hace que aumenten los costos de la infraestructura de computación subyacente. Hasta el 90 % de la inversión en infraestructura para el desarrollo y ejecución de aplicaciones de ML va para la inferencia. Los clientes buscan soluciones de infraestructura rentables para implementar sus aplicaciones de ML en producción.

Las instancias Inf1 de Amazon EC2 ofrecen una inferencia de ML de alto rendimiento y bajo costo. Ofrecen un rendimiento hasta 2,3 veces mayor y un costo por inferencia hasta un 70 % menor que las instancias comparables de Amazon EC2. Las instancias Inf1 se crean desde cero para ser compatibles con las aplicaciones de inferencia de ML. Ofrecen hasta 16 chips de AWS Inferentia, chips de inferencia de ML de alto rendimiento diseñados y creados por AWS. Además, las instancias Inf1 incluyen procesadores Intel Xeon escalables de segunda generación y redes de hasta 100 Gbps para lograr una inferencia de alto rendimiento.

Los clientes pueden usar las instancias Inf1 para ejecutar aplicaciones de inferencia de ML a gran escala, como la búsqueda, los motores de recomendaciones, la visión artificial, el reconocimiento de voz, el procesamiento de lenguaje natural (NLP), la personalización y la detección de fraudes.

Los desarrolladores pueden implementar sus modelos de machine learning en instancias Inf1 con el SDK de AWS Neuron, que se integra con marcos de machine learning populares tales como TensorFlow, PyTorch y Apache MXNet. Pueden continuar usando los mismos procesos de ML y migrar aplicaciones sin complicaciones a instancias Inf1 con muy pocos cambios en el código y sin tener que recurrir a soluciones específicas del proveedor.

Comenzar a usar instancias Inf1 es fácil con Amazon SageMaker, las AMI de aprendizaje profundo de AWS (DLAMI) preconfiguradas con el SDK de Neuron o Amazon Elastic Container Service (Amazon ECS) o Amazon Elastic Kubernetes Service (Amazon EKS) para las aplicaciones de ML en contenedores.

Beneficios

Costo hasta un 70 % menor por inferencia

Con Inf1, los desarrolladores pueden reducir significativamente el costo de sus implementaciones de producción de machine learning. La combinación del poco costo de la instancia y el gran rendimiento de las instancias Inf1 ofrece un costo por inferencia hasta un 70 % más bajo que las instancias de Amazon EC2 comparables.

Facilidad de uso y portabilidad del código

El SDK de Neuron está integrado con marcos de machine learning, como TensorFlow, PyTorch y MXNet. Los desarrolladores pueden continuar usando los mismos procesos de ML y migrar aplicaciones sin complicaciones a instancias Inf1 con muy pocos cambios en el código. Esto les brinda la libertad necesaria para usar el marco de ML de su elección, la plataforma de computación que mejor se adapte a sus necesidades y utilizar las últimas tecnologías sin estar limitados a las soluciones del proveedor.

Rendimiento hasta 2,3 veces mayor

Las instancias Inf1 brindan un rendimiento hasta 2,3 veces mayor en comparación con las instancias Amazon EC2 comparables. Los chips de AWS Inferentia que utilizan las instancias Inf1 están optimizados para el rendimiento de las inferencias de lotes pequeños, gracias a lo cual las aplicaciones en tiempo real pueden maximizar el rendimiento y cumplir los requisitos de latencia.

Latencia extremadamente baja

Los chips de AWS Inferentia cuentan con una gran memoria que les permite almacenar en caché modelos de machine learning directamente en el chip. Puede implementar sus modelos con capacidades como la canalización de NeuronCore, con las que deja de ser necesario acceder a recursos de memoria externos. Las instancias Inf1 le permiten implementar aplicaciones de inferencia en tiempo real con latencias prácticamente en tiempo real sin que el ancho de banda se vea afectado.

Compatibilidad con varios modelos y tipos de datos de ML

Las instancias Inf1 son compatibles con muchas de las arquitecturas de modelos de machine learning que se usan comúnmente, como SSD, VGG o ResNext para el reconocimiento y la clasificación de imágenes, así como también Transformer y BERT para el procesamiento de lenguaje natural. Asimismo, la compatibilidad con el repositorio de modelos HuggingFace en Neuron permite que los clientes puedan compilar y ejecutar fácilmente inferencias con modelos entrenados previamente, o incluso perfeccionados. Para ello, basta con cambiar una única línea del código. Admite múltiples tipos de datos, como BF16 y FP16, con precisión combinada para una serie de modelos y necesidades de rendimiento.

Características

Con tecnología de AWS Inferentia

AWS Inferentia es un chip de ML diseñado específicamente por AWS con el fin de ofrecer inferencias de alto rendimiento a un costo bajo. Cada chip de AWS Inferentia tiene cuatro núcleos NeuronCore de primera generación, brinda hasta 128 TOPS (billones de operaciones por segundo) de rendimiento y admite tipos de datos FP16, BF16 e INT8. Los chips de AWS Inferentia también cuentan con una gran cantidad de memoria en chip que se puede usar para almacenar en caché modelos grandes; esto es particularmente beneficioso para los modelos que requieren un acceso frecuente a la memoria.

Implementación con los marcos populares de ML mediante AWS Neuron

El SDK de AWS Neuron consta de un compilador, un controlador de tiempo de ejecución y herramientas de creación de perfiles. Esto permite la implementación de modelos de redes neuronales complejas, creados y entrenados en marcos populares, como TensorFlow, PyTorch y MXNet, para que se ejecuten con instancias Inf1. Con la canalización de NeuronCore, puede dividir grandes modelos para la ejecución mediante múltiples chips de Inferentia con interconexión chip a chip física de alta velocidad, de manera que consigue una inferencia de alto rendimiento y un costo más bajo por inferencia.

Redes y almacenamiento de alto rendimiento

Las instancias Inf1 ofrecen hasta 100 Gbps de rendimiento de red para las aplicaciones que requieren acceso a las redes de alta velocidad. Las tecnologías de última generación Elastic Network Adapter (ENA) y NVM Express (NVMe) proporcionan a las instancias Inf1 interfaces de alto rendimiento y baja latencia para redes y Amazon Elastic Block Store (Amazon EBS).

Con base en AWS Nitro System

El sistema Nitro de AWS es una amplia colección de bloques funcionales que descargan muchas de las funciones de virtualización tradicionales a hardware y software dedicados para ofrecer alto rendimiento, alta disponibilidad y alta seguridad, al tiempo que reduce la sobrecarga de la virtualización.

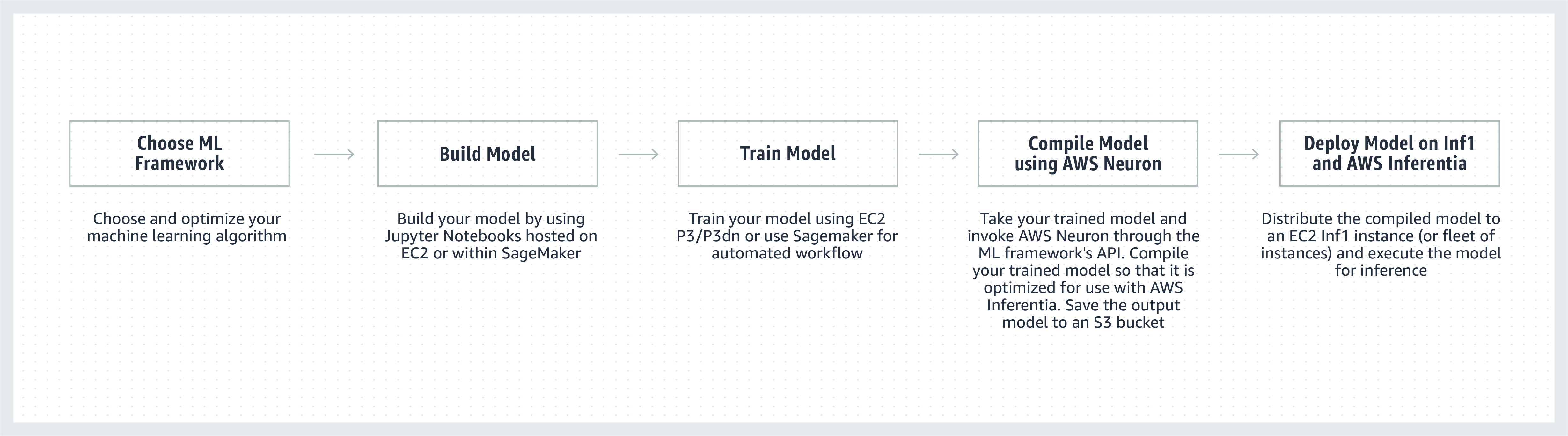

Funcionamiento

Testimonios de clientes

“Incorporamos el machine learning en muchos aspectos de Snapchat y el análisis de la innovación en este campo es una prioridad clave. Una vez que nos enteramos de Inferentia, comenzamos a colaborar con AWS a fin de adoptar instancias Inf1/Inferentia que nos ayudaran con la implementación del machine learning, incluidos el rendimiento y el costo. Comenzamos con nuestros modelos de recomendación y esperamos adoptar más modelos con las instancias Inf1 en el futuro”.

Nima Khajehnouri, VP Engineering en Snap Inc.

“La plataforma de administración unificada de la experiencia del cliente impulsada por IA de Sprinklr (Unified-CXM) permite a las empresas recopilar y traducir los comentarios de los clientes en tiempo real a través de múltiples canales a información procesable, lo que resulta en una resolución proactiva de problemas, desarrollo de productos mejorado, marketing de contenido mejorado, mejor servicio al cliente y mucho más”. Mediante el uso de Inf1 de Amazon EC2, pudimos mejorar significativamente el rendimiento de uno de nuestros modelos de procesamiento de lenguaje natural y mejorar el rendimiento de uno de nuestros modelos de visión artificial. Esperamos seguir utilizando Inf1 de Amazon EC2 para servir mejor a nuestros clientes globales”.

Vasant Srinivasan, Senior Vice President of Product Engineering en Sprinklr

“Nuestro producto de procesamiento de lenguaje natural de vanguardia, Finch for Text, ofrece a los usuarios la capacidad de extraer, desambiguar y enriquecer varios tipos de entidades en grandes volúmenes de texto. Finch for Text necesita recursos de computación significativos para proporcionar a nuestros clientes enriquecimientos de baja latencia en orígenes de datos globales. Ahora, utilizamos instancias Inf1 de AWS en nuestros modelos de NLP, traducción y desambiguación de entidades con PyTorch. Pudimos reducir los costos de inferencia en más de un 80 % (con respecto a las GPU) con optimizaciones mínimas, además de mantener la velocidad de inferencia y el rendimiento. Esta mejora permite a nuestros clientes enriquecer sus textos en francés, español, alemán y neerlandés en tiempo real en orígenes de datos de streaming y a escala mundial, algo que es fundamental para nuestros clientes de servicios financieros, agregadores de datos y del sector público”.

Scott Lightner, Chief Technology Officer en Finch Computing

“Alertamos sobre muchos tipos de eventos en todo el mundo en muchos idiomas y en diferentes formatos (imágenes, video, audio, sensores de texto, combinaciones de todos estos tipos) desde cientos de miles de orígenes. Optimizar la velocidad y el costo dada esa escala es absolutamente fundamental para nuestro negocio. Con AWS Inferentia, hemos reducido la latencia de los modelos y hemos conseguido un rendimiento por dólar hasta 9 veces superior. Esto nos ha permitido aumentar la precisión de los modelos e incrementar las capacidades de nuestra plataforma mediante la implementación de modelos de aprendizaje profundo más sofisticados y el procesamiento de un volumen de datos 5 veces mayor, manteniendo nuestros costos bajo control”.

Alex Jaimes, Chief Scientist y Senior Vice President of AI en Dataminr

“Autodesk potencia la tecnología cognitiva de nuestro asistente virtual impulsado por IA, Autodesk Virtual Agent (AVA), mediante el uso de Inferentia. AVA responde más de 100 000 preguntas de clientes por mes gracias a la comprensión del lenguaje natural (NLU) y las técnicas de aprendizaje profundo (DL) para extraer el contexto, la intención y el significado de las consultas. Mediante el uso de Inferentia, podemos obtener un rendimiento 4,9 veces mayor que G4dn para nuestros modelos de NLU y esperamos ejecutar más cargas de trabajo en las instancias Inf1 basadas en Inferentia”.

Binghui Ouyang, Sr. Data Scientist en Autodesk

Servicios de Amazon que utilizan instancias Inf1 de Amazon EC2

Amazon Advertising ayuda a las empresas de todos los tamaños a conectar con sus clientes en cada etapa de su proceso de compra. Cada día se revisan, clasifican y publican millones de anuncios, tanto con texto como con imágenes, con el objetivo de ofrecer una experiencia óptima al cliente.

“Para el procesamiento de nuestros anuncios con texto, implementamos modelos BERT basados en PyTorch de forma global en instancias Inf1 basadas en AWS Inferentia. Con el paso a Inferentia desde las GPU, conseguimos reducir los costos un 69 % sin afectar el rendimiento. Compilar y probar nuestros modelos para AWS Inferentia nos llevó menos de tres semanas. Gracias a que utilizamos Amazon SageMaker para implementar nuestros modelos en instancias Inf1, nos aseguramos de que la implementación fuera escalable y fácil de administrar. Cuando analicé por primera vez los modelos compilados, el rendimiento con AWS Inferentia fue tan impresionante que hasta tuve que volver a ejecutar los puntos de referencia para asegurarme de que eran correctos. En un futuro, tenemos previsto migrar nuestros modelos de procesamiento de anuncios con imágenes a Inferentia. Ya hemos comprobado que la latencia es un 30 % menor y conseguimos un ahorro de costos del 71 % en comparación con instancias similares basadas en GPU para estos modelos”.

Yashal Kanungo, Applied Scientist en Amazon Advertising

Lea el blog de noticias »

“La inteligencia basada en IA y ML de Amazon Alexa, con tecnología de AWS, está disponible en más de 100 millones de dispositivos hoy en día. Además, nuestra promesa a los clientes es que Alexa será cada vez más inteligente, más conversacional, más proactiva y aún más encantadora. El cumplimiento de esta promesa requiere mejoras continuas en los tiempos de respuesta y en los costos de la infraestructura de machine learning, por lo que estamos encantados de utilizar Inf1 de Amazon EC2 para reducir la latencia de inferencia y el costo por inferencia en la conversión de texto a voz de Alexa. Gracias a Inf1 de Amazon EC2 podremos mejorar aún más el servicio para las decenas de millones de clientes que utilizan Alexa cada mes”.

Tom Taylor, Senior Vice President en Amazon Alexa

“Innovamos constantemente para mejorar la experiencia de nuestros clientes y reducir nuestros costos de infraestructura”. Trasladar nuestras cargas de trabajo de respuesta a preguntas basadas en la web (WBQA) de instancias P3 basadas en GPU a instancias Inf1 basadas en AWS Inferentia no solo nos ayudó a reducir los costos de inferencia en un 60 %, sino que también mejoró la latencia de extremo a extremo en más de un 40 %, lo que contribuyó a mejorar la experiencia de preguntas y respuestas de los clientes con Alexa. Utilizar Amazon SageMaker para nuestro modelo basado en TensorFlow hizo que el proceso de cambio a las instancias Inf1 fuera sencillo y fácil de administrar. Ahora utilizamos instancias Inf1 a nivel global para ejecutar estas cargas de trabajo de WBQA y optimizamos el rendimiento de estas para AWS Inferentia con el fin de reducir aún más los costos y la latencia”.

Eric Lind, Software Development Engineer en Alexa AI

“Amazon Prime Video usa modelos de ML de visión artificial para analizar la calidad de los videos de los eventos en vivo a fin de garantizar una experiencia de visualización óptima para los miembros de Prime Video. Implementamos nuestros modelos de ML de clasificación de imágenes en instancias Inf1 de EC2 y vimos una mejora en el rendimiento 4 veces superior y hasta un 40 % de ahorro en el costo. Ahora, queremos aprovechar este ahorro de costos para innovar y crear modelos avanzados que puedan detectar defectos más complejos, como diferencias de sincronización entre los archivos de audio y video, para ofrecer una experiencia de visualización mucho mejor a los miembros de Prime Video”.

Victor Antonino, Solutions Architect en Amazon Prime Video

“Amazon Rekognition es una aplicación simple y fácil de análisis de imágenes y videos que ayuda a los clientes a detectar objetos, personas, textos y actividades. Amazon Rekognition necesita una infraestructura de aprendizaje profundo de alto rendimiento que pueda analizar miles de millones de imágenes y videos diariamente para nuestros clientes. Con las instancias Inf1 basadas en AWS Inferentia, la ejecución de modelos de Amazon Rekognition, como la clasificación de objetos, dio como resultado una latencia 8 veces menor y el doble de rendimiento que la ejecución de estos modelos en GPU. Con base en estos resultados, estamos pasando Amazon Rekognition a Inf1, lo que permite a nuestros clientes obtener resultados precisos más rápido”.

Rajneesh Singh, Director, SW Engineering en Amazon Rekognition and Video

Precios

* Los precios que se muestran son para la región EE. UU. Este (Norte de Virginia) de AWS. Los precios de las instancias reservadas para 1 y 3 años son para las opciones de pago “parcial por adelantado”, y “sin pago por adelantado” para instancias sin la opción de pago parcial.

Las instancias Inf1 de Amazon EC2 se encuentran disponibles en las regiones EE. UU. Este (Norte de Virginia) y EE. UU. Oeste (Oregón) de AWS como instancias bajo demanda, reservadas o de spot.

Introducción

Uso de Amazon SageMaker

SageMaker facilita la compilación e implementación de su modelo de ML entrenado en producción en las instancias Inf1 de Amazon, de manera que puede comenzar a generar predicciones en tiempo real con baja latencia. AWS Neuron, el compilador para AWS Inferentia, se integra con Amazon SageMaker Neo, lo que le permite compilar sus modelos de ML entrenados para ejecutar las instancias Inf1 de manera óptima. Con SageMaker puede ejecutar fácilmente sus modelos de clústeres de escalado automático de instancias Inf1 distribuidas en varias zonas de disponibilidad para ofrecer inferencia en tiempo real de alto rendimiento y alta disponibilidad. Aprenda cómo implementar Inf1 con SageMaker mediante los ejemplos en GitHub.

Uso de DLAMI

Las DLAMI ofrecen a los investigadores y profesionales de ML la infraestructura y las herramientas necesarias para agilizar las tareas de aprendizaje profundo en la nube a cualquier escala. El SDK de AWS Neuron viene preinstalado en DLAMI para compilar y ejecutar sus modelos de machine learning de forma óptima en instancias Inf1. Si desea obtener más información orientativa acerca del proceso introductorio, visite la guía de selección de AMI y más recursos sobre aprendizaje profundo. Consulte la guía de introducción a las DLAMI de AWS para saber cómo usar la DLAMI con Neuron.

Uso de contenedores de aprendizaje profundo

Los desarrolladores ahora pueden implementar instancias Inf1 en Amazon EKS, que es un servicio de Kubernetes completamente administrado, así como en Amazon ECS, que es un servicio de orquestación de contenedores completamente administrado de Amazon. Conozca más sobre la introducción a Inf1 en Amazon EKS o con Amazon ECS. Hay más detalles disponibles sobre la ejecución de contenedores en instancias Inf1 en la página del tutorial de herramientas de contenedores de Neuron. Neuron también está disponible de manera preinstalada en los contenedores de aprendizaje profundo de AWS.

Blogs y artículos

How Amazon Search reduced ML inference costs by 85% with AWS Inferentia

escrito por Joao Moura, Jason Carlson, Jaspreet Singh, Shaohui Xi, Shruti Koparkar, Haowei Sun, Weiqi Zhang, and Zhuoqi Zhangs; 22/09/2022

High-performance, low-cost machine learning infrastructure is accelerating innovation in the cloud (La infraestructura de machine learning de alto rendimiento y costo bajo está acelerando la innovación en la nube)

por MIT Technology Review Insights, 01/11/2021

por Davide Galliteli y Hasan Poonawala, 19/10/2021

Machine learning in the cloud is helping businesses innovate

por MIT Technology Review Insights, 15/10/2021

por Alex Iankoulski, Joshua Correa, Mahadevan Balasubramaniam y Sundar Ranganatha, 30/09/2021

por Fabio Nonato de Paula y Mahadevan Balasubramaniam, 04/05/2021

escrito por Binghui Ouyang, 07/04/2021

Majority of Alexa now running on faster, more cost-effective Amazon EC2 Inf1 instances (La mayor parte de Alexa ahora se ejecuta en instancias Inf1 de Amazon EC2 más rápidas y rentables)

por Sébastien Stormacq, 12/11/2020

Amazon ECS Now Supports EC2 Inf1 Instances

por Julien Simon, 14/08/2020

Por Fabio Nonato De Paula y Haichen Li, 22/07/2020

Amazon EKS ahora admite las instancias Inf1 de EC2

por Julien Simon, 15/06/2020