Elastic Fabric Adapter (EFA) は、Amazon EC2 インスタンス用のネットワークインターフェイスです。これによりお客様は、高いレベルのノード間通信を必要とするアプリケーションを AWS で大規模実行できます。カスタムビルドのオペレーティングシステム (OS) バイパスハードウェアインターフェイスでは、これらのアプリケーションのスケーリングに不可欠な、インスタンス間通信のパフォーマンスを向上させます。EFA を使用すると、Message Passing Interface (MPI) を使用する高性能計算 (HPC) アプリケーションおよび NVIDIA Collective Communications Library (NCCL) を使用する Machine Learning (ML) アプリケーションを、数千の CPU や GPU にスケールできます。その結果、AWS クラウドのオンデマンドの伸縮自在性と柔軟性を備えたオンプレミスの HPC クラスターのアプリケーションパフォーマンスを実現できます。

EFA は、EC2 ネットワーク機能として、サポートされている EC2 インスタンスにおいて追加料金なしで利用できます。さらに、ノード間通信で広く使用されているインターフェイス、API、ライブラリと互換性があるので、HPC アプリケーションを、ほとんどまたはまったく変更を加えずに AWS に移行できます。

メリット

より迅速な成果

EFA 独自の OS バイパスネットワーキングメカニズムにより、インスタンス間の通信で低レイテンシー、低ジッターのチャネルを利用できます。これにより、緊密に結合された HPC または分散型の機械学習アプリケーションを数千コアまで拡張でき、アプリケーションの実行速度が向上します。

柔軟な構成

EC2 インスタンスのリストが大きくなっていく中で EFA のサポートを有効にし、ワークロードに適したコンピューティング構成を柔軟に選択することができます。具体的には、変更の必要性に応じてクラスター構成を変更し、新しいコンピュートインスタンスで EFA サポートを有効にするだけです。事前の予約や計画は必要ありません。

シームレスな移行

EFA は通信にリブファブリックインターフェイスとリブファブリック API を使用します。ほとんどすべての HPC プログラミングモデルがこのインターフェイスをサポートしているため、既存の HPC アプリケーションをほとんどまたはまったく変更せずにクラウドに移行できます。

EFA パフォーマンス

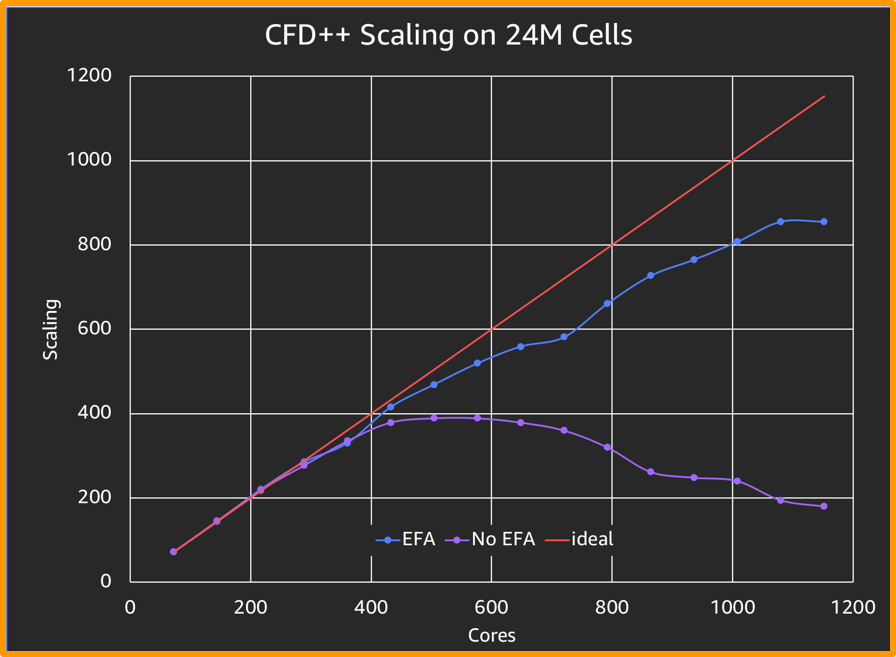

EFA では、上の図のように、標準の CFD シミュレーションのスケーリングが ENA よりも 4 倍強化されます。

メタコンプテクノロジーが提供するこのベンチマークのソルバー

仕組み

ユースケース

数値流体力学

計算流体力学 (CFD) アルゴリズムの進歩により、エンジニアはますます複雑化する流れ現象をシミュレートできるようになり、HPC はターンアラウンドタイムの短縮に役立ちます。EFA では、設計エンジニアはシミュレーションジョブをスケールアウトできるようになり、パラメータをさらに調整して、正確な結果が短時間で得られます。

気象モデリング

複雑な気象モデルで正確な結果を得るには、広いメモリ帯域幅、高速な相互接続、堅牢な並列ファイルシステムが必要です。モデルのグリッド間隔が狭いほど、結果の精度が高くなり、多くの計算リソースがモデルに必要になります。EFA で得られる高速相互接続では、気象モデリングアプリケーションでは AWS クラウドのスケーリング機能をほぼ無制限に利用でき、短時間でより正確な予測結果が得られます。

Machine Learning

ディープラーニングモデルのトレーニングは、GPU での分散コンピューティングによって大幅に高速化できます。Caffe、Caffe2、Chainer、MXNet、TensorFlow、PyTorch などの主要ディープラーニングフレームワークはすでに NCCL が統合済みであり、ノード間の通信でマルチ GPU コレクティブを活用しています。EFA は AWS 上の NCCL に最適化されているため、これらのトレーニングモデルのスループットとスケーラビリティが向上し、結果がより早く得られます。

リソース