Amazon EC2 Inf1 Bulut Sunucuları

Çok çeşitli sektörlerden işletmeler, yapay zekânın (AI) gücüne dayanan dönüşümlerle işletme inovasyonuna yön vermenin, müşteri deneyimini iyileştirmenin ve süreç iyileştirmeleri yapmanın yollarını arıyor. Yapay zekâ uygulamalarına güç veren makine öğrenimi (ML) modelleri, işlem altyapısı maliyetlerinin yükselmesine yol açacak şekilde giderek karmaşıklaşıyor. ML uygulamaları geliştirip çalıştırmaya yönelik altyapı harcamasının %90 kadarını çoğu zaman çıkarım oluşturuyor. Müşteriler, ML uygulamalarını üretim ortamlarına dağıtmak için uygun maliyetli altyapı çözümleri arıyor.

Amazon EC2 Inf1 bulut sunucuları, yüksek performanslı ve düşük maliyetli ML çıkarımı sunar. Çıkarım başına, karşılaştırılabilir Amazon EC2 bulut sunucularından 2,3 kata kadar daha yüksek aktarım hızı ve %70'e kadar daha düşük maliyet sağlar. Inf1 bulut sunucuları, ML çıkarım uygulamalarını desteklemek için sıfırdan oluşturulmuştur. Bu bulut sunucuları, 16'ya kadar AWS Inferentia çipi sunar. Bu çipler, AWS tarafından tasarlanıp oluşturulan yüksek performanslı ML çıkarım çipleridir. Inf1 bulut sunucuları, aynı zamanda yüksek aktarım hızında çıkarım sağlamak için 2. Nesil Intel Xeon Ölçeklenebilir işlemciler ve 100 Gbps'ye varan ağ iletişimi sunar.

Müşteriler, Inf1 bulut sunucularını kullanarak arama, öneri altyapıları, bilgisayarlı görü, konuşma tanıma, doğal dil işleme (NLP), kişiselleştirme ve dolandırıcılık algılama gibi büyük ölçekli ML çıkarım uygulamalarını çalıştırabilir.

Geliştiriciler; TensorFlow, PyTorch ve Apache MXNet gibi popüler makine öğrenimi çerçeveleriyle entegre AWS Neuron SDK'yi kullanarak ML modellerini Inf1 bulut sunucularına dağıtabilir. Aynı ML iş akışlarını kullanmaya devam edebilir ve uygulamaları minimum düzeyde kod değişikliği ile ve satıcıya özel hiçbir çözüme bağlı kalmaksızın sorunsuz bir şekilde Inf1 bulut sunucularına geçirebilirler.

Amazon SageMaker, Neuron SDK ile önceden yapılandırılmış olarak gelen AWS Derin Öğrenme AMI'leri (DLAMI) veya container'lı ML uygulamaları için Amazon Esnek Container Hizmeti (Amazon ECS) ya da Amazon Esnek Kubernetes Hizmeti (Amazon EKS) ile Inf1 bulut sunucularını kolayca kullanmaya başlayın.

Avantajlar

Çıkarım başına %70'e varan daha düşük maliyet

Inf1 kullanan geliştiriciler, ML üretim dağıtımlarının maliyetini önemli ölçüde azaltabilir. Inf1 bulut sunucularının düşük bulut sunucusu maliyeti ile yüksek aktarım hızının birleşimi, çıkarım başına karşılaştırılabilir Amazon EC2 bulut sunucularından %70'e kadar daha düşük maliyet sağlar.

Kullanım kolaylığı ve kod taşınabilirliği

Neuron SDK; TensorFlow, PyTorch ve MXNet gibi yaygın ML çerçeveleri ile entegredir. Geliştiriciler, aynı ML iş akışlarını kullanmaya devam edebilir ve uygulamalarını minimum düzeyde kod değişikliği ile sorunsuz bir şekilde Inf1 bulut sunucularına geçirebilir. Bu onlara tercih ettikleri ML çerçevesini ve gereksinimlerini en iyi karşılayan işlem platformunu kullanma özgürlüğü ve satıcıya özel çözümlere bağlı kalmadan en son teknolojilerden faydalanma imkânı sağlar.

2,3 kata varan daha yüksek aktarım hızı

Inf1 bulut sunucuları, karşılaştırılabilir Amazon EC2 bulut sunucularından 2,3 kata kadar daha yüksek aktarım hızı sağlar. Inf1 bulut sunucularına güç veren AWS Inferentia yongaları, gerçek zamanlı uygulamaların aktarım hızını en üst düzeye çıkarmasını ve gecikme gereksinimlerini karşılamasını sağlayan küçük toplu iş boyutlarına yönelik çıkarım performansı için optimize edilmiştir.

Son derece düşük gecikme süresi

AWS Inferentia çipleri, ML modellerinin doğrudan çip üzerinde önbelleğe alınmasını sağlayan büyük çip üzeri bellekle donatılmıştır. Modellerinizi, NeuronCore İşlem Hattı gibi dış bellek kaynaklarına erişme ihtiyacını ortadan kaldıran özellikler kullanarak dağıtabilirsiniz. Inf1 bulut sunucuları ile, gerçek zamanlı çıkarım uygulamalarını bant genişliğinizi etkilemeksizin gerçek zamanlıya yakın gecikmelerle dağıtabilirsiniz.

Çeşitli ML modelleri ve veri türleri için destek

Inf1 bulut sunucuları, görüntü tanıma/sınıflandırma için SSD, VGG ve ResNext gibi yaygın kullanılan pek çok ML modeli mimarisinin yanı sıra NLP için Transformer ve BERT'i destekler. Ek olarak, Neuron'daki HuggingFace model deposu için destek, müşterilere önceden eğitilmiş veya sadece tek bir kod satırını değiştirerek hassas şekilde ayarlanmış modeller kullanarak kolayca çıkarım derleme ve çalıştırma imkânı sunar. Çeşitli modeller ve performans ihtiyaçları için BF16 ve FP16 dâhil olmak üzere birden fazla veri türü karmaşık duyarlılıkla desteklenir.

Özellikler

AWS Inferentia tarafından sağlanmıştır

AWS Inferentia, düşük maliyetle yüksek performanslı çıkarım sunmak için AWS tarafından amaca yönelik olarak oluşturulmuş bir ML çipidir. Her AWS Inferentia çipi, dört adet birinci nesil NeuronCore'a sahiptir ve saniye başına 128 tera işleme (TOPS) kadar performans sağlamakta olup FP16, BF16 ve INT8 veri türlerini destekler. Ayrıca AWS Inferentia yongalarında, büyük modelleri önbelleğe alma işleminde kullanılabilecek büyük miktarda yonga belleği bulunur ve bu durum özellikle sık bellek erişimi gerektiren modeller için kullanışlıdır.

AWS Neuron'u kullanarak popüler ML çerçeveleriyle dağıtın

AWS Neuron SDK; derleyici, çalışma zamanı sürücüsü ve profil oluşturma araçlarından oluşur. TensorFlow, PyTorch ve MXNet gibi popüler çerçevelerde oluşturulup eğitilen karmaşık sinir ağı modellerinin dağıtımının Inf1 bulut sunucuları aracılığıyla yürütülmesini sağlar. NeuronCore İşlem Hattı ile, yüksek hızlı ve fiziksel çipten çipe bağlantı kullanarak birden fazla Inferentia çipinde yürütmeyi mümkün kılmak için büyük modelleri bölebilir ve bu sayede hem yüksek çıkarım aktarım hızı hem de daha düşük çıkarım maliyeti elde edebilirsiniz.

Yüksek performanslı ağ iletişimi ve depolama

Inf1 bulut sunucuları, yüksek hızlı ağ iletişimine erişim gerektiren uygulamalar için 100 Gbps’ye varan ağ aktarım hızı sunar. Yeni nesil Esnek Ağ Bağdaştırıcısı (ENA) ve NVM Express (NVMe) teknolojisi sayesinde Inf1 bulut sunucuları, ağ iletişimi ve Amazon Esnek Blok Deposu (Amazon EBS) için hem yüksek aktarım hızlı hem de düşük gecikme süreli arabirimler sunar.

AWS Nitro Sistemi üzerinde geliştirilmiştir

AWS Nitro System yüksek performans, yüksek erişilebilirlik ve yüksek güvenlik sunarken görselleştirme maliyetlerini azaltmak için özel donanım ve yazılımlara klasik görselleştirme işlevlerinin birçoğunu sunan zengin bir yapı taşı koleksiyonudur.

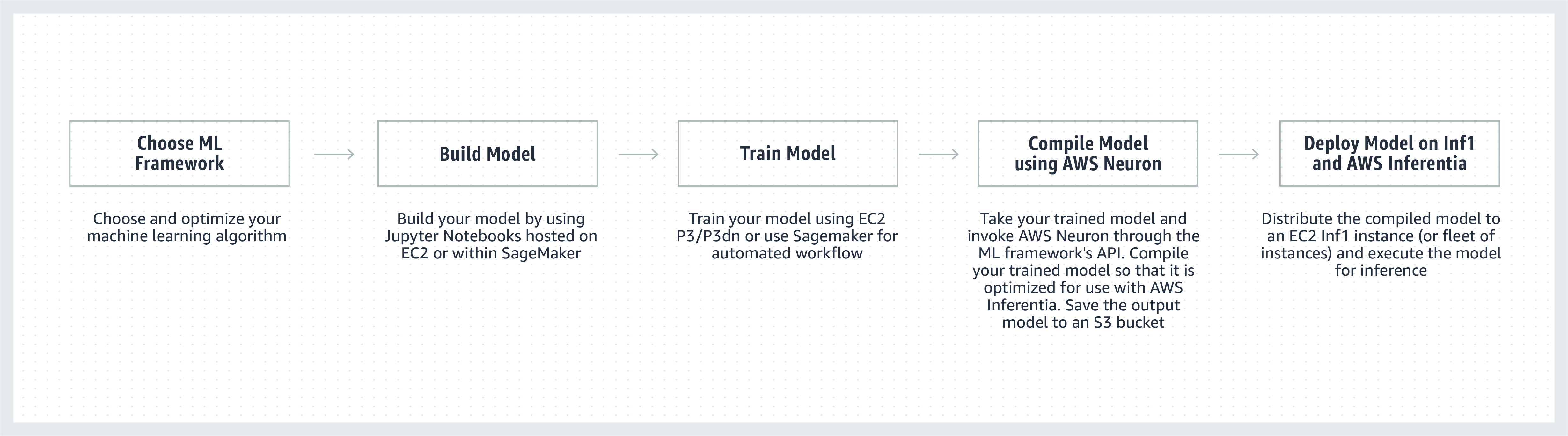

Nasıl çalışır?

Müşteri görüşleri

"ML'yi Snapchat'in birçok özelliğine ekliyoruz ve bu alanda yenilikleri keşfetmek en önemli önceliğimiz. Infertia'yi öğrendiğimizde performans ve maliyet dâhil olmak üzere ML dağıtımları için bize yardımcı olması için Inf1/Inferentia bulut sunucuları edinmek için AWS ile işbirliğine başladık. Öneri modellerimiz ile başladık ve gelecekte Inf1 bulut sunucuları ile daha fazla model edinmeyi dört gözle bekliyoruz."

Nima Khajehnouri, Mühendislikten Sorumlu Başkan Yardımcısı, Snap Inc.

"Sprinklr'ın yapay zekâ temelli birleştirilmiş müşteri deneyimi yönetme (Unified-CXM) platformu, şirketlerin birden fazla kanalda gerçek zamanlı müşteri geri bildirimlerini toplayıp eyleme geçirilebilir öngörülere dönüştürmesine olanak tanır ve sonuç olarak proaktif sorun çözümü, iyileştirilmiş ürün geliştirme, iyileştirilmiş içerik pazarlaması, daha iyi müşteri hizmeti ve çok daha fazlasını ortaya çıkarır. Amazon EC2 Inf1'i kullanarak NLP modellerimizden birinin performansını önemli ölçüde iyileştirebildik ve görüntü işleme modellerimizden birinin performansını artırdık. Küresel müşterilerimize daha iyi hizmet sunabilmek için Amazon EC2 Inf1'i kullanmaya devam etmek için sabırsızlanıyoruz."

Vasant Srinivasan, Ürün Mühendisliği Kıdemli Başkan Yardımcısı, Sprinklr

"Son teknoloji NLP ürünümüz Finch for Text, kullanıcılara büyük hacimli metinlerde birden fazla varlık türünü ayıklama, belirsizleştirme ve zenginleştirme olanağı sunuyor. Finch for Text, müşterilerimize küresel veri akışlarında düşük gecikmeli zenginleştirmeler sağlamak için önemli bilgi işlem kaynakları gerektirir. Artık AWS Inf1 bulut sunucularını; PyTorch NLP, çeviri ve varlık anlam ayrımı modellerimizde kullanıyoruz. Çıkarım hızımızı ve performansımızı korurken minimum optimizasyonlarla çıkarım maliyetlerimizi %80'in üzerinde (GPU'lar üzerinden) azaltmayı başardık. Bu iyileştirme; müşterilerimizin Fransızca, İspanyolca, Almanca ve Felemenkçe dilindeki metinlerini akış veri akışlarında ve küresel ölçekte gerçek zamanlı olarak zenginleştirmelerini sağlıyor. Bu da finansal hizmetlerimiz, veri toplayıcımız ve kamu sektörü müşterilerimiz için kritik bir öneme sahip."

Scott Lightner, Teknolojiden Sorumlu Müdür, Finch Computing

"Yüz binlerce kaynaktan farklı biçimlerde (görüntüler, videolar, ses dosyaları, metin sensörleri, tüm bu türlerin kombinasyonları) birçok dilde dünyanın dört bir yanından birçok olay türü hakkında uyarılar sağlıyoruz. Bu ölçek göz önüne alındığında hız ve maliyeti optimize etmek, işletmemiz için kesinlikle kritik bir öneme sahiptir. AWS Inferentia ile model gecikmesini azalttık ve dolar başına 9 kata kadar daha iyi aktarım hızı elde ettik. Bu, daha gelişmiş DL modelleri dağıtarak ve maliyetlerimizi kontrol altında tutarken 5 kat daha fazla veri hacmi işleyerek model doğruluğunu artırmamıza ve platformumuzun özelliklerini büyütmemize olanak sağladı."

Alex Jaimes, Bilim Departmanı Müdürü ve Yapay Zekâ Kıdemli Başkan Yardımcısı, Dataminr

"Autodesk, Inferentia kullanarak yapay zekâ temelli sanal asistanımız olan Autodesk Virtual Agent’in (AVA) bilişsel teknolojisini geliştiriyor. AVA, doğal dil anlama (NLU) ve derin öğrenme (DL) teknikleri uygulayarak sorguların arkasındaki bağlamı, niyeti ve anlamı çıkarmak için aylık 100.000 müşteri sorusunu cevaplamaktadır. Inferentia kullanarak NLU modellerimiz için G4dn bulut sunucularına kıyasla 4,9 kat daha yüksek aktarım hızı elde edebiliyoruz ve Inferentia temelli Inf1 bulut sunucularında daha fazla iş yükü çalıştırmayı dört gözle beliyoruz."

Binghui Ouyang, Kıdemli Veri Bilimcisi, Autodesk

Amazon EC2 Inf1 bulut sunucularını kullanan Amazon hizmetleri

Amazon Advertising, her ölçekten işletmelerin müşterilerle alışveriş yolculuklarının her aşamasında bağlantı kurmasına yardımcı olur. En uygun müşteri deneyimi için, metin ve görüntüler dahil olmak üzere her gün milyonlarca reklam yönetiliyor, sınıflandırılıyor ve sunuluyor.

"Metin reklam işleme süreçlerimiz için, AWS Inferentia tabanlı Inf1 bulut sunucuları üzerinde küresel olarak PyTorch tabanlı BERT modelleri dağıtıyoruz. GPU'lardan Inferentia'ya geçerek, maliyetlerimizi benzer performansla %69 oranında azaltabildik. AWS Inferentia için modellerimizi derleyerek test etmemiz üç haftadan az bir zaman aldı. Modellerimizi Inf1 bulut sunucularına dağıtmak için Amazon SageMaker'ı kullanmak, dağıtımımızın ölçeklenebilir ve yönetmesi kolay olmasını sağladık. Derlenen modelleri ilk kez analiz ettiğimde AWS Inferentia ile elde edilen performans öylesine etkileyiciydi ki, doğru olduklarını doğrulamak için karşılaştırmaları yeniden çalıştırmak zorunda kaldım! Gelecekte görüntü reklam işleme modellerimizi Inferentia'ya taşımayı planlıyoruz. Hâlihazırda yaptığımız karşılaştırmalarda, bu modeller için benzer GPU tabanlı bulut sunucularına kıyasla %30 daha düşük gecikme süresi ve %71 oranında maliyet tasarrufu elde ettiğimizi gördük."

Yashal Kanungo, Uygulamalı Bilim İnsanı, Amazon Advertising

Haber blogunu okuyun »

"AWS tarafından desteklenen Amazon Alexa'nın yapay zekâ ve makine öğrenimi tabanlı zekâsı, bugün 100 milyondan fazla cihazda kullanılabilir. Biz, müşterilerimize Alexa'nın daima daha akıllı, daha konuşkan, daha proaktif ve hatta daha eğlenceli olacağı sözünü veriyoruz. Bu sözleri yerine getirmek için yanıt sürelerinde ve ML altyapısı maliyetlerinde sürekli iyileştirmeler gerekmektedir. Bu yüzden, Alexa'nın metin seslendirmesindeki çıkarım gecikmesini ve çıkarım başına olan maliyeti azaltmak amacıyla Amazon EC2 Inf1'i kullanacağımız için çok heyecanlıyız. Amazon EC2 Inf1 sayesinde, her ay Alexa'yı kullanan onlarca milyon müşterimize çok daha iyi hizmet sunabileceğiz."

Tom Taylor, Kıdemli Başkan Yardımcısı, Amazon Alexa

"Müşteri deneyimimizi daha da iyileştirmek ve altyapı maliyetlerimizi düşürmek için sürekli inovasyon yapıyoruz. Web tabanlı soru yanıtlama (WBQA) iş yüklerimizi GPU tabanlı P3 bulut sunucularından AWS Inferentia tabanlı Inf1 bulut sunucularına taşımak, çıkarım maliyetlerini %60 oranında azaltmamıza yardımcı olmanın yanı sıra uçtan uca gecikmeyi de %40'ın üzerinde azaltarak Alexa ile müşteri soru-cevap deneyimini iyileştirmeye yardımcı oldu. TensorFlow tabanlı modelimiz için Amazon SageMaker'ı kullanmak, Inf1 bulut sunucularına geçiş sürecini basit ve yönetilmesi kolay bir hâle getirdi. Artık bu WBQA iş yüklerini çalıştırmak için küresel olarak Inf1 bulut sunucularını kullanıyoruz ve hem maliyetleri hem de gecikmeyi daha da azaltmak üzere performanslarını AWS Inferentia için optimize ediyoruz."

Eric Lind, Yazılım Geliştirme Mühendisi, Alexa AI

"Amazon Prime Video, Prime Video üyeleri için en iyi izleyici deneyimini sağlamak amacıyla canlı etkinliklerin video kalitesini analiz etmek için bilgisayarlı görme ML modellerini kullanıyor. Görüntü sınıflandırma ML modellerimizi EC2 Inf1 bulut sunucularına dağıttık ve performansta 4 kat iyileşme ve maliyette %40'a varan tasarruf elde ettik. Şimdi bu maliyet tasarruflarından yararlanarak Prime Video üyelerine daha gelişmiş görüntüleme deneyimi sunmak amacıyla ses ve video dosyaları arasındaki senkronizasyon boşlukları gibi daha karmaşık kusurları tespit edebilen gelişmiş modeller geliştirmek ve geliştirmek istiyoruz."

Victor Antonino, Çözüm Mimarı, Amazon Prime Video

"Amazon Rekognition, müşterilere nesneleri, insanları, metinleri ve etkinlikleri tanımlamak için yardım eden basit ve kolay bir görüntü ve video analizi uygulamasıdır. Amazon Rekognition, müşterilerimiz için günlük trilyonlarca görüntü ve video analiz edebilen yüksek performanslı DL altyapısına ihtiyaç duymaktadır. AWS Inferentia temelli Inf1 bulut sunucuları ile nesne sınıflandırması gibi Amazon Rekognition modelleri çalıştırmak, bu modelleri GPU’larda çalıştırmaya kıyasla 8 kat daha az gecikme süresi ve 2 kat daha fazla aktarım hızıyla sonuçlanmıştır. Bu sonuçlar doğrultusunda Amazon Rekognition'ı Inf1'e taşıyarak müşterilerimizin doğru sonuçları daha hızlı almalarını sağlıyoruz."

Rajneesh Singh, Yönetici, SW Engineering, Amazon Rekognition and Video

Fiyatlandırma

*Gösterilen fiyatlar ABD Doğu (Kuzey Virginia) AWS Bölgesi için geçerlidir. 1 yıllık ve 3 yıllık rezerve edilmiş bulut sunucusu fiyatları, "Kısmi Ön Ödeme" ödeme seçeneklerine veya Kısmı Ön Ödeme olanağı olmayan bulut sunucularında "Ön Ödemesiz" seçeneğe yöneliktir.

Amazon EC2 Inf1 bulut sunucuları; İstek Üzerine, Rezerve Edilmiş veya Spot Bulut Sunucuları olarak ABD Doğu (K. Virginia) ve ABD Batı (Oregon) AWS Bölgelerinde kullanılabilir.

Kullanmaya başlama

Amazon SageMaker Kullanımı

SageMaker, düşük gecikme süresiyle gerçek zamanlı tahminler oluşturmaya başlayabilmeniz için Amazon Inf1 bulut sunucuları üzerindeki üretim ortamınızda eğitilmiş ML modelinizi derlemenizi ve dağıtmanızı kolaylaştırır. AWS Inferentia'nın derleyicisi olan AWS Neuron, Amazon SageMaker Neo ile entegredir ve eğitilmiş ML modellerinizi Inf1 bulut sunucularında en ideal olarak çalışacak şekilde derlemenizi sağlar. SageMaker sayesinde modellerinizi yüksek performans ve yüksek erişilebilirliğe sahip gerçek zamanlı çıkarım sağlamak üzere birden fazla Erişilebilirlik Alanı'na dağıtılmış olan Inf1 bulut sunucularının otomatik ölçeklendirme kümeleri üzerinde kolayca çalıştırabilirsiniz. GitHub'daki örnekler ile SageMaker kullanarak Inf1'e nasıl dağıtım yapacağınızı öğrenin.

DLAMI'yi Kullanma

DLAMI, ML uygulayıcılarına ve araştırmacılarına bulutta ve tüm ölçeklerde derin öğrenimi hızlandırmak için kullanabilecekleri altyapıyı ve araçları sunar. AWS Neuron SDK, DLAMI'de önceden yüklenmiş hâlde gelir. Böylece, ML modellerinizi Inf1 bulut sunucularında en ideal şekilde derleyebilir ve çalıştırabilirsiniz. Başlangıç sürecinde size yardımcı olması için AMI seçim kılavuzunu ve diğer DL kaynaklarını ziyaret edin. DLAMI’yi Neuron ile nasıl kullanacağınızı öğrenmek için AWS DLAMI Kullanmaya Başlama kılavuzuna bakın.

Derin Öğrenme Container'larını Kullanma

Geliştiriciler, artık Inf1 bulut sunucularını bir tam olarak yönetilen Kubernetes hizmeti olan Amazon EKS'de veya Amazon’un bir tam olarak yönetilen container düzenleme hizmeti olan Amazon ECS'de dağıtabilirler. Amazon EKS üzerinde veya Amazon ECS ile Inf1'i kullanmaya başlama hakkında daha fazla bilgiye ulaşabilirsiniz. Container'ları Inf1 bulut sunucuları üzerinden çalıştırma konusunda Neuron container araçları öğreticisi sayfasından ulaşabilirsiniz. Neuron, AWS Derin Öğrenme Container'larında önceden yüklenmiş olarak da mevcuttur.

Bloglar ve makaleler

Amazon Search, AWS Inferentia ile ML çıkarım maliyetlerini nasıl %85 oranında azalttı?

Yazar: Joao Moura, Jason Carlson, Jaspreet Singh, Shaohui Xi, Shruti Koparkar, Haowei Sun, Weiqi Zhang ve Zhuoqi Zhangs, 22.09.2022

High-performance, low-cost machine learning infrastructure is accelerating innovation in the cloud

Yazar: MIT Technology Review Insights, 01.11.2021

Yazarlar: Davide Galliteli ve Hasan Poonawala, 19.10.2021

Machine learning in the cloud is helping businesses innovate

Yazar: MIT Technology Review Insights, 15.10.2021

Yazarlar: Alex Iankoulski, Joshua Correa, Mahadevan Balasubramaniam ve Sundar Ranganatha, 30.09.2021

Yazarlar: Fabio Nonato de Paula ve Mahadevan Balasubramaniam, 4.05.2021

Yazar: Binghui Ouyang, 7.04.2021

Majority of Alexa now running on faster, more cost-effective Amazon EC2 Inf1 instances

Yazar: Sébastien Stormacq, 12.11.2020

Yazar: Julien Simon, 22.04.2020

Amazon ECS Now Supports EC2 Inf1 Instances

Yazar: Julien Simon, 14.08.2020

Yazarlar: Fabio Nonato De Paula ve Haichen Li, 22.07.2020

Amazon EKS now supports EC2 Inf1 instances

Yazar: Julien Simon, 15.06.2020