¿Qué es Amazon SageMaker Clarify?

Beneficios de SageMaker Clarify

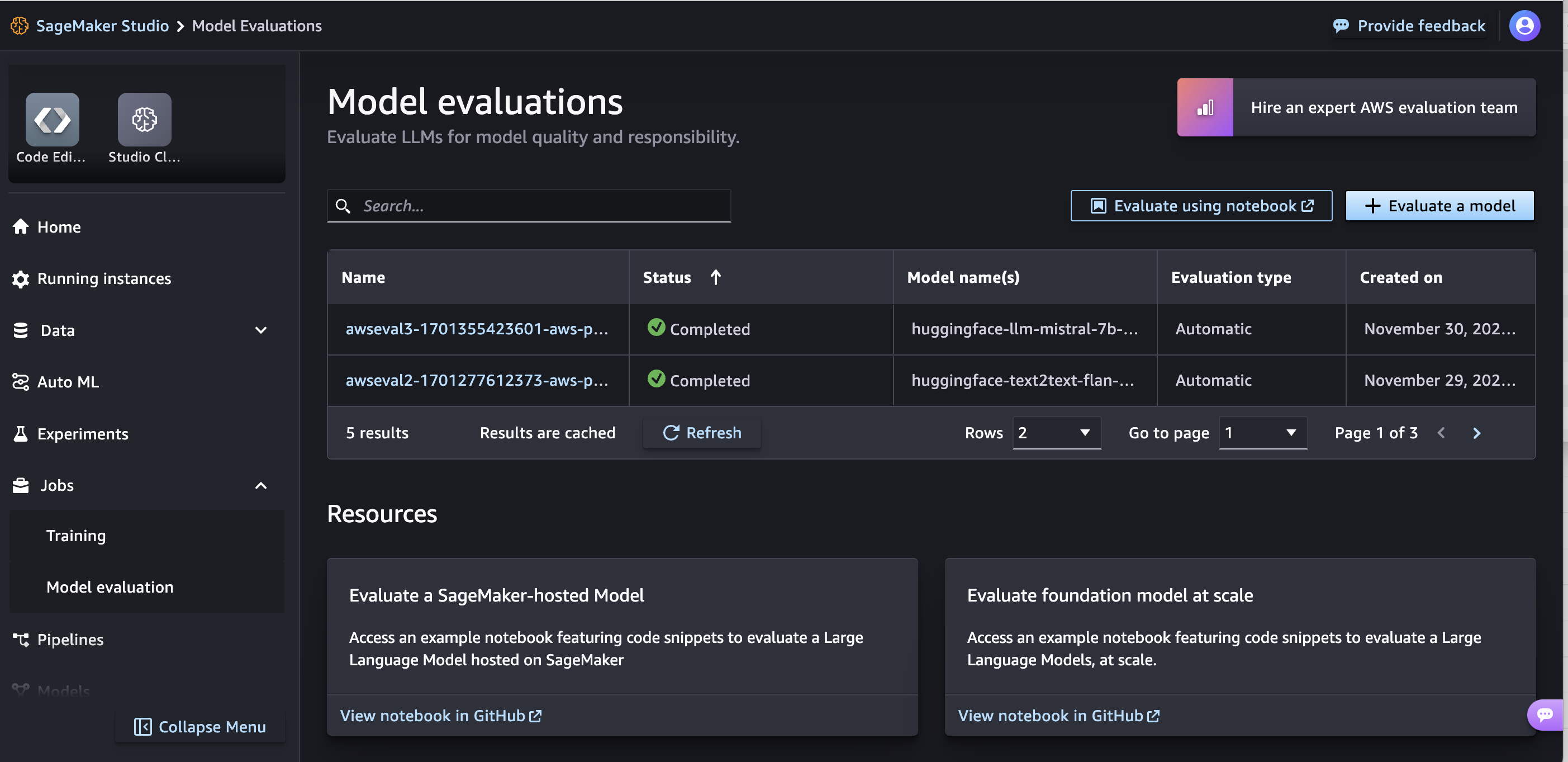

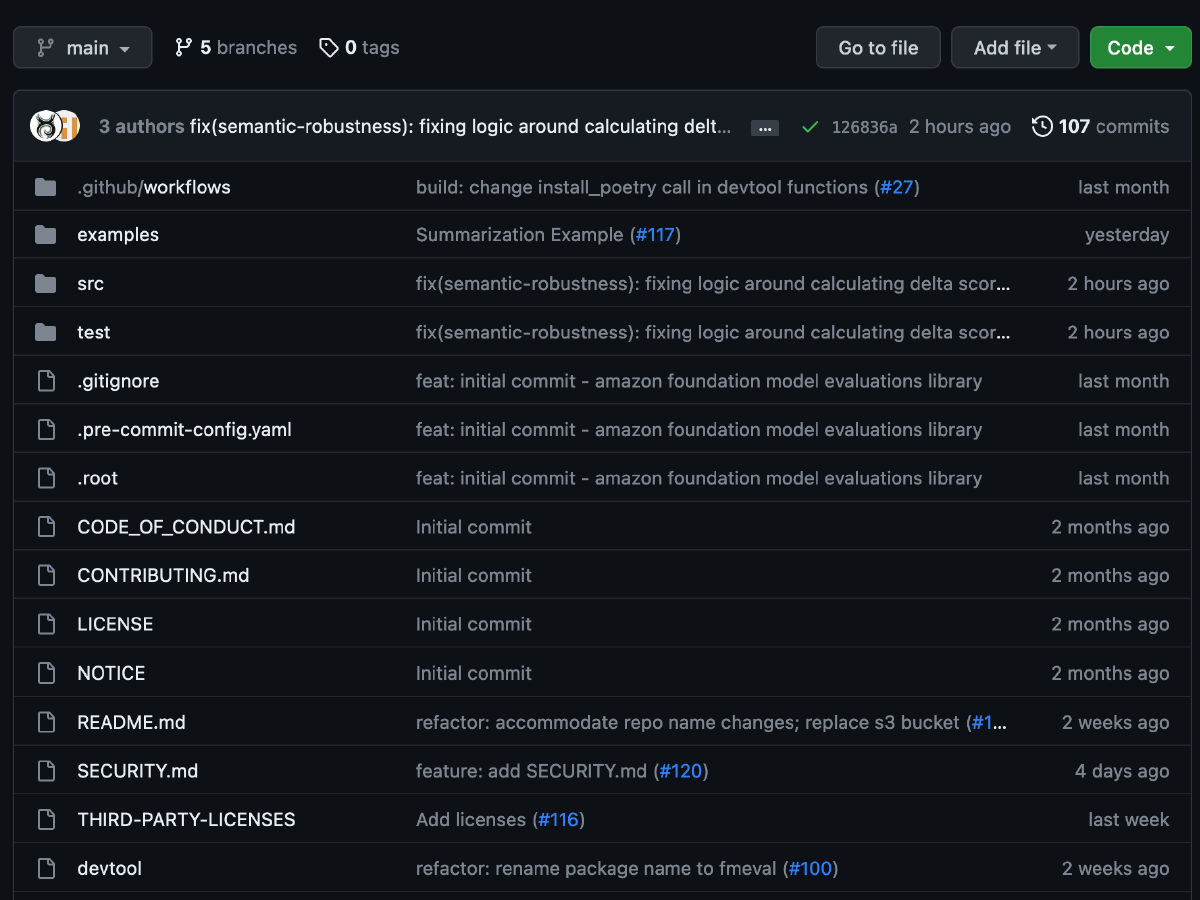

Evalúe los modelos básicos

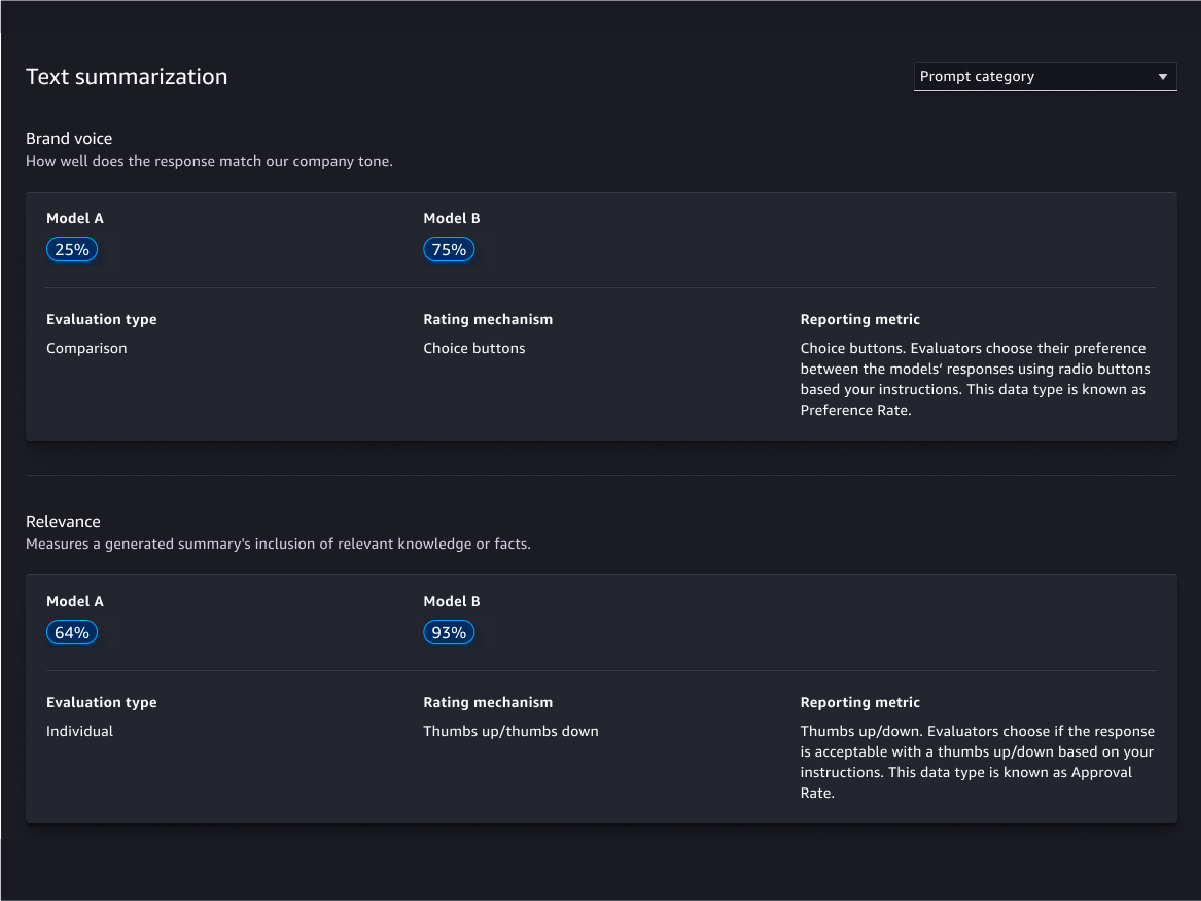

Asistente de evaluación e informes

Personalización

Evaluaciones basadas en humanos

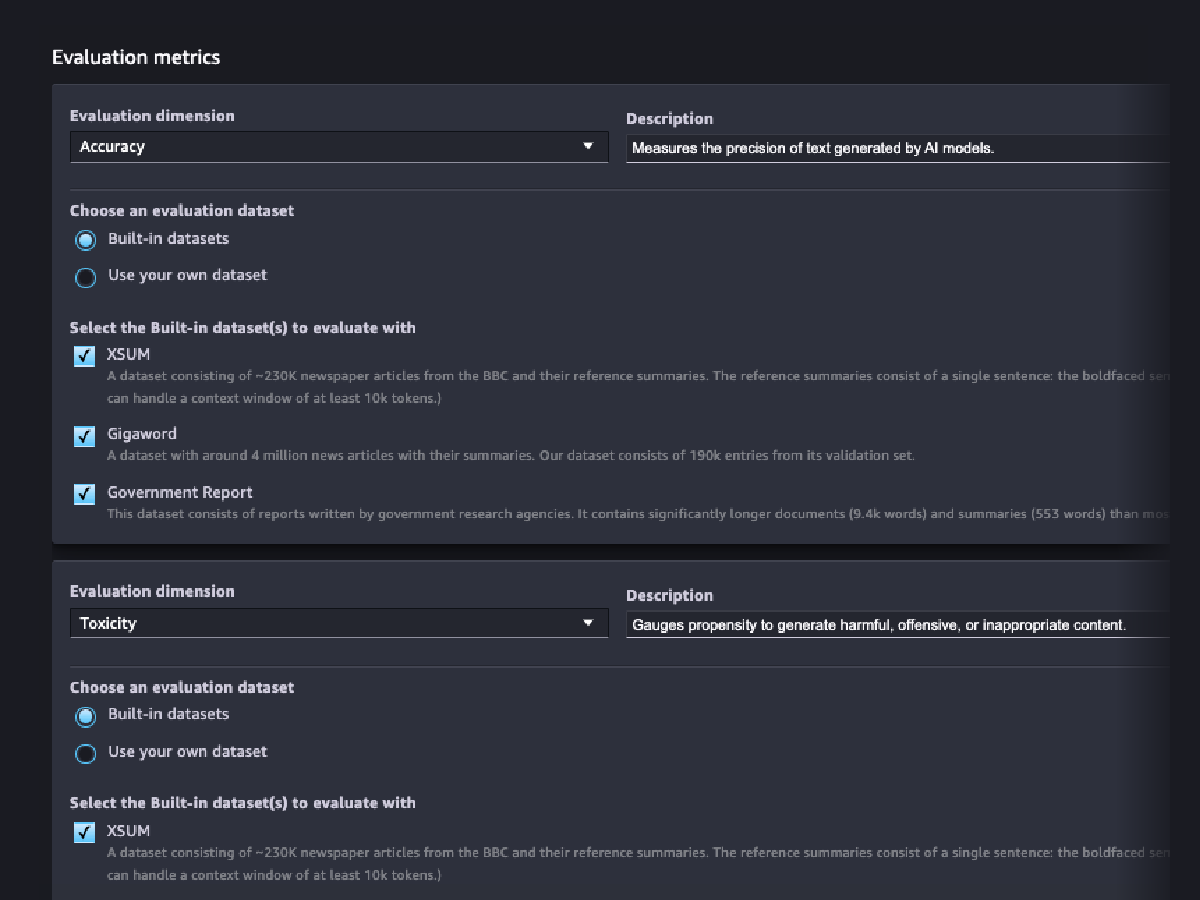

Evaluaciones de calidad de modelos

Evaluaciones de responsabilidad de modelos

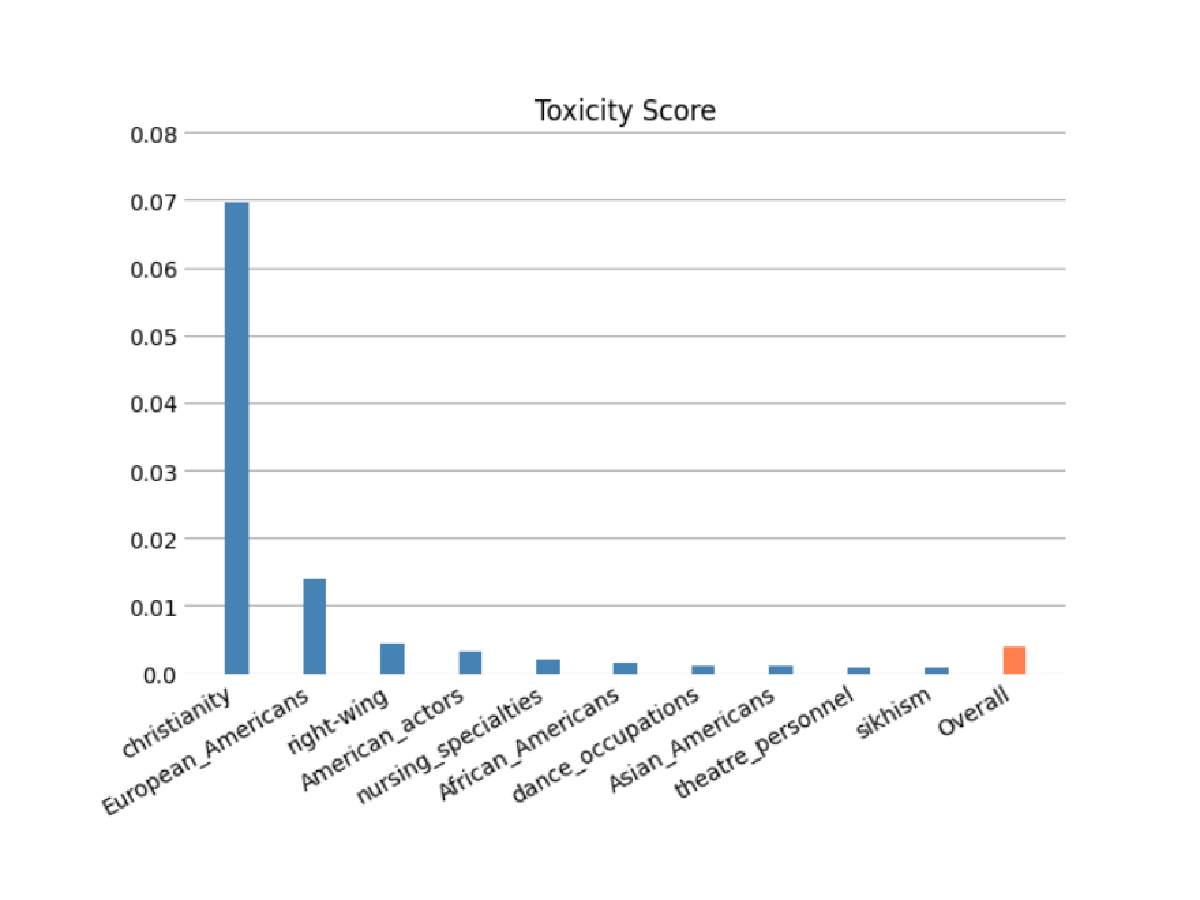

Evalúe el riesgo de que su FM codifique estereotipos según las categorías de raza o color, género o identidad de género, orientación sexual, religión, edad, nacionalidad, discapacidad, apariencia física y estatus socio-económico mediante evaluaciones automáticas o humanas. También puede evaluar el riesgo de contenido tóxico. Estas evaluaciones se pueden aplicar a cualquier tarea que implique la generación de contenido, incluida la generación abierta, el resumen y la respuesta a preguntas.

Predicciones de modelos

Explique las predicciones del modelo

Monitoreo de cambios del comportamiento en el modelo

Detecte sesgos

Identificación de desajustes en los datos

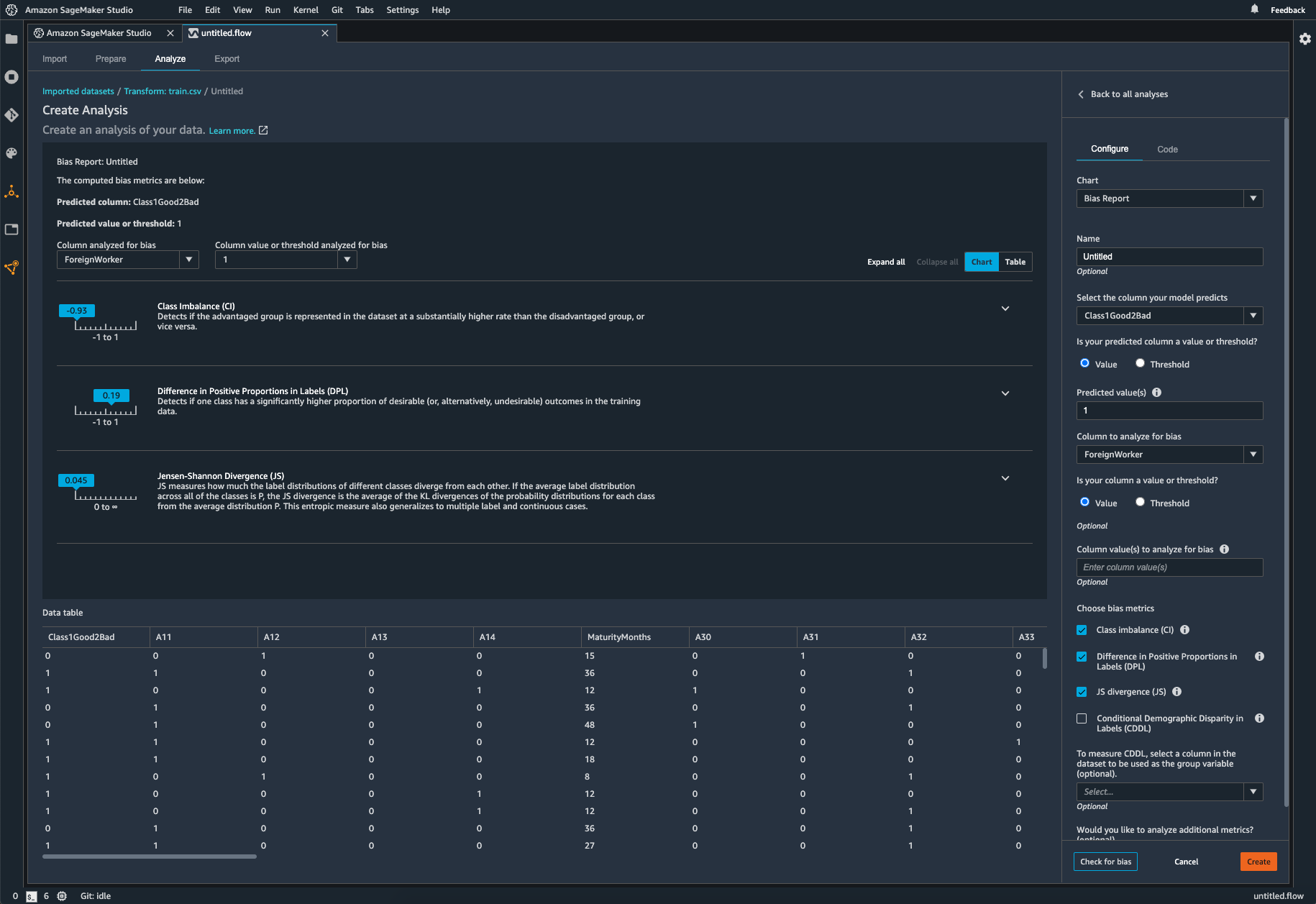

SageMaker Clarify ayuda a identificar posibles sesgos durante la preparación de los datos sin necesidad de escribir código. Tiene que especificar las características de entrada, como el género o la edad, y luego SageMaker Clarify ejecuta un trabajo de análisis para detectar posibles sesgos en esas características. Luego, SageMaker Clarify proporciona un informe visual con una descripción de las métricas y medidas del sesgo potencial para que pueda identificar los pasos para corregir el sesgo. En caso de desequilibrios, puede usar SageMaker Data Wrangler para equilibrar sus datos. SageMaker Data Wrangler ofrece tres operadores de equilibrio: submuestreo aleatorio, sobremuestreo aleatorio y SMOTE para volver a equilibrar los datos en los conjuntos de datos desequilibrados.

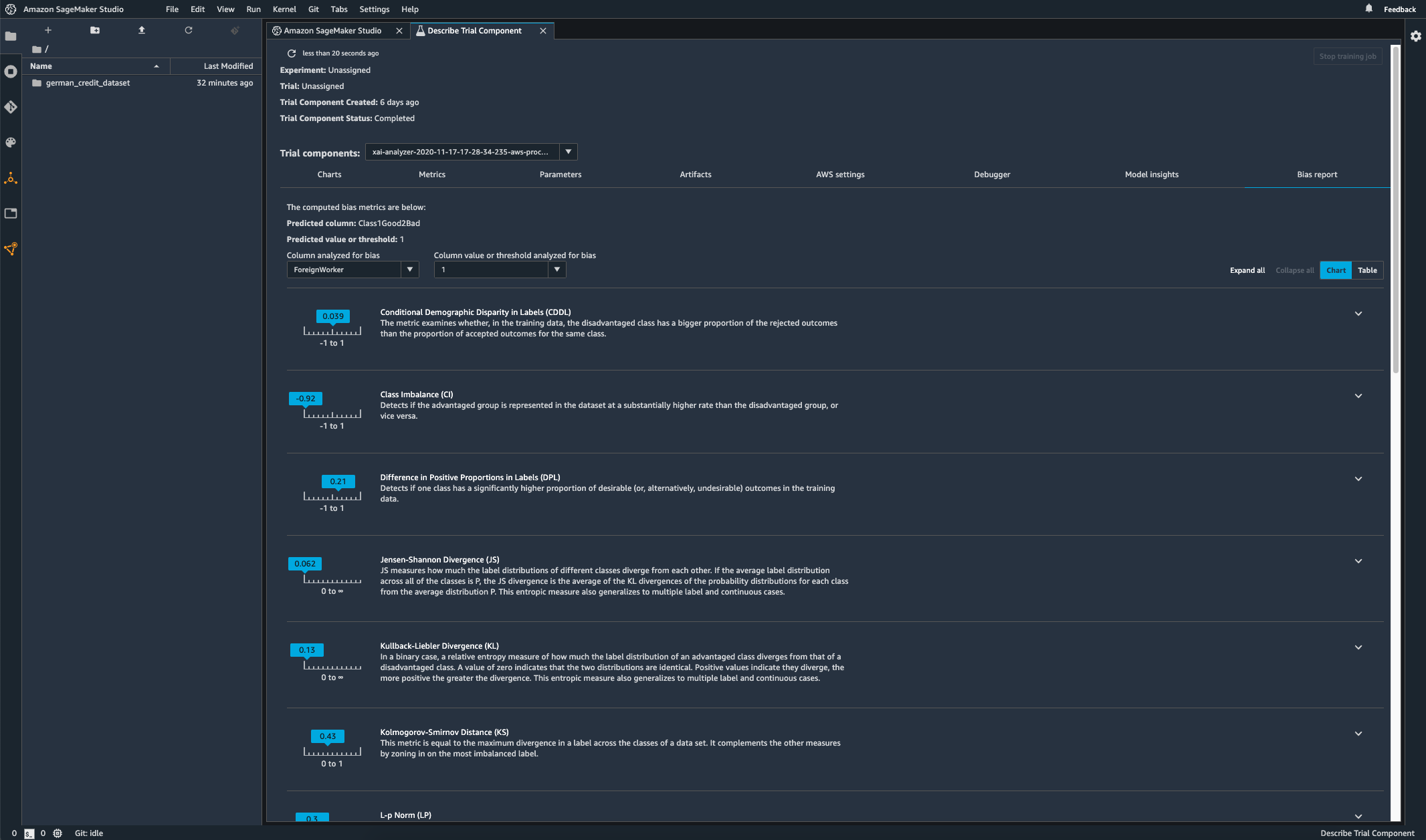

Verificación de sesgos en el modelo entrenado

Una vez que entrene su modelo, puede ejecutar un análisis de sesgo de SageMaker Clarify a través de los Experimentos de Amazon SageMaker para verificar si este tiene un sesgo potencial, como predicciones que producen un resultado negativo con más frecuencia para un grupo que para otro. Especifique las características de entrada con respecto a las cuales desea medir el sesgo en los resultados del modelo, y SageMaker ejecutará un análisis y le proporcionará un informe visual que identifica los diferentes tipos de sesgo por cada característica. El método de código abierto de AWS Fair Bayesian Optimization puede ayudar a mitigar el sesgo al ajustar los hiperparámetros de un modelo.

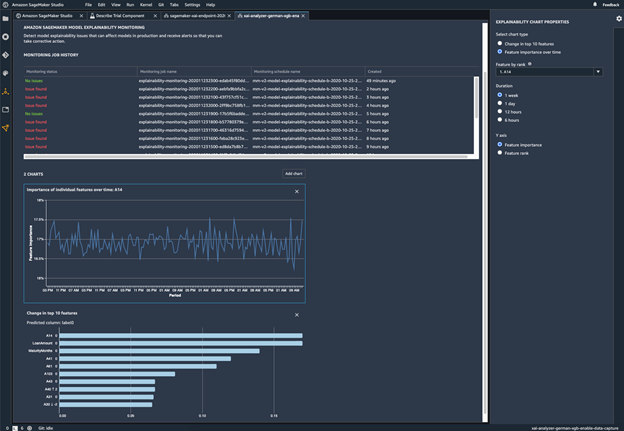

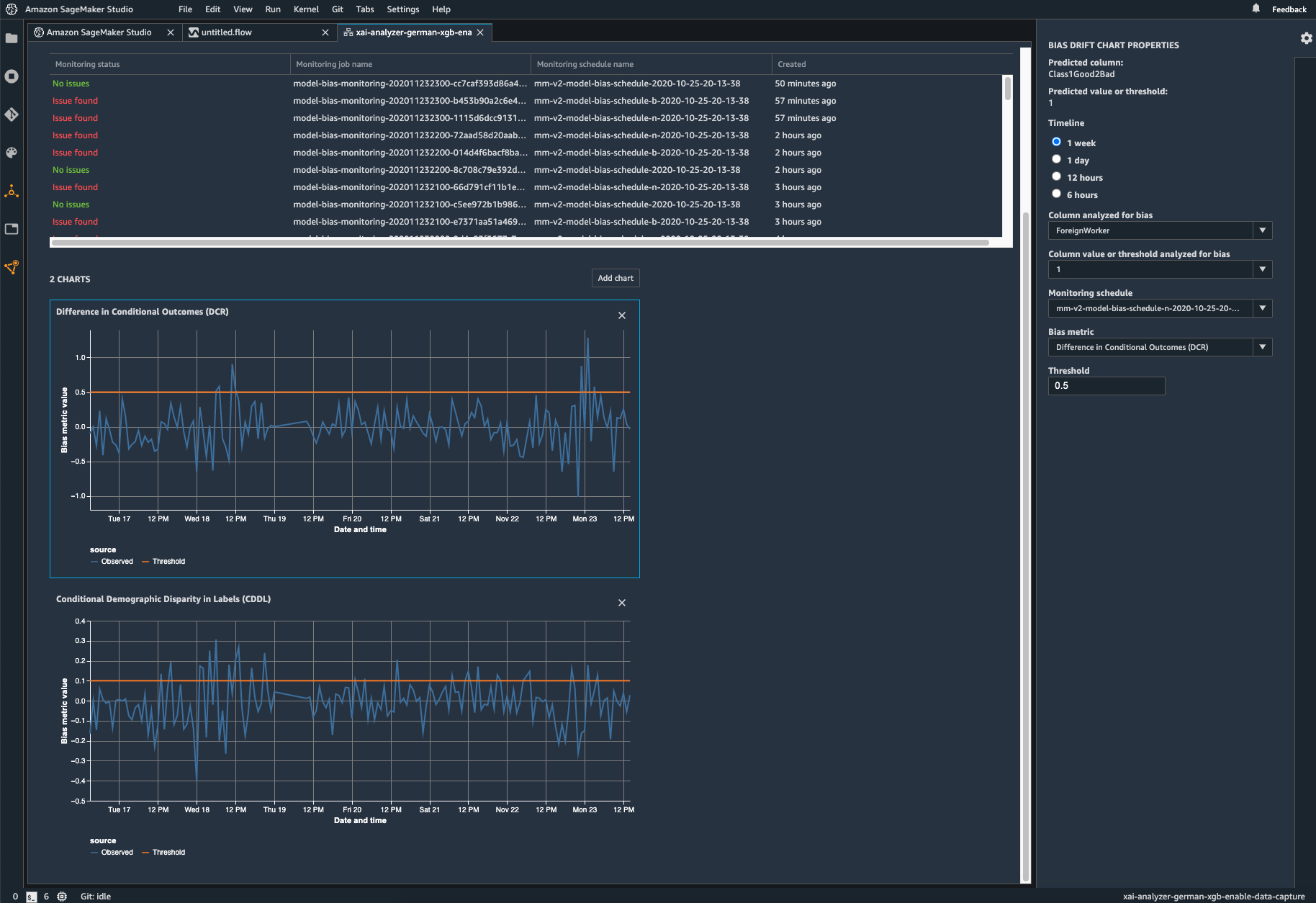

Supervise su modelo implementado para detectar sesgos

El sesgo se puede introducir o exacerbar en los modelos de ML implementados cuando los datos de formación difieren de los datos en directo que el modelo ve durante la implementación. Por ejemplo, los resultados de un modelo para predecir los precios de la vivienda pueden estar sesgados si los tipos hipotecarios usados para formar el modelo difieren de los tipos hipotecarios actuales. Las capacidades de detección de sesgos de SageMaker Clarify están integradas en el Monitor de modelos de Amazon SageMaker, de modo que, cuando SageMaker detecta sesgos más allá de un determinado umbral, genera métricas de manera automática que se pueden ver en Amazon SageMaker Studio y a través de las métricas y alarmas de Amazon CloudWatch.

Recursos

Novedades

- Fecha (de más reciente a más antigua)