인공 지능(AI) 기반 전환은 다양한 산업 분야의 기업에서 비즈니스 혁신을 주도하고 고객 경험과 프로세스를 개선하기 위한 방안으로 고려되고 있습니다. AI 애플리케이션을 구동하는 기계 학습(ML) 모델이 더 복잡해지면서 기본 컴퓨팅 인프라 비용도 늘어나고 있습니다. 기계 학습 애플리케이션을 개발하고 실행하는 데 필요한 인프라 지출 중 최대 90%는 종종 추론에서 발생합니다. 고객들은 프로덕션에 ML 애플리케이션을 배포할 때 사용할 수 있는 비용 효율적인 인프라 솔루션을 찾고 있습니다.

Amazon EC2 Inf1 인스턴스는 저렴한 비용의 고성능 ML 추론을 제공합니다. 비교 가능한 Amazon EC2 인스턴스에 비해 추론당 최대 70% 저렴한 비용으로 최대 2.3배 더 많은 처리량을 제공합니다. Inf1 인스턴스는 ML 추론 애플리케이션을 지원하도록 완전히 새롭게 구축된 인스턴스입니다. 이 인스턴스에는 AWS가 설계하고 제작한 고성능 ML 추론 칩인 AWS Inferentia 칩이 최대 16개 탑재되어 있습니다. 또한 Inf1 인스턴스에는 2세대 인텔 제온 스케일러블 프로세서 및 최대 100Gbps의 네트워킹이 포함되어 뛰어난 추론 처리량을 제공합니다.

Inf1 인스턴스를 사용하면 검색, 추천 엔진, 컴퓨터 비전, 음성 인식, 자연어 처리(NLP), 개인화 및 사기 탐지 같은 대규모 ML 추론 애플리케이션을 실행할 수 있습니다.

TensorFlow, PyTorch, Apache MXNet 등의 인기 ML 프레임워크와 통합되는 AWS Neuron SDK를 사용하여 Inf1 인스턴스에 ML 모델을 배포할 수 있습니다. 동일한 기계 학습 워크플로를 계속 사용할 수 있고 최소의 코드 변경과 공급업체별 솔루션에 구속되지 않고도 Inf1 인스턴스에서 원활하게 애플리케이션을 마이그레이션할 수 있습니다.

Amazon SageMaker, Neuron SDK가 사전에 구성되어 있는 AWS Deep Learning AMI(DLAMI) 또는 컨테이너식 ML 애플리케이션을 위한 Amazon Elastic Container Service(Amazon ECS)나 Amazon Elastic Kubernetes Service(Amazon EKS)를 사용하여 Inf1 인스턴스를 간편하게 시작해 보세요.

이점

추론당 최대 70% 더 저렴한 비용

Inf1을 사용하면 ML 프로덕션 배포 비용을 크게 줄일 수 있습니다. Inf1 인스턴스의 저렴한 인스턴스 비용과 높은 처리량이라는 조합은 비교 가능한 Amazon EC2 인스턴스보다 최대 70% 더 저렴한 추론당 비용을 제공합니다.

사용 편의성 및 코드 이식성

Neuron SDK는 TensorFlow, PyTorch 및 MXNet과 같은 일반적인 ML 프레임워크와 통합됩니다. 동일한 기계 학습 워크플로를 계속 사용할 수 있고 최소의 코드 변경으로 Inf1 인스턴스에서 원활하게 애플리케이션을 마이그레이션할 수 있습니다. 따라서 원하는 ML 프레임워크와 요구 사항에 가장 적합한 컴퓨팅 플랫폼을 사용할 수 있으며 특정 공급업체 솔루션에 구속되지 않고도 최신 기술을 활용할 수 있습니다.

최대 2.3배 더 높은 처리량

Inf1 인스턴스는 비교 가능한 Amazon EC2 인스턴스에 비해 최대 2.3배 더 많은 처리량을 제공합니다. Inf1 인스턴스를 지원하는 AWS Inferentia 칩은 작은 배치 크기의 추론 성능에 최적화되어 실시간 애플리케이션이 처리량을 극대화하고 지연 시간 요구 사항을 충족할 수 있도록 지원합니다.

극도로 짧은 지연 시간

AWS Inferentia 칩에는 대용량 온칩 메모리가 탑재되어 있어서 ML 모델을 칩에서 직접 캐싱할 수 있습니다. 메모리 리소스 외부에 액세스하지 않아도 되는 NeuronCore Pipeline과 같은 기능을 사용하여 모델을 배포할 수 있습니다. Inf1 인스턴스를 사용하면 대역폭에 영향을 주지 않고 실시간에 가까운 지연 시간으로 실시간 추론 애플리케이션을 배포할 수 있습니다.

다양한 ML 모델 및 데이터 유형 지원

Inf1 인스턴스는 이미지 인식 및 분류를 위한 SSD, VGG 및 ResNext, NLP를 위한 Transformer 및 BERT와 같이 일반적으로 널리 사용되는 다수의 ML 모델을 지원합니다. 또한 Neuron은 HuggingFace 모델 리포지토리를 지원하므로 코드 줄 하나만 변경하는 것으로 사전 훈련된 모델 또는 미세 조정된 모델을 사용하여 추론을 손쉽게 컴파일하고 실행할 수 있습니다. BF16 및 FP16 등의 다양한 데이터 유형을 서로 다른 정밀도로 지원하므로 다양한 모델과 성능 요구 사항을 충족할 수 있습니다.

기능

AWS Inferentia 기반

AWS Inferentia는 저렴한 비용으로 높은 성능의 추론을 제공하도록 AWS가 특별히 구축한 ML 칩입니다. 각 AWS Inferentia 칩에는 1세대 NeuronCore 4개가 탑재되어 있고 최대 128 TOPS(초당 조단위 연산)의 성능을 제공하며 FP16, BF16 및 INT8 데이터 유형을 지원합니다. 또한 AWS Inferentia 칩에는 대규모 모델을 캐싱하는 데 사용될 수 있는 고용량 온칩 메모리가 있어 잦은 메모리 액세스가 필요한 모델에 특히 유용합니다.

AWS Neuron을 사용하여 인기 있는 ML 프레임워크로 배포

AWS Neuron SDK는 컴파일러, 런타임 드라이버 및 프로파일링 도구로 구성됩니다. 이 SDK를 사용하면 Inf1 인스턴스를 통해 인기 있는 프레임워크(예: TensorFlow, PyTorch, MXNet)에서 생성하고 훈련한 복잡한 신경망 모델을 배포할 수 있습니다. NeuronCore Pipeline에서는 여러 Inferentia 칩에 걸친 실행을 위해 고속 물리적 칩 간 상호 연결을 사용하여 대규모 모델을 분할하는 기능을 지원하므로 높은 추론 처리량과 저렴한 추론 비용을 제공합니다.

고성능 네트워킹 및 스토리지

Inf1 인스턴스는 고속 네트워킹에 대한 액세스가 필요한 애플리케이션을 위해 최대 100Gbps의 네트워킹 처리량을 제공합니다. 차세대 Elastic Network Adapter(ENA) 및 NVM Express(NVMe) 기술이 적용된 Inf1 인스턴스는 네트워킹 및 Amazon Elastic Block Store(Amazon EBS)에 사용할 수 있는, 처리량이 높고 지연 시간이 짧은 인터페이스를 제공합니다.

AWS Nitro System 기반

AWS Nitro System은 기존의 많은 가상화 기능을 전용 하드웨어 및 소프트웨어로 오프로드하여 고성능, 고가용성 및 뛰어난 보안을 제공하면서 가상화 오버헤드도 줄이는 다양한 빌딩 블록 모음입니다.

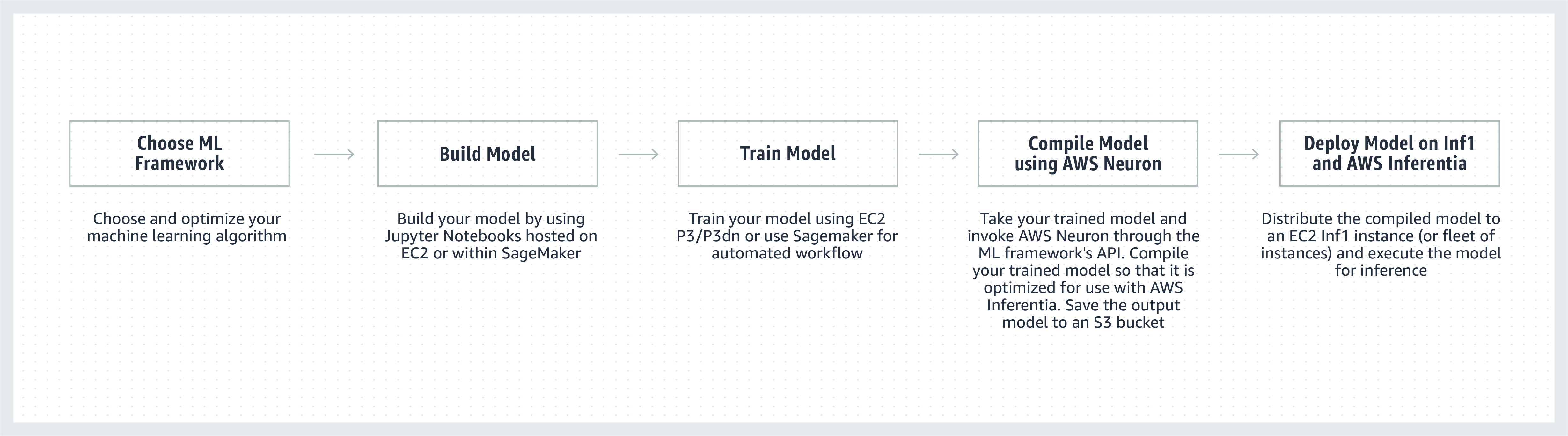

작동 방식

고객 추천사

"Snapchat의 여러 부분에 ML을 도입하고 있는데, 이 분야에서는 혁신 탐구가 최우선 과제입니다. Inferentia에 대해 들었을 때 성능과 비용 등의 측면에서 ML 배포를 지원하기 위해 AWS와 협업하여 Inf1/Inferentia 인스턴스를 채택하기 시작했습니다. 추천 모델로 시작했고, 앞으로는 Inf1 인스턴스와 함께 더 많은 모델을 채택할 수 있기를 기대합니다."

Nima Khajehnouri, Snap Inc. VP Engineering

"Sprinklr의 AI 기반 통합 고객 경험 관리(통합 CXM) 플랫폼을 사용하면 여러 채널의 실시간 고객 피드백을 수집 및 번역하고 실행 가능한 인사이트로 변환하여 문제를 사전에 해결하고, 제품 개발을 개선하고, 콘텐츠 마케팅의 효과를 높이며, 향상된 고객 서비스를 제공할 수 있습니다. Amazon EC2 Inf1을 사용한 후로 NLP 모델 중 하나의 성능이 크게 개선되었고 컴퓨터 비전 모델의 성능도 개선되었습니다. 당사는 계속해서 Amazon EC2 Inf1을 사용하여 글로벌 고객에게 더 나은 서비스를 제공할 계획입니다."

Vasant Srinivasan, Sprinklr Senior Vice President of Product Engineering

“당사의 첨단 NLP 제품인 Finch for Text는 방대한 양의 텍스트에서 다양한 유형의 엔터티를 추출, 명확화 및 보강할 수 있는 기능을 제공합니다. Finch for Text에서 글로벌 데이터 피드를 짧은 지연 시간으로 보강하려면 많은 양의 컴퓨팅 리소스가 필요합니다. 당사는 현재 AWS Inf1 인스턴스를 PyTorch NLP, 번역 및 엔터티 명확화 모델에 사용하고 있는데, GPU를 사용할 때와 비교하여 최소한의 최적화로 추론 속도와 성능을 유지하면서 80% 이상의 추론 비용을 절감할 수 있었습니다. 이 개선을 통해 글로벌 규모에서 스트리밍 데이터 피드의 프랑스어, 스페인어, 독일어, 네덜란드어 텍스트를 실시간으로 보강할 수 있게 되었는데, 금융 서비스, 데이터 집계 기관, 공공 부문 고객에게 중요한 이점이라고 할 수 있습니다.”

Scott Lightner, Finch Computing Chief Technology Officer

“우리는 수십만 개의 소스에서 다양한 형식(이미지, 비디오, 오디오, 텍스트 센서, 이러한 모든 유형의 조합)으로 전 세계에서 발생하는 다양한 유형의 이벤트를 여러 언어로 경고합니다. 이러한 규모를 고려했을 때 속도와 비용을 최적화하는 것은 우리 비즈니스에 절대적으로 중요합니다. AWS Inferentia를 사용하여 모델 지연 시간을 줄이고 달러당 처리량을 최대 9배까지 개선했습니다. 이를 통해 더 정교한 DL 모델을 배포하고 비용을 통제하면서 5배 더 많은 데이터 볼륨을 처리함으로써 모델 정확도를 높이고 플랫폼 기능을 확장할 수 있었습니다.”

Alex Jaimes, Dataminr Chief Scientist and Senior Vice President of AI

"Autodesk는 Inferentia를 사용하여 AI 기반 가상 비서인 Autodesk Virtual Agent(AVA)의 인지 기술을 발전시키고 있습니다. AVA는 자연어 이해(NLU) 및 딥 러닝(DL) 기술로 문의 내용 이면의 맥락, 의도 및 의미를 추출하여 매달 10만 개 이상의 고객 질문에 답합니다. Inferentia를 조종하면서 NLU 모델의 처리량을 G4dn의 4.9배로 높일 수 있었으며 Inferentia 기반 Inf1 인스턴스에서 더 많은 워크로드를 실행할 수 있기를 기대합니다."

Binghui Ouyang, Autodesk Sr. Data Scientist

Amazon EC2 Inf1 인스턴스를 사용하는 Amazon 서비스

Amazon Advertising은 모든 규모의 비즈니스에서 쇼핑 여정의 모든 단계에 있는 고객과 교류하는 데 도움이 됩니다. 텍스트 및 이미지를 포함한 수백만 건의 광고를 조정, 분류 및 제공하여 매일 최적의 고객 경험을 보장합니다.

“텍스트 광고 처리를 위해 전 세계의 AWS Inferentia 기반 Inf1 인스턴스에 PyTorch 기반 BERT 모델을 배포합니다. GPU에서 Inferentia로 전환한 후 비슷한 성능으로 비용을 69%까지 절감할 수 있었습니다. AWS Inferentia용으로 모델을 컴파일하고 테스트하는 데 걸린 시간은 3주 미만이었습니다. Amazon SageMaker를 사용하여 Inf1 인스턴스에 모델을 배포했기 때문에 배포를 확장하고 손쉽게 관리할 수 있습니다. 컴파일된 모델을 처음 분석했을 때 AWS Inferentia는 벤치마크를 다시 실행하여 맞는지 확인해야 할 정도로 인상적인 성능을 제공했습니다. 앞으로는 이미지 광고 처리 모델을 Inferentia로 마이그레이션할 계획입니다. 이러한 모델에서 비슷한 GPU 기반 인스턴스에 비해 이미 30% 짧은 지연 시간과 71%의 비용 절감을 벤치마크했습니다.”

Yashal Kanungo, Amazon Advertising Applied Scientist

뉴스 블로그 읽기 »

"AWS에서 제공하는 Amazon Alexa의 AI 및 ML 기반 인텔리전스는 오늘날 1억 대 이상의 장치에서 사용 가능하며, 당사는 Alexa가 갈수록 더 스마트해지고, 더 진보한 대화를 나누고, 더 능동적이고, 더 만족스러운 경험을 제공할 것을 고객에게 약속드립니다. 이 약속을 지키려면 응답 시간과 ML 인프라 비용의 지속적인 개선이 필요합니다. 당사는 Amazon EC2 Inf1을 사용하여 Alexa 텍스트를 음성으로 변환 기능의 추론 지연 시간을 줄이고 추론당 비용을 낮출 수 있게 된 것을 기쁘게 생각합니다. Amazon EC2 Inf1을 통해 당사는 매월 Alex를 사용하는 수천만 고객에게 더 나은 서비스를 제공할 수 있게 되었습니다."

Tom Taylor, Amazon Alexa Senior Vice President

"고객 경험을 계속해서 개선하고 인프라 비용을 줄이기 위해 계속 혁신하고 있습니다. 웹 기반 질문 답변(WBQA) 워크로드를 GPU 기반 P3 인스턴스에서 AWS Inferentia 기반 Inf1 인스턴스로 이전하면서 추론 비용이 60% 절감되었을 뿐만 아니라, 전체 지연 시간도 40% 넘게 개선되어 Alexa를 통해 고객 Q&A 경험을 향상시킬 수 있었습니다. Tensorflow 기반 모델에 Amazon SageMaker를 사용하자 Inf1 인스턴스로 바로 전환할 수 있었고 관리도 쉬웠습니다. 이제 글로벌 기반으로 Inf1 인스턴스를 사용하여 WBQA 워크로드를 실행하고 추가적으로 비용과 지연 시간을 줄이기 위해 AWS Inferentia에 대한 성능을 최적화하고 있습니다."

Eric Lind, Alexa AI Software Development Engineer

“Amazon Prime Video는 컴퓨터 비전 ML 모델을 사용하여 라이브 이벤트의 비디오 화질을 분석함으로써 Prime Video 회원의 시청 경험을 최적화합니다. 이미지 분류 ML 모델을 EC2 Inf1 인스턴스에 배포한 후 성능이 4배 개선되었고 비용은 40%까지 절감되었습니다. 이제 이 절감한 비용을 고급 모델을 혁신하고 구축하는 데 활용하려고 합니다. 고급 모델은 오디오와 비디오 파일 간의 동기화 차이와 같은 더 복잡한 결함을 감지하여 Prime Video 회원들에게 더 향상된 시청 경험을 제공할 수 있게 될 것입니다.”

Victor Antonino, Amazon Prime Video Solutions Architect

"Amazon Rekognition은 고객이 객체, 사람, 텍스트 및 활동을 식별하는 데 도움이 되는 간단하고 쉬운 이미지 및 비디오 분석 애플리케이션입니다. Amazon Rekognition은 매일 수십억 개의 이미지와 비디오를 분석할 수 있는 고성능 DL 인프라를 필요로 합니다. AWS Inferentia 기반 Inf1 인스턴스를 사용하여 객체 분류와 같은 Amazon Rekognition 모델을 실행하면 GPU에서 이러한 모델을 실행할 때보다 지연 시간이 8배 감소하고 처리량이 2배 증가했습니다. 이러한 결과를 기반으로 고객이 정확한 결과를 더 빠르게 얻을 수 있도록 Amazon Rekognition을 Inf1로 이동하고 있습니다."

Rajneesh Singh, SW Engineering, Amazon Rekognition and Video 부문 Director

요금

* 명시된 요금은 미국 동부(버지니아 북부) AWS 리전 요금입니다. 1년 및 3년 예약 인스턴스의 요금은 “부분 선결제” 결제 옵션에 해당하는 요금이거나, 부분 선결제 옵션이 없는 인스턴스의 경우 “선결제 없음”에 해당하는 요금입니다.

Amazon EC2 Inf1 인스턴스는 미국 동부(버지니아 북부) 및 미국 서부(오레곤) AWS 리전에서 온디맨드, 예약 또는 스팟 인스턴스로 사용 가능합니다.

시작하기

Amazon SageMaker 사용하기

SageMaker를 사용하면 훈련된 ML 모델을 손쉽게 컴파일하고 프로덕션 환경의 Amazon Inf1 인스턴스에 배포하여 짧은 지연 시간으로 실시간 예측을 생성할 수 있습니다. Amazon SageMaker Neo에는 AWS Inferentia용 컴파일러인 AWS Neuron이 통합되어 있기 때문에 훈련된 ML 모델을 컴파일하여 Inf1 인스턴스에서 최적의 상태로 실행할 수 있습니다. SageMaker를 사용하면 여러 가용 영역에 분산된 Inf1 인스턴스의 Auto Scaling 클러스터에서 손쉽게 모델을 실행하여 뛰어난 성능과 고가용성을 모두 갖춘 실시간 추론을 제공할 수 있습니다. GitHub의 예제를 통해 SageMaker를 사용한 Inf1 배포 방법에 대해 알아보세요.

DLAMI 사용

DLAMI는 ML 실무자 및 연구원에게 규모와 관계없이 클라우드에서 DL을 가속화할 수 있는 인프라 및 도구를 제공합니다. AWS Neuron SDK는 Inf1 인스턴스에서 ML 모델을 컴파일 및 실행할 수 있도록 DLAMI에 미리 설치되어 제공됩니다. 시작하기 프로세스에 대한 안내는 AMI 선택 설명서 및 기타 DL 리소스를 참조하세요. DLAMI를 Neuron과 함께 사용하는 방법은 AWS DLAMI 시작 가이드를 참조하세요.

AWS Deep Learning 컨테이너 사용

개발자는 이제 완전 관리형 Kubernetes 서비스인 Amazon EKS뿐 아니라 Amazon의 완전관리형 컨테이너 오케스트레이션 서비스인 Amazon ECS에 Inf1 인스턴스를 배포할 수 있습니다. Amazon EKS 또는 Amazon ECS에서 Inf1을 시작하는 방법에 대해 자세히 알아보세요. Inf1 인스턴스 기반의 컨테이너 실행에 대한 자세한 내용은 Neuron 컨테이너 도구 자습서 페이지를 참조하세요. Neuron도 AWS Deep Learning Containers에 미리 설치되어 제공됩니다.

블로그 및 기사

작성자: Joao Moura, Jason Carlson, Jaspreet Singh, Shaohui Xi, Shruti Koparkar, Haowei Sun, Weiqi Zhang, Zhuoqi Zhangs, 2022년 9월 22일

고성능의 저비용 기계 학습 인프라로 클라우드에서의 혁신 가속화

작성자: MIT Technology Review Insights, 2021년 11월 1일

Amazon SageMaker를 사용하여 컴퓨터 비전 추론을 위한 최적의 AI 액셀러레이터 및 모델 컴파일 선택

작성자: Davide Galliteli 및 Hasan Poonawala, 2021년 10월 19일

작성자: MIT Technology Review Insights, 2021년 10월 15일

AWS Inferentia를 사용해 Amazon EKS에서 시간당 50 USD 이하로 3,000개의 딥 러닝 모델 제공

작성자: Alex Iankoulski, Joshua Correa, Mahadevan Balasubramaniam, Sundar Ranganatha, 2021년 9월 30일

AWS Inferentia에서 PyTorch 자연어 처리 애플리케이션에 대해 즉시 12배 더 높은 처리량과 가장 짧은 지연 시간 달성

작성자: Fabio Nonato de Paula 및 Mahadevan Balasubramaniam, 2021년 5월 4일

Autodesk Ava Chatbot에 대해 AWS Inferentia를 사용하여 PyTorch NLP 모델 성능을 4.9배 촉진하는 방법

작성자: Binghui Ouyang, 2021년 4월 7일

이제 대다수의 Alexa가 더 빠르고 더 비용 효율적인 Amazon EC2 Inf1 인스턴스에서 실행 중

작성자: Sébastien Stormacq, 2020년 11월 12일

Amazon SageMaker에서 고성능 및 비용 효율적 기계 학습 추론을 위해 Inf1 인스턴스 가용성 발표

작성자: Julien Simon, 2020년 4월 22일

Amazon ECS에서 EC2 Inf1 인스턴스 지원 시작

작성자: Julien Simon, 2020년 8월 14일

AWS Inferentia 기반 Inf1 인스턴스에서 TensorFlow OpenPose를 배포하여 가격 성능비 대폭 개선

작성자: Fabio Nonato De Paula 및 Haichen Li, 2020년 7월 22일

Amazon EKS, 이제 EC2 Inf1 인스턴스 지원

작성자: Julien Simon, 2020년 6월 15일

Amazon EC2 업데이트 – 고성능 비용 효율적 추론을 위해 AWS Inferentia 칩을 포함한 Inf1 인스턴스

작성자: Jeff Barr, 2019년 12월 3일

AWS Inferentia, 업계에서 가장 우수한 대규모 객체 감지 모델 성능을 보유하고 AWS 리전 11개에서 정식 출시

작성자: Gadi Hutt, 2020년 9월 28일