Amazon SageMaker Clarify nedir?

SageMaker Clarify'ın Avantajları

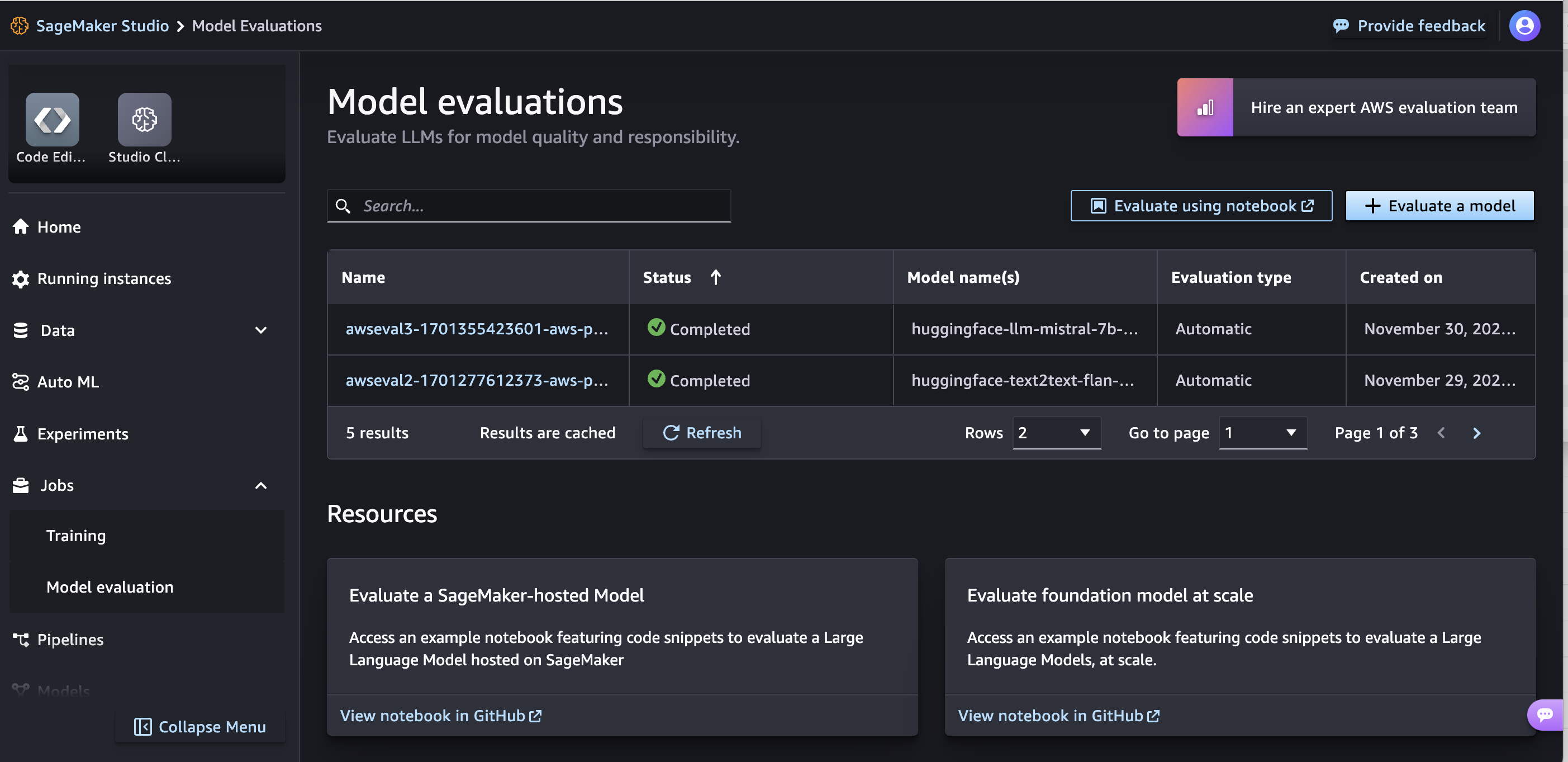

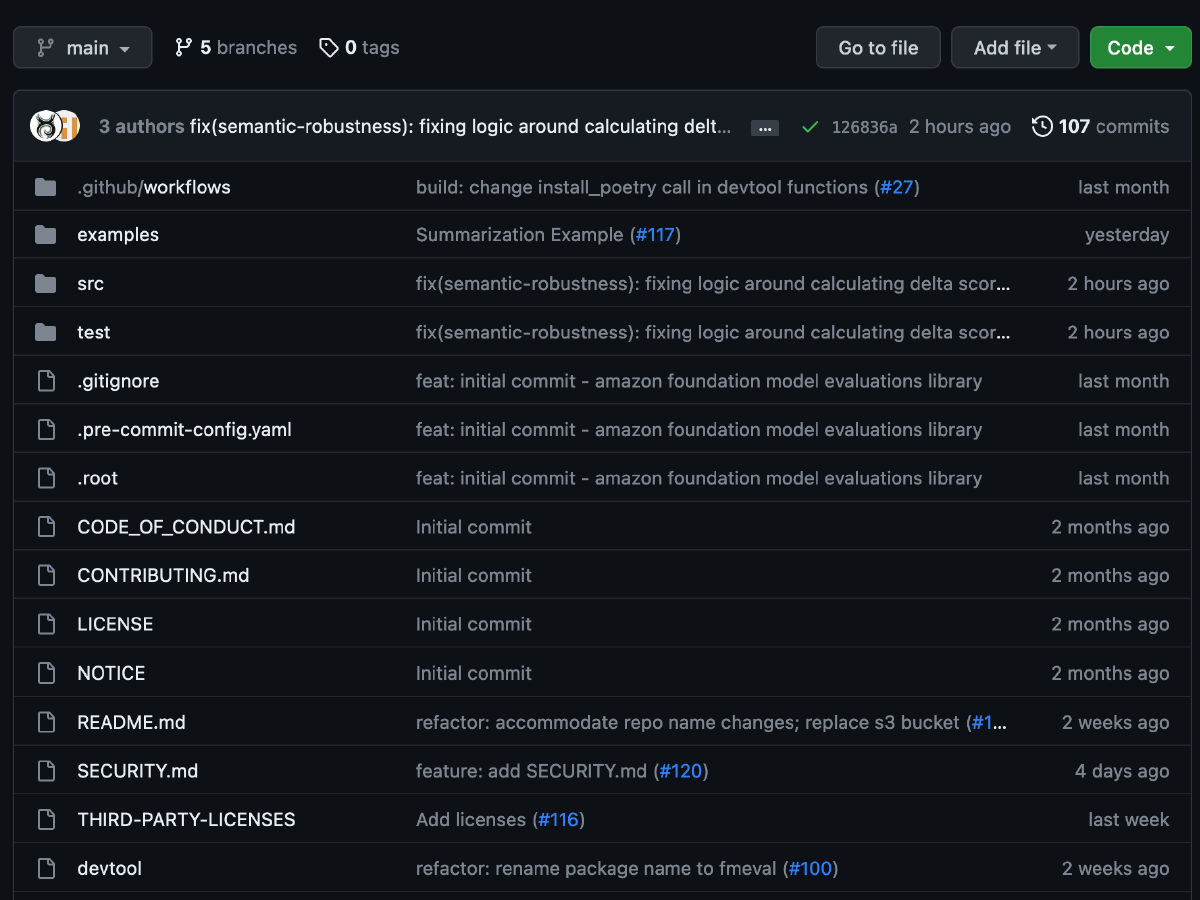

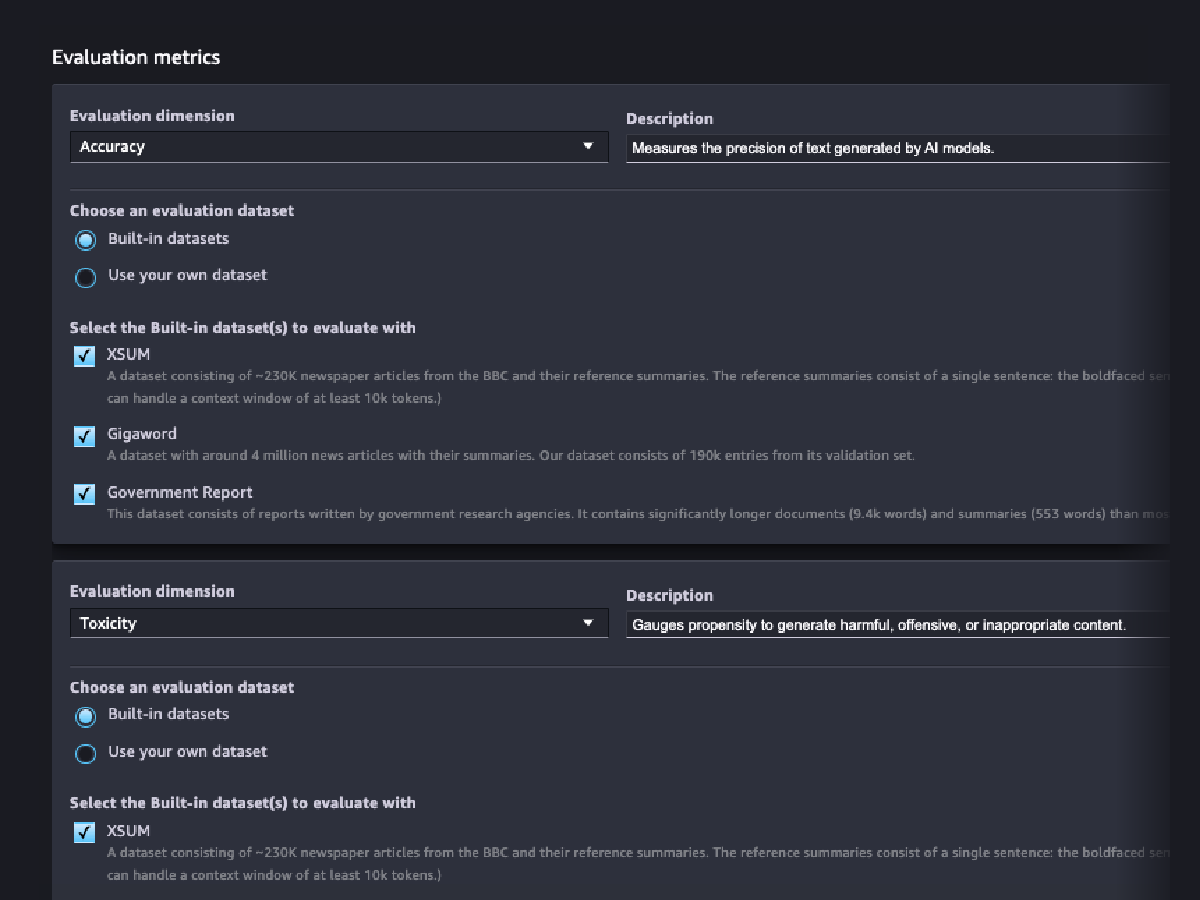

Temel modellerini değerlendirin

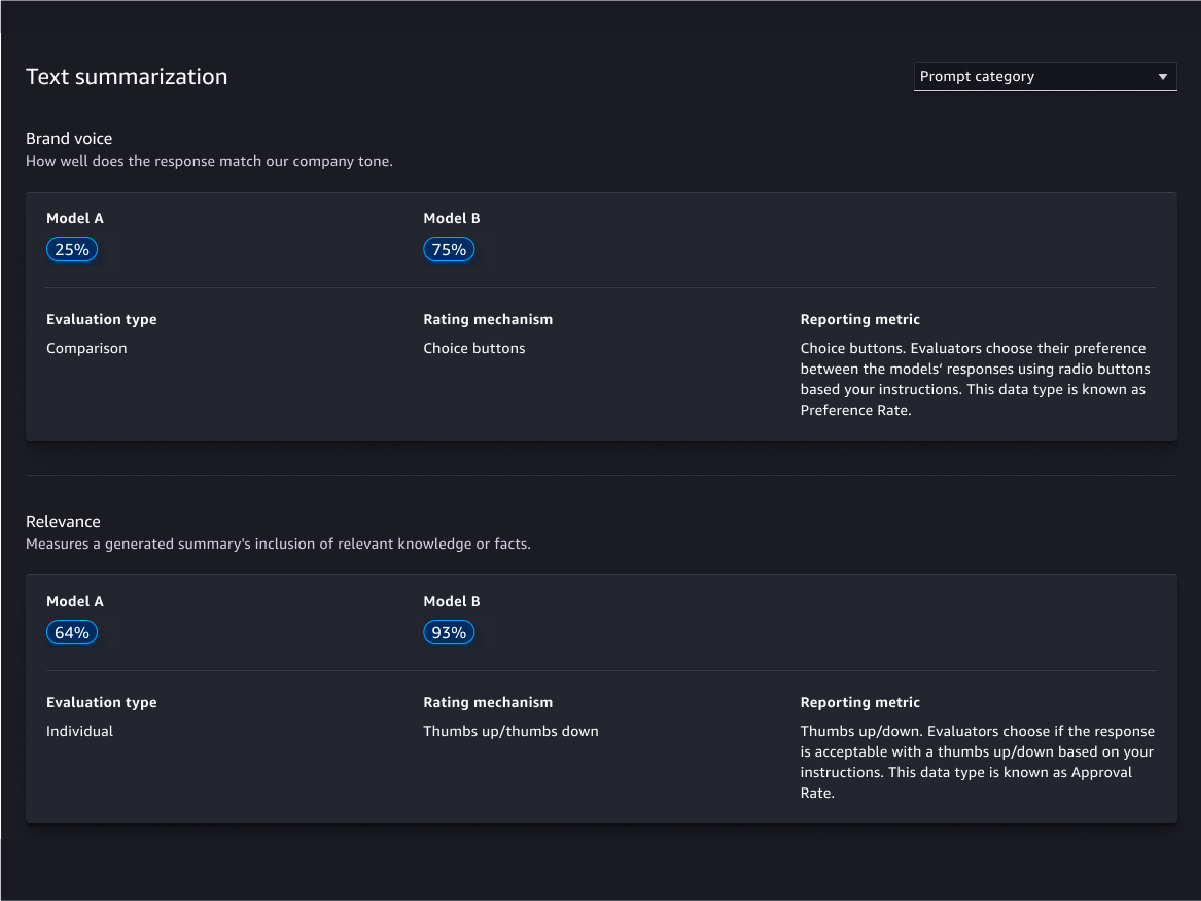

Değerlendirme sihirbazı ve raporlar

Özelleştirme

İnsan temelli değerlendirmeler

Model kalite değerlendirmeleri

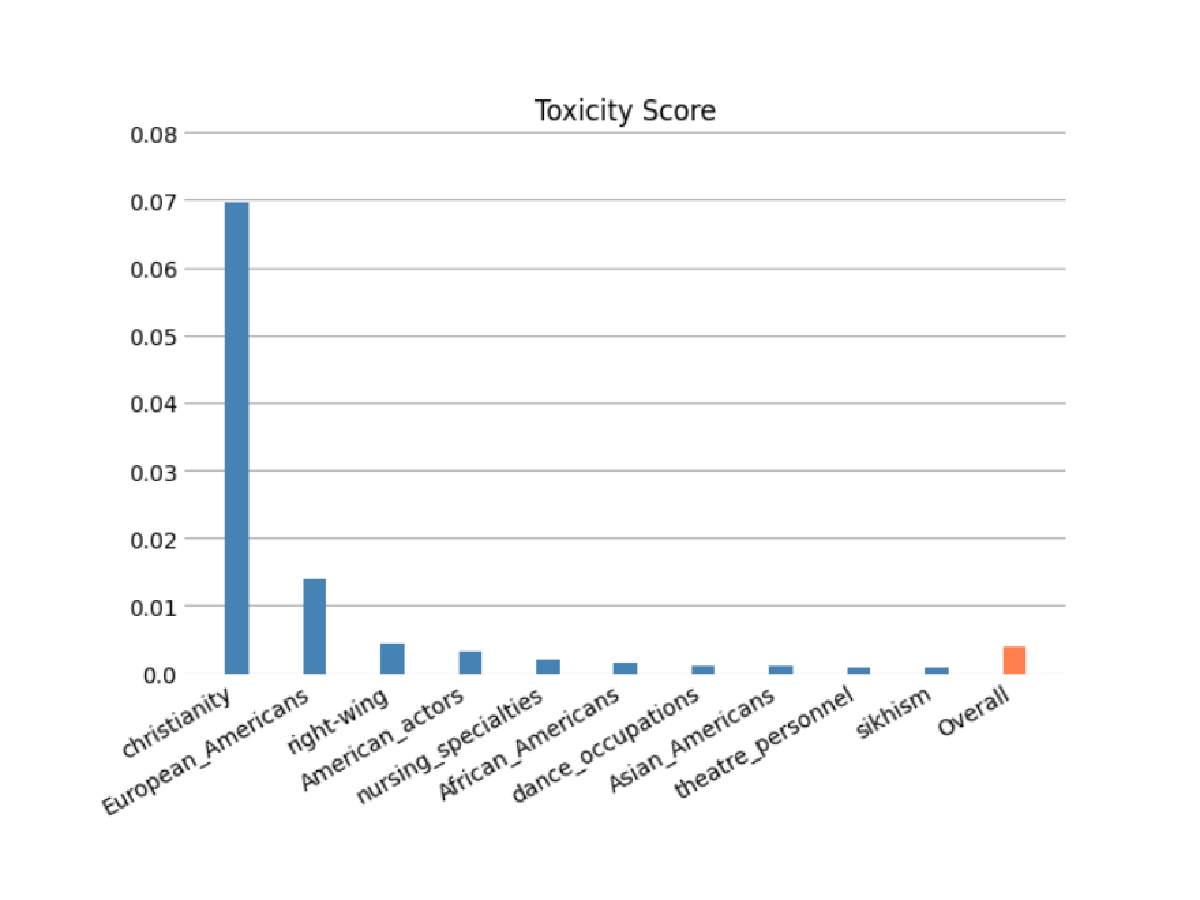

Model sorumluluk değerlendirmeleri

Otomatik ve/veya insan temelli değerlendirmeleri kullanarak altyapı modelinizin ırk/renk, cinsiyet/cinsiyet kimliği, cinsel yönelim, din, yaş, milliyet, engellilik, fiziksel görünüm ve sosyoekonomik durum kategorilerinde stereotipleri kodlama riskini değerlendirin. Zararlı içerik riskini de değerlendirebilirsiniz. Bu değerlendirmeler; açık uçlu oluşturma, özetleme ve soru yanıtlama dahil olmak üzere içerik oluşturmayı içeren herhangi bir göreve uygulanabilir.

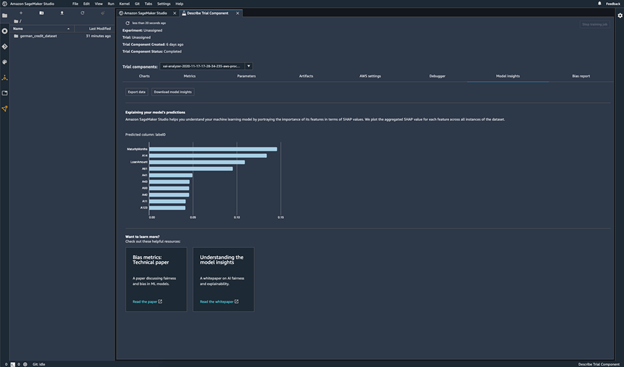

Model tahminleri

Model tahminlerini açıklayın

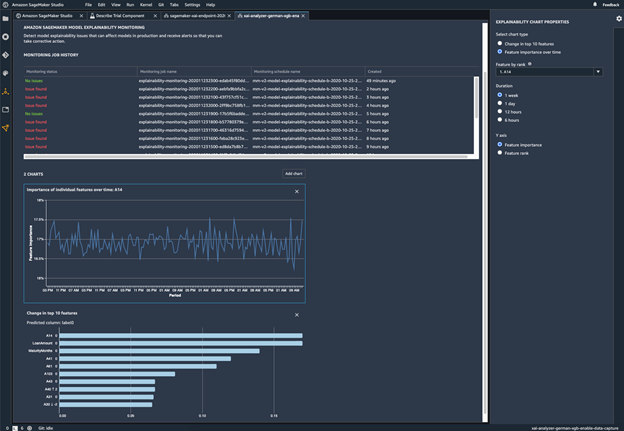

Modelinizdeki davranış değişikliklerini izleyin

Sapmayı tespit edin

Verilerdeki dengesizlikleri belirleyin

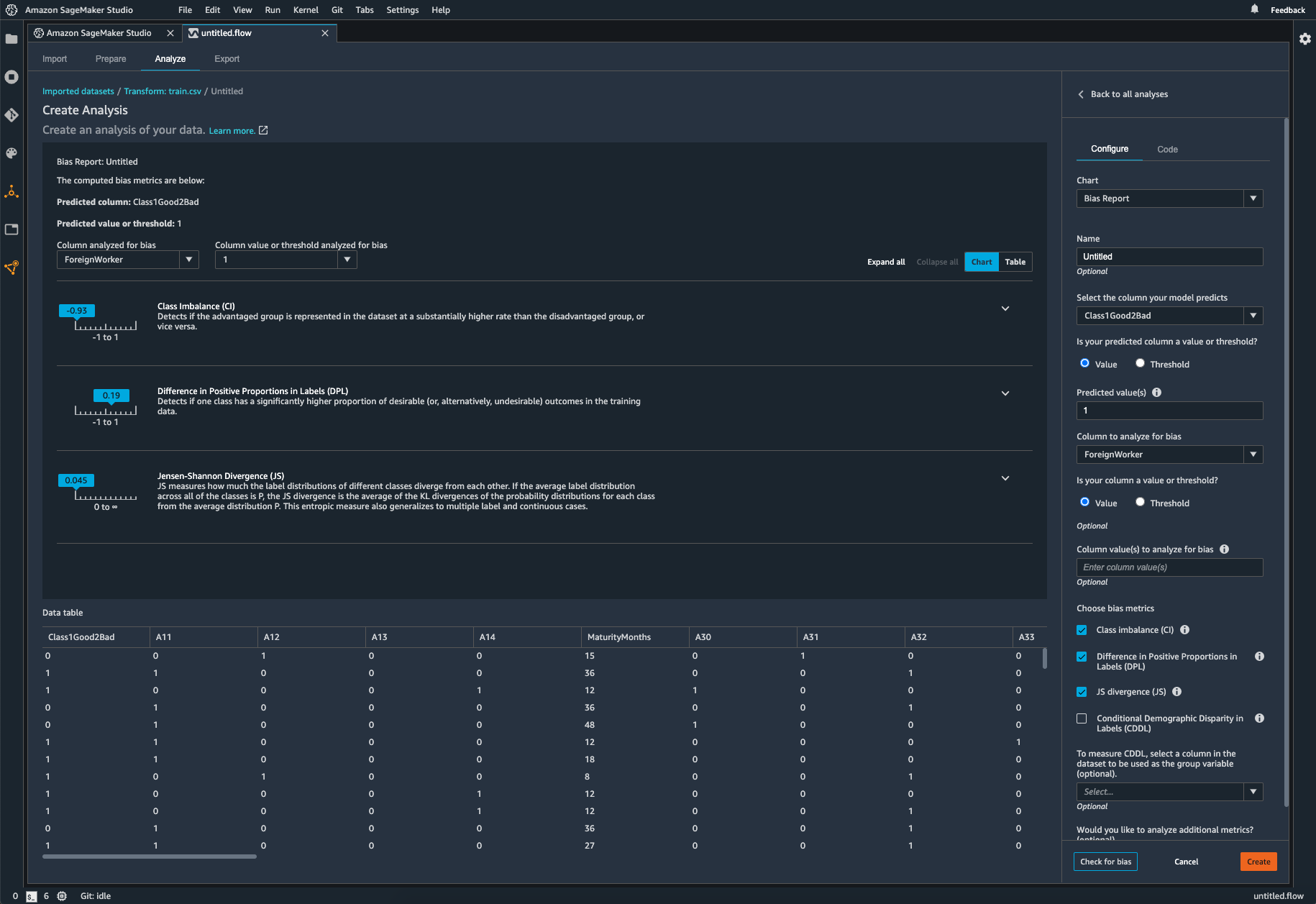

SageMaker Clarify, kod yazmadan veri hazırlama esnasında olası sapmaları belirlemeye yardımcı olur. Cinsiyet veya yaş gibi giriş özelliklerini belirtirsiniz ve SageMaker Clarify, bu özelliklerdeki olası sapmaları tespit etmek için bir analiz işi yürütür. Ardından SageMaker Clarify, sapmaları düzeltecek adımları belirleyebilmeniz için olası sapmaların ölçümlerinin açıklamasını içeren görsel bir rapor sağlar. Dengesizlik durumunda, SageMaker Data Wrangler'ı kullanarak verilerinizi dengeleyebilirsiniz. SageMaker Data Wrangler üç dengeleme operatörü sunar: dengesiz veri kümelerinizdeki verileri yeniden dengelemek için rastgele yetersiz örnekleme, rastgele aşırı örnekleme ve SMOTE.

Eğitilen modelinizde sapma olup olmadığını kontrol edin

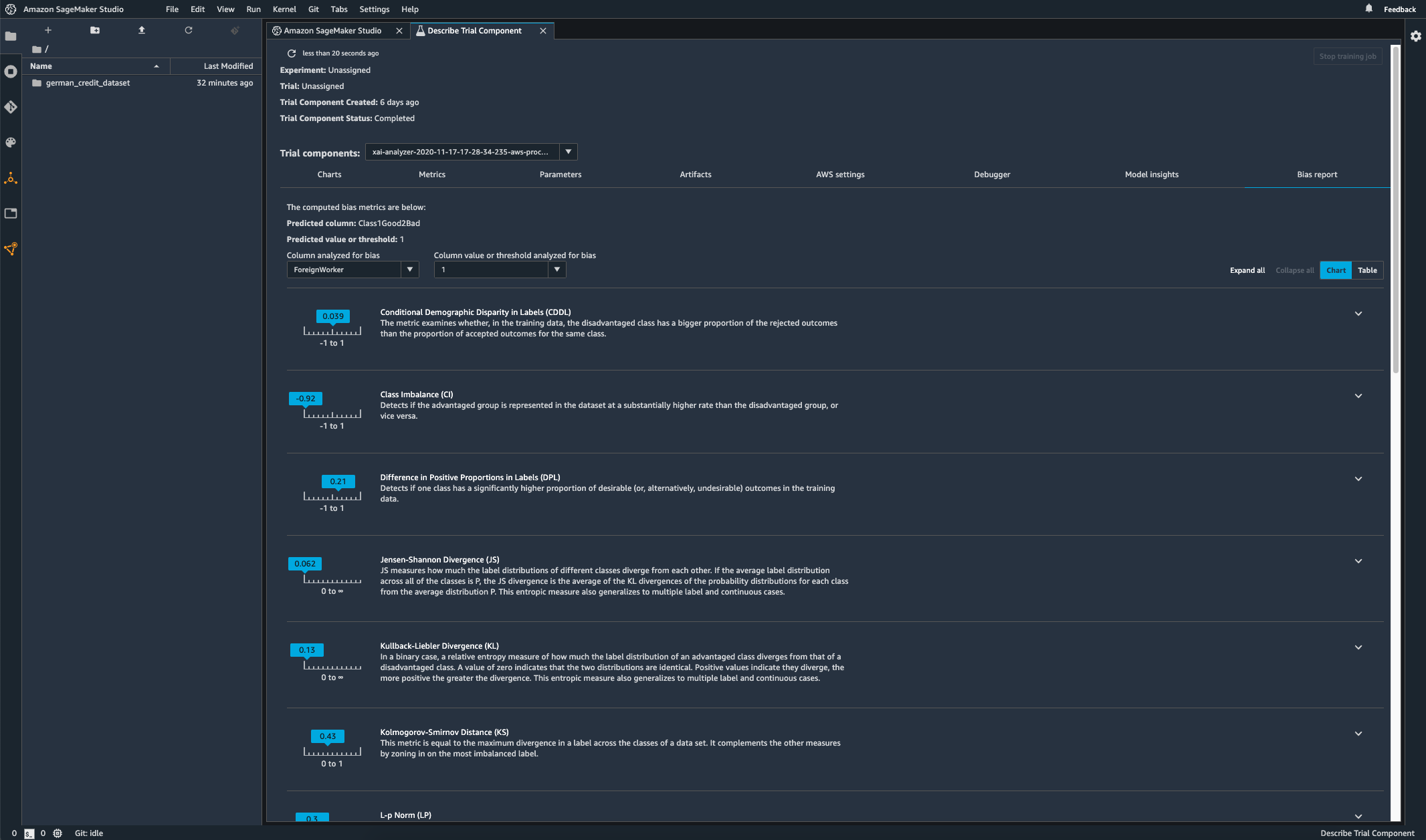

Modelinizi eğittikten sonra, bir grup için diğerine göre daha sık olumsuz sonuç oluşturan tahminler gibi olası sapmalara yönelik olarak modelinizi kontrol etmek üzere Amazon SageMaker Deneyler aracılığıyla bir SageMaker Clarify sapma analizi çalıştırabilirsiniz. Model sonuçlarında ölçmek istediğiniz sapmalara göre girdi özelliklerini belirtirsiniz ve SageMaker bir analiz yürütüp size her özellik için farklı sapma türlerini tanımlayan görsel bir rapor sunar. AWS açık kaynak yöntemi Fair Bayesian Optimization, bir modelin hiperparametrelerini ayarlayarak sapmayı azaltmaya yardımcı olabilir.

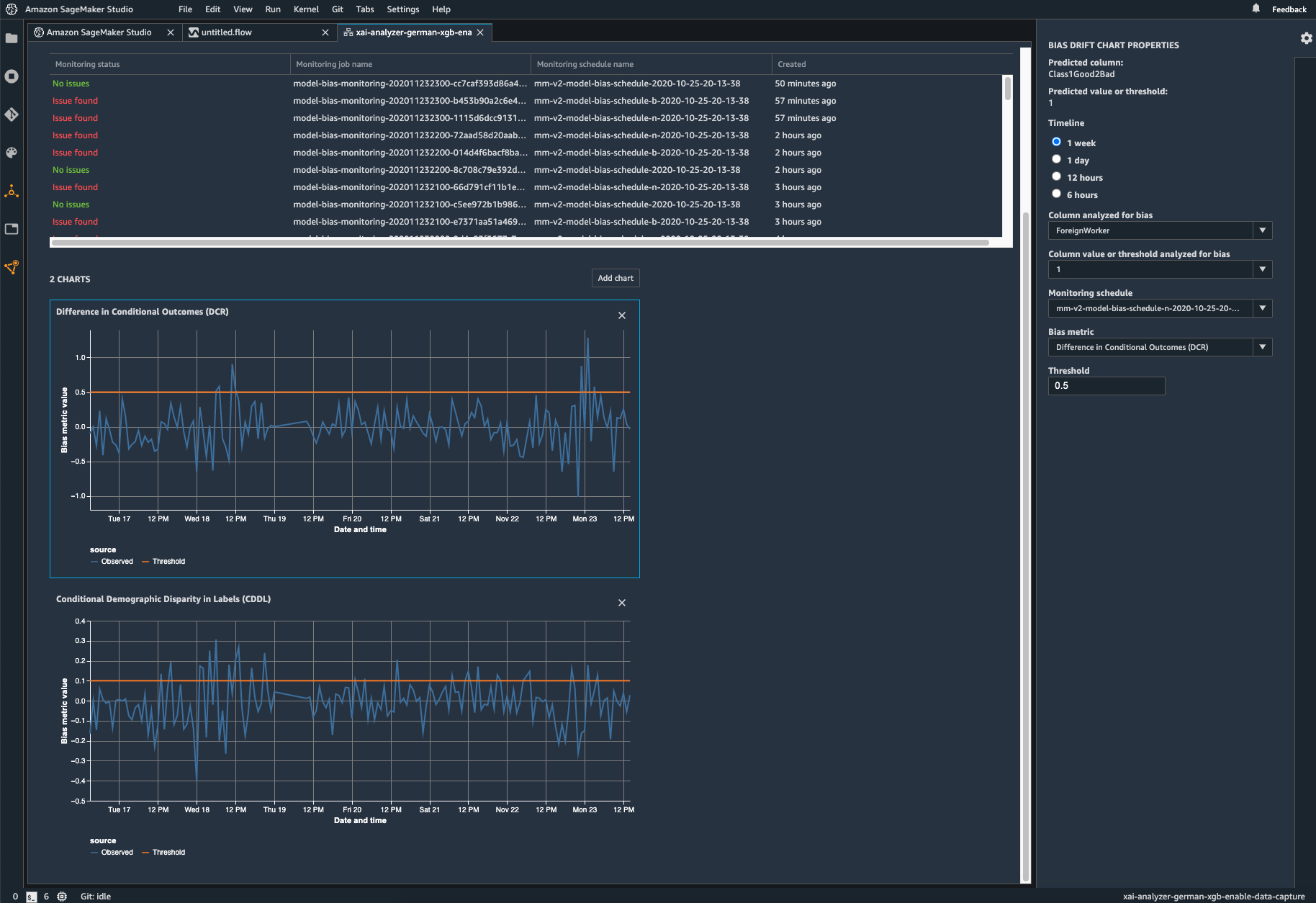

Dağıtılan modelinizde sapma olup olmadığını izleyin

Eğitim verileri, modelin dağıtım sırasında gördüğü canlı verilerden farklı olduğunda, dağıtılan makine öğrenimi modellerinde sapma ortaya çıkabilir veya şiddetlenebilir. Örneğin, modeli eğitmek için kullanılan ipotek oranları mevcut ipotek oranlarından farklıysa ev fiyatlarını tahmin etmeye yönelik bir modelin çıktılarında sapma meydana gelebilir. SageMaker Clarify sapma tespiti özellikleri, Amazon SageMaker Model İzleyici'ye entegre edilmiştir. Böylece SageMaker belirli bir eşiğin ötesinde sapma tespit ettiğinde hem Amazon SageMaker Stüdyosu'nda hem de Amazon CloudWatch ölçüm ve alarmları aracılığıyla görüntüleyebileceğiniz ölçümleri otomatik olarak oluşturur.