不同產業的企業都在研究採用人工智慧 (AI) 技術的轉型,以推動業務創新、改善客戶體驗和程序改進。採用 AI 應用程式的機器學習 (ML) 模型正變得越來越複雜,導致潜在的運算基礎設施成本不斷上升。用於開發和執行 ML 應用程式的基礎設施支出中,高達 90% 通常用於推論。客戶正在尋找具成本效益的基礎設施解決方案,以在生產中部署 ML 應用程式。

Amazon EC2 Inf1 執行個體提供高效能和低成本的 ML 推論。相較於 Amazon EC2 執行個體,其輸送量最多提高 2.3 倍,每次推論成本最多降低 70%。Inf1 執行個體是從基礎開始建置,並支援 ML 推論應用程式。內建最多 16 塊 AWS Inferentia 晶片,這些高效能 ML 推論晶片是由 AWS 設計和建置。此外,Inf1 執行個體包含了第 2 代 Intel Xeon 可擴充處理器,以及最高 100 Gbps 聯網,帶來高輸送量推論。

客戶可以使用 Inf1 執行個體執行大型的 ML 推論應用程式,例如,搜尋推薦、電腦視覺、語音辨識、自然語言處理 (NLP)、個人化作業和詐騙偵測。

開發人員可以與 TensorFlow、PyTorch 和 Apache MXNet 等熱門 ML 架構整合的 AWS Neuron SDK 部署 ML 至 Inf1 執行個體。 他們可以繼續使用相同的 ML 工作流程,並無縫地將應用程式遷移至 Inf1 執行個體,只需變更極少的程式碼,且不受限於廠商專屬的解決方案。

透過使用 Amazon SageMaker、預先設定了 Neuron SDK 的 AWS Deep Learning AMI (DLAMI),或使用 Amazon Elastic Container Service (Amazon ECS) 或 Amazon Elastic Kubernetes Service (Amazon EKS) 實現容器化 ML 應用程式,輕鬆開始使用 Inf1 執行個體。

優勢

每次推論降低最高 70% 的成本

使用 Inf1,開發人員可以大幅降低 ML 產品部署的成本。與 Amazon EC2 執行個體相比,Inf1 執行個體既具有低執行個體成本又具有高輸送量,每次推論成本最多可降低 70%。

易用性和程式碼可攜性

Neuron SDK 與常見的 ML 架構 (如 TensorFlow、PyTorch 和 MXNet) 整合。開發人員可以繼續使用相同的 ML 工作流程,並無縫地將應用程式遷移至 Inf1 執行個體,只需變更極少的程式碼。這可讓他們自由地使用所選擇的 ML 架構、最能滿足其需求的運算平台,並利用最新技術,而不受限於廠商專屬的解決方案。

高達 2.3 倍的更佳輸送量

與 Amazon EC2 執行個體相比,Inf1 執行個體提供高達 2.3 倍的更佳輸送量。 為 Inf1 執行個體提供強大功能的 AWS Inferentia 晶片針對小批量的推斷效能進行了最佳化,可讓即時應用程式最大限度地提高輸送量並滿足延遲要求。

極低延遲

AWS Inferentia 晶片配備大型晶片記憶體,可讓 ML 模型在晶片本身上直接進行快取。您可以使用 NeuronCore Pipeline 之類的功能來部署您的模型,這樣就不需要存取外部記憶體資源。使用 Inf1 執行個體,您能以近乎即時的延遲部署即時推論應用程式,而不會影響頻寬。

支援各種 ML 模型和資料類型

Inf1 執行個體支援許多常用的 ML 模型架構,例如:SSD、VGG 和 ResNext – 進行影像辨識/分類;以及 Transformer 和 BERT – 進行自然語言處理 (NLP)。此外,對 Neuron 中 HuggingFace 模型儲存庫的支援可讓客戶使用預先訓練或微調的模型來輕鬆編譯和執行推論,只需變更一行程式碼即可輕鬆完成。包括 BF16 和 FP16 在內的多種資料類型,具有混合的精準度,也支援各種模型和效能需求。

功能

採用 AWS Inferentia 技術

AWS Inferentia 是 AWS 專門打造的 ML 晶片,能以低成本帶來高效能。每顆 AWS Inferentia 晶片都有四個第一代 NeuronCore,可提供高達每秒 128 萬億次運算 (TOPS) 的效能,並支援 FP16、BF16 和 INT8 資料類型。AWS Inferentia 晶片也具有大量的片上記憶體,可用於快取大型模型,這對於需要頻繁存取記憶體的模型尤其有益。

使用 AWS Neuron 部署熱門 ML 架構

AWS Neuron SDK 由編譯器、執行期驅動程式和分析工具組成。藉此使用 Inf1 執行個體,讓在 TensorFlow、PyTorch 和 MXNet 等熱門架構中建立和經過訓練的複雜神經網路模型得以部署。使用 NeuronCore Pipeline,您可以使用高速實體晶片至晶片互連,將大型模型拆分為多個 Inferentia 晶片來執行的功能,從而提供高推論輸送量並降低推論成本。

高效能網路與儲存

Inf1 執行個體為需要存取高速網絡的應用程式提供高達 100 Gbps 的網絡輸送量。新一代彈性網路介面卡 (ENA) 和 NVM Express (NVMe) 技術為 Inf1 執行個體提供適用於聯網和 Amazon Elastic Block Store (Amazon EBS) 的高輸送量和低延遲界面。

在 AWS Nitro System 上建置

AWS Nitro System 是一個豐富的建置區塊集合,可將許多傳統的虛擬化功能卸載到專用的硬體和軟體,以提供高效能、高可用性和高安全性,還能降低虛擬化的額外負荷。

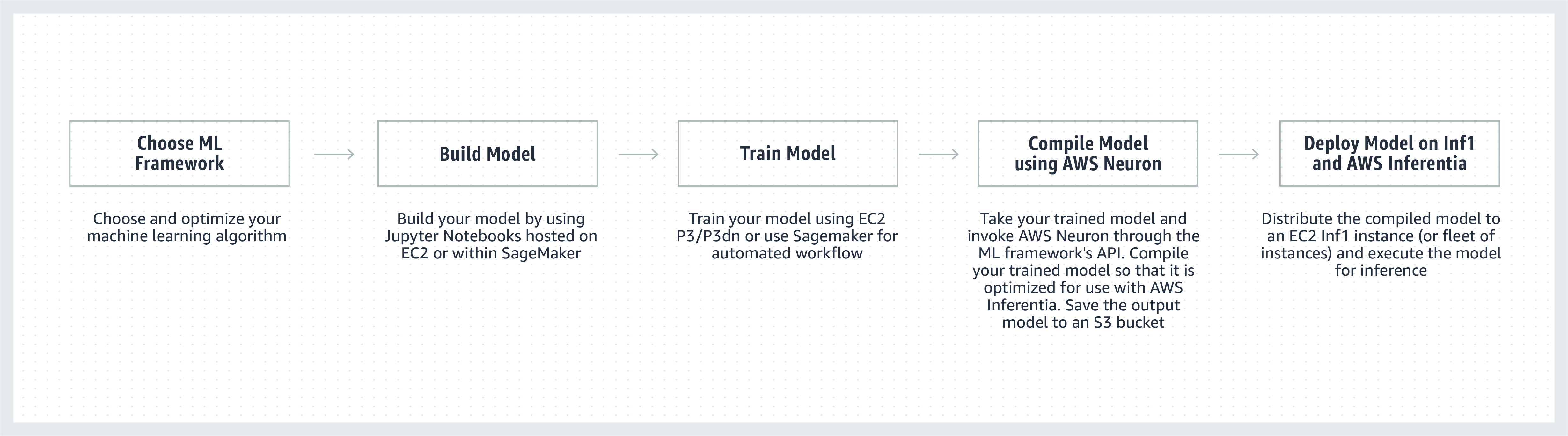

運作方式

客戶見證

Airbnb 成立於 2008 年,總部位於三藩市,是一個社區市集,擁有超過 400 萬名房東,在全球幾乎每個國家接待了超過 9 億賓客。

「Airbnb 的社區支援平台為我們由全球數百萬賓客和房東組成的社區提供智慧、可擴展和卓越的服務體驗。我們一直在尋找各種方法,來提高我們支援聊天機器人應用程式所用 NLP 模型的效能。藉助採用 AWS Inferentia 技術的 Amazon EC2 Inf1 執行個體,我們看到,相較於以 PyTorch 為基礎的 BERT 模型的 GPU 執行個體,輸送量提升了 2 倍。我們期待未來將 Inf1 執行個體用於其他模型和使用案例。」

AirBnB 工程經理 Bo Zeng

「我們將 ML 整合至 Snapchat 的許多方面,探索這一領域的創新是最優先的考量。聽說 Inferentia 後,我們便開始與 AWS 合作,採用 Inf1/Inferentia 執行個體來幫助我們進行 ML 部署,包括圍繞效能和成本方面的合作。我們從我們的推薦模型開始,並期待將來在更多模型上採用 Inf1 執行個體。」

Snap Inc. 工程副總裁 Nima Khajehnouri

「Sprinklr 的 AI 驅動型統一客戶體驗管理 (Unified-CXM) 平台可讓公司跨多個管道收集即时客戶回饋,並將其轉化為可行的洞察,從而主動解決問題、增强產品開發、改進內容行銷、提供更好的客戶服務等。使用 Amazon EC2 Inf1,我們可以大幅提高 NLP 模型的效能,並提高電腦視覺模型的效能。我們期待繼續使用 Amazon EC2 Inf1,更好地為全球客戶提供服務。」

Sprinklr 產品工程副總裁 Vasant Srinivasan

「我們最先進的 NLP 產品 Finch for Text 為使用者提供了在大量文字中擷取、消除歧義和擴充多種類型實體的能力。Finch for Text 需要大量運算資源,來為我們的客戶提供對全球資料摘要的低延遲擴充。我們現在在 PyTorch NLP、翻譯和實體歧義消除模型中使用 AWS Inf1 執行個體。我們能夠以最低程度的最佳化,將推論成本降低 80% 以上 (超過 GPU),同時保持推論速度和效能。這一改善讓我們的客戶能夠在串流資料摘要時,在全球範圍內即時擴充其法文、西班牙文、德文和荷蘭文文字,這對於我們的金融服務、資料彙總工具和公共部門客戶來說至關重要。」

Finch Computin 公司技術長 Scott Lightner

「我們針對世界各地數十萬種來源的許多類型的事件發出提醒,包括多種語言及不同的格式 (影像、影片、音訊、文字感應器、所有這些類型的組合)。由於規模對我們的業務來說絕對至關重要,因此需要針對速度和成本進行優化。藉助 AWS Inferentia,我們降低了模型延遲,並實現了每美元提升高達 9 倍的輸送量。這讓我們能夠部署更複雜的 DL 模型,並處理增加多達 5 倍的資料量,同時控制我們的成本,藉此提高模型的準確度並擴展平台的功能。」

Dataminr 首席科學家兼人工智慧資深副總裁 Alex Jaimes

「Autodesk 正在透過使用 Inferentia,推進我們採用 AI 技術虛擬助理 Autodesk Virtual Agent (AVA) 的認知技術。AVA 透過使用自然語言理解 (NLU) 和深度學習 (DL) 技術來擷取查詢背後的上下文、意圖和含義,每月回答超過 100,000 個客戶問題。與使用 G4dn 相比,試用 Inferentia 時我們的 NLU 模型能夠取得原先 4.9 倍的輸送量,我們期待在 Inferentia 型 Inf1 執行個體上執行更多的工作負載。」

Autodesk 資深資料科學家Binghui Ouyang

使用 Amazon EC2 Inf1 執行個體的 Amazon 服務

Amazon 廣告協助各種規模的企業在購物過程的每個階段都與客戶聯繫。每天都有數百萬的廣告 (包括文字和影像) 被調節、分類和使用,以取得最佳的客戶體驗。

「對於文字廣告處理,我們在 AWS Inferentia 型 Inf1 執行個體上全域部署 PyTorch 型 BERT 模型。透過從 GPU 轉向 Inferentia,我們能够以相當的效能將成本降低 69%。編譯和測試我們的 AWS Inferentia 模型不到三週。使用 Amazon SageMaker 將我們的模型部署至 Inf1 執行個體,確保了我們的部署可擴展且易於管理。當我第一次分析編譯的模型時,AWS Inferentia 的效能令人印象深刻,以至於我不得不重新執行基準測試以確保它們是正確的! 接下來,我們計劃將影像廣告處理模型遷移至 Inferentia。我們已經對這些模型進行基準測試,與可比的 GPU 型執行個體相比,延遲降低了 30%,成本節約了 71%。」

Amazon 廣告應用科學家 Yashal Kanungo

閱讀新聞部落格 »

「採用 AWS 技術的 Amazon Alexa AI 和 ML 智慧目前已用於上億台裝置,我們對客戶的承諾是 Alexa 一直在變得更智慧、更對話式、更主動甚至更令人愉快。為實現承諾,需要繼續縮短回應時間以及降低 ML 基礎設施成本,這也是我們樂於使用 Amazon EC2 Inf1 在 Alexa 文字轉換語音方面降低推論延遲和每次推論成本的原因。有了 Amazon EC2 Inf1,我們可以讓數以千萬計每月使用 Alexa 的客戶獲得更好的服務。」

Amazon Alexa 資深副總裁 Tom Taylor

「我們不斷創新以進一步改善我們的客戶體驗並降低我們的基礎設施成本。將我們基於 Web 的問答 (WBQA) 工作負載從基於 GPU 的 P3 執行個體遷移到基於 AWS Inferentia 的 Inf1 執行個體,不僅幫助我們將推論成本降低了 60%,還將端到端延遲降低了 40% 以上,幫助提升客戶對 Alexa 的問答體驗。將 Amazon SageMaker 用於我們基於 TensorFlow 的模型,讓切換到 Inf1 執行個體的過程變得簡單且易於管理。我們現在在全球範圍內使用 Inf1 執行個體來執行這些 WBQA 工作負載,並正在為 AWS Inferentia 最佳化其效能,以進一步降低成本和縮短延遲。」

Alexa AI 軟體開發工程師 Eric Lind

「Amazon Prime Video 使用電腦視覺 ML 模型,來分析即時活動的影片品質,以確保 Prime Video 會員獲得最佳的觀看體驗。我們在 EC2 Inf1 執行個體上部署我們的影像分類 ML 模型,並且能夠看到 4 倍的效能提升,以及高達 40% 的成本節省。我們目前正在尋求充分利用這些成本節省,來進行創新和建置進階模型,這能夠偵測更複雜的缺陷,如音訊與影片檔案之間的同步間隙,從而為 Prime Video 會員提供更進階的觀看體驗。」

Amazon Prime Video 解決方案架構師 Victor Antonino

「Amazon Rekognition 是一種簡單易用的影像和影片分析應用程式,可幫助客戶識別物件、人物、文字和活動。Amazon Rekognition 需要高效能的 DL 基礎設施,以便每天為我們的客戶分析數十億個影像和影片。與在 GPU 上執行相比,使用 AWS Inferentia 型 Inf1 執行個體執行 Amazon Rekognition 模型 (例如物件分類) 可將延遲降低至原來的 8 倍,將輸送量提高至原來的 2 倍。鑒於這些結果,我們正在將 Amazon Rekognition 移至 Inf1,讓我們的客戶能夠更快地取得準確結果。」

Amazon Rekognition and Video 軟體工程 Rajneesh Singh

定價

*所示價格是針對美國東部 (維吉尼亞北部) AWS 區域。1 年期和 3 年期預留執行個體的價格適用於「部分預付」付款選項,沒有「部分預付」選項的執行個體則適用於「無預付」。

美國東部 (維吉尼亞北部) 及美國西部 (奧勒岡) AWS 區域的 Amazon EC2 Inf1 執行個體可提供隨需、預留或競價型執行個體等形式。

入門

使用 Amazon SageMaker

SageMaker 讓您可以更輕鬆地在生產中的 Amazon Inf1 執行個體上編譯和部署經過訓練的 ML 模型,以便開始產生具有低延遲的即時預測。AWS Neuron 是一款 AWS Inferentia 編譯器,與 Amazon SageMaker Neo 整合,協助您編譯經過訓練的 ML 模型,從而在 Inf1 執行個體上以最佳方式執行。藉助 SageMaker,您可以輕鬆在分佈於多個可用區域的 Inf1 執行個體自動調整規模叢集上執行模型,以提供高效能和高可用性即時推論。透過 GitHub 上的範例,了解如何使用 SageMaker 部署至 Inf1。

使用 DLAMI

DLAMI 為 ML 從業人員和研究人員提供基礎設施和各種工具,以加速雲端中各種規模的 DL 工作。AWS Neuron SDK 預先安裝於 DLAMI 中,以最佳方式在 Inf1 執行個體上編譯和執行 ML 模型。如需協助您完成入門程序的指導,請參閱 AMI 選購指南和更多 DL 資源。請參閱 AWS DLAMI 入門指南,了解如何透過 Neuron 使用 DLAMI。

使用深度學習容器

開發人員目前可以在 Amazon EKS 上部署 Inf1 執行個體,這是一種全受管 Kubernetes 服務;也可以在 Amazon ECS 中部署,這是一種 Amazon 的全受管容器協同運作服務。進一步了解在 Amazon EKS 上或透過 Amazon ECS 開始使用 Inf1 的資訊。更多關於 Inf1 執行個體上執行容器的詳細資訊,請參閱 Neuron 容器工具教學頁面。Neuron 也可以預先安裝在 AWS Deep Learning Containers 中。

部落格和文章

Amazon 搜尋如何使用 AWS Inferentia 將機器學習推理成本降低 85%

作者:Joao Moura、Jason Carlson、Jaspreet Singh、Shaohui Xi、Shruti Koparkar、Haowei Sun、Weiqi Zhang 和 Zhuoqi Zhangs,2022 年 9 月 22 日

作者:MIT Technology Review Insights,2021 年 11 月 1 日

使用 Amazon SageMaker 為電腦視覺推論選擇最佳 AI 加速器和模型編譯

作者:Davide Galliteli 和 Hasan Poonawala,2021 年 10 月 19 日

作者:MIT Technology Review Insights,2021 年 10 月 15 日

使用 AWS Inferentia 以每小時不到 50 USD 的費用在 Amazon EKS 上提供 3,000 個深度學習模型

作者︰Alex Inkolsky、Joshua Curry、Mahadevan Balasubramaniam 和 Sundar Ranganatha,2021 年 9 月 30 日

使用 AWS Inferentia 上開箱即用的 PyTorch 自然語言處理應用程式獲得提升 12 倍的輸送量和最低延遲

作者:Fabio Nonato de Paula 和 Mahadevan Balasubramaniam,2021 年 5 月 4 日

我們如何使用 AWS Inferentia 將 Autodesk Ava Chatbot 的 PyTorch NLP 模型效能提高 4.9 倍

作者:Binghui Ouyang,2021 年 4 月 7 日

絕大多數 Alexa 現在能在更快、更經濟高效的 Amazon EC2 Inf1 執行個體上執行

作者︰Sébastien Stormacq,2020 年 11 月 12 日

宣布 Amazon SageMaker 中提供 Inf1 執行個體,可實現高效能和經濟高效的機器學習推論

作者:Julien Simon,2020 年 4 月 22 日

作者:Julien Simon,2020 年 8 月 14 日

在基於 AWS Inferentia 的 Inf1 執行個體上部署 TensorFlow OpenPose,大幅提升成本效益

作者:Fabio Nonato De Paula 和 Haichen Li,2020 年 07 月 22 日

作者︰Julien Simon,2020 年 06 月 15 日

Amazon EC2 更新 – 搭載 AWS Inferentia 晶片的 Inf1 執行個體可實現經濟高效的高效能推理

作者:Jeff Barr,2019 年 12 月 3 日

AWS Inferentia 現於 11 個 AWS 區域開放使用,具備一流的效能,可大規模執行物件偵測模型

作者︰Gadi Hutt,2020 年 9 月 28 日