مثيلات Amazon EC2 Inf1

تبحث الشركات عبر مجموعة متنوعة من الصناعات في التحول المدعوم بالذكاء الاصطناعي (AI) لدفع الابتكار في الأعمال وتحسين تجربة العملاء وتحسينات العمليات. أصبحت نماذج تعلم الآلة (ML) التي تدعم تطبيقات الذكاء الاصطناعي معقدة بشكل متزايد، مما يؤدي إلى ارتفاع تكاليف البنية التحتية للحوسبة الأساسية. يُنسب ما يصل إلى 90% من الإنفاق على البنية التحتية إلى عمليات الاستدلال بغرض تطوير تطبيقات التعلم الآلي وتشغيلها. يبحث العملاء عن حلول فعالة من حيث التكلفة للبنية التحتية من أجل نشر تطبيقات التعلم الآلي التي في مرحلة الإنتاج.

توفر مثيلات Amazon EC2 Inf1 عمليات استدلال تعلّم آلة عالية الأداء مقابل أقل تكلفة. فإن هذه المثيلات توفر معدل نقل أعلى بما يصل إلى 2.3 مرة وبتكلفة أقل تصل إلى 70% لكل عملية استدلال مقارنةً بمثيلات سحابة الحوسبة المرنة لـ Amazon (Amazon EC2). يتم إنشاء مثيلات Inf1 من الألف إلى الياء لدعم تطبيقات استدلال تعلّم الآلة (ML). وهي تحتوي على ما يصل إلى 16 شريحة AWS Inferentia وشرائح استدلال تعلم الآلة (ML) عالية الأداء تم تصميمها وصنعها بواسطة AWS. بالإضافة إلى ذلك، تشتمل مثيلات Inf1 على معالجات Intel Xeon Scalable من الجيل الثاني وشبكات تصل سرعتها إلى 100 جيجابت في الثانية لتقديم استدلال عالي الإنتاجية.

يمكن للعملاء استخدام مثيلات Inf1 لتشغيل تطبيقات استدلال تعلّم الآلة (ML) واسعة النطاق مثل البحث ومحركات التوصية ورؤية الكمبيوتر والتعرف على الكلام ومعالجة اللغة الطبيعية (NLP) والتخصيص واكتشاف الاحتيال.

يمكن للمطورين نشر نماذج تعلم الآلة الخاصة بهم في مثيلات Inf1 باستخدام AWS Neuron SDK، التي تتكامل مع أطر تعلم الآلة الشائعة مثل TensorFlow وPyTorch وApache MXNet. يمكنهم الاستمرار في استخدام نفس عمليات سير عمل تعلم الآلة (ML) وترحيل التطبيقات بسلاسة إلى مثيلات Inf1 مع الحد الأدنى من تغييرات التعليمات البرمجية وبدون الارتباط بالحلول الخاصة بالبائع.

يمكنك بدء استخدام مثيلات Inf1 بسهولة من خلال Amazon SageMaker أو AWS Deep Learning AMI (DLAMI) التي تم تكوينها مسبقًا باستخدام Neuron SDK أو خدمة حاويات Amazon المرنة (Amazon ECS) أو خدمة Kubernetes المرنة بـ Amazon (Amazon EKS) لتطبيقات تعلم الآلة في حاويات.

الفوائد

تكلفة أقل حتى 70% لكل عملية استدلال

باستخدام Inf1، يمكن للمطورين تقليل تكلفة عمليات نشر إنتاج ML بشكل كبير. يوفر الجمع بين التكلفة المنخفضة للمثيل والإنتاجية العالية لمثيلات Inf1 تكلفة أقل بنسبة تصل إلى 70٪ لكل استنتاج مقارنة بمثيلات Amazon EC2 المماثلة.

سهولة الاستخدام وإمكانية نقل التعليمات البرمجية

تتكامل مجموعة تطوير البرمجيات (SDK) الخاصة بـ Neuron مع أُطر عمل تعلم الآلة الشائعة، مثل TensorFlow وPyTorch وMXNet. يمكن للمطورين الاستمرار في استخدام سير عمل التعلم الآلي نفسه وترحيل التطبيقات بسلاسة إلى مثيلات Inf1 بأقل تغييرات في التعليمات البرمجية. وهذا يمنحهم حرية استخدام إطار تعلم الآلة المفضل، ومنصة الحوسبة التي تلبي متطلباتهم على أفضل وجه، وأحدث التقنيات دون الارتباط بالحلول الخاصة بالبائع.

معدل نقل أعلى بما يصل إلى 2.3 مرة

توفر مثيلات Inf1 معدل نقل أعلى بما يصل إلى 2.3 مرة مقارنةً بمثيلات سحابة الحوسبة المرنة لـ Amazon (Amazon EC2). تتميز رقاقات AWS Inferentia المشغِّلة لمثيلات Inf1 بأنها محسَّنة لتعزيز أداء عمليات الاستدلال للدفعات صغيرة الحجم، ما يمكِّن تطبيقات الوقت الفعلي من زيادة معدل النقل إلى أقصى حد وتلبية متطلبات زمن الاستجابة.

وقت استجابة منخفض للغاية

تم تجهيز رقائق AWS Inferentia بذاكرة كبيرة على الرقاقة تتيح التخزين المؤقت لنماذج ML مباشرة على الشريحة نفسها. يمكنك نشر نماذجك باستخدام إمكانيات مثل مسار NeuronCore الذي يلغي الحاجة إلى الوصول إلى موارد الذاكرة الخارجية. مع مثيلات Inf1، يمكنك نشر تطبيقات استدلال الوقت الفعلي بأوقات استجابة في الوقت الفعلي تقريبًا بدون التأثير في النطاق الترددي.

دعم نماذج ML وأنواع البيانات المختلفة

تدعم مثيلات Inf1 العديد من بنيات نماذج ML الشائعة الاستخدام مثل SSD وVGG وResNext للتعرف على الصور/تصنيفها، بالإضافة إلى Transformer وBERT لـ NLP. بالإضافة إلى ذلك، دعم مستودع نماذج HuggingFace في Neuron يوفر للعملاء القدرة على تجميع الاستدلال وتشغيله بسهولة باستخدام نماذج تم اختبارها مسبقًا أو ضبطها بدقة عن طريق تغيير سطر واحد فقط من التعليمات البرمجية. يتم أيضًا دعم أنواع البيانات المتعددة بما في ذلك BF16 وFP16 بدقة مختلطة لمختلف النماذج واحتياجات الأداء.

الميزات

مدعومة من AWS Inferentia

AWS Inferentia عبارة عن شريحة ML مصممة خصيصًا بواسطة AWS لتقديم استدلال عالي الأداء بتكلفة منخفضة. تتضمن كل رقاقة من رقاقات AWS Inferentia أربعةً من معالجات NeuronCores من الجيل الأول وتوفر ما يصل إلى 128 تريليون عملية في الثانية (TOPS) من الأداء ودعمًا لأنواع البيانات FP16 وBF16 وINT8. تتميز رقاقات AWS Inferentia بكم كبير من ذاكرة الرقاقة التي يمكن استخدامها في التخزين المؤقت للنماذج الكبيرة، التي تعد مفيدةً بوجه خاص للنماذج التي تتطلب الوصول المتكرر للذاكرة.

النشر بأُطر عمل تعلم الآلة الشائعة باستخدام AWS Neuron

تتكون مجموعة تطوير البرمجيات (SDK) الخاصة بـ AWS Neuron من برنامج التحويل البرمجي وبرنامج تشغيل وأدوات التنميط. وتمكّن من نشر نماذج الشبكات العصبية المعقدة التي تُنشأ وتُدرب في أُطر عمل شائعة، مثل Tensorflow وPyTorch وMXNet، وتنفيذها باستخدام مثيلات Inf1. باستخدام مسار NeuronCore، يمكنك تقسيم النماذج الكبيرة للتنفيذ عبر شرائح Inferentia المتعددة باستخدام اتصال مادي عالي السرعة من شريحة إلى شريحة، مما يوفر إنتاجية عالية للاستدلال وتكاليف استدلال أقل.

اتصال شبكي وتخزين عاليا الأداء

توفر مثيلات Inf1 ما يصل إلى 100 جيجابت في الثانية من معدل نقل الشبكة للتطبيقات التي تتطلب الوصول إلى الشبكات عالية السرعة. الجيل التالي من تقنية محول الشبكة المرنة (ENA) وتقنية NVM Express (NVMe) يوفران مثيلات Inf1 التي تتسم بمعدل نقل عالي وواجهات ذات زمن استجابة منخفض للاتصالات الشبكية ومخزن المجموعات المرن بــ Amazon (Amazon EBS).

مصمم وفق AWS Nitro System

نظام AWS Nitro هو مجموعة غنية من كتل الإنشاء التي تقوم بتفريغ العديد من الوظائف الافتراضية التقليدية في الجهاز المخصص والبرنامج المخصص لتقديم أداءٍ عالٍ والتوافر بدرجة عالية وحماية عالية بينما تعمل أيضًا على خفض النفقات الافتراضية.

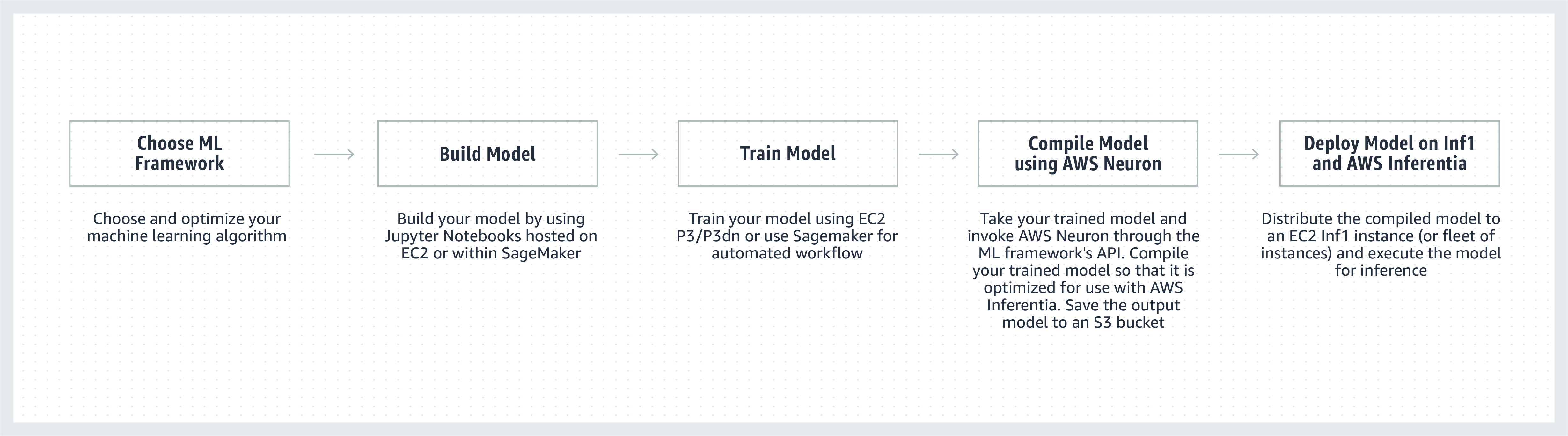

كيفية العمل

شهادات العملاء

تأسست شركة Airbnb في سان فرانسيسكو عام 2008، وهي سوق مجتمعية لأكثر من 4 ملايين مضيف استقبلوا أكثر من 900 مليون نزيل في كل دول العالم تقريبًا.

"توفر منصة دعم مجتمع Airbnb تجارب خدمية ذكية واستثنائية وقابلة للتوسع لمجتمعنا من ملايين النزلاء والمضيفين حول العالم. نحن نبحث باستمرار عن طرق لتحسين أداء نماذج البرمجة اللغوية العصبية التي تستخدمها تطبيقات chatbot الداعمة لدينا. من خلال مثيلات Amazon EC2 Inf1 التي يتم تشغيلها بواسطة AWS Inferentia، نرى تحسنًا في معدل النقل بمقدار الضعف خارج الصندوق مقارنة بالمثيلات المستندة إلى وحدة معالجة الرسومات لنماذج BERT المستندة إلى Pytorch. نتطلع إلى الاستفادة من مثيلات Inf1 للنماذج الأخرى وحالات الاستخدام في المستقبل.»

بو تسنغ، مدير قسم الهندسة، Airbnb

«نحن ندمج تعلم الآلة (ML) في العديد من جوانب Snapchat، واستكشاف الابتكار في هذا المجال هو أولوية رئيسية. وما أن سمعنا بـ Inferentia بدأنا في التعاون مع AWS لتبني مثيلات Inf1/Inferentia لتساعدنا في نشر ML بما يشمل الأداء والتكلفة. بدأنا بنماذج التوصية الخاصة بنا، ونتطلع إلى تبني المزيد من النماذج باستخدام مثيلات Inf1 في المستقبل.»

نيما خاجهنوري، نائب مدير قسم الهندسة بشركة Snap Inc.

"تعمل منصة إدارة تجربة العملاء الموحدة المدعومة بالذكاء الاصطناعي (AI) (Unified-CXM) لشركة Sprinklr على تمكين الشركات من جمع ملاحظات العملاء وترجمتها في الوقت الفعلي عبر قنوات متعددة وتحويلها إلى معارف دقيقة قابلة للتنفيذ، وهذا يؤدي إلى حلول استباقية للمشكلات وتحسين تطوير المنتجات وتحسين تسويق المحتوى وتحسين خدمة العملاء وغير ذلك الكثير. باستخدام Amazon EC2 Inf1، تمكنا من تحسين أداء أحد نماذج معالجة اللغة الطبيعية (NLP) بشكل كبير وتحسين أداء أحد نماذج رؤية الكمبيوتر الخاصة بنا. نتطلع إلى مواصلة استخدام Amazon EC2 Inf1 لتقديم خدمة أفضل لعملائنا العالميين.»

فاسانت سرينيفاسان، النائب الأول لمدير قسم هندسة المنتجات في Sprinklr

«يوفر منتج معالجة اللغة الطبيعية (NLP)، Finch for Text، للمستخدمين القدرة على استخراج وإزالة الغموض وإثراء أنواع متعددة من الكيانات بكميات ضخمة من النص. يتطلب Finch for Text موارد حوسبة كبيرة لتزويد عملائنا بعمليات إثراء بزمن استجابة منخفض في مواجز البيانات العالمية. نستخدم في الوقت الحالي مثيلات AWS Inf1 في نماذج اللغة الطبيعية PyTorch NLP، والترجمة، وتوضيح الكيانات. لقد تمكنا من تقليل تكاليف الاستدلال بأكثر من 80٪ (أكثر من وحدات معالجة الرسومات) مع الحد الأدنى من التحسينات مع الحفاظ على سرعة الاستدلال والأداء. يسمح هذا التحسين لعملائنا بإثراء النصوص التي باللغات الفرنسية والإسبانية والألمانية والهولندية في الوقت الفعلي من خلال دفق مواجز البيانات وعلى نطاق عالمي، وهو أمر بالغ الأهمية لخدماتنا المالية وأدوات تجميع البيانات وعملاء القطاع العام."

سكوت لايتنر، رئيس قسم التكنولوجيا - Finch Computing

«ننبه إلى العديد من أنواع الأحداث في جميع أنحاء العالم بعدة لغات وبتنسيقات مختلفة (الصور والفيديو والصوت ومستشعرات النص ومجموعات من كل هذه الأنواع) من مئات الآلاف من المصادر. يعد تحسين السرعة والتكلفة نظرًا لهذا الحجم أمرًا بالغ الأهمية لأعمالنا. باستخدام AWS Inferentia، قمنا بخفض زمن استجابة النموذج وحققنا معدل نقل أفضل بما يصل إلى 9 أضعاف لكل USD. وقد سمح لنا ذلك بزيادة دقة النموذج وتنمية قدرات منصتنا من خلال نشر نماذج التعليم العميق (DL) الأكثر تعقيدًا ومعالجة حجم بيانات أكبر بمقدار 5 أضعاف مع الحفاظ على تكاليفنا تحت السيطرة.»

أليكس جيمس، كبير العلماء ونائب الرئيس الأول للذكاء الاصطناعي، Dataminr

"تقوم شركة Autodesk باستخدام Inferentia في تطوير التكنولوجيا الإدراكية للمساعد الافتراضي المشغّل بالذكاء الاصطناعي (AI)، Autodesk Virtual Agent (AVA). تجيب AVA على أكثر من 100000 سؤال للعملاء شهريًا من خلال تطبيق تقنيات فهم اللغة الطبيعية (NLU) والتعلم العميق (DL) لاستخراج السياق والنية والمعنى وراء الاستفسارات. وبتجربة Inferentia، استطعنا الحصول على معدل نقل أعلى بمقدار 4.9 مرات من G4dn لنماذج NLU الخاصة بنا، ونتطلع لتشغيل المزيد من أعباء العمل على مثيلات Inf1 القائمة على Inferentia."

بينغوي أويانغ، الأب. عالم بيانات، Autodesk

خدمات Amazon تستخدم مثيلات Amazon EC2 Inf1

تساعد Amazon Advertising الأعمال التجارية من جميع الأحجام على التواصل مع العملاء في كل مرحلة من مراحل رحلة التسوق الخاصة بهم. تخضع ملايين الإعلانات، بما فيها من نصوص وصور للمراجعة والتصنيف، ومن ثم يتم تقديمها لمنح العملاء تجربة مثالية كل يوم.

"فيما يتعلق بمعالجة الإعلانات النصية لدينا، ننشر نماذج BERT القائمة على PyTorch عالميًا على مثيلات Inf1 القائمة على AWS Inferentia. بانتقالنا من وحدات معالجة الرسومات (GPU) إلى Inferentia، تمكَّنا من خفض التكاليف بنسبة 69% بأداء قابل للمقارنة. استغرق تجميع نماذجنا واختبارها لـ AWS Inferentia أقل من ثلاثة أسابيع. أكَّد استخدام Amazon SageMaker لنشر نماذجنا إلى مثيلات Inf1 أن نشرنا قابل للتوسع وسهل الإدارة. عندما قمت بتحليل النماذج المجمعة لأول مرة، كان الأداء مع AWS Inferentia مثيرًا للإعجاب لدرجة أنني لجأت بالفعل إلى إعادة تشغيل المقاييس للتأكد من صحتها! من الآن فصاعدًا، نخطط لترحيل نماذج معالجة الإعلانات المصورة إلى Inferentia. لقد قمنا بالفعل بقياس زمن استجابة أقل بنسبة 30٪ ووفورات في التكاليف بنسبة 71٪ مقارنة بالمثيلات المماثلة القائمة على وحدة معالجة الرسومات لهذه النماذج.»

ياشال كانونجو، عالم تطبيقي، Amazon Advertising

اقرأ مدونة الأخبار»

«إن الذكاء المستند إلى الذكاء الاصطناعي (AI) وتعلم الآلة (ML) من Amazon Alexa، المدعوم من Amazon Web Services، متاح على أكثر من 100 مليون جهاز اليوم، ونعد العملاء بأن تبقى Alexa دائمًا أكثر ذكاءً، وأكثر قدرة على إجراء المحادثات، وأكثر استباقية، وأكثر بهجةً. يتطلب الوفاء بهذا الوعد تحسينات مستمرة في أوقات الاستجابة وتكاليف البنية التحتية لتعلم الآلة، ولهذا السبب نحن متحمسون لاستخدام Amazon EC2 Inf1 لخفض زمن الاستجابة الخاص بالاستدلال وخفض التكلفة لكل الاستدلال على خدمة Alexa text-to-speech. مع Amazon EC2 Inf1، سنتمكن من تحسين الخدمة لعشرات الملايين من العملاء الذين يستخدمون Alexa كل شهر.»

توم تايلور، النائب الأول للرئيس في Amazon Alexa

«إننا نواصل الابتكار لتحسين تجربة عملائنا وتقليل تكاليف البنية التحتية لدينا. إن نقل أعباء العمل الخاصة بالإجابة على الأسئلة المستندة إلى الويب (WBQA) من مثيلات P3 المستندة إلى وحدة معالجة الرسومات إلى مثيلات Inf1 المستندة إلى AWS Inferentia لم يساعد في خفض تكاليف الاستدلال بنسبة 60% وحسب، بل أدى أيضًا إلى تحسين زمن الانتقال الشامل بأكثر من 40% وهذا يساعد في تحسين تجربة الأسئلة والأجوبة الخاصة بالعميل مع Alexa. إن استخدام Amazon SageMaker للنموذج القائم على Tensorflow أدى إلى تبسيط عملية التبديل إلى مثيلات Inf1 وتيسير إدارتها. إننا الآن نستخدم مثيلات Inf1 عالميًا لتشغيل أعباء عمل WBQA هذه وتحسين أدائها لـ AWS Inferentia لتقليل التكلفة وتقليل زمن الانتقال بشكل أكبر.»

إريك ليند، مهندس تطوير برمجيات في Alexa AI

"يستخدم Amazon Prime Video نماذج التعلم الآلي المتعلقة برؤية الكمبيوتر لتحليل جودة الفيديو للأحداث المباشرة لضمان تجربة مثلى للمشاهد بالنسبة لأعضاء Prime Video. لقد نشرنا نماذج تعلم آلي تختص بتصنيف الصور على مثيلات EC2 Inf1 وشهدنا تحسنًا في الأداء بمقدار 4 أضعاف ووفورات في التكلفة تصل إلى 40%. إننا نتطلع الآن إلى الاستفادة من هذه الوفورات لابتكار وإنشاء نماذج متقدمة يمكنها اكتشاف العيوب الأكثر تعقيدًا مثل فجوات المزامنة بين ملفات الصوت والفيديو لتقديم المزيد من التحسينات في تجربة المشاهدة لأعضاء Prime Video.»

فيكتور أنطونيو، مهندس حلول، Amazon Prime Video

«Amazon Rekognition هو تطبيق بسيط وسهل لتحليل الصور ومقاطع الفيديو يساعد العميل في التعرّف على العناصر والأشخاص والنصوص والأنشطة. ويحتاج Amazon Rekognition إلى بنية تعلم عميق عالية الأداء يمكن من خلالها تحليل مليارات الصور ومقاطع الفيديو يوميًا لعملائنا. باستخدام مثيلات Inf1 المستندة إلى AWS Inferentia، أدى تشغيل نماذج Amazon Rekognition مثل تصنيف الكائنات إلى تقليل زمن الوصول بمقدار 8 مرات وزيادة الإنتاجية بمقدار الضعف مقارنة بتشغيل هذه النماذج على وحدات معالجة الرسومات. وبناءً على هذه النتائج، سوف ننقل Rekognition إلى Inf1، مما يمكّن عملاءنا من الحصول على نتائج دقيقة على نحو أسرع.»

راجنيش سينغ، مدير هندسة البرمجيات، Rekognition and Video

التسعير

*الأسعار المعروضة في منطقة AWS في شرق الولايات المتحدة (شمال فرجينيا). أسعار المثيلات المحجوزة لمدة عام و3 أعوام هي لخيارات الدفع "مقدمًا جزئيًا" أو "بدون مقدم" للحالات التي لا تحتوي على خيار مقدم جزئي.

تتوفر مثيلات Amazon EC2 Inf1 في شرق الولايات المتحدة (شمال فرجينيا) أو مناطق AWS في غرب الولايات المتحدة (أوريغون) كمثيلات حسب الطلب أو محجوزة أو فورية.

بدء الاستخدام

استخدام Amazon SageMaker

تُسهِّل SageMaker تجميع نموذج تعلم الآلة (ML) المدرب وتُسهِّل نشره في الإنتاج على مثيلات Amazon Inf1 بحيث يمكنك البدء في إنشاء تنبؤات في الوقت الفعلي بزمن استجابة منخفض. يندمج AWS Neuron، المحول البرمجي لـ AWS Inferentia، مع Amazon SageMaker Neo لتمكينك من التحويل البرمجي لنماذج تعلم الآلة المدربة لديك لتعمل بشكل محسّن على مثيلات Inf1. باستخدام SageMaker يمكنك أن تختار بسهولة تشغيل نماذجك على مجموعات توسيع تلقائي لمثيلات Inf1 والتي تنتشر عبر العديد من مناطق التوافر لتوفير استدلال يتميز بكل من الأداء العالي والتوافر العالي. تعرَّف على طريقة النشر إلى Inf1 باستخدام SageMaker من خلال أمثلة على Github.

استخدام DLAMI

توفر DLAMI لممارسي تعلم الآلة والباحثين البنية التحتية والأدوات لتسريع التعلم العميق في السحابة، على أي نطاق. تأتي مجموعة تطوير البرمجيات (SDK) الخاصة بـ AWS Neuron مثبتة مسبقًا في DLAMI لتجميع نماذج تعلم الآلة (ML) وتشغيلها على النحو الأمثل على مثيلات Inf1. للمساعدة في إرشادك عبر عملية بدء الاستخدام، تفضل بزيارةدليل اختبار AMI والمزيد من موارد التعلم العميق. يُرجى الرجوع إلى دليل بدء استخدام AWS DLAMI للتعرّف على كيفية استخدام DLAMI مع Neuron.

استخدام حاويات التعلم العميق

يمكن للمطورين الآن نشر مثيلات Inf1 في Amazon EKS، وهي خدمة Kubernetes مُدارة بالكامل، وكذلك في Amazon ECS، وهي خدمة تنسيق حاويات مُدارة بالكامل من Amazon. تعرَّف على المزيد حول بدء استخدام Inf1 على Amazon EKS أو مع Amazon ECS. يتوفر المزيد من التفاصيل حول تشغيل الحاويات في مثيلات Inf1 في صفحة البرنامج التعليمي لأدوات حاوية Neuron. تتوفر خدمة Neuron أيضًا بتثبيت مسبق في حاويات التعلم العميق من AWS.

المدونات والمقالات

كيف خفضت Amazon Search تكاليف استدلال تعلم الآلة بنسبة 85% باستخدام AWS Inferentia

بقلم جواو مورا، وجايسون كارلسون، وجاسبريت سينغ، وشواهو تشي، وشروتي كوباركار، وهاوي سون، وويقي تشانج، وجوقي تشانج بتاريخ 22 / 9 / 2022

تعمل البنية الأساسية لتعلم الآلة عالية الأداء ومنخفضة التكلفة على تسريع الابتكار في السحابة

من إعداد MIT Technology Review Insights، بتاريخ 1 / 11 / 2021

اختيار أفضل مسرع ذكاء اصطناعي وتجميع النماذج لاستدلال رؤية الكمبيوتر باستخدام Amazon SageMaker

بقلم دافيد جاليتيلي وحسن بوناوالا، بتاريخ 19 / 10 / 2021

التعلم الآلي في السحابة يساعد الشركات على الابتكار

من إعداد MIT Technology Review Insights، بتاريخ 15 / 10 / 2021

تقديم 3000 نموذج تعلم عميق على Amazon EKS مع AWS Inferentia مقابل أقل من 50 USD في الساعة

بقلم أليكس إنكولسكي، وجوشوا كوريي، وماهاديفان بالاسوبرامانيام، وسوندار رانجاناثا، بتاريخ 30 / 9 / 2021

بقلم فابيو نوناتو دي باولا وماهاديفان بالاسوبرامانيام، بتاريخ 4/5/2021

بقلم بينغوي أويانغ، بتاريخ 7 / 4 / 2021

معظم أعباء عمل Alexa مشغلة الآن على مثيلات Amazon EC2 Inf1 الأسرع والأكثر فعالية من حيث التكلفة

بقلم سيباستيان ستورماك، بتاريخ 12/11/2020

بقلم جولين سيمون، بتاريخ 22/4/2020

Amazon ECS تدعم الآن مثيلات EC2 Inf1

بقلم جولين سيمون، بتاريخ 14 / 8 / 2020

نشر TensorFlow OpenPose على مثيلات Inf1 المستندة إلى AWS Inferentia لتحسين أداء السعر بشكل كبير

بقلم فابيو نوناتو دي باولا وهايشن لي، بتاريخ 07/22/2020

Amazon EKS تدعم مثيلات Inf1 من EC2

بقلم جولين سيمون، بتاريخ 15/6/2020

بقلم چيف بار، بتاريخ 3/12/2019