Instans Inf1 Amazon EC2

Bisnis di berbagai industri mencari transformasi yang didukung kecerdasan buatan (AI) untuk mendorong inovasi bisnis dan meningkatkan pengalaman pelanggan serta peningkatan proses. Model machine learning (ML) yang mendukung aplikasi AI menjadi makin kompleks, sehingga biaya infrastruktur komputasi dasar juga meningkat. Hingga 90% pengeluaran infrastruktur untuk mengembangkan dan menjalankan aplikasi ML sering kali dialokasikan pada inferensi. Pelanggan mencari solusi infrastruktur yang hemat biaya untuk melakukan deployment aplikasi ML mereka dalam produksi.

Instans Inf1 Amazon EC2 menghasilkan inferensi ML dengan performa tinggi dan biaya rendah. Instans ini menghasilkan throughput yang lebih tinggi hingga 2,3x lipat dan biaya per inferensi yang lebih rendah hingga 70% dibandingkan instans Amazon EC2 yang setara. Instans Inf1 dibangun dari awal untuk mendukung aplikasi inferensi ML. Instans ini menghadirkan hingga 16 chip AWS Inferentia, chip inferensi ML berperforma tinggi yang didesain dan dibuat oleh AWS. Selain itu, instans Inf1 menyertakan prosesor Intel Xeon Scalable Generasi Ke-2 dan jaringan hingga 100 Gbps untuk menghasilkan inferensi throughput yang tinggi.

Pelanggan dapat menggunakan instans Inf1 untuk menjalankan aplikasi inferensi ML skala besar seperti pencarian, mesin rekomendasi, penglihatan komputer, pengenalan ucapan, pemrosesan bahasa alami (NLP), personalisasi, dan deteksi kecurangan.

Developer dapat melakukan deployment model ML pada instans Inf1 menggunakan AWS Neuron SDK, yang terintegrasi dengan kerangka kerja ML populer seperti TensorFlow, PyTorch, dan Apache MXNet. Mereka dapat terus menggunakan alur kerja ML yang sama dan memigrasikan aplikasi ke instans Inf1 secara lancar dengan perubahan kode minimal serta tanpa terikat dengan solusi khusus vendor.

Mulai instans Inf1 secara mudah menggunakan Amazon SageMaker, AWS Deep Learning AMI (DLAMI) yang telah dikonfigurasikan sebelumnya dengan Neuron SDK, atau Amazon Elastic Container Service (Amazon ECS) atau Amazon Elastic Kubernetes Service (Amazon EKS) untuk aplikasi ML terkontainer.

Manfaat

Biaya per inferensi yang lebih rendah hingga 70%

Dengan Inf1, developer dapat mengurangi biaya deployment produksi ML mereka secara signifikan. Kombinasi biaya instans yang rendah dan throughput tinggi dari instans Inf1 menghasilkan biaya per inferensi yang lebih rendah hingga 70% dibandingkan instans Amazon EC2 yang setara.

Kemudahan penggunaan dan portabilitas kode

Neuron SDK terintegrasi dengan kerangka kerja ML umum seperti TensorFlow, PyTorch, dan MXNet. Developer dapat terus menggunakan alur kerja ML yang sama dan memigrasikan aplikasi mereka ke instans Inf1 secara lancar dengan perubahan kode minimal. Hal ini memberi mereka kebebasan untuk menggunakan kerangka kerja ML pilihan, platform komputasi yang paling memenuhi persyaratan, dan teknologi terbaru tanpa terikat dengan solusi khusus vendor.

Throughput yang lebih tinggi hingga 2,3x

Instans Inf1 menghasilkan throughput yang lebih tinggi hingga 2,3x dibandingkan instans Amazon EC2 yang setara. Chip AWS Inferentia yang mendukung instans Inf1 dioptimalkan untuk performa inferensi pada ukuran batch kecil, sehingga memungkinkan aplikasi waktu nyata memaksimalkan throughput dan memenuhi persyaratan latensi.

Latensi yang luar biasa rendah

Chip AWS Inferentia dilengkapi dengan memori dalam chip ukuran besar yang memungkinkan cache model ML secara langsung di chip tersebut. Anda dapat melakukan deployment model menggunakan kemampuan seperti NeuronCore Pipeline yang menghilangkan kebutuhan untuk mengakses sumber daya yang ada di luar memori. Dengan Instans Inf1, Anda dapat melakukan deployment aplikasi inferensi waktu nyata pada latensi hampir secara waktu nyata tanpa memengaruhi bandwidth.

Dukungan untuk berbagai model dan tipe data ML

Instans Inf1 mendukung berbagai arsitektur model ML yang umum digunakan seperti SSD, VGG, dan ResNext untuk pengenalan/klasifikasi gambar serta Transformer dan BERT untuk NLP. Selain itu, dukungan untuk repositori model HuggingFace di Neuron memberi pelanggan kemampuan untuk dengan mudah mengompilasi dan menjalankan inferensi menggunakan model yang dilatih sebelumnya atau model yang disetel hanya dengan mengubah satu baris kode. Beberapa tipe data termasuk BF16 dan FP16 dengan presisi campuran juga didukung untuk berbagai model serta kebutuhan performa.

Fitur

Didukung oleh AWS Inferentia

AWS Inferentia adalah chip ML yang dibuat oleh AWS untuk memberikan inferensi performa tinggi dengan biaya rendah. Setiap chip AWS Inferentia memiliki empat NeuronCore generasi pertama dan memberikan performa hingga 128 tera operasi per detik (TOPS), serta mendukung tipe data FP16, BF16, dan INT8. Chip AWS Inferentia juga memiliki sejumlah besar memori pada chip yang dapat digunakan untuk membuat cache model besar, yang khususnya bermanfaat bagi model yang sering memerlukan akses memori.

Deploy dengan kerangka kerja ML populer menggunakan AWS Neuron

AWS Neuron SDK terdiri dari compiler, driver runtime, dan alat pembuatan profil. Hal ini memungkinkan deployment model jaringan neural kompleks, yang dibuat dan dilatih di kerangka kerja populer seperti TensorFlow, PyTorch, serta MXNet, yang akan dijalankan menggunakan instans Inf1. Dengan NeuronCore Pipeline, Anda dapat memecah model besar untuk dijalankan di beberapa chip Inferentia menggunakan interkoneksi chip ke chip fisik berkecepatan tinggi, sehingga memberikan throughput inferensi yang tinggi dan biaya inferensi yang lebih rendah.

Jaringan dan penyimpanan performa tinggi

Instans Inf1 menawarkan throughput jaringan hingga 100 Gbps untuk aplikasi yang memerlukan akses ke jaringan berkecepatan tinggi. Teknologi Adaptor Jaringan Elastis (ENA) dan NVM Express (NVMe) generasi berikutnya menyediakan instans Inf1 dengan antarmuka throughput tinggi dan latensi rendah untuk jaringan serta Amazon Elastic Block Store (Amazon EBS).

Dibangun di AWS Nitro System

AWS Nitro System adalah kumpulan komponen dasar yang melepaskan beban berbagai fungsi virtualisasi konvensional ke perangkat keras dan perangkat lunak khusus untuk memberikan performa tinggi, ketersediaan tinggi, dan keamanan tinggi sekaligus juga mengurangi biaya overhead virtualisasi.

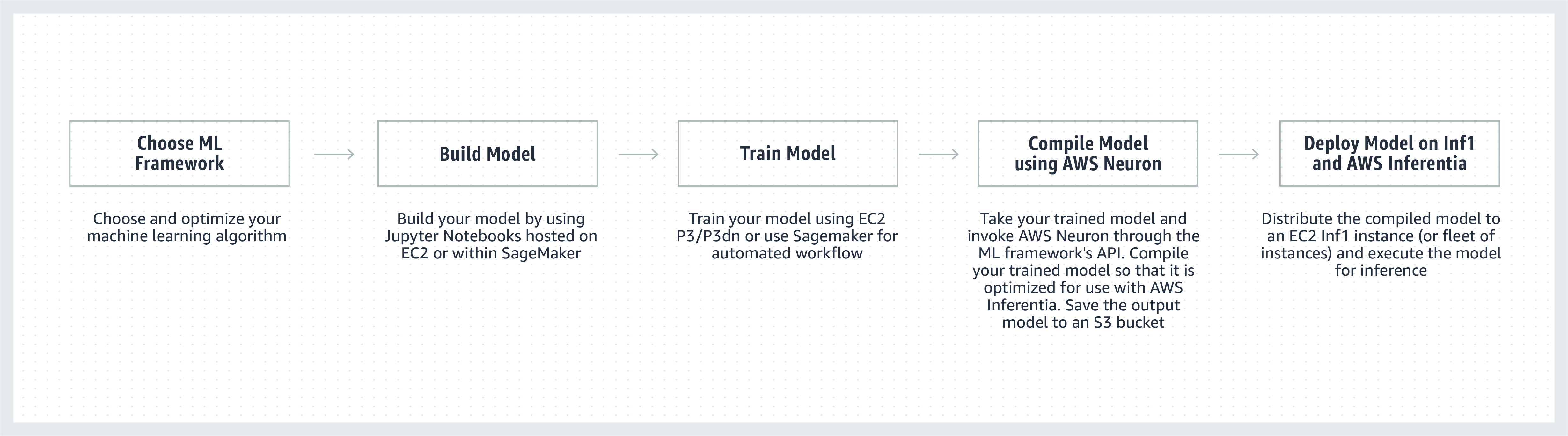

Cara kerjanya

Testimoni pelanggan

“Kami menggabungkan ML ke dalam banyak aspek Snapchat, dan eksplorasi inovasi di bidang ini merupakan prioritas utama. Setelah mendengar tentang Inferentia, kami mulai berkolaborasi dengan AWS untuk mengadopsi instans Inf1/Inferentia untuk membantu dalam deployment ML, termasuk dalam hal performa dan biaya. Kami memulai dengan model rekomendasi dan ingin mengadopsi lebih banyak model dengan instans Inf1 di masa mendatang.”

Nima Khajehnouri, VP Engineering, Snap Inc.

“Platform unified customer experience management (Unified-CXM) yang didorong AI milik Sprinklr memungkinkan perusahaan mengumpulkan dan menerjemahkan umpan balik pelanggan waktu nyata di berbagai saluran menjadi wawasan yang dapat ditindaklanjuti—yang kemudian menghasilkan resolusi masalah yang proaktif, pengembangan produk yang ditingkatkan, pemasaran konten yang lebih baik, layanan pelanggan yang lebih baik, dan lebih banyak lagi. Dengan Inf1 Amazon EC2, kami dapat meningkatkan performa salah satu model NLP secara signifikan dan meningkatkan performa salah satu model penglihatan komputer kami. Kami ingin terus menggunakan Inf1 Amazon EC2 untuk melayani pelanggan global dengan lebih baik.”

Vasant Srinivasan, Senior Vice President of Product Engineering, Sprinklr

“Produk NLP kami yang canggih, Finch for Text, menawarkan kemampuan untuk mengekstraksi, membedakan, dan memperkaya berbagai tipe entitas dalam volume teks yang besar kepada pengguna. Finch for Text memerlukan sumber daya komputasi yang signifikan untuk menyediakan pengayaan latensi rendah pada umpan data global kepada klien kami. Kami saat ini menggunakan instans Inf1 AWS dalam model NLP PyTorch, penerjemahan, dan disambiguasi entitas. Kami dapat mengurangi biaya inferensi hingga lebih dari 80% (dibandingkan GPU) dengan optimisasi minimal sekaligus mempertahankan kecepatan dan performa inferensi. Peningkatan ini memungkinkan pelanggan kami untuk memperkaya teks bahasa Prancis, Spanyol, Jerman, dan Belanda mereka secara waktu nyata pada umpan data streaming serta dalam skala global—sesuatu yang penting bagi layanan keuangan, agregator data, dan pelanggan sektor publik kami.”

Scott Lightner, Chief Technology Officer, Finch Computing

“Kami menangkap berbagai jenis peristiwa di seluruh dunia dalam banyak bahasa, dalam berbagai format (gambar, video, audio, sensor teks, kombinasi dari semuanya) dari ratusan ribu sumber. Mengoptimalkan kecepatan dan biaya dengan skala sebesar itu merupakan hal yang krusial bagi bisnis kami. Dengan AWS Inferentia, kami telah menurunkan latensi model dan mencapai throughput hingga 9x lebih baik per dolar. Hal tersebut membuat kami dapat meningkatkan akurasi model dan mengembangkan kemampuan platform kami dengan melakukan deployment model DL yang lebih canggih serta memproses volume data 5x lebih banyak sekaligus menjaga biaya kami tetap terkendali.”

Alex Jaimes, Chief Scientist dan Senior Vice President of AI, Dataminr

“Autodesk memajukan teknologi kognitif asisten virtual yang didukung AI milik kami, Autodesk Virtual Agent (AVA), menggunakan Inferentia. AVA menjawab lebih dari 100.000 pertanyaan pelanggan per bulan dengan menerapkan teknik pemahaman bahasa alami (NLU) dan deep learning (DL) untuk mengekstraksi konteks, tujuan, serta makna di balik pertanyaan. Saat mencoba Inferentia, kami mampu meraih throughput 4,9x lebih tinggi daripada G4dn untuk model NLU, dan kami berharap dapat menjalankan lebih banyak beban kerja pada instans Inf1 berbasis Inferentia.”

Binghui Ouyang, Sr. Data Scientist, Autodesk

Layanan Amazon menggunakan Instans Inf1 Amazon EC2

Amazon Advertising membantu bisnis dari semua ukuran terhubung dengan pelanggan di setiap tahap perjalanan belanja mereka. Jutaan iklan, termasuk teks dan citra, dimoderasi, diklasifikasikan, dan ditayangkan untuk pengalaman pelanggan yang optimal setiap hari.

“Untuk pemrosesan iklan teks, kami men-deploy model BERT berbasis PyTorch secara global pada instans Inf1 berbasis AWS Inferentia. Dengan pindah ke Inferentia dari GPU, kami dapat menurunkan biaya sebesar 69% dengan performa yang sebanding. Mengompilasi dan menguji model kami untuk AWS Inferentia membutuhkan waktu kurang dari tiga minggu. Dengan menggunakan Amazon SageMaker untuk men-deploy model kami ke instans Inf1 memastikan deployment kami dapat diskalakan dan mudah dikelola. Ketika saya pertama kali menganalisis model yang dikompilasi, performa dengan AWS Inferentia sangatlah mengesankan sampai-sampai saya harus menjalankan kembali tolok ukur untuk memastikan bahwa tidak ada kesalahan. Ke depannya, kami berencana untuk memigrasikan model pemrosesan iklan citra kami ke Inferentia. Kami mendapati bahwa tolok ukur menunjukkan latensi 30% lebih rendah dan penghematan biaya 71% daripada instans berbasis GPU yang sebanding untuk model ini.”

Yashal Kanungo, Applied Scientist, Amazon Advertising

Baca blog berita »

“Kecerdasan berbasis AI dan ML Amazon Alexa, yang didukung oleh AWS, saat ini tersedia di lebih dari 100 juta perangkat—dan kami berjanji untuk memastikan bahwa Alexa akan terus berkembang menjadi layanan yang lebih cerdas, lebih komunikatif, lebih proaktif, serta lebih menyenangkan. Untuk memenuhi janji itu, perlu penyempurnaan berkelanjutan dalam hal waktu respons dan biaya infrastruktur ML. Karena itulah kami sangat senang menggunakan Inf1 Amazon EC2 untuk menurunkan latensi inferensi dan biaya per inferensi pada teks-ke-ucapan Alexa. Dengan Inf1 Amazon EC2, kami akan mampu membuat layanan menjadi lebih baik bagi puluhan juta pelanggan yang menggunakan Alexa setiap bulannya.”

Tom Taylor, Senior Vice President, Amazon Alexa

“Kami terus berinovasi untuk lebih meningkatkan pengalaman pelanggan dan untuk menekan biaya infrastruktur. Memindahkan beban kerja penjawab pertanyaan (WBQA) berbasis web kami dari instans P3 berbasis GPU ke instans Inf1 berbasis AWS Inferentia tidak hanya membantu kami mengurangi biaya inferensi sebesar 60%, tetapi juga meningkatkan latensi ujung ke ujung sebesar lebih dari 40%, yang membantu meningkatkan pengalaman Tanya Jawab pelanggan dengan Alexa. Penggunaan Amazon SageMaker untuk model berbasis TensorFlow kami membuat proses peralihan ke instans Inf1 menjadi lebih praktis dan mudah dikelola. Kami kini menggunakan instans Inf1 secara global untuk menjalankan beban kerja WBQA ini dan mengoptimalkan performanya untuk AWS Inferentia guna menekan biaya dan mengurangi latensi secara maksimal.”

Eric Lind, Software Development Engineer, Alexa AI

“Amazon Prime Video menggunakan model ML penglihatan komputer untuk menganalisis kualitas video peristiwa langsung guna memastikan pengalaman penonton yang optimal bagi anggota Prime Video. Kami melakukan deployment model ML klasifikasi gambar di instans Inf1 EC2 dan memperoleh 4x peningkatan dalam hal performa serta penghematan biaya hingga 40%. Kami kini ingin memanfaatkan penghematan biaya ini untuk berinovasi dan membangun model lanjutan yang dapat mendeteksi kecacatan yang lebih kompleks, seperti kesenjangan sinkronisasi antara file audio dan video, untuk menghadirkan pengalaman menonton yang lebih baik bagi anggota Prime Video.”

Victor Antonino, Solutions Architect, Amazon Prime Video

“Amazon Rekognition adalah aplikasi analisis gambar dan video yang sederhana serta mudah, yang membantu pelanggan mengidentifikasi objek, manusia, teks, dan aktivitas. Amazon Rekognition memerlukan infrastruktur DL performa tinggi yang dapat menganalisis miliaran gambar dan video setiap harinya untuk pelanggan kami. Dengan instans Inf1 berbasis AWS Inferentia, pengoperasian model Amazon Rekognition, seperti klasifikasi objek, menghasilkan latensi 8x lebih rendah dan throughput 2x lipat jika dibandingkan dengan menjalankan model ini pada GPU. Berdasarkan hasil ini, kami memindahkan Amazon Rekognition ke Inf1 agar pelanggan kami dapat memperoleh hasil yang akurat dengan lebih cepat.”

Rajneesh Singh, Director, SW Engineering, Amazon Rekognition and Video

Harga

* Harga yang ditunjukkan adalah untuk Wilayah AWS US East (Northern Virginia). Harga untuk instans cadangan 1 tahun dan 3 tahun adalah untuk opsi pembayaran "Sebagian di Muka" atau "Tanpa Biaya di Muka" untuk instans tanpa opsi Sebagian di Muka.

Instans Inf1 Amazon EC2 tersedia di Wilayah AWS AS Timur (Virginia U.), AS Barat (Oregon) sebagai Instans Sesuai Permintaan, Terpesan, atau Spot.

Memulai

Menggunakan Amazon SageMaker

SageMaker memudahkan kompilasi dan deployment model ML yang Anda latih dalam produksi pada instans Inf1 Amazon sehingga Anda dapat mulai membuat prediksi secara waktu nyata dengan latensi rendah. AWS Neuron, compiler untuk AWS Inferentia, terintegrasi dengan Amazon SageMaker Neo, sehingga Anda dapat mengompilasi model ML terlatih untuk berjalan secara optimal pada instans Inf1. Dengan SageMaker, Anda dapat menjalankan model dengan mudah di klaster penskalaan otomatis instans Inf1 yang tersebar di beberapa Zona Ketersediaan untuk menghasilkan performa tinggi dan inferensi waktu nyata dengan ketersediaan tinggi. Pelajari cara melakukan deployment ke Inf1 menggunakan SageMaker dengan contoh di GitHub.

Menggunakan DLAMI

DLAMI menyediakan infrastruktur dan alat bagi praktisi serta peneliti ML untuk mempercepat DL di cloud pada semua skala. AWS Neuron SDK sudah diinstal sebelumnya di DLAMI untuk mengompilasi dan menjalankan model ML Anda secara optimal pada instans Inf1. Untuk membantu Anda melalui proses memulai, kunjungi panduan pemilihan AMI dan sumber daya DL lainnya. Lihat panduan Memulai AWS DLAMI untuk mempelajari cara menggunakan DLAMI dengan Neuron.

Menggunakan Kontainer Deep Learning

Developer saat ini dapat melakukan deployment instans Inf1 di Amazon EKS, yang merupakan layanan Kubernetes terkelola penuh, dan di Amazon ECS, yang merupakan layanan orkestrasi kontainer terkelola penuh dari Amazon. Pelajari selengkapnya tentang memulai dengan Inf1 di Amazon EKS atau dengan Amazon ECS. Detail selengkapnya tentang menjalankan kontainer di instans Inf1 tersedia di halaman tutorial alat kontainer Neuron. Neuron juga tersedia pra-instal di Kontainer AWS Deep Learning.

Blog dan artikel

Cara Amazon Search mengurangi biaya inferensi ML hingga 85% dengan AWS Inferentia

oleh Joao Moura, Jason Carlson, Jaspreet Singh, Shaohui Xi, Shruti Koparkar, Haowei Sun, Weiqi Zhang, dan Zhuoqi Zhangs, 9/22/2022

Infrastruktur machine learning dengan performa tinggi dan biaya rendah mempercepat inovasi di cloud

berdasarkan Wawasan Peninjauan Teknologi MIT, 01/11/2021

oleh Davide Galliteli dan Hasan Poonawala, 19/10/2021

Machine learning di cloud bisnis untuk berinovasi

berdasarkan Wawasan Peninjauan Teknologi MIT, 15/10/2021

oleh Alex Iankoulski, Joshua Correa, Mahadevan Balasubramaniam, dan Sundar Ranganatha, 30/09/2021

oleh Fabio Nonato de Paula dan Mahadevan Balasubramaniam, 04/05/2021

oleh Binghui Ouyang, 07/04/2021

oleh Sébastien Stormacq, 12/11/2020

Amazon ECS kini mendukung instans Inf1 EC2

oleh Julien Simon, 14/08/2020

Oleh Fabio Nonato De Paula dan Haichen Li, 07/22/2020

Amazon EKS kini mendukung instans Inf1 EC2

oleh Julien Simon, 15/06/2020

oleh Jeff Barr, 03/12/2019