RLHF คืออะไร

การเรียนรู้แบบเสริมแรงจากข้อเสนอแนะของมนุษย์ (RLHF) เป็นเทคนิคการเรียนรู้ของแมชชีนเลิร์นนิง (ML) ที่ใช้ข้อเสนอแนะของมนุษย์เพื่อเพิ่มประสิทธิภาพโมเดล ML เพื่อให้เรียนรู้ด้วยตนเองได้อย่างมีประสิทธิภาพมากขึ้น เทคนิคการเรียนรู้แบบเสริมแรง (RL) จะฝึกซอฟต์แวร์ในการตัดสินใจที่ได้ Reward สูงสุดและได้ผลลัพธ์ที่แม่นยำยิ่งขึ้น RLHF รวบรวมข้อเสนอแนะของมนุษย์เข้ากับฟังก์ชัน Reward ดังนั้นโมเดล ML จึงสามารถทำงานที่สอดคล้องกับเป้าหมาย ความต้องการ และความต้องการของมนุษย์ได้มากขึ้น RLHF ถูกใช้ในแอปพลิเคชัน AI ช่วยสร้าง (generative AI) รวมถึงในโมเดลภาษาขนาดใหญ่ (LLM)

ทำไม RLHF ถึงมีความสำคัญ

การประยุกต์ใช้ปัญญาประดิษฐ์ (AI) มีหลากหลายตั้งแต่รถยนต์ที่ขับเคลื่อนด้วยตนเองไปจนถึงการประมวลผลภาษาธรรมชาติ (NLP) เครื่องทำนายตลาดหุ้น และบริการร้านค้าปลีกที่ได้รับการปรับแต่ง ไม่ว่าจะเป็นการประยุกต์ใช้ใดก็ตาม เป้าหมายของ AI ในท้ายที่สุดคือการเลียนแบบการตอบสนอง พฤติกรรม และการตัดสินใจของมนุษย์ โมเดล ML จะต้องเข้ารหัสอินพุตของมนุษย์เป็นข้อมูลการฝึก เพื่อให้ AI เลียนแบบมนุษย์ได้ใกล้เคียงยิ่งขึ้นเมื่อทำงานที่ซับซ้อนเสร็จสิ้น

RLHF เป็นเทคนิคเฉพาะที่ใช้ในการฝึกระบบ AI ให้ดูเหมือนมนุษย์มากขึ้น ควบคู่ไปกับเทคนิคอื่นๆ เช่น การเรียนรู้แบบมีผู้สอนและแบบไม่มีผู้ดูแล ประการแรก การตอบสนองของโมเดลจะถูกเปรียบเทียบกับการตอบสนองของมนุษย์ จากนั้นมนุษย์จะประเมินคุณภาพของการตอบสนองที่แตกต่างจากเครื่อง โดยให้คะแนนว่าการตอบสนองใดฟังดูเป็นมนุษย์มากกว่า คะแนนอาจขึ้นอยู่กับคุณสมบัติโดยกำเนิดของมนุษย์ เช่น ความเป็นมิตร ระดับบริบทที่เหมาะสม และอารมณ์

RLHF โดดเด่นในด้านความเข้าใจภาษาธรรมชาติ แต่ยังใช้กับการประยุกต์ใช้ AI ช่วยสร้างอื่นๆ อีกด้วย

อ่านข้อมูลเกี่ยวกับปัญญาประดิษฐ์

อ่านเกี่ยวกับการประมวลผลภาษาธรรมชาติ

อ่านข้อมูลเกี่ยวกับการเรียนรู้แบบมีผู้ดูแลแตกต่างกับแบบไม่มีผู้ดูแลอย่างไร

เพิ่มประสิทธิภาพ AI

RLHF ช่วยให้โมเดล ML มีความแม่นยำยิ่งขึ้น คุณสามารถฝึกโมเดลที่สามารถฝึกกับข้อมูลของมนุษย์ที่สร้างไว้ล่วงหน้าได้ แต่การมีลูปป้อนกลับของมนุษย์เพิ่มเติมจะช่วยเพิ่มประสิทธิภาพของโมเดลได้อย่างมากเมื่อเทียบกับสถานะเริ่มต้น

ตัวอย่างเช่น เมื่อข้อความถูกแปลจากภาษาหนึ่งเป็นอีกภาษาหนึ่ง โมเดลอาจสร้างข้อความที่มีความถูกต้องทางเทคนิคแต่ฟังดูไม่เป็นธรรมชาติสำหรับผู้อ่าน นักแปลมืออาชีพสามารถทำการแปลได้ก่อน โดยให้คะแนนการแปลที่สร้างโดยเครื่องเทียบกับการแปลนั้น จากนั้นจึงให้คะแนนคุณภาพการแปลที่สร้างโดยคอมพิวเตอร์ชุดหนึ่ง การเพิ่มการฝึกเพิ่มเติมให้กับโมเดลนี้ทำให้สามารถผลิตคำแปลที่ฟังดูเป็นธรรมชาติได้ดีขึ้น

แนะนำพารามิเตอร์การฝึกที่ซับซ้อน

ในบางกรณีใน AI ช่วยสร้าง การฝึกโมเดลสำหรับพารามิเตอร์บางตัวอย่างแม่นยำอาจเป็นเรื่องยาก ตัวอย่างเช่น คุณจะกำหนดอารมณ์ของเพลงได้อย่างไร อาจมีพารามิเตอร์ทางเทคนิค เช่น คีย์และจังหวะที่บ่งบอกถึงอารมณ์บางอย่าง แต่จิตวิญญาณของผลงานดนตรีนั้นขึ้นอยู่กับอัตวิสัยมากกว่าและมีการนิยามได้ชัดเจนน้อยกว่าการใช้เพียงชุดของเทคนิค แต่คุณสามารถให้คำแนะนำของมนุษย์โดยที่ผู้แต่งสร้างผลงานที่มีอารมณ์แปรปรวน จากนั้นคุณสามารถติดป้ายกำกับผลงานที่สร้างโดยเครื่องตามระดับความแปรปรวนได้ สิ่งนี้ช่วยให้เครื่องสามารถเรียนรู้พารามิเตอร์เหล่านี้ได้เร็วขึ้นมาก

เพิ่มความพึงพอใจของผู้ใช้

แม้ว่าโมเดล ML จะแม่นยำ แต่ก็อาจดูไม่เหมือนมนุษย์ จำเป็นต้องใช้ RL เพื่อนำทางโมเดลไปสู่การตอบสนองที่ดีที่สุดและน่าดึงดูดที่สุดสำหรับผู้ใช้ที่เป็นมนุษย์

ตัวอย่างเช่น หากคุณถามแชทบอทว่าสภาพอากาศข้างนอกเป็นอย่างไร แชทบอทอาจตอบว่า “อุณหภูมิ 30 องศาเซลเซียส มีเมฆและมีความชื้นสูง” หรืออาจตอบว่า “ขณะนี้อุณหภูมิประมาณ 30 องศา” ท้องฟ้ามีเมฆมากและอากาศชื้น ดังนั้นอากาศจึงอาจดูหนาแน่นขึ้น!” แม้ว่าคำตอบทั้งสองจะพูดในสิ่งเดียวกัน แต่คำตอบที่สองฟังดูเป็นธรรมชาติมากกว่าและให้บริบทมากกว่า

เนื่องจากผู้ใช้ที่เป็นมนุษย์ให้คะแนนการตอบสนองของโมเดลที่พวกเขาต้องการ คุณสามารถใช้ RLHF เพื่อรวบรวมคำติชมของมนุษย์ และปรับปรุงโมเดลของคุณเพื่อให้บริการคนจริงได้ดีที่สุด

RLHF ทำงานอย่างไร

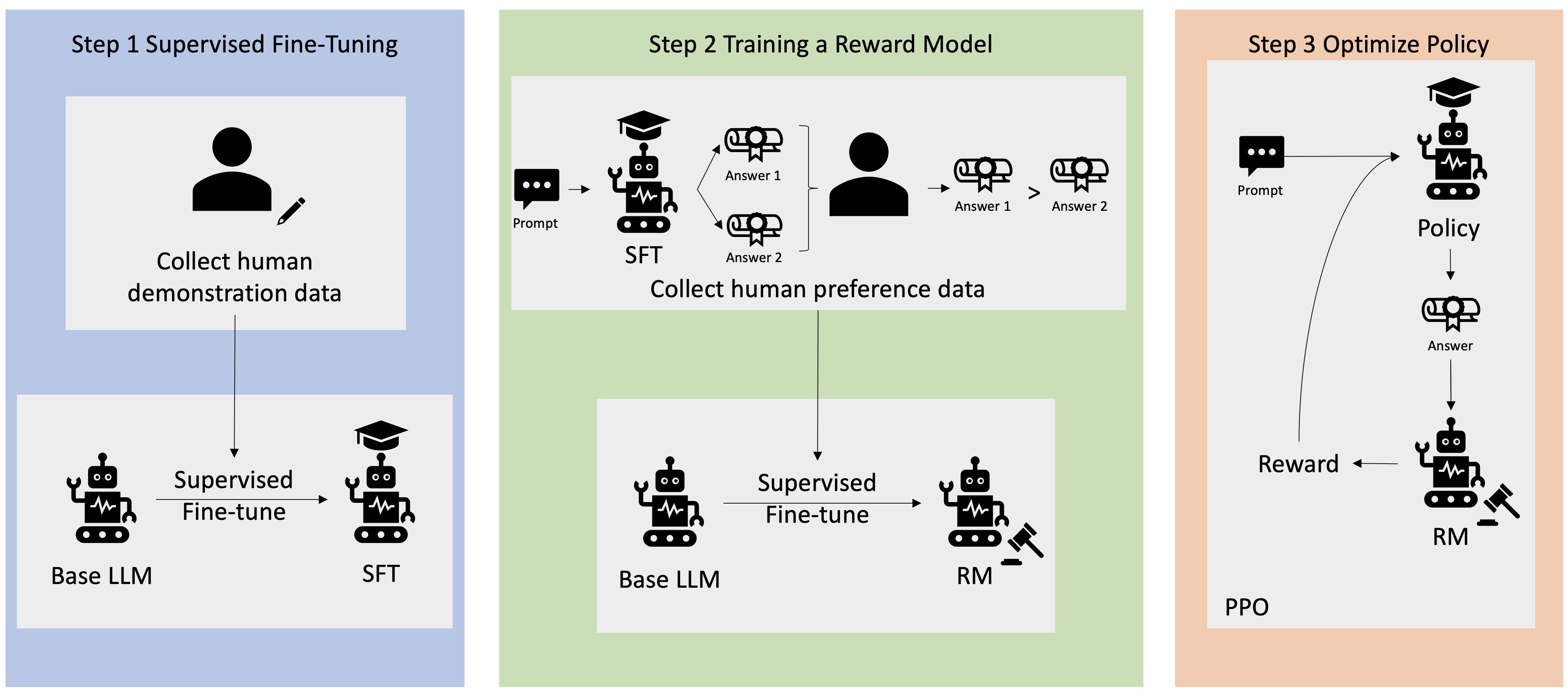

RLHF ดำเนินการในสี่ขั้นตอนก่อนที่โมเดลจะถือว่าพร้อม ที่นี่ เราใช้ตัวอย่างของโมเดลภาษา—แชทบอทฐานความรู้ภายในบริษัท—ที่ใช้ RLHF สำหรับการปรับแต่ง

เราให้เพียงภาพรวมของกระบวนการเรียนรู้เท่านั้น การฝึกอบรมโมเดลและการปรับแต่งนโยบายสำหรับ RLHF มีความซับซ้อนทางคณิตศาสตร์อย่างมีนัยสำคัญ อย่างไรก็ตาม กระบวนการที่ซับซ้อนได้รับการกำหนดไว้อย่างดีใน RLHF และมักจะมีอัลกอริธึมที่สร้างไว้ล่วงหน้าซึ่งเพียงต้องการอินพุตเฉพาะของคุณ

การเก็บรวบรวมข้อมูล

ก่อนที่จะดำเนินการงาน ML ด้วยโมเดลภาษา จะมีการสร้างชุดข้อความแจ้งและการตอบกลับที่มนุษย์สร้างขึ้นสำหรับข้อมูลการฝึก ชุดนี้ใช้ในภายหลังในกระบวนการฝึกของโมเดล

ตัวอย่างเช่น ข้อความพรอมท์อาจเป็น:

- “ที่ตั้งของแผนกทรัพยากรบุคคลในบอสตันอยู่ที่ไหน”

- “ขั้นตอนการอนุมัติสำหรับโพสต์บนโซเชียลมีเดียคืออะไร”

- “รายงานไตรมาสที่ 1 ระบุอะไรเกี่ยวกับยอดขายบ้างเมื่อเทียบกับรายงานประจำไตรมาสก่อนหน้า”

ผู้ใช้ความรู้ในการปฏิบัติงาน (Knowledge Worker) ในบริษัทจะตอบคำถามเหล่านี้ด้วยคำตอบที่ถูกต้องและเป็นธรรมชาติ

มีการควบคุมดูแลการปรับแต่งโมเดลภาษาอย่างละเอียด

คุณสามารถใช้โมเดลฝึกล่วงหน้าเชิงพาณิชย์เป็นโมเดลพื้นฐานสำหรับ RLHF คุณสามารถปรับแต่งโมเดลให้เข้ากับฐานความรู้ภายในของบริษัทได้โดยใช้เทคนิค เช่น Retrieval-augmented generation (RAG) เมื่อโมเดลได้รับการปรับแต่งอย่างละเอียด คุณจะเปรียบเทียบการตอบสนองของโมเดลกับข้อความพรอมท์ที่กำหนดไว้ล่วงหน้ากับการตอบสนองของมนุษย์ที่รวบรวมไว้ในขั้นตอนก่อนหน้า เทคนิคทางคณิตศาสตร์สามารถคำนวณระดับความคล้ายคลึงระหว่างทั้งสองอย่างนี้ได้

ตัวอย่างเช่น การตอบกลับที่เครื่องสร้างขึ้นสามารถกำหนดคะแนนได้ระหว่าง 0 ถึง 1 โดย 1 คือความแม่นยำมากที่สุด และ 0 คือความแม่นยำน้อยที่สุด ด้วยคะแนนเหล่านี้ โมเดลจึงมีนโยบายที่ออกแบบมาเพื่อสร้างการตอบสนองที่ให้คะแนนใกล้เคียงกับการตอบสนองของมนุษย์มากขึ้น นโยบายนี้เป็นพื้นฐานของการตัดสินใจในอนาคตทั้งหมดสำหรับโมเดลนี้

การสร้างโมเดลการให้รางวัลแยก

หัวใจหลักของ RLHF คือการฝึกโมเดลการให้รางวัล AI ที่แยกจากกันโดยอิงตามความคิดเห็นของมนุษย์ จากนั้นใช้โมเดลนี้เป็นฟังก์ชันการให้รางวัลเพื่อปรับนโยบายให้เหมาะสมผ่าน RL เมื่อได้รับชุดการตอบสนองหลายรายการจากโมเดลที่ตอบพรอมท์เดียวกัน มนุษย์สามารถระบุความพึงพอใจเกี่ยวกับคุณภาพของคำตอบแต่ละรายการได้ คุณใช้การตั้งค่าการให้คะแนนการตอบกลับเหล่านี้เพื่อสร้างโมเดลการให้รางวัลที่จะประเมินโดยอัตโนมัติว่ามนุษย์จะให้คะแนนการตอบกลับทันทีได้สูงแค่ไหน

ปรับโมเดลภาษาให้เหมาะสมด้วยโมเดลตามรางวัล

จากนั้นโมเดลภาษาจะใช้โมเดลรางวัลเพื่อปรับแต่งนโยบายโดยอัตโนมัติก่อนที่จะตอบสนองต่อพรอมท์ เมื่อใช้โมเดลการให้รางวัล โมเดลภาษาจะประเมินชุดคำตอบภายใน จากนั้นเลือกคำตอบที่มีแนวโน้มมากที่สุดที่จะให้ผลลัพธ์ที่ยิ่งใหญ่ที่สุด ซึ่งหมายความว่ามันจะตอบสนองความต้องการของมนุษย์ในลักษณะที่เหมาะสมที่สุด

ภาพต่อไปนี้แสดงภาพรวมของกระบวนการเรียนรู้ RLHF

RLHF ถูกนำมาใช้ในด้าน AI ช่วยสร้างอย่างไร

RLHF ได้รับการยอมรับว่าเป็นเทคนิคมาตรฐานอุตสาหกรรมในการรับรองว่า LLM ผลิตเนื้อหาที่เป็นความจริง ไม่เป็นอันตราย และเป็นประโยชน์ อย่างไรก็ตาม การสื่อสารของมนุษย์เป็นกระบวนการที่เป็นอัตนัยและสร้างสรรค์ และประโยชน์ของผลลัพธ์ LLM นั้นได้รับอิทธิพลอย่างลึกซึ้งจากค่านิยมและความชอบของมนุษย์ โมเดลแต่ละโมเดลได้รับการฝึกฝนแตกต่างกันเล็กน้อยและใช้การตอบสนองของมนุษย์ที่แตกต่างกัน ดังนั้นผลลัพธ์จึงแตกต่างกันแม้ระหว่าง LLM ของคู่แข่งก็ตาม ระดับที่แต่ละโมเดลเกี่ยวข้องกับค่านิยมของมนุษย์นั้นขึ้นอยู่กับผู้สร้างโดยสิ้นเชิง

แอปพลิเคชันของ RLHF ขยายขอบเขตของ LLM ไปสู่ AI ช่วยสร้างประเภทอื่นๆ ดังตัวอย่างต่อไปนี้

- RLHF สามารถใช้ในการสร้างภาพด้วย AI ได้ เช่น การวัดระดับความสมจริง เทคนิค หรืออารมณ์ของงานศิลปะ

- ในการสร้างดนตรี RLHF สามารถช่วยในการสร้างเพลงที่ตรงกับอารมณ์และเพลงประกอบกับกิจกรรมต่างๆ

- สามารถใช้ RLHF ในผู้ช่วยเสียงได้ โดยแนะนำเสียงให้ฟังดูเป็นมิตร น่าสนใจ และน่าเชื่อถือมากขึ้น

AWS จะช่วยเรื่องข้อกำหนด RLHF ของคุณได้อย่างไรบ้าง

Amazon SageMaker Ground Truth นำเสนอชุดความสามารถแบบมนุษย์ในวงที่ครอบคลุมที่สุดสำหรับการรวมความคิดเห็นของมนุษย์ตลอดวงจรการทำงานของ ML เพื่อปรับปรุงความแม่นยำและความเกี่ยวข้องของโมเดล คุณสามารถทำงานแบบมนุษย์ในลูปได้หลากหลาย ตั้งแต่การสร้างข้อมูลและคำอธิบายประกอบไปจนถึงการให้รางวัลในการสร้างโมเดล การตรวจสอบโมเดล และการปรับแต่งผ่านข้อเสนอแบบบริการตนเองหรือที่ AWS จัดการ

SageMaker Ground Truth มีตัวอธิบายข้อมูลสำหรับความสามารถ RLHF คุณสามารถให้ข้อเสนอแนะและคำแนะนำโดยตรงเกี่ยวกับผลลัพธ์ที่โมเดลสร้างขึ้นโดยการจัดอันดับ การจัดประเภท หรือทำทั้งสองอย่างสำหรับการตอบสนองต่อผลลัพธ์ RL ข้อมูลที่เรียกว่าข้อมูลการเปรียบเทียบและการจัดอันดับนั้นเป็นโมเดลการให้รางวัลหรือฟังก์ชันการให้รางวัลที่มีประสิทธิภาพ ซึ่งจะนำไปใช้ในการฝึกโมเดล คุณสามารถใช้ข้อมูลการเปรียบเทียบและการจัดอันดับเพื่อปรับแต่งโมเดลที่มีอยู่สำหรับกรณีการใช้งานของคุณ หรือปรับแต่งโมเดลที่คุณสร้างตั้งแต่เริ่มต้น

เริ่มต้นใช้งานเทคนิค RLHF บน AWS ด้วยการสร้างบัญชีวันนี้

ขั้นตอนถัดไปบน AWS