亚马逊AWS官方博客

AWS DeepComposer – 现已全面开放并增加新的功能

AWS DeepComposer 是一种创新的机器学习入门方法,在 AWS re:Invent 2019 大会上推出了预览版。今天我特别高兴地宣布,DeepComposer 现已向所有 AWS 客户开放并增加了多项新功能。

AWS DeepComposer 基础

如果您还不熟悉 AWS DeepComposer,请参考下面的入门步骤。

- 登录 AWS DeepComposer 控制台。

- 了解该服务以及它如何使用生成式 AI。

- 使用控制台中的虚拟键盘或物理键盘(可在 Amazon.com 订购)录制一段短乐音。

- 选择您喜爱种类的预训练模型。

- 以您的乐音为基础,使用此模型生成新的复调乐曲。

- 在控制台中播放乐曲。

- 导出乐曲或在 SoundCloud 上分享。

现在我们来看新增的功能,借助这些新功能可以更轻松开始使用生成式 AI。

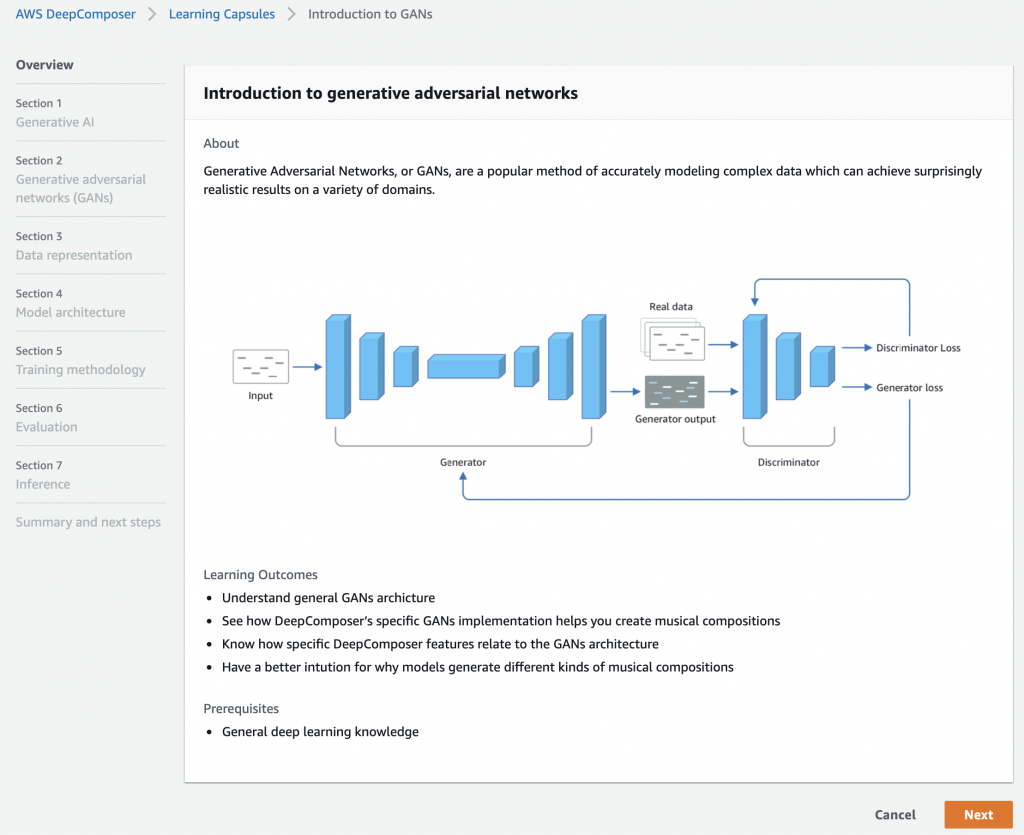

学习胶囊

DeepComposer 采用生成式对抗网络(简称 GAN,参阅研究报告)技术。GAN 是一种专为利用现有数据集生成新样本而构建的神经网络架构。GAN 包含两个相互对抗的不同神经网络,根据样本输入生成原创数字作品:借助 DeepComposer,您可以训练并优化 GAN 模型以创作原创音乐。

在此之前,希望提升 GAN 技能的开发人员并没有轻松的入门方法。为了帮助他们提升,而不论他们的 ML 或音乐背景如何,我们构建了一系列的轻松学习胶囊,介绍了关键的概念以及如何训练和评估 GAN。这包括一个动手实验室,其中包含了构建 GAN 模型的详细分步操作说明和代码。

在您熟悉 GAN 后,您将能够开始训练自己的模型!

控制台中训练

您现在可以在 DeepComposer 控制台中直接训练自己的生成式模型,无需编写任何机器学习代码。

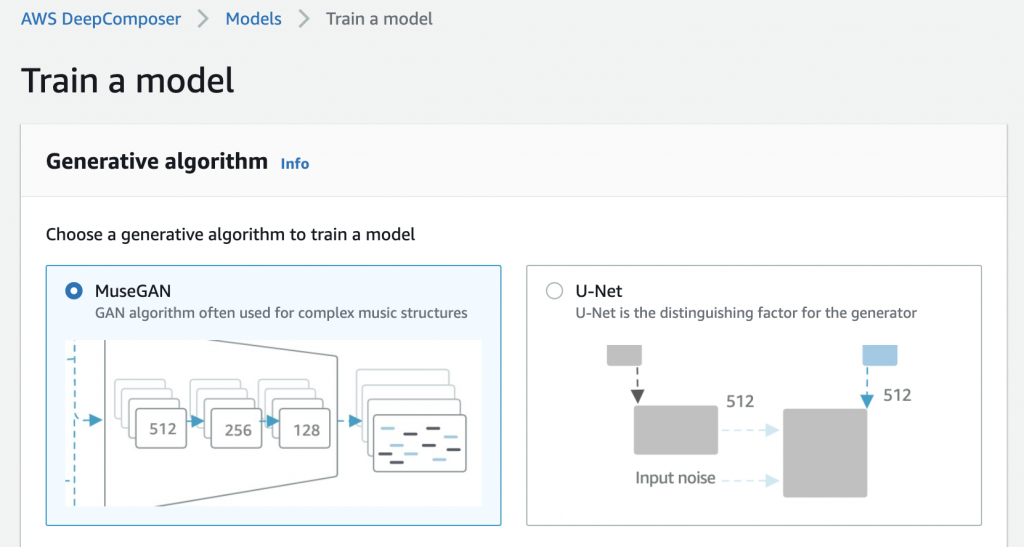

首先选择一个 GAN 架构:

- MuseGAN(由 Hao-Wen Dong、Wen-Yi Hsiao、Li-Chia Yang 和 Yi-Hsuan Yang 开发,参阅研究报告,见 Github):MuseGAN 专为生成音乐而设计。MuseGAN 中的生成器由一个共享网络和一系列私有网络组成,该共享网络用于学习歌曲的高级别表现,私有网络用于学习如何生成单个音轨。

- U-Net(由 Olaf Ronneberger、Philipp Fischer 和 Thomas Brox 开发,参阅研究报告,见项目页面):U-Net 在图像转换领域尤其成功(例如将冬季图像转换为夏季图像),也可以用于音乐生成。它的架构比 MuseGAN 更简单,因此更便于初学者理解。如果您想更深入了解,则可以通过此 Jupyter 笔记本进一步了解 U-Net 架构。

假设我们使用 MuseGAN 并给新模型取一个名称。

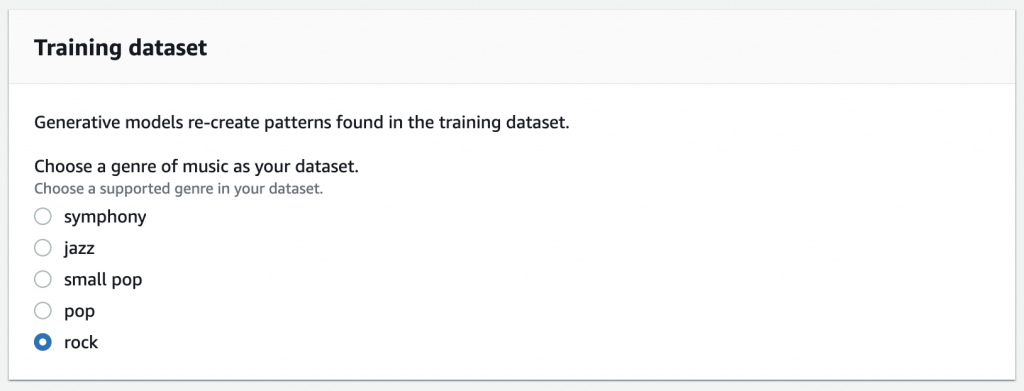

然后我会选择我要用于训练模型的数据集。

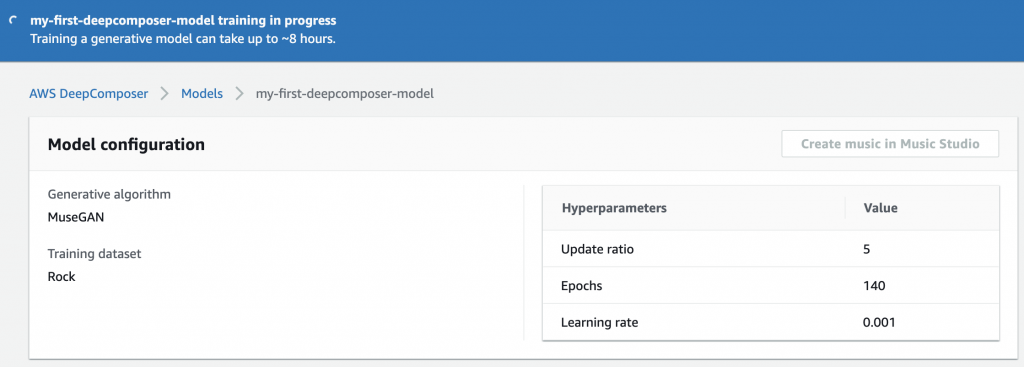

当然我也可以设置超参数(即训练参数),但这次我将使用默认设置。最后,我单击“开始训练”,AWS DeepComposer 将会启动一个训练作业并代我完成所有的基础设施和机器学习设置。

大约 8 小时后,模型训练完成,我可以使用它来生成乐曲。此处我可以添加新推出的“旋律助手”功能,它会帮助纠正输入中的音符定时,并确保音符与节拍保持一致。

入门

AWS DeepComposer 现已在美国东部(弗吉尼亚北部)区域开放。

此服务为所有 AWS 客户提供了 12 个月的免费套餐,因此您可以使用我们的示例模型免费生成 500 首乐曲。

除提供免费套餐外,在美国境内通过 Amazon.com 订购键盘并将它关联到 DeepComposer 控制台,还将享受另外 3 个月的免费试用机会!

立即试用 AWS DeepComposer 并向我们提供反馈! 请通过您常用的 AWS Support 联系方式或者 DeepComposer 的 AWS 论坛向我们发送反馈。