Инстансы Amazon EC2 Inf1

Компании из самых разных отраслей выбирают трансформацию на базе искусственного интеллекта в качестве основы для стимулирования бизнес-инноваций, улучшения качества сервиса и рабочих процессов. Модели машинного обучения, которые лежат в основе приложений искусственного интеллекта, становятся все более сложными, а следовательно растет и базовая стоимость вычислительной инфраструктуры. До 90 % инфраструктурных затрат, вложенных в разработку и запуск приложений машинного обучения, зачастую приходится на логические выводы. Клиентам требуются экономически эффективные инфраструктурные решения для развертывания приложений машинного обучения на производстве.

Инстансы Amazon EC2 Inf1 обеспечивают высокопроизводительный логический вывод ML с низкими затратами. Они могут увеличить пропускную способность в 2,3 раза и сократить стоимость вывода на 70 % по сравнению с аналогичными инстансами Amazon EC2. Инстансы Inf1 изначально разработаны для поддержки логических приложений машинного обучения. Данные инстансы содержат до 16 высокопроизводительных микросхем логических выводов машинного обучения AWS Inferentia, разработанных и созданных компанией AWS. Кроме того, инстансы Inf1 оснащены процессорами Intel Xeon Scalable 2-го поколения и сетевым интерфейсом со скоростью до 100 Гбит/с, что дает высокую пропускную способность логических выводов.

С помощью инстансов Inf1 клиенты могут запускать широкомасштабные приложения логических выводов машинного обучения, такие как поиск, механизмы рекомендаций, машинное зрение, обработка естественного языка (NLP), персонализация, а также выявление мошенничества.

Разработчики могут развертывать модели машинного обучения на инстансах Inf1 с помощью AWS Neuron SDK, интегрированного в популярные среды машинного обучения, такие как TensorFlow, PyTorch и Apache MXNet. Можно не менять используемые рабочие процессы машинного обучения и беспрепятственно переносить приложения на инстансы Inf1, внося минимальные изменения в код и не привязываясь к решениям конкретных поставщиков.

Легко начните работу с инстансами Inf1, используя Amazon SageMaker, Глубокое обучение AWS AMI (DLAMI), поставляемые с предварительно настроенным SDK Neuron, Эластичный контейнерный сервис Amazon (Amazon ECS) или Эластичный сервис Amazon Kubernetes (Amazon EKS) для контейнерных приложений машинного обучения.

Преимущества

Экономия до 70 % на затраты на логические выводы

С помощью Inf1 разработчики могут значительно снизить стоимость рабочих развертываний машинного обучения. Сочетание низкой стоимости и высокой пропускной способности инстансов Inf1 обеспечивает экономию до 70 % на затраты на логический вывод, если сравнивать с аналогичными инстансами Amazon EC2.

Простота использования и универсальность кода

Пакет SDK Neuron интегрирован в распространенные модели платформ машинного обучения, такие как TensorFlow, PyTorch и MXNet. Можно не менять используемые рабочие процессы машинного обучения и беспрепятственно переносить приложения на инстансы Inf1, внося минимальные изменения в код. Это позволяет свободно выбирать платформу машинного обучения, использовать вычислительную платформу, которая отвечает требованиям наилучшим образом, и задействовать новейшие технологии, не привязываясь к решениям конкретных поставщиков.

Пропускная способность больше вплоть до 2,3 раза

Инстансы Inf1 обеспечивают пропускную способность выше до 2,3 раза по сравнению с аналогичными инстансами Amazon EC2. В основе инстансов Inf1 лежат микросхемы AWS Inferentia, которые оптимизированы для рабочего вывода небольших пакетов, что позволяет приложениям, работающим в режиме реального времени, обеспечить самую большую пропускную способность и необходимое время задержки.

Крайне низкая задержка

В микросхемы AWS Inferentia встроен большой объем памяти, который позволяет кэшировать модели машинного обучения прямо в микросхеме. Вы можете развертывать модели с помощью, например, такой функции, как конвейер NeuronCore, который позволяет не получать доступ к внешним ресурсам памяти. С инстансами Inf1 можно развертывать приложения для получения логических выводов в режиме реального времени, при этом получая близкое к реальному время задержки без ущерба для пропускной способности.

Поддержка различных моделей машинного обучения и типов данных

Инстансы Inf1 поддерживают многие часто используемые модели архитектуры машинного обучения, такие как SSD, VGG и ResNext для распознавания или классификации изображений, а также Transformer и BERT для обработки естественного языка. Кроме того, Neuron поддерживает репозиторий моделей HuggingFace, что позволяет клиентам легко компилировать и выполнять вывод с использованием предварительно подготовленных или тонко настроенных моделей, всего лишь изменив одну строку кода. Также поддерживается несколько типов данных, в том числе BF16 и FP16 со смешанной точностью, обеспечивая разнообразие моделей и требований к производительности.

Возможности

На базе AWS Inferentia

AWS Inferentia – это специальная микросхема для машинного обучения, разработанная и созданная компанией AWS для обеспечения высокой производительности получения логических выводов при низкой стоимости. Каждая микросхема AWS Inferentia оснащена 4 ядрами NeuronCore первого поколения, производит до 128 тераопераций в секунду (терафлопсов) и поддерживает типы данных FP16, BF16 и INT8. Также микросхемы AWS Inferentia имеют большой объем встроенной памяти, которую можно использовать для кэширования больших моделей, что особенно полезно для моделей, которым необходим частый доступ к памяти.

Развертывание с использованием популярных сред машинного обучения с помощью AWS Neuron

SDK AWS Neuron состоит из компилятора, драйвера среды выполнения и инструментов профилирования. Он позволяет выполнять развертывание сложных моделей нейронных сетей, созданных и обученных на популярных платформах, таких как TensorFlow, PyTorch и MXNet, используя инстансы Inf1. С помощью Конвейера NeuronCore можно разделять большие модели для выполнения на нескольких микросхемах Inferentia с использованием высокоскоростного физического соединения микросхем, что повышает пропускную способность и снижает затраты.

Высокая производительность сети и хранилища

Для приложений, которым требуется высокая сетевая производительность, инстансы Inf1 обеспечивают пропускную способность сети до 100 Гбит/с. Благодаря эластичным сетевым адаптерам (ENA) и технологии NVM Express (NVMe) нового поколения инстансы Inf1 оснащены интерфейсами с высокой пропускной способностью и низкой задержкой для работы с сетями и Магазином эластичных блоков Amazon (Amazon EBS).

Создано на основе Системы AWS Nitro

Система AWS Nitro предлагает широкий выбор структурных блоков, позволяющих использовать выделенное оборудование и программное обеспечение для выполнения многих традиционных задач виртуализации, чтобы повышать производительность, доступность и безопасность при одновременном сокращении издержек, связанных с виртуализацией.

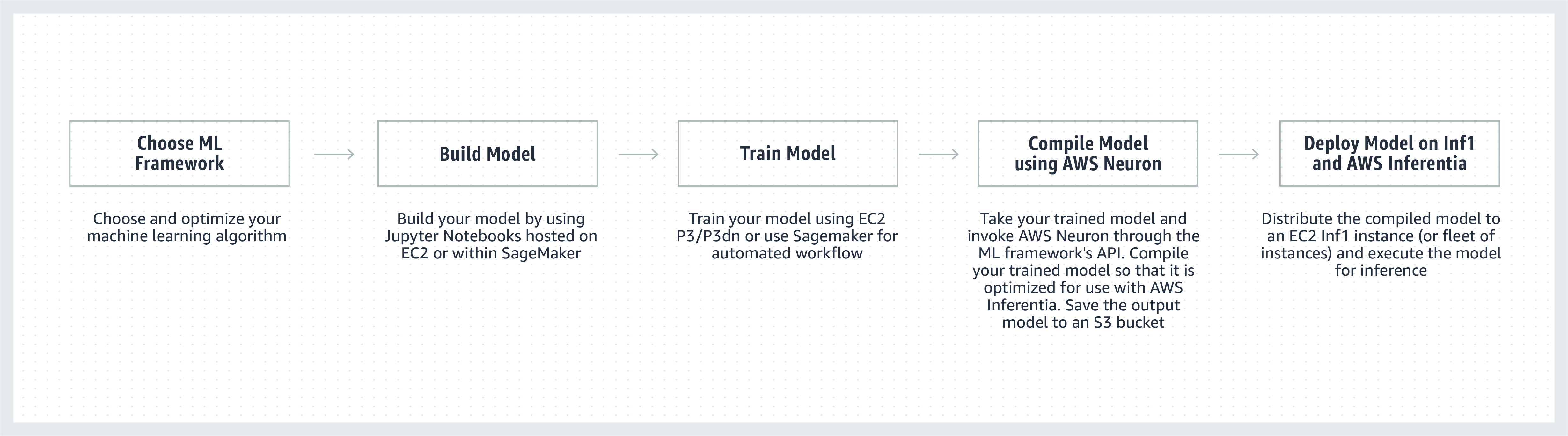

Принцип работы сервиса

Отзывы клиентов

Компания Airbnb, основанная в 2008 году в Сан-Франциско, – это рынок сообщества, который охватывает более 4 миллионов хостов, которые посетило более 900 миллионов гостей почти в каждой стране мира.

«Платформа Airbnb с поддержкой сообщества обеспечивает интеллектуальные функции, масштабируемость и исключительное обслуживание для нашего сообщества из миллионов гостей и хостов во всем мире. Мы постоянно ищем пути повышения производительности наших моделей обработки естественного языка, которые используются нашим чат-ботом службы поддержки. Благодаря инстансам Amazon EC2 Inf1 на базе AWS Inferentia мы наблюдаем двукратное повышение пропускной способности без предварительной настройки при использовании инстансов на основе графических процессоров для моделей BERT на основе PyTorch. В будущем мы хотим применять инстансы Inf1 и для других моделей и примеров использования».

Бо Цзэн, руководитель инженерной группы, Airbnb

«Мы внедряем машинное обучение во множество аспектов Snapchat. Исследование инноваций в этой области является главным приоритетом. Мы начали сотрудничать с AWS, как только узнали об Inferentia. Наша цель заключалась в адаптации инстансов Inf1/Inferentia для последующего развертывания машинного обучения, включая аспекты производительности и затрат. Мы начали с моделей рекомендаций и с нетерпением ждем возможности использовать больше моделей с инстансами Inf1 в дальнейшем».

Нима Хадженоури, вице-президент по проектированию, Snap Inc.

«Единая платформа управления клиентским опытом (Unified-CXM) Sprinklr на основе искусственного интеллекта позволяет компаниям собирать отзывы клиентов по нескольким каналам и преобразовывать их в режиме реального времени в полезные выводы – и в результате решать проблемы на упреждение, улучшать разработку продуктов, контент-маркетинг, обслуживание клиентов и многое другое. С помощью Amazon EC2 Inf1 мы смогли значительно улучшить производительность наших моделей компьютерного зрения и обработки естественного языка (NLP). Мы с нетерпением ожидаем дальнейшего использования Amazon EC2 Inf1, чтобы предоставить лучшее обслуживание для наших клиентов по всему миру».

Васант Шринивасан, старший вице-президент по разработке продуктов в Sprinklr

«Наш современный продукт для обработки естественного языка Finch for Text позволяет пользователям извлекать и обогащать многие типы сущностей в больших объемах текста и устранять в них противоречия. Для Finch for Text требуется значительное количество вычислительных ресурсов, чтобы проводить обогащение глобальных потоков данных с малой задержкой. Теперь мы используем инстансы AWS Inf1 в моделях PyTorch NLP, перевода и устранения противоречий. Нам удалось сократить затраты на формирование логических выводов более чем на 80 % (по сравнению с графическими процессорами) с минимальной оптимизацией и сохранением скорости и производительности. Это улучшение позволяет нашим клиентам обогащать текст на французском, испанском, немецком и голландском языке в потоках данных в режиме реального времени в глобальных масштабах, что крайне важно для наших клиентов из сферы финансовых услуг, агрегирования данных и государственного сектора».

Скотт Лайтнер, технический директор Finch Computing

«Мы оповещаем о различных событиях по всему миру на разных языках и в разных форматах (изображения, видео, аудио, текстовые датчики, комбинации всех этих типов) из сотен тысяч источников. Оптимизация скорости и затрат с учетом такого масштаба крайне важна для нашего бизнеса. С помощью AWS Inferentia мы снизили задержку модели и достигли до 9 раз лучшей пропускной способности в пересчете на один доллар. Таким образом, мы смогли повысить точность моделирования и расширить возможности нашей платформы за счет развертывания более сложных моделей глубокого обучения и обработки в 5 раз большего объема данных, сохраняя при этом контроль над расходами».

Алекс Джеймс, главный научный сотрудник и старший вице-президент по вопросам искусственного интеллекта, Dataminr

«Компания Autodesk расширяет когнитивные технологии нашего виртуального помощника на базе ИИ, Autodesk Virtual Agent (AVA), используя Inferentia. Виртуальный помощник AVA отвечает на более чем 100 000 вопросов клиентов ежемесячно, применяя технологию понимания естественного языка и методы глубокого обучения для извлечения контекста, намерений и смысла запросов. Используя Inferentia в тестовом режиме, мы можем повысить пропускную способность в 4,9 раза по сравнению с G4dn для наших моделей на базе понимания естественного языка и надеемся запустить больше рабочих нагрузок на инстансах Inf1 на основе Inferentia».

Бингуи Оянг, старший специалист по работе с данными, Autodesk

Сервисы Amazon с использованием инстансов Inf1 на основе Amazon EC2

Amazon Advertising помогает компаниям любого размера общаться с клиентами на каждом этапе их покупательского пути. Миллионы объявлений, включая текстовые и графические, модерируются, классифицируются и обслуживаются, чтобы ежедневно обеспечивать оптимальное обслуживание клиентов.

«Для обработки текстовой рекламы мы развертываем модели BERT на основе PyTorch на инстансах Inf1, базирующихся на AWS Inferentia, по всему миру. Сменив графические процессоры на Inferentia, мы добились снижения затрат на 69 % при сопоставимой производительности. Компиляция и тестирование моделей для AWS Inferentia заняли менее трех недель. Использование Amazon SageMaker для развертывания моделей в инстансах Inf 1 обеспечило масштабируемость и простоту управления. Когда я впервые проанализировал скомпилированные модели, AWS Inferentia показал настолько впечатляющую производительность, что мне пришлось запустить тесты повторно, чтобы убедиться в правдивости! В дальнейшем мы планируем перенести в Inferentia модели обработки рекламных изображений. Мы уже отметили снижение времени задержки на 30 % и экономию средств в размере 71 % по сравнению с сопоставимыми инстансами той же модели на базе графического процессора».

Яшал Канунго, практикующий научный сотрудник, Amazon Advertising

Читать новостной блог »

«Возможности искусственного интеллекта и машинного обучения Amazon Alexa, которые работают на основе AWS, сегодня доступны более чем на 100 миллионах устройств, и мы обещаем клиентам, что Alexa все время будет становиться умнее, общительнее, предусмотрительнее и даже очаровательнее. Чтобы выполнить это обещание, нужно постоянно сокращать время отклика и затраты на инфраструктуру машинного обучения, поэтому мы рады применять инстансы Inf1 на основе Amazon EC2, чтобы снижать задержку генерирования логических выводов и сокращать затраты на каждый логический вывод при использовании функции Alexa для преобразования текста в речь. Благодаря Inf1 на основе Amazon EC2 мы сможем сделать этот сервис еще удобнее для десятков миллионов клиентов, которые пользуются Alexa каждый месяц».

Том Тейлор, старший вице-президент, Amazon Alexa

«Мы постоянно внедряем инновации ради повышения качества обслуживания клиентов и снижения затрат на инфраструктуру. Перенос рабочих нагрузок, касающихся ответов на вопросы в онлайн-формате (WBQA), с инстансов P3 на основе GPU на инстансы Inf1 на основе AWS Inferentia помог снизить затраты на вывод на 60 %, а также более чем на 40 % сократить задержку на всем пути сигнала, благодаря чему общение клиентов с Alexa стало лучше. Мы использовали Amazon SageMaker для нашей модели на основе Tensorflow, и за счет этого легко и просто перешли на инстансы Inf 1. Сейчас для рабочих нагрузок WBQA мы по всему миру задействуем инстансы Inf1 и оптимизируем их производительность для AWS Inferentia, чтобы еще больше сократить затраты и задержку».

Эрик Линд, инженер по разработке ПО, Alexa AI.

«Amazon Prime Video использует модели компьютерного видения на базе машинного обучения для анализа качества видео прямых трансляций, чтобы предоставить участникам Prime Video наилучшие впечатления. Мы развернули наши модели классификации изображений на основе машинного обучения на инстансах EC2 Inf1, что позволило повысить производительность в 4 раза и сократить затраты почти на 40 %. Теперь мы хотим использовать эти сэкономленные средства для инноваций и создания усовершенствованных моделей для обнаружения более сложных дефектов, таких как задержка синхронизации между аудио- и видеофайлами, чтобы улучшить впечатления участников Prime Video».

Виктор Антонио, архитектор решений, Amazon Prime Video

Amazon Rekognition – это простое и удобное приложение для анализа изображений и видео, которое помогает клиентам идентифицировать объекты, людей, текст и действия. Приложение Amazon Rekognition требует высокопроизводительной инфраструктуры глубокого обучения, которая может ежедневно анализировать миллиарды изображений и видео для наших клиентов. Благодаря инстансам Inf1 на основе AWS Inferentia использование таких моделей Amazon Rekognition, как классификация объектов, привело к сокращению задержки в 8 раз и увеличению пропускной способности в 2 раза по сравнению с использованием этих моделей на ГП. С учетом этих результатов мы перемещаем Amazon Rekognition на Inf1, что позволяет нашим клиентам быстрее получать точные результаты».

Раджниш Сингх, директор, программная инженерия, Amazon Rekognition и видео

Цены

* Цены указаны для региона AWS Восток США (Северная Вирджиния). Цены, указанные для инстансов, зарезервированных на 1 и 3 года, действительны при выборе способа оплаты с частичной предоплатой или без предоплаты (для инстансов, не предусматривающих возможности частичной предоплаты).

Инстансы Amazon EC2 Inf1 доступны в регионах AWS Восток США (Северная Вирджиния) и Запад США (Орегон) как инстансы по требованию, а также зарезервированные и спотовые инстансы.

Начало работы

Использование Amazon SageMaker

Amazon SageMaker упрощает компиляцию и развертывание обученной модели машинного обучения в производственной среде на инстансах Amazon Inf1, чтобы вы могли начать генерировать прогнозы в реальном времени и с низкой задержкой. AWS Neuron, компилятор для AWS Inferentia, интегрирован с Amazon SageMaker Neo, что позволяет компилировать обученные модели машинного обучения для оптимальной работы на инстансах Inf1. С помощью SageMaker вы можете легко запускать модели в автомасштабируемых кластерах инстансов Inf1, расположенных в нескольких зонах доступности, что обеспечивает высокую производительность и доступность логических выводов в реальном времени. Узнайте, как развернуть модель на инстансе Inf1 с помощью SageMaker, изучив примеры на Github.

Использование образов DLAMI

Образы DLAMI предоставляют специалистам по машинному обучению и ученым инфраструктуру и инструменты для ускорения глубокого обучения в облаке в любых масштабах. В AWS Neuron SDK заранее установлены образы DLAMI для оптимальной компиляции и работы ваших моделей машинного обучения на инстансах Inf1. Чтобы получить инструкции по началу работы, см. Руководство по выбору AMI и другие ресурсы по глубокому обучению. Чтобы узнать, как пользоваться DLAMI с Neuron, см. Руководство по началу работы с AWS DLAMI.

Контейнеры глубокого обучения AWS

Теперь разработчики могут развертывать инстансы Inf1 в Эластичном сервисе Amazon Kubernetes (EKS), полностью управляемом сервисе Kubernetes, а также в Эластичном контейнерном сервисе Amazon (ECS), полностью управляемом сервисе оркестрации контейнеров от Amazon. Подробнее о начале работы с Inf1 на основе Amazon EKS или Amazon ECS. Дополнительная информация о работе контейнеров на инстансах Inf1 доступна на странице Учебного пособия по инструментам контейнеров Neuron. Кроме того, Neuron предварительно установлен в контейнерах для глубокого обучения AWS.

Публикации в блогах и статьи

Авторы: Джао Моура, Джейсон Карлсон, Джасприт Сингх, Шаохуа Си, Шрути Копаркар, Хаовей Сан, Вэй Чжан и Чжуоци Чжан, 22.09.2022

MIT Technology Review Insights, 01.11.2021

Авторы: Давиде Галлители и Хасан Пунавала, 19.10.2021

Облачное машинное обучение помогает бизнесу внедрять инновации

MIT Technology Review Insights, 15.10.2021

Авторы: Алекс Янкоулски, Джошуа Корреа, Махадеван Баласубраманьям и Сундар Ранганатха, 30.09.2021

Автор: Фабио Нонато де Паула и Махадеван Баласубраманиам, 4.05.2021 г.

Автор: Бингуи Оянг, 07.04.2021

Большая часть Alexa теперь работает на более быстрых и экономных инстансах Amazon EC2 Inf1

Себастьян Стормак, 12.11.2020 г.

Жюльен Симон (Julien Simon), 22.04.2020 г.

Amazon ECS теперь поддерживает инстансы EC2 Inf1

Жюльен Симон (Julien Simon), 14.08.2020 г.

Фабио Нонато де Паула и Хайчэнь Ли, 22.07.2020 г.

Amazon EKS теперь поддерживает инстансы EC2 Inf1

Жюльен Симон (Julien Simon), 15.06.2020 г.

Джеф Барр (Jeff Barr), 03.12.2019 г.