Amazon-EC2-Inf1-Instances

Unternehmen aus den unterschiedlichsten Branchen setzen auf künstliche Intelligenz (KI)-gestützte Transformation, um Geschäftsinnovationen voranzutreiben, das Kundenerlebnis zu verbessern und Prozesse zu optimieren. Die Modelle für Machine Learning (ML), die KI-Anwendungen antreiben, werden immer komplexer, was zu steigenden Kosten für die zugrunde liegende Recheninfrastruktur führt. Bis zu 90 % der Infrastrukturausgaben für die Entwicklung und den Betrieb von ML-Anwendungen entfallen häufig auf die Inferenz. Kunden sind auf der Suche nach kostengünstigen Infrastrukturlösungen für den Einsatz ihrer ML-Anwendungen in der Produktion.

Amazon-EC2-Inf1-Instances liefern leistungsstarke und kostengünstige ML-Inferenz. Sie bieten einen bis zu 2,3-fach höheren Durchsatz und bis zu 70 % niedrigere Kosten pro Inferenz als vergleichbare Amazon-EC2-Instances. Inf1-Instances sind von Grund auf neu entwickelt worden, um Inferenzanwendungen für ML zu unterstützen. Sie verfügen über bis zu 16 AWS-Inferentia-Chips, leistungsstarke ML-Inferenz-Chips, die von AWS entwickelt und gebaut wurden. Außerdem verfügen Inf1-Instances über Intel-Xeon-Scalable-Prozessoren der 2. Generation und bis zu 100 Gbit/s Netzwerkfähigkeit, um Inferenzen mit hohem Durchsatz zu liefern.

Kunden können Inf1-Instances nutzen, um groß angelegte ML-Inferenzanwendungen wie Suchempfehlungs-Engines, Computervision, Spracherkennung, natürliche Sprachverarbeitung (NLP), Personalisierung und Betrugserkennung ausführen.

Entwickler können ihre ML-Modelle mithilfe des AWS Neuron SDK, das in gängige ML-Frameworks wie TensorFlow, PyTorch und Apache MXNet integriert ist, auf Inf1-Instances anwenden. Sie können weiterhin dieselben ML-Workflows verwenden und Anwendungen nahtlos auf Inf1-Instances migrieren – mit minimalen Code-Änderungen und ohne Bindung an herstellerspezifische Lösungen.

Beginnen Sie ganz einfach mit Inf1-Instances, die Amazon SageMaker, AWS Deep Learning AMIs (DLAMI), die mit Neuron SDK vorkonfiguriert sind, oder Amazon Elastic Container Service (Amazon ECS) oder Amazon Elastic Kubernetes Service (Amazon EKS) für containerisierte ML-Anwendungen verwenden.

Vorteile

Bis zu 70 % weniger Kosten pro Inferenz

Mit Inf1 können Entwickler die Kosten für ihre ML-Produktions-Bereitstellungen reduzieren. Die Kombination aus niedrigen Instance-Kosten und hohem Durchsatz der Inf1-Instances liefert bis zu 70 % niedrigere Kosten pro Inferenz als vergleichbare Amazon-EC2-Instances.

Einfache Nutzung und Code-Übertragbarkeit

Neuron SDK ist in gängige ML-Frameworks wie TensorFlow, PyTorch und MXNet integriert. Entwickler können weiterhin dieselben ML-Workflows verwenden und ihre Anwendungen mit minimalen Code-Änderungen nahtlos auf Inf1-Instances migrieren. Dies gibt ihnen die Freiheit, das ML-Framework ihrer Wahl und die Datenverarbeitungsplattform zu verwenden, die ihren Anforderungen am besten entspricht, sowie die neuesten Technologien zu nutzen, ohne an herstellerspezifische Lösungen gebunden zu sein.

Bis zu 2,3-fach höherer Durchsatz

Inf1-Instances liefern einen bis zu 2,3-fach höheren Durchsatz als vergleichbare GPU-basierte Amazon-EC2-Instances der aktuellen Generation. Die AWS-Inferentia-Chips, die Inf1-Instances antreiben, sind für die Inferenzleistung bei kleinen Stapelgrößen optimiert, sodass Echtzeitanwendungen den Durchsatz maximieren und die Latenzanforderungen erfüllen können.

Äußerst niedrige Latenz

AWS-Inferentia-Chips sind mit einem großen On-Chip-Arbeitsspeicher ausgestattet, der das Caching von ML-Modellen direkt auf dem Chip selbst ermöglicht. Sie können Ihre Modelle mithilfe von Funktionen wie der NeuronCore-Pipeline bereitstellen, die den Zugriff auf externe Speicherressourcen überflüssig machen. Mit Inf1-Instances können Sie Echtzeit-Inferenzanwendungen mit nahezu Echtzeit-Latenzen einsetzen, ohne die Bandbreite zu beeinträchtigen.

Unterstützung für verschiedene ML-Modelle und Datentypen

Inf1-Instances unterstützen viele häufig verwendete ML-Modellarchitekturen wie SSD, VGG und ResNext für die Bilderkennung/Klassifizierung sowie Transformer und BERT für NLP. Darüber hinaus bietet die Unterstützung für das HuggingFace-Modell-Repository in Neuron Kunden die Möglichkeit, Inferenzen mithilfe vortrainierter oder fein abgestimmter Modelle einfach zu kompilieren und auszuführen, indem nur eine einzige Codezeile geändert wird. Außerdem werden auch mehrere Datentypen wie BF16 und FP16 mit gemischter Präzision für eine Vielzahl von Modellen und Leistungsanforderungen unterstützt.

Features

Powered by AWS Inferentia

AWS Inferentia ist ein ML-Chip, der von AWS speziell gebaut wurde, um hohe Inferenzleistung zu niedrigen Kosten zu liefern. Jeder AWS Inferentia-Chip verfügt über vier NeuronCores der ersten Generation und bietet eine Leistung von bis zu 128 Tera-Operationen pro Sekunde (TOPS) sowie Unterstützung für FP16-, BF16- und INT8-Datentypen. AWS Inferentia-Chips verfügen auch über einen großen On-Chip-Speicher, der für das Caching umfangreicher Modelle verwendet werden kann, was besonders bei Modellen mit häufigen Speicherzugriffen vorteilhaft ist.

Mit gängigen ML-Frameworks unter Verwendung von AWS Neuron bereitstellen

Das AWS-Neuron-SDK besteht aus einem Compiler, einem Laufzeittreiber und Profiling-Tools. Es ermöglicht die Bereitstellung von komplexer neuronaler Netzmodelle, die in gängigen Frameworks wie TensorFlow, PyTorch und MXNet erstellt und trainiert wurden, unter Verwendung von Inf1-Instances. Mit der NeuronCore-Pipeline können Sie große Modelle zur Ausführung auf mehrere Inferentia-Chips aufteilen, indem ein sehr schneller physikalischer Chip-to-Chip-Interconnect verwendet wird. Dadurch werden ein hoher Inferenzdurchsatz und niedrigere Inferenzkosten erreicht.

Hochleistungsnetzwerk und -speicher

Inf1-Instances bieten einen Netzwerkdurchsatz von bis zu 100 Gbit/s für Anwendungen, die Zugang zu Hochgeschwindigkeitsnetzwerken benötigen. Elastic Network Adapter (ENA) und NVM Express (NVMe)-Technologie der nächsten Generation bieten Inf1-Instances mit Schnittstellen mit hohem Durchsatz und geringer Latenz für Netzwerke und Amazon Elastic Block Store (Amazon EBS).

Mit AWS Nitro System entwickelt

Das AWS Nitro-System ist eine umfangreiche Sammlung von Modulbausteinen, die viele der herkömmlichen Virtualisierungsfunktionen auf spezielle Hard- und Software auslagern, sodass hohe Leistung, Verfügbarkeit und Sicherheit bei gleichzeitig geringerem Virtualisierungsaufwand gewährleistet werden.

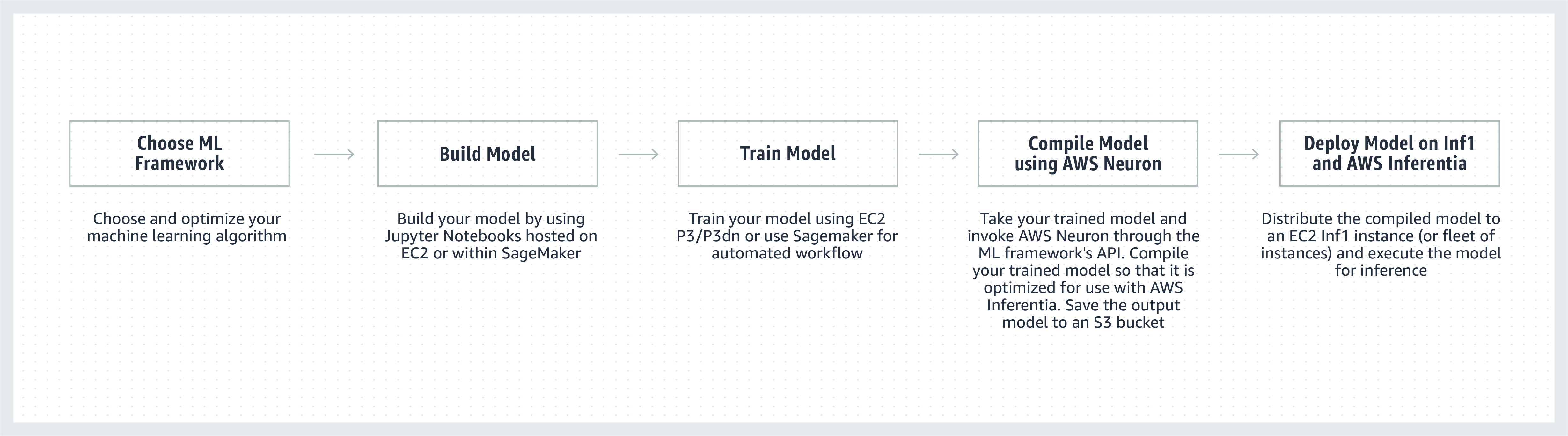

Funktionsweise

Kundenempfehlungen

„Wir integrieren ML in viele Aspekte von Snapchat und die Erforschung von Innovationen in diesem Bereich hat für uns oberste Priorität. Als wir von Inferentia hörten, begannen wir, mit AWS zusammenzuarbeiten, um Inf1-/Inferentia-Instances einzuführen, die uns bei der Bereitstellung von ML helfen sollten, auch im Hinblick auf Leistung und Kosten. Wir haben mit unseren Empfehlungsmodellen begonnen und freuen uns darauf, in Zukunft weitere Modelle mit den Inf1-Instances einzuführen."

Nima Khajehnouri, VP Engineering, Snap Inc.

„Die KI-gesteuerte Unified Customer Experience Management (Unified-CXM, einheitliches Kundenerlebnis-Management)-Plattform von Sprinklr ermöglicht es Unternehmen, Kundenfeedback in Echtzeit über mehrere Kanäle hinweg zu sammeln und in verwertbare Erkenntnisse umzuwandeln – mit dem Ergebnis einer proaktiven Problemlösung, einer verbesserten Produktentwicklung, eines verbesserten Content-Marketings, eines besseren Kundenservices und mehr. Mit Amazon EC2 Inf1 könnten wir die Leistung einer unserer NLP-Modelle wesentlich steigern und auch die Leistung eines unserer Computer-Vision-Modelle verbessern. Wir freuen uns darauf, weiterhin Amazon EC2 Inf1 zu verwenden, um unsere globalen Kunden besser unterstützen zu können.“

Vasant Srinivasan, Senior Vice President of Product Engineering, Sprinklr

„Unser hochmodernes NLP-Produkt, Finch for Text, bietet den Anwendern die Möglichkeit, mehrere Arten von Entitäten in großen Textmengen zu extrahieren, zu disambiguieren und anzureichern. Finch for Text erfordert beträchtliche Rechenkapazitäten, um unseren Kunden Anreicherungen mit geringer Latenzzeit auf globalen Datenfeeds anbieten zu können. Wir verwenden jetzt AWS-Inf1-Instances in unseren PyTorch-NLP-, Übersetzungs- und Entity-Disambiguierungsmodellen. Wir waren in der Lage, unsere Inferenzkosten mit minimalen Optimierungen um über 80 % zu senken (im Vergleich zu GPUs), während wir unsere Inferenzgeschwindigkeit und -leistung beibehielten. Diese Weiterentwicklung ermöglicht es unseren Kunden, ihre Texte in französischer, spanischer, deutscher und niederländischer Sprache in Echtzeit in Streaming-Datenfeeds und auf globaler Ebene anzureichern – das ist für unsere Kunden aus den Bereichen Finanzdienstleistungen, Datenaggregatoren und öffentlicher Sektor von entscheidender Bedeutung.“

Scott Lightner, Chief Technology Officer, Finch Computing

„Wir informieren über viele Arten von Ereignissen auf der ganzen Welt in vielen Sprachen und in verschiedenen Formaten (Bilder, Video, Audio, Textsensoren, Kombinationen all dieser Typen) aus Hunderttausenden von Quellen. Angesichts dieser Größenordnung ist die Optimierung im Hinblick auf Geschwindigkeit und Kosten für unser Geschäft von entscheidender Bedeutung. Mit AWS Inferentia haben wir die Modelllatenz gesenkt und einen bis zu 9-mal besseren Durchsatz pro Dollar erzielt. Dies hat es uns ermöglicht, die Modellgenauigkeit zu erhöhen und die Fähigkeiten unserer Plattform zu erweitern, indem wir anspruchsvollere DL-Modelle einsetzen und 5-mal mehr Datenvolumen verarbeiten konnten, während wir gleichzeitig unsere Kosten unter Kontrolle hielten.“

Alex Jaimes, Chief Scientist und Senior Vice President of AI, Dataminr

„Autodesk treibt die kognitive Technologie unseres KI-gestützten virtuellen Assistenten, Autodesk Virtual Agent (AVA), mit Hilfe von Inferentia voran. AVA beantwortet mehr als 100 000 Kundenfragen pro Monat durch Anwendung von natürlichem Sprachverständnis (NLU) und Deep Learning (DL)-Techniken, um den Kontext, die Absicht und die Bedeutung hinter den Anfragen zu extrahieren. Durch die Pilotierung von Inferentia sind wir in der Lage, einen 4,9-fach höheren Durchsatz als G4dn für unsere NLU-Modelle zu erzielen, und wir freuen uns darauf, mehr Workloads auf den Inferentia-basierten Inf1-Instances auszuführen.“

Binghui Ouyang, Sr. Data Scientist, Autodesk

Amazon-Services mit Amazon-EC2-Inf1-Instances

Amazon Advertising hilft Unternehmen jeder Größe, mit Kunden in jeder Phase ihres Einkaufs in Kontakt zu treten. Millionen von Anzeigen, darunter auch Text- und Bildanzeigen, werden täglich moderiert, klassifiziert und für ein optimales Kundenerlebnis bereitgestellt.

„Für unsere Textanzeigenverarbeitung stellen wir PyTorch-basierte BERT-Modelle weltweit auf AWS-Inferentia-basierten Inf1-Instances bereit. Durch den Wechsel von GPUs zu Inferentia konnten wir unsere Kosten bei vergleichbarer Leistung um 69 % senken. Das Zusammenstellen und Testen unserer Modelle für AWS Inferentia dauerte weniger als drei Wochen. Die Verwendung von Amazon SageMaker zur Bereitstellung unserer Modelle auf Inf1-Instances stellte sicher, dass unsere Bereitstellung skalierbar und einfach zu verwalten war. Als ich die kompilierten Modelle zum ersten Mal analysierte, war die Leistung mit AWS Inferentia so beeindruckend, dass ich die Benchmarks sogar noch einmal durchführen musste, um sicher zu sein, dass sie korrekt waren! In Zukunft möchten wir unsere Modelle zur Verarbeitung von Bildanzeigen auf Inferentia migrieren. Wir haben für diese Modelle bereits eine um 30 % niedrigere Latenz und 71 % Kosteneinsparungen gegenüber vergleichbaren GPU-basierten Instances ermittelt.”

Yashal Kanungo, Applied Scientist, Amazon Advertising

Den News-Blog lesen »

„Die KI- und ML-basierte Intelligenz von Amazon Alexa, unterstützt von AWS, ist heute auf mehr als 100 Millionen Geräten verfügbar – und unser Versprechen an die Kunden ist, dass Alexa immer intelligenter, gesprächiger, proaktiver und noch erfreulicher wird. Um dieses Versprechen zu halten, müssen die Antwortzeiten und die ML-Infrastrukturkosten kontinuierlich verbessert werden. Deshalb freuen wir uns, Amazon EC2 Inf1 zu nutzen, um die Inferenz-Latenzzeit und die Kosten pro Inferenz bei Alexa Text-to-Speech zu senken. Mit Amazon EC2 Inf1 werden wir in der Lage sein, den Service für die zig Millionen Kunden, die Alexa jeden Monat nutzen, noch besser zu machen.“

Tom Taylor, Senior Vice President, Amazon Alexa

„Wir führen kontinuierlich Innovationen durch, um unser Kundenerlebnis weiter zu verbessern und die Infrastrukturkosten zu senken. Der Übergang unserer webbasiertes Frage-Antwort-System (WBQA)-Workloads von GPU-basierten P3-Instances zu AWS-Inferentia-basierten Inf1-Instances hat uns nicht nur dabei geholfen, die Inferenzkosten um 60 % zu senken, sondern verbesserte auch die durchgängige Latenz um mehr als 40 %. Das hilft dabei, das Frage-und-Antwort-Erlebnis mit Alexa zu verbessern. Die Nutzung von Amazon SageMaker für unser Tensorflow-basiertes Modell vereinfachte den Prozess des Übergangs zu Inf1-instances und leicht handhabbar. Wir nutzen nun Inf1-Instances weltweit, um diese WBQA-Workloads auszuführen und wir optimieren ihre Leistung für AWS Inferentia, um die Kosten und die Latenz weiterhin zu senken.“

Eric Lind, Software Development Engineer, Alexa AI

„Amazon Prime Video verwendet ML-Modelle zur Analyse der Videoqualität von Live-Events, um ein optimales Zuschauererlebnis für Mitglieder von Prime Video zu gewährleisten. Wir haben unsere ML-Modelle zur Bildklassifizierung auf Inf1-Instances von EC2 eingesetzt und konnten eine vierfache Leistungssteigerung und Kosteneinsparungen von bis zu 40 % feststellen. Wir wollen diese Kosteneinsparungen jetzt nutzen, um Innovationen zu entwickeln und fortschrittliche Modelle zu erstellen, die komplexere Fehler wie Synchronisationslücken zwischen Audio- und Videodateien erkennen können, um den Mitgliedern von Prime Video ein noch besseres Erlebnis beim Ansehen zu bieten.“

Victor Antonino, Solutions Architect, Amazon Prime Video

„Amazon Rekognition ist eine einfache und leichte Anwendung zur Bild- und Videoanalyse, die den Kunden hilft, Objekte, Personen, Texte und Aktivitäten zu identifizieren. Amazon Rekognition benötigt eine leistungsstarke DL-Infrastruktur , die täglich Milliarden von Bildern und Videos für unsere Kunden analysieren kann. Bei AWS-Inferentia-basierten Inf1-Instances führte die Ausführung von Amazon-Rekognition-Modellen wie z. B. der Objektklassifikation zu einer 8-mal geringeren Latenz und einem 2-mal geringeren Durchsatz im Vergleich zur Ausführung dieser Modelle auf GPUs. Auf der Grundlage dieser Ergebnisse stellen wir Amazon Rekognition auf Inf1 um, sodass unsere Kunden schneller genaue Ergebnisse erhalten.“

Rajneesh Singh, Director, SW Engineering, Amazon Rekognition and Video

Preise

* Die angegebenen Preise gelten in der AWS-Region USA Ost (Nord-Virginia). Preise für Reserved Instances für 1 Jahr und 3 Jahre gelten für Bezahloptionen mit teilweiser Vorauszahlung oder, im Fall von instances ohne die Option der teilweisen Vorauszahlung, ohne Vorauszahlung.

Amazon EC2-Inf1-Instances sind als On-Demand, Reserved oder Spot-Instances in den AWS Regionen USA Ost (Nord-Virginia) und USA West (Oregon) verfügbar.

Erste Schritte

Amazon SageMaker verwenden

SageMaker macht es Ihnen leicht, Ihr trainiertes ML-Modell in der Produktion auf Amazon-Inf1-Instances zu kompilieren und bereitzustellen, damit Sie mit der Generierung von Echtzeit-Prognosen mit niedriger Latenz beginnen können. AWS Neuron, der Compiler für AWS Inferentia, ist in Amazon SageMaker Neo integriert und hilft Ihnen, Ihre trainierten ML-Modelle so zu kompilieren, dass sie optimal auf Inf1-Instances ausgeführt werden. Mit SageMaker können Sie Ihre Modelle problemlos auf Auto-Scaling-Clustern von Inf1-Instances, die über mehrere Availability Zones verteilt sind, ausführen lassen, um sowohl höchste Leistungen als auch Echtzeit-Inferenzen mit höchster Verfügbarkeit zu liefern. Lernen Sie mit Beispielen auf Github, wie Sie SageMaker für Inf1 bereitstellen können.

Verwenden von DLAMI

DLAMI bietet ML-Praktikern und -Forschern die Infrastruktur und die Werkzeuge, um DL in der Cloud zu beschleunigen, und zwar in jeder Größenordnung. Das AWS Neuron SDK ist in DLAMI vorinstalliert, um Ihre ML-Modelle optimal auf Inf1-Instances zu kompilieren und auszuführen. Sehen Sie sich für die ersten Schritte den AMI-Auswahlleitfaden und weitere DL-Ressourcen an. Im Handbuch zu den ersten Schritten mit AWS DLAMI erfahren Sie, wie das DLAMI mit Neuron verwendet wird.

Verwenden von Deep Learning Containers

Entwickler können jetzt Inf1-Instances in Amazon EKS, einem vollständig verwalteten Kubernetes-Service, sowie in Amazon ECS, einem vollständig verwalteten Container-Orchestrierungsdienst von Amazon, bereitstellen. Erfahren Sie mehr über die ersten Schritte mit Inf1 in Amazon EKS oder mit Amazon ECS. Weitere Einzelheiten zum Ausführen von Containern auf Inf1-Instances finden Sie auf der Tutorial-Seite für Neuron-Container-Tools. Neuron ist auch in AWS Deep Learning Containers vorinstalliert verfügbar.

Blogs und Artikel

Wie Amazon Search mit AWS Inferentia die Kosten für ML-Inferenzen um 85 % reduzierte

von Joao Moura, Jason Carlson, Jaspreet Singh, Shaohui Xi, Shruti Koparkar, Haowei Sun, Weiqi Zhang und Zhuoqi Zhangs, 22.09.2022

von MIT Technology Review Insights, 01.11.2021

von Davide Galliteli und Hasan Poonawala, 19.10.2021

Machine Learning in der Cloud hilft Unternehmen bei der Innovation

von MIT Technology Review Insights, 15.10.2021

von Alex Iankoulski, Joshua Correa, Mahadevan Balasubramaniam und Sundar Ranganatha, 30.09.2021

von Fabio Nonato de Paula und Mahadevan Balasubramaniam, 04.05.2021

von Binghui Ouyang, 07.04.2021

Die Mehrheit von Alexa läuft jetzt auf schnelleren, kostengünstigeren Amazon EC2-Inf1-Instances

von Sébastien Stormacq, 12.11.2020

Amazon ECS unterstützt jetzt EC2-Inf1-Instances

von Julien Simon, 14.08.2020

von Fabio Nonato De Paula und Haichen Li, 22.07.2020

Amazon EKS now supports EC2 Inf1 instances

von Julien Simon, 15.06.2020