亚马逊AWS官方博客

新增功能 – Amazon AppFlow 正式发布

软件即服务 (SaaS) 应用程序对客户的重要性不断提升,对此类应用程序的采用也在快速增长。尽管这种软件使用方式具有许多的优势,但一个挑战是现在的数据存在于许多不同的位置。要利用此数据获得有意义的见解,我们需要能够对它进行分析,如果我们的数据分散于多个不同的数据孤岛中,分析将变得十分困难。

开发人员花费了大量的时间来编写自定义的集成,以便他们可以在 SaaS 应用程序和 AWS 服务之间传输数据,并进而可以对数据进行分析;这种操作的成本可能十分高昂,并且经常需要数月时间才能完成。如果数据需求发生变化,那么又不得不对集成进行成本高昂且复杂的修改。企业如果没有充裕的工程人员,可能发现他们难以从应用程序手动导入和导出数据,因为这些手动操作十分耗时、存在泄漏数据的风险并且有可能会引入人为的错误。

今天,我很高兴地宣布我们推出了一项叫做 Amazon AppFlow 的新服务,让此问题迎刃而解。借助 Amazon AppFlow,您可以实现 AWS 服务和 SaaS 应用程序(例如 Salesforce、Zendesk 和 ServiceNow)之间的数据流的自动化。SaaS 应用程序管理员、业务分析师和商业智能 (BI) 专业人员无需花费数月时间等待 IT 部门完成集成项目,即可快速实施所需的大多数集成。

除运行将数据从 SaaS 应用程序传入 AWS 服务外,此服务还能够将数据从 AWS 服务发送到 SaaS 应用程序。AWS 始终将安全性放在工作的首位,因此所有传输中的数据都执行加密。一些 SaaS 应用程序已经与 AWS PrivateLink 集成,这提供了额外的安全性和隐私保护层。当数据通过 AWS PrivateLink 在 SaaS 应用程序和 AWS 之间流动时,数据流量将始终位于 Amazon 网络中,而不使用公共互联网。如果 SaaS 应用程序支持,Amazon AppFlow 将会自动负责这一连接,让每个人都可以方便地进行私有数据传输,减少来自基于互联网的攻击的威胁以及泄漏敏感数据的风险。

您可以根据业务事件按计划传输数据,也可按需传输数据,从而让您在共享数据时兼具速度和灵活性。

为了证明此新服务的强大能力,我将为大家演示一个简单的流。

我将在英国和爱尔兰为 Web 社区组织者运行一个 Slack 工作区。由于 Slack 是 Amazon AppFlow 中支持的 SaaS 应用程序之一,我计划尝试将一些对话数据导入 S3。将数据导入 S3 后,我可以使用 Amazon Athena 来分析该数据,最后我将使用 Amazon QuickSight 创建一个可视化项。

首先,我前往 Amazon AppFlow 控制台并单击创建流按钮。

然后我会输入流名称和流描述。此外还有一些关于数据加密的选项。默认情况下,所有数据都启用传输中加密,对于 S3 则还将启用静态加密。您可以选择提供自己的加密密钥,但对于本演示,我将使用我账户中默认使用的密钥。

在这一步,您哈可以为资源输入标签,我习惯将我账户中的演示基础设施标记为 Demo,从而方便我知道我可以删除哪些资源。

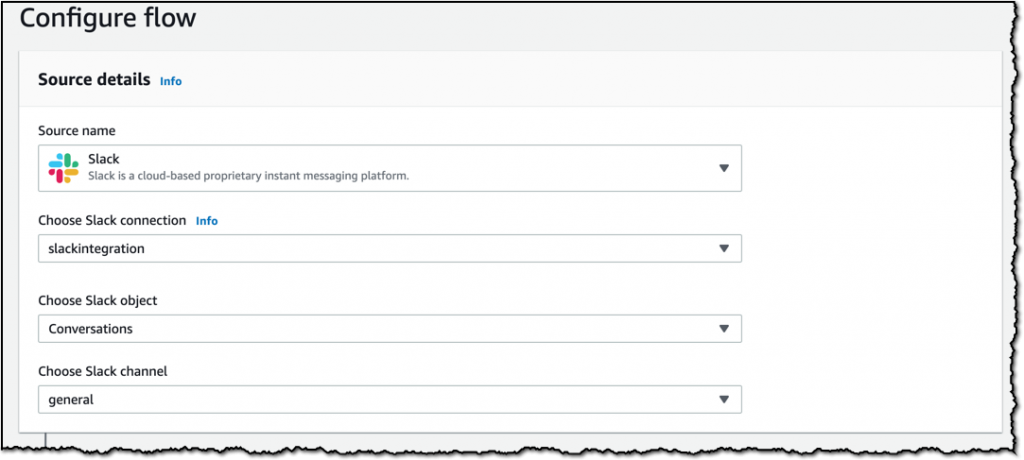

下一步我将选择我的数据源。我会选择 Slack 并按向导提示操作以建立到我的 Slack 工作区的连接。此外我还会选择我希望从我的 Slack 工作区导入的数据。我在 general Slack 频道中选择了 Conversations 对象。这将导入发布到 general 频道的任何消息,然后将消息发送到我在下一步配置的目标位置。

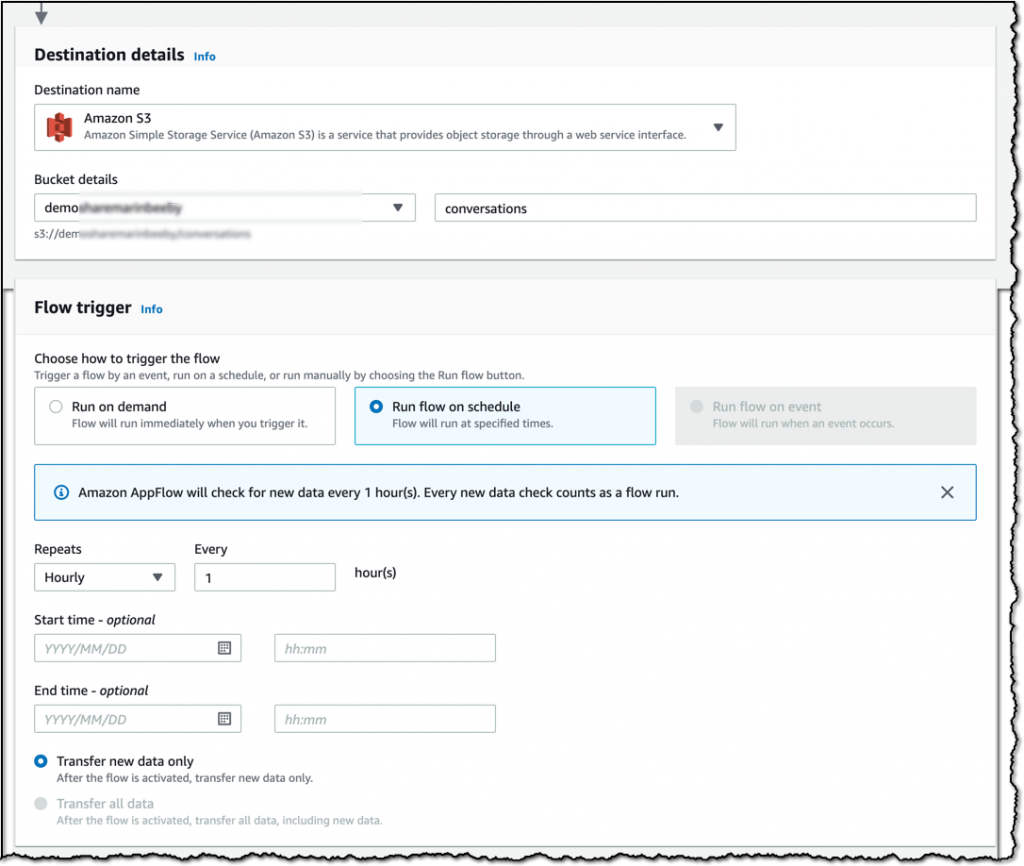

我可以从多个目标中选择,但为简便起见,我要求将数据发送到一个 S3 存储桶。此外,我还将在这一步设置提取数据的频率。我希望每小时检索一次数据,因此我选择了按计划运行流并进行了必要的配置。Slack 可以按需触发或按计划触发;某些其他资源也可按特定的事件(例如在 Salesforce 中转化销售线索)触发。

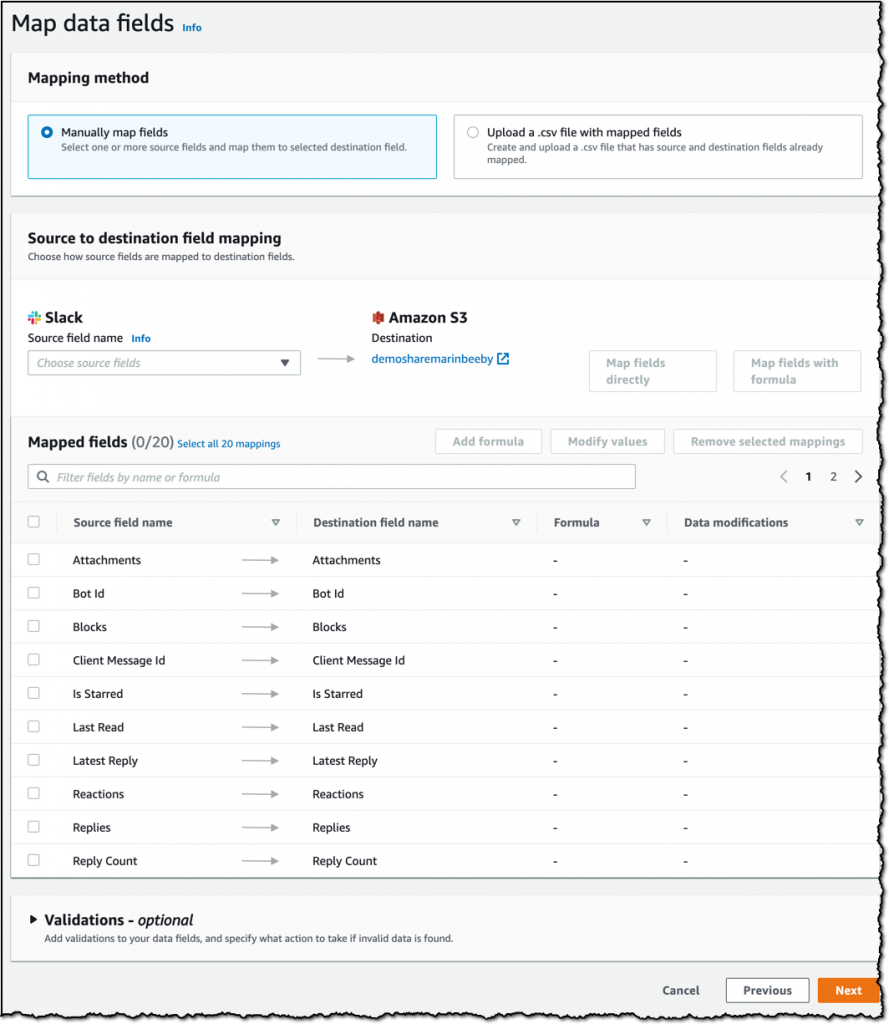

下一步将是映射数据字段,我将使用默认值,当然您也可以对此进行自定义并合并字段,或者仅选择分析所需的特定字段。

现在流已经成功创建并且我已经激活了它;它会自动每隔一个小时运行一次,自动将新数据添加到我的 S3 存储桶。

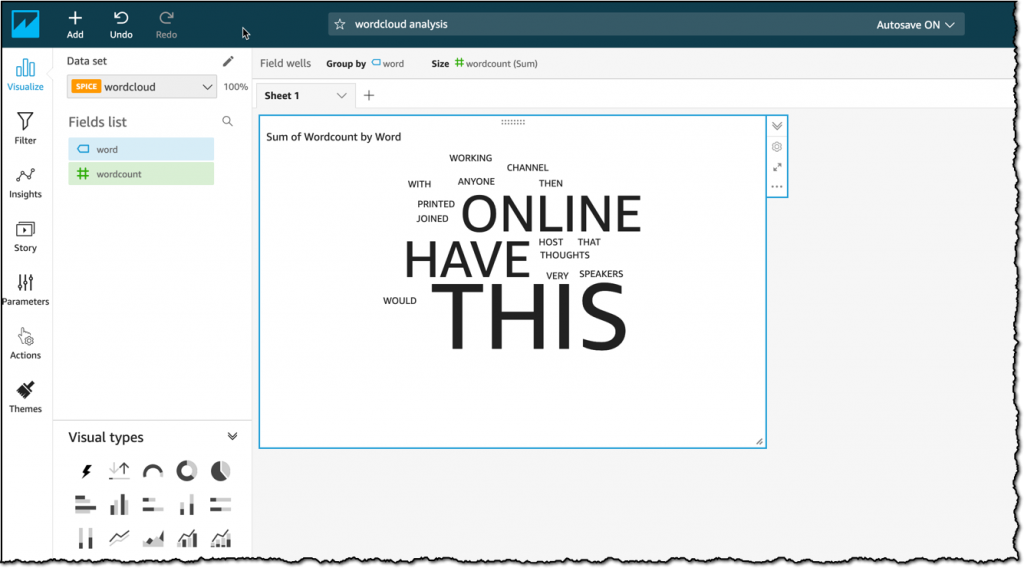

我不会涉及 Amazon Athena 或 Amazon QuickSight 的细节,但使用了这两项 AWS 服务来提取存储在 S3 中的数据并利用在我的 Slack 频道中使用的最常用词生成一个文字云。

Athena 的神奇之处在于您可以直接对 S3 中的加密数据运行 SQL 查询,无需任何额外的数据仓库。您可以在下图中看到结果。我现在可以轻松以控制面板的方式与我组织内的任何人共享此结果。

Amazon AppFlow 今天正式发布并支持将 S3 和 13 种 SaaS 应用程序作为数据源,以及将 S3、Amazon Redshift、Salesforce 和 Snowflake 作为目标。随着此服务的发展,我们还将增加数百种数据源和目标。

此服务会自动根据置放的需求扩展或缩减,此外还运行您在单个流中传输 100GB 的数据,这意味着您无需将数据切分为多个批次。您可以放心将最宝贵的数据委托给 Amazon AppFlow,因为我们的架构采用高可用性和恢复能力设计。

Amazon AppFlow 现已在下列区域开放:美国东部(弗吉尼亚北部)、美国东部(俄亥俄)、美国西部(加利福尼亚北部)、美国西部(俄勒冈)、加拿大(中部)、亚太地区(新加坡)、亚太地区(东京)、亚太地区(悉尼)、亚太地区(首尔)、亚太地区(孟买)、欧洲(巴黎)、欧洲(爱尔兰)、欧洲(法兰克福)、欧洲(伦敦)以及南美洲(圣保罗),更多区域也将很快推出。

祝大家数据流顺利