AWS Germany – Amazon Web Services in Deutschland

Neue AWS Werkzeuge zur Nutzung Generativer KI

von Swami Sivasubramanian, übersetzt von Tobias Nitzsche

Die Grundlagen für einen Paradigmenwechsel im Maschinenlernen (ML) existieren seit Jahrzehnten, doch erst mit der heutigen Verfügbarkeit skalierbaren Rechenkapazität, einer anhaltenden Datenexplosion und der rasanten Fortschritte im Bereich ML beginnen Kund:innen verschiedener Branchen, ihre Geschäfte zu transformieren. Neulich erst haben generative KI-Anwendungen wie ChatGPT weitreichend Aufmerksamkeit und Vorstellungskraft erregt. Wir befinden uns tatsächlich an einem spannenden Wendepunkt bei der breiten Einführung von ML, und wir glauben, dass die meisten Kundenerlebnisse und Anwendungen mit generativer KI neu erfunden werden.

KI und ML sind schon seit mehr als 20 Jahren ein Fokus von Amazon. Viele der Funktionen, die Kund:innen von Amazon täglich nutzen werden von ML unterstützt: Unser E-Commerce-Empfehlungs-Engine wird von ML unterstützt; Die Routen, die unsere Pick-Roboter in unseren Logistikzentren fahren, werden mit Hilfe von ML optimieren; Unsere Lieferkette, Prognosen und Kapazitätsplanung basieren auf ML; Prime Air (unsere Drohnen) und die Computervisiontechnologie für Amazon Go (unsere physische Einzelhandelserfahrung, die es Verbraucher:innen ermöglicht, Artikel aus dem Regal zu nehmen und den Laden ohne formellen Bezahlvorgang an einer Kasse zu verlassen) nutzen Deep Learning; Alexa, unterstützt von mehr als 30 verschiedenen ML-Systemen, hilft Kund:innen milliardenfach pro Woche dabei, Smart Homes zu steuern, einzukaufen, Informationen und Unterhaltung zu erhalten und vieles mehr. Wir haben Tausende von Ingenieuren und Ingenieurinnen bei Amazon, die sich dem ML verschrieben haben. ML ist ein großer Teil unser Vergangenheit, unseres aktuellen Ethos und unserer Zukunft.

Bei AWS haben wir hart daran gearbeitet, maschinelles Lernen (ML) für alle, die es nutzen möchten verfügbar zu machen – einschließlich über 100.000 unserer Kunden aus verschiedenen Branchen und Unternehmen jeder Größe. AWS verfügt über das umfassendste und tiefgreifendste Portfolio an KI- und ML-Diensten auf allen drei Ebenen des Stacks.

Wir haben Geld investiert und kreative Ideen entwickelt, um eine starke und anpassungsfähige Infrastruktur zu schaffen. Auf dieser Basis können nun Alle maschinelles Lernen kostengünstig trainieren und nutzen; Wir haben Amazon SageMaker entwickelt, was für alle Entwickler:innen der einfachste Weg ist, Modelle zu bauen, zu trainieren und einzusetzen; Wir haben eine breite Palette von Diensten entwickelt, die es Kund:innen ermöglichen, KI-Funktionen wie Bilderkennung, Prognosen und intelligente Suchen mit einem einfachen API-Aufruf zu ihren Anwendungen hinzuzufügen. Das ist der Grund, warum Kunden wie Intuit, Thomson Reuters, AstraZeneca, Ferrari, Bundesliga, 3M und BMW, sowie Tausende von Start-ups und Regierungsbehörden weltweit sich selbst, ihre Branchen und ihre Aufgaben mit ML transformieren.

Wir verfolgen denselben demokratisierenden Ansatz für generative KI: Wir arbeiten daran, diese Technologien aus dem Bereich der Forschung und Versuche zu holen und ihre Verfügbarkeit weit über eine Handvoll Start-ups und große, gut finanzierte Technologieunternehmen hinaus zu erweitern.

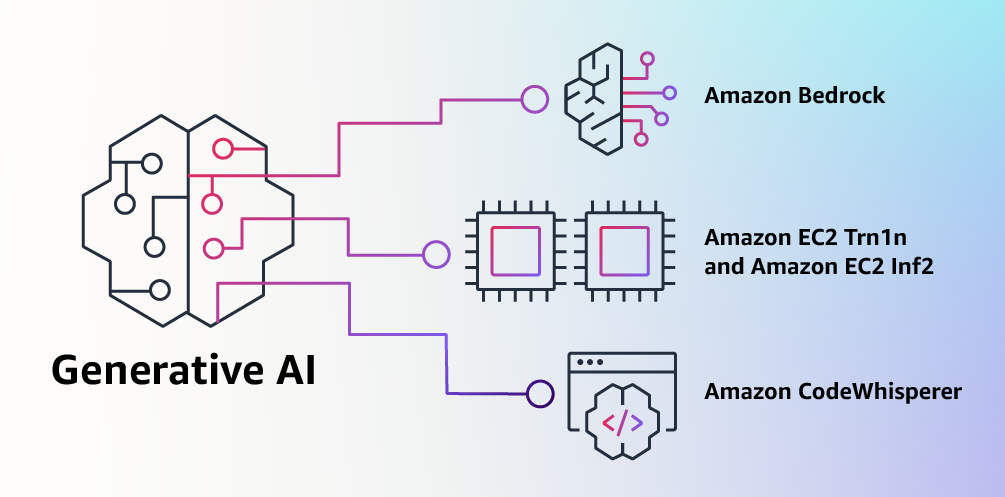

Deshalb freue ich mich heute, mehrere neue Innovationen ankündigen zu können, die es unseren Kund:innen leichter machen werden, generative KI in ihren Unternehmen zu nutzen.

Tools zur Nutzung Generativer KI mit AWS

Generative KI und Grundlagenmodelle

Generative KI ist eine Art von KI, die neue Inhalte und Ideen erzeugen kann, einschließlich Gespräche, Geschichten, Bilder, Videos und Musik. Wie alle KI wird generative KI von ML-Modellen getrieben – sehr große Modelle, die auf riesigen Datenmengen vortrainiert wurden und üblicherweise als Grundlagenmodelle (engl. “foundation model” – FM) bezeichnet werden. Jüngste Fortschritte im ML (insbesondere die Erfindung der Transformer-basierten neuronalen Netzwerkarchitektur) haben zur Entstehung von Modellen geführt, die Milliarden von Parametern oder Variablen enthalten.

Um einen Eindruck von der Änderung des Maßstabs zu geben: das größte vortrainierte Modell im Jahr 2019 war lediglich 330 Millionen Parameter groß. Heute sind die größten Modelle mehr als 500 Milliarden Parameter groß – eine 1.600-fache Steigerung der Größe in nur wenigen Jahren. Die heutigen FMs, wie die großen Sprachmodelle (engl. “large Language models” – LLM) GPT3.5 oder BLOOM, und das Text-zu-Bild-Modell Stable Diffusion von Stability AI, können eine Vielzahl von Aufgaben aus verschiedenenDomänen ausführen, wie zum Beispiel das Verfassen von Blogposts, das Generieren von Bildern, das Lösen von Matheaufgaben, das Führen von Dialogen, sowie das Beantworten von Fragen auf Basis eines Dokuments.

Die Größe und Allgemeingültigkeit von FMs unterscheidet sie von traditionellen ML-Modellen, die in der Regel spezifische Aufgaben erledigen, wie zum Beispiel das Analysieren von Texten auf Stimmungen, oder die Klassifizierung von Bildern, sowie das Prognostizieren von Trends.

FMs können sich so vieler weitere Aufgaben annehmen, da sie eine so große Anzahl von Parametern enthalten. Durch diese sind sie in der Lage, komplexe Konzepte zu erlernen. Da das Vortraining von FMs internetweit verbreiteten Daten in verschiedenen Formen, sowie einer Unzahl von Mustern beinhaltet, können fertige FMs in einer Vielzahl von Kontexten zur Anwendung kommen.

Während die Fähigkeiten und daraus resultierenden Möglichkeiten eines vortrainierten FMs erstaunlich sind, sind Kund:innen wirklich begeistert, da diese allgemein fähigen Modelle auch für domänenspezifische Funktionen angepasst werden können. Vortrainierte FMs lassen sich vergleichsweise einfach und nur mit einem Bruchteil der Daten und Rechenleistung, die erforderlich wären, um ein neues Modell von Grund auf neu zu trainieren, für einzelne Unternehmen und Anwendungen anpassen. Die angepassten FMs können ein einzigartiges Kund:innen-Erlebnis schaffen, das die Stimme, den Stil und die Dienstleistungen des Unternehmens in einer Vielzahl von Verbraucherindustrien, wie Banken, Reisen und Gesundheitswesen, verkörpert. So kann beispielsweise ein Finanzunternehmen, das einen täglichen Aktivitätsbericht für den internen Umlauf unter Verwendung aller relevanten Transaktionen automatisch generieren muss, ein Modell mit firmeneigenen Daten anpassen, die frühere Berichte enthalten, so dass das FM lernt, wie diese Berichte strukturiert wurden und welche Daten zur Verwendung kamen.

Das Potential von FMs ist unglaublich spannend. Aber wir befinden uns noch in den allerersten Tagen. Während ChatGPT die erste weit verbreitete generative KI-Erfahrung war, die Kund:innen aufmerksam gemacht hat, haben die meisten Leute, die generative KI studieren, schnell erkannt, dass mehrere Unternehmen seit Jahren an FMs arbeiten und es mehrere verschiedene FMs gibt – jedes mit seinen eignen Stärken und Eigenschaften. Wie wir es im Laufe der Jahre bei schnell fortschreitenden Technologien und in der Entwicklung des ML gesehen haben, ändern sich die Dinge sehr schnell.

Wir erwarten, dass in der Zukunft neue Architekturen entstehen werden, und die Vielfalt von FMs eine Welle von Innovationen auslösen wird. Bereits heute sehen wir völlig neue Anwendungserfahrungen. AWS-Kund:innen haben uns gefragt, wie sie schnell das nutzen können, was heute verfügbar ist (und was eventuell kommen wird) und schnell mit der Nutzung von FMs und generativer KI in ihren Unternehmen und Organisationen beginnen können, um neue Produktivitätsniveaus zu erreichen und ihr Angebot zu transformieren.

Ankündigung der Amazon Bedrock- und Amazon Titan-Modelle. Der einfachste Weg zum Aufbau und zur Skalierung generativer KI-Anwendungen mit FMs.

Kund:innen teilten uns mit, dass heute einige große Hindernisse in ihrem Weg stehen: Zunächst benötigen sie einen unkomplizierten Weg, um leistungsfähige FMs, die hervorragende Ergebnisse liefern und am besten für ihre Zwecke geeignet sind, zu finden und darauf zuzugreifen. Zweitens möchten Kund:innen eine nahtlose Integration in ihre Anwendungen, ohne riesige Infrastrukturcluster verwalten oder hohe Kosten verursachen zu müssen. Schließlich möchten Kund:innen auch, dass es einfach ist, die Basis-FMs zu nutzen um verschiedene Anwendungen mit ihren eigenen Daten (wenig oder viel) zu erstellen.

Da die Daten, die Kund:innen für die Anpassung verwenden möchten, unglaublich wertvolles geistiges Eigentum sind, müssen sie während dieses Prozesses vollständig geschützt, sicher und privat bleiben. Unsere Kund:innen möchten starke Kontrolle darüber haben, wie ihre Daten geteilt und genutzt werden.

Wir haben all dieses Feedback von Kund:innen aufgenommen, und freuen uns heute Amazon Bedrock [EN] anzukündigen. Ein neuer Service, der FMs von AI21 Labs, Anthropic, Stability AI und Amazon über eine API zugänglich macht. Bedrock ist für Kund:innen der einfachste Weg, generative-KI-basierte Anwendungen mit FMs zu erstellen und zu skalieren und demokratisieret somit den Zugang für alle Entwickler:innen.

Bedrock bietet mittels eines skalierbaren, zuverlässigen und sicheren von AWS verwalteten Service, nun die Möglichkeit, auf eine Reihe von leistungsstarken FMs für Text und Bilder zuzugreifen – einschließlich der Titan-FMs von Amazon [EN], die aus zwei neuen LLM bestehen, die wir ebenfalls heute ankündigen. Durch Bedrocks serverloser Anwendung können Kund:innen einfach das richtige Modell für ihr aktuelles Projekt finden. So können sie schnell starten, FMS für sich mit ihren eigenen Daten anzupassen und diese einfach in ihre Anwendungen mit den ihnen vertrauten AWS-Tools und -Funktionen, zu integrieren und bereitstellen – und das alles ganz ohne Infrastruktur verwalten zu müssen (einschließlich Integrationen mit Amazon SageMaker ML-Funktionen wie “Experiments” zum Testen verschiedener Modelle und Pipelines zur Verwaltung ihrer FMs im großen Maßstab).

Amazon Bedrock-Kund:innen können aus vielen der fortschrittlichsten, heute verfügbaren FMs wählen. Dies beinhaltet die Jurassic-2-Familie von mehrsprachigen LLM von AI21 Labs, welche natürlichen Sprachanweisungen folgen, um Text in Spanisch, Französisch, Deutsch, Portugiesisch, Italienisch oder Niederländisch zu erzeugen. Claude, Anthropic’s LLM, kann eine Vielzahl von Gesprächs- und Textverarbeitungsaufgaben ausführen und basiert auf Anthropic’s umfangreicher Forschung zur Erstellung ehrlicher und verantwortungsbewusster KI-Systeme. Amazon Bedrock erleichtert auch den Zugang zu Stability AI’s Familie von Text-zu-Bild-FMs, einschließlich Stable Diffusion (dem beliebtesten seiner Art), was in der Lage ist, einzigartige, realistische und hochwertige Bilder, Kunst, Logos und Designs zu erzeugen.

Eine der wichtigsten Fähigkeiten von Bedrock ist die einfache Anpassung eines FM.

Kund:innen weisen Bedrock einfach auf einige vorgefertigte Beispiele in Amazon S3, und der Service kann das gewählte Modell für eine bestimmte Aufgabe abstimmen – ohne dass Kund:innen große Mengen von Daten annotieren müssen (schon 20 Beispiele genügen).

Ein Beispiel: Stellen Sie sich vor, sie sind ein:e Content-Marketing-Manager:in, der/die bei einem großen Modehändler arbeitet und neue, gezielte Anzeigen- und Kampagnentexte für eine bevorstehende Handtaschenlinie entwickeln muss. Um dies zu erreichen, stellen Sie Amazon Bedrock einige anmontierte Beispiele ihrer leistungsstärksten Slogans, sowie die dazugehörigen Produktbeschreibungen, aus Ihren vergangenen Kampagnen zur Verfügung.

Bedrock erstellt eine separate Kopie des FMs, welches nur für Sie zugänglich ist. Anschließend trainiert es Ihre private Kopie des Modells. Nach dem Training beginnt Bedrock automatisch, effektive Social-Media Post, Werbeanzeigen und Websites für die neuen Handtaschen zu generieren.

Keine Ihrer Kundendaten wird verwendet, um die ursprünglichen FMs zu trainieren. Sie können darauf vertrauen, dass Ihre Kundendaten privat und vertraulich bleiben, da all Ihre Daten verschlüsselt sind und zudem Ihre Virtual Private Cloud (VPC) nicht verlassen können.

Bedrock befindet sich aktuell in einer begrenzten Vorschau, und Kund:innen wie Coda [EN, Extern] sind begeistert, wie schnell sie von ihre Entwicklungsteams in Betrieb genommen werden können. Shishir Mehrotra, Mitbegründer und CEO von Coda: „Als langjährige und zufriedene AWS-Kunden freuen wir uns, wie Amazon Bedrock Qualität, Skalierbarkeit und Leistung für Coda AI erbringen kann. Da alle unsere Daten bereits auf AWS liegen, können wir schnell generative KI mit Bedrock einbinden, mit all der Sicherheit und Privatsphäre, die wir zum Schutz unserer Daten benötigen. Mit Zehntausenden von Teams, die auf Coda arbeiten, einschließlich großer Teams wie Uber, die New York Times und Square, sind Zuverlässigkeit und Skalierbarkeit wirklich wichtig für uns.“

Wir haben Amazons neue Titan-FMs mit einigen Kund:innen getestet, bevor wir sie in den kommenden Monaten breiter zugänglich machen werden. Zunächst werden wir zwei Titan-Modelle anbieten: Das erste ist ein generatives LLM für Aufgaben wie Zusammenfassung, Texterzeugung (zum Beispiel das Erstellen eines Blog-Posts), Klassifizierung, offene Fragen und Antworten und Informationsentnahme. Das zweite ist ein Einbettungs-LLM, das Texteingaben (Wörter, Phrasen oder möglicherweise große Texteinheiten) in numerische Darstellungen (bekannt als Einbettungen) übersetzt, die die semantische Bedeutung des Textes enthalten. Während dieses LLM keinen Text generiert, ist es nützlich für Anwendungen wie Personalisierung und Suche. Durch den Vergleich von Einbettungen wird das Modell in der Lage sein, bessere Antworten erzeugen als herkömmliche Word-Matching-Modelle. Amazon.de verwendet unter anderem ein ähnliches Einbettungsmodell, um unsere Kund:innen bei ihrer Suche nach Produkten besser zu unterstützen.

Um die besten Praktiken im verantwortungsvollen Umgang mit KI weiter zu unterstützen, sind Titan-FMs darauf ausgelegt, schädlichen Inhalt in den Daten zu erkennen und zu entfernen. Unangemessenen Inhalt in der Benutzereingabe wird abgelehnt und Ergebnisse der Modelle wird nach unter anderem nach Hassrede, Obszönitäten und Gewalt gefiltert.

Amazon Bedrock macht die Leistungsfähigkeit von FMs für Unternehmen aller Größen zugänglich. Bedingt durch die Vereinfachung der Implementierung für Ihre Entwickler:innen, ermöglicht Amazon Bedrock Ihnen die Nutzung von ML in ihren Organisationen zu beschleunigen und Ihre eigenen generativen KI-Anwendungen zu gestalten.

Wir glauben, dass Amazon Bedrock ein großer Schritt in Richtung Demokratisierung von FMs sein wird. Unsere Partner wie Accenture, Deloitte, Infosys und Slalom [EN, Extern] bauen bereits Prozesse auf, um andere Unternehmen bei der schnelleren Umsetzung von generativer KI zu helfen.

Unabhängige Softwareanbieter (ISVs) wie C3 AI [EN, Extern] und Pega freuen sich darauf, Amazon Bedrock als einfachen Zugang zu derer großartigen Auswahl an FMs nutzen zu können – All dies mit dem gewohnt hohen Maß an Sicherheit, Privatsphäre und Zuverlässigkeit, welches von AWS erwartet wird.

Wir freuen uns, die allgemeine Verfügbarkeit der Amazon EC2 Trn1n-Instanzen, die mit AWS Trainium betrieben werden, sowie der Amazon EC2 Inf2-Instanzen, die mit AWS Inferentia2 betrieben werden, bekannt zu geben.

Die heute kosteneffizienteste Cloud-Infrastruktur für generative KI.

Unabhängig davon, was Kund:innen mit FMs vorhaben – ob sie diese nutzen, erstellen oder anpassen möchten – benötigen sie die leistungsfähigste und kosteneffizienteste Infrastruktur, die speziell für ML konzipiert wurde. In den letzten fünf Jahren hat AWS in eigenes Silizium investiert, um die Leistung und das Preis-Leistungs-Verhältnis für anspruchsvolle Workflows wie ML-Training und Inference zu steigern.

Unsere hauseigenen AWS Trainium- und Inferentia-Chips bieten die niedrigsten Kosten für Training und Inferencing von Modellen in der Cloud. Die Fähigkeit, Leistung zu maximieren und Kosten zu kontrollieren, indem die optimale ML-Infrastruktur ausgewählt wird, ist einer der Gründe, warum führende KI-Startups wie AI21 Labs, Anthropic, Cohere, Grammarly, Hugging Face, Runway und Stability AI auf AWS setzen.

Trn1-Instanzen, betrieben mit Trainium, können gegenüber jeder anderen EC2-Instanzklasse bis zu 50% Ersparnis bei den Trainingskosten erzielen und sind, untereinander mit der zweiten Generation des Elastic Fabric Adapter (EFA) verbunden mit bis zu 800 Gbps, optimiert für die Verteilung des Trainings über mehrere Server hinweg. Kund:innen können Trn1-Instanzen in UltraClusters bereitstellen, welche auf bis zu 30.000 Trainium-Chips (insgesamt über 6 Exaflops an Rechenleistung) in der gleichen AWS-Verfügbarkeitszone (engl. “Availability Zone” – AZ) mit Petabit-Grade Netzwerk skaliert werden können.

Viele AWS-Kund:innen, einschließlich Helixon, Money Forward und das Amazon Search Team, nutzen schon heute Trn1-Instanzen, um die Trainingszeit ihrer größten Deep-Learning-Modelle von Monaten auf Wochen oder gar Tage zu reduzieren und simultan ihre Kosten zu senken. 800 Gbps ist viel Bandbreite, dennoch haben wir weitere Innovationen vorangetrieben, um noch mehr zu liefern.

Heute kündigen wir die allgemeine Verfügbarkeit von neuen, netzwerkoptimierten Trn1n-Instanzen [EN] an. Diese bieten biz zu 1600 Gbps Netzwerkbandbreite und sind für große, netzwerkintensive Modelle auf eine 20% höhere Leistung als Trn1 ausgelegt.

Heute wird Großteil an Zeit und Budget der FMs für ihr Training genutzt. Dies liegt daran, dass viele Kund:innen gerade erst beginnen, FMs in ihre Produktion einzubinden. In der Zukunft, wenn FMs im großen Maßstab eingesetzt werden, werden die meisten Kosten mit dem Betrieb der Modelle, also den Inferences entspringen. Während man ein Modell normalerweise periodisch trainiert, kann eine Produktionsanwendung ständig Vorhersagen generieren. Diese sind als Inferences bekannt und werden möglicherweise Millionenfach pro Stunde erzeugt. Inferences sollten in Echtzeit erfolgen, was sehr niedrige Latenzzeiten und hohe Netzwerkdurchsätze erfordert. Alexa ist mit Millionen von Anfragen jede Minute welche rund 40% aller Rechenkosten ausmachen ein gutes Beispiel hierfür.

Weil wir wissen, dass die meisten zukünftigen ML-Kosten aus Inferences resultieren werden, haben wir vor einigen Jahren einen Fokus auf Inference optimiertes Silizium gelegt. Im Jahr 2018 haben wir Inferentia angekündigt – den ersten speziell für Inference entwickelten Chip. Jedes Jahr hilft Inferentia Amazon dabei, Billionen von Inferences durchzuführen und hat Unternehmen wie Amazon bereits über hundert Millionen Dollar gespart.

Die Ergebnisse sind schon jetzt beeindruckend und wir sehen noch viele weitere Möglichkeiten zur weiteren Innovation. Dies ist durch weiter steigende Größe und Komplexität, sowie steigende Arbeitslasten durch die verstärkte Integration generativer KI Anwendungen durch Kund:innen bedingt.

Daher geben wir heute die allgemeine Verfügbarkeit von Inf2-Instanzen [EN], betrieben mit AWS Inferentia2, bekannt. Dies sind speziell für groß angelegte generative KI-Anwendungen mit Modellen, welche hunderte von Milliarden an Parametern enthalten, optimiert. Inf2-Instanzen liefern bis zu vier mal höheren Durchsatz und bis zu zehn mal geringere Latenz, verglichen mit früheren Inferentia-basierten Instanzen. Für die Unterstützung großer, verteilter Inferences, verfügen sie zudem über eine ultra schnelle Verbindung zwischen den einzelnen KI-Beschleunigern.

Diese Eigenschaften resultieren zusammen in einer bis zu 40% besserer Preis-Performance als vergleichbare Amazon EC2-Instanzen und den heute niedrigsten Kosten für Inference in der Cloud. Kund:innen wie Runway erleben mit Inf2, für einige ihrer Modelle, einen bis zu doppelt so hohen Durchsatz, als mit vergleichbaren Amazon EC2-Instanzen.

Diese hochleistungsfähige, kostengünstige Inference wird es Runway ermöglichen, in Zukunft noch mehr Funktionen einzuführen, komplexere Modelle einzusetzen und letztendlich ein noch besseres Kundenerlebnis für die Millionen von Entwickler:innen zu schaffen, welche Runway nutzen.

Wir freuen uns, die allgemeine Verfügbarkeit von Amazon CodeWhisperer anzukündigen. Kostenlos für einzelne Entwickler:innen.

Wir wissen, dass das Schaffen mit den richtigen FMs und das Betreiben von generativen KI-Anwendungen im großen Maßstab auf unserer, der leistungsfähigsten Cloud-Infrastruktur, für unsere Kund:innen, sowie für alle Nutzer:innen, revolutionär wird.

Mit eingebauter generativer KI können Nutzer:innen natürlichere und nahtlosere Interaktionen mit Anwendungen und Systemen haben. Denken Sie zum Beispiel an die heute selbstverständliche Funktion unserer Smartphones, diese einfach nur durch Anschauen zu entsperren, ohne etwas über die leistungsstarken ML-Modelle wissen zu müssen, die diese Features ermöglichen.

Ein Bereich, in dem wir ein schnelles Wachstum der Nutzung von generativer KI erwarten, ist das Coden. Softwareentwickler:innen verbringen heute einen erheblichen Teil ihrer Zeit mit Schreiben von Code, welcher vergleichsweise simpel und undifferenziert ist. Sie verbringen auch viel Zeit damit, Schritt zu halten mit einer komplexen und sich ständig ändernden Werkzeug- und Technologielandschaft.

All das lässt Entwickler:innen weniger Zeit, um neue, innovative Fähigkeiten und Dienste zu entwickeln. Diese versuchen aktuell, dies zu überwinden, indem sie Code-Snippets aus dem Web kopieren und modifizieren. Das kann dazu führen, dass sie unbeabsichtigt Code kopieren, welcher nicht funktioniert, Sicherheitslücken aufweist oder die Nutzung von Open-Source-Software nicht nachverfolgt. Letztlich nimmt das Suchen und Kopieren immer noch viel Zeit in Anspruch, welche ansonsten wertschöpfender genutzt werden könnte.

Generative KI kann bei dieser Aufgabe unterstützen, indem sie einen Großteil des undifferenzierten Codes “schreibt”. Generative KI kann unterstützend die Effizienz der Entwickler:innen erhöhen, da diese sich nun mehr auf die kreativeren Aspekte ihrer Arbeit konzentrieren können.

Aus diesem Grund haben wir im letzten Jahr die Vorschau von Amazon CodeWhisperer angekündigt. Amazon CodeWhisperer ist ein KI-Coding-Begleiter, der ein FM nutzt, um die Produktivität der Entwickler:innen drastisch zu verbessern. Dies gelingt durch Antworten und Code-Vorschlägen in Echtzeit resultierend auf den Kommentaren der Entwickler:innen, sowie bestehendem Code in deren Integrated Development Environment (IDE).

Entwickler:innen können also einfach CodeWhisperer bitten, eine Aufgabe zu erledigen. Zum Beispiel: „Einen CSV-String von Songs parsen”, oder “eine strukturierte Liste basierend auf Werten wie Künstler, Titel und höchster Chartplatzierung zurückzugeben”. CodeWhisperer bietet in diesem Beispiel einen Produktivitätsschub, indem er eine umfängliche Funktion generiert, die den gegeben String parst und die Liste wie angegeben zurückgibt.

Die Resonanz der Entwickler:innen auf die Vorschau war überwältigend positiv. Wir sind weiterhin davon überzeugt, dass Hilfe beim Coden eine der stärksten Anwendungen von generativer KI in den nächsten Jahren sein könnte.

Während der Vorschau haben wir eine Produktivitäts-Challenge durchgeführt, und Teilnehmer:innen, die CodeWhisperer nutzten, erledigten Aufgaben durchschnittlich 57% schneller und waren 27% wahrscheinlicher erfolgreich als diejenigen, die CodeWhisperer nicht nutzten. Dies ist ein gewaltiger Sprung in der Produktivität von Entwickler:innen, und wir sind überzeugt, dass dies erst der Anfang ist.

Heute freuen wir uns, die allgemeine Verfügbarkeit von Amazon CodeWhisperer für Python, Java, JavaScript, TypeScript und C# anzukündigen – sowie zehn weitere Sprachen, darunter Go, Kotlin, Rust, PHP und SQL. CodeWhisperer kann direkt in IDEs wie VS Code, IntelliJ IDEA, AWS Cloud9 und vielen weiteren über die jeweilige AWS-Toolkit IDE-Erweiterung genutzt werden. CodeWhisperer ist zudem auch in der AWS Lambda-Konsole verfügbar.

Neben dem Lernen aus Milliarden von öffentlich zugänglichen Codezeilen wurde CodeWhisperer auch mit Amazon-Code trainiert. Wir glauben, dass CodeWhisperer jetzt der präziseste, schnellste und sicherste Weg ist, Code für AWS-Dienste, einschließlich Amazon EC2, AWS Lambda und Amazon S3, zu generieren.

Entwickler:innen werden nicht wirklich produktiver sein, wenn der von ihrem generativen KI-Tool vorgeschlagene Code versteckte Sicherheitslücken enthält oder es versäumt, verantwortungsbewusst mit Open Source Projekten umzugehen. CodeWhisperer ist heute der einzige KI-Coding-Begleiter mit eingebautem Sicherheits-Scan (unterstützt durch Automatic Reasoning) zur Erkennung schwer erkennbarerer Sicherheitslücken. Beispiele hierfür sind unter anderem die in den Top Ten des Open Worldwide Application Security Project (OWASP) definierten Schwachstellen, sowie Code, welcher nicht den Best Practices für Krypto-Bibliotheken entspricht. Wurde ein Risiko erkannt, liefert CodeWhisperer automatische Vorschläge zur Behebung der Schwachstelle.

Um Entwickler:innen verantwortungsbewusstes Coden zu ermöglichen, filtert CodeWhisperer Code-Vorschläge heraus, die als voreingenommen oder unfair betrachtet werden könnten,. CodeWhisperer ist der einzige Coding-Begleiter, der Code-Vorschläge filtern und kennzeichnen kann, welche Open Source-Code ähneln und die Kund:innen möglicherweise referenzieren oder lizenzieren möchten.

Wir wissen, dass generative KI den Alltag für Entwickler:innen verändern wird, und wir möchten, dass sie so vielen wie möglich nützt. Deshalb ist CodeWhisperer für alle Einzelnutzer:innen kostenlos – ohne Qualifikationen oder zeitliche Beschränkungen für die Generierung von Code! Jede:r mit einer E-Mail Adresse kann sich für CodeWhisperer registrieren und innerhalb von Minuten produktiver werden – Sie müssen nicht einmal ein AWS-Konto haben.

Für Geschäftskunden bieten wir eine CodeWhisperer Professional an. CodeWhisperer Professional bietet zusätzlich Verwaltungsfunktionen wie Single Sign-On (SSO) mit AWS Identity and Access Management (IAM) Integration sowie genauerer Grenzen für Sicherheitsscans.

Das Bauen von leistungsstarken Anwendungen wie CodeWhisperer ist für Entwickler:innen und all unsere Kund:innen revolutionär. Wir haben noch viel mehr vor, und wir sind gespannt, was Sie mit generativer KI auf AWS erschaffen werden. Unsere Mission ist es, es Entwickler:innen aller Kompetenzstufen und Organisationen aller Größen zu ermöglichen, mit generativer KI zu innovieren. Dies ist erst der Anfang dessen, was wie wir glauben, die nächste Welle von ML sein wird, die neue Möglichkeiten für alle ermöglichen wird.

Ressourcen

Nutzen Sie die folgenden Ressourcen, um mehr über generative KI auf AWS und weitere Ankündigungen zu lernen:

- Generative KI auf AWS entdecken.

- Einführung in die generative KI [EN, Extern]: Lesen Sie, was Werner Vogels, CTO von Amazon.de, über generative KI zu sagen hat.

- Generative KI entmystifizieren [EN, Extern]: Hören Sie Werner Vogels und Swami Sivasubramanian, wie sie die Auswirkungen generativer KI auf Unternehmen diskutieren.

- Erfahren Sie mehr über Amazon Bedrock [EN]: Der einfachste Weg, um generative KI-Anwendungen mit FMs zu erstellen und zu skalieren.

- Erfahren Sie mehr über Amazon Titan [EN]: Leistungsstarke FMs von Amazon für verantwortungsvolle Innovationen.

- Entdecken Sie die neue AWS Trainium-basierte Trn1n-Instanz [EN] und die AWS Inferentia-basierte Inf2-Instanz [EN].

- Erfahren Sie, wie Sie Amazon CodeWhisperer als Ihren Coding-Begleiter nutzen [EN] können.

Über den Autor

Swami Sivasubramanian ist Vice President für Daten und maschinelles Lernen bei AWS. In dieser Rolle überwacht er alle AWS-Datenbank-, Analyse-, KI- und ML-Dienste. Die Mission seines Teams besteht darin, Organisationen dabei zu helfen, ihre Daten durch eine komplette, End-to-End-Datenlösung zur Speicherung, Zugang, Analyse, Visualisierung und Vorhersage nutzbar zu machen.

Swami Sivasubramanian ist Vice President für Daten und maschinelles Lernen bei AWS. In dieser Rolle überwacht er alle AWS-Datenbank-, Analyse-, KI- und ML-Dienste. Die Mission seines Teams besteht darin, Organisationen dabei zu helfen, ihre Daten durch eine komplette, End-to-End-Datenlösung zur Speicherung, Zugang, Analyse, Visualisierung und Vorhersage nutzbar zu machen.