อินสแตนซ์ Amazon EC2 Inf1

ธุรกิจต่างๆ จากกลุ่มอุตสาหกรรมที่หลากหลายกำลังมองหาการเปลี่ยนแปลงที่ขับเคลื่อนด้วยปัญญาประดิษฐ์ (AI) ในการผลักดันนวัตกรรมทางธุรกิจ ปรับปรุงประสบการณ์ของลูกค้า และการปรับปรุงกระบวนการ โมเดลแมชชีนเลิร์นนิ่ง (ML) ที่ขับเคลื่อนแอปพลิเคชัน AI กลายเป็นความซับซ้อนที่มากขึ้นซึ่งส่งผลให้มีต้นทุนด้านโครงสร้างพื้นฐานการประมวลผลพื้นฐานที่เพิ่มขึ้น การใช้จ่ายเกี่ยวกับโครงสร้างพื้นฐานมากถึง 90% สำหรับการพัฒนาและเรียกใช้แอปพลิเคชัน ML มักเกี่ยวข้องกับการอนุมาน ลูกค้ากำลังมองหาโซลูชันโครงสร้างพื้นฐานที่คุ้มค่าใช้จ่ายสำหรับการติดตั้งใช้งานแอปพลิเคชัน ML ในการผลิต

อินสแตนซ์ Amazon EC2 Inf1 มีการอนุมานของ ML ที่มีประสิทธิภาพสูงและค่าใช้จ่ายต่ำ ซึ่งมีอัตราการโอนถ่ายข้อมูลเพิ่มขึ้นถึง 2.3 เท่าและมีค่าใช้จ่ายน้อยลงถึง 70% ต่อการอนุมานเมื่อเทียบกับอินสแตนซ์ Amazon EC2 อินสแตนซ์ Inf1 ได้รับการออกแบบใหม่ทั้งหมดให้รองรับแอปพลิเคชันการอนุมานของ ML ซึ่งฟีเจอร์ AWS Inferentia มากถึง 16 ตัว ซึ่งเป็นชิปการอนุมานของ ML ประสิทธิภาพสูงที่ออกแบบและสร้างโดย AWS นอกจากนี้ อินสแตนซ์ Inf1 ยังมาพร้อมกับโปรเซสเซอร์ Intel Xeon เจนเนอเรชัน 2 แบบปรับขนาดได้ และระบบเครือข่ายสูงสุด 100 Gbps สำหรับการอนุมานที่มีอัตราการโอนถ่ายข้อมูลสูง

ลูกค้าสามารถใช้อินสแตนซ์ Inf1 เพื่อเรียกใช้แอปพลิเคชันการอนุมานของ ML ขนาดใหญ่ เช่น การค้นหา กลไกการให้คำแนะนำ คอมพิวเตอร์วิทัศน์ การจดจำคำพูด การประมวลผลภาษาธรรมชาติ (NLP) การปรับให้เข้ากับบุคคล และการตรวจจับการฉ้อโกงได้

นักพัฒนาสามารถติดตั้งใช้งานโมเดล ML กับอินสแตนซ์ Inf1 โดยใช้ AWS Neuron SDK ซึ่งผสานรวมเฟรมเวิร์ก ML ยอดนิยมไว้ด้วยกัน เช่น TensorFlow, PyTorch และ Apache MXNet นักพัฒนาสามารถใช้เวิร์กโฟลว์ ML เดียวกันและย้ายข้อมูลแอปพลิเคชันไปยังอินสแตนซ์ Inf1 ได้อย่างราบรื่นโดยมีการเปลี่ยนแปลงโค้ดเพียงเล็กน้อยและไม่เป็นการผูกมัดกับโซลูชันเฉพาะของผู้ให้บริการ

เริ่มต้นใช้งานอินสแตนซ์ Inf1 ได้ง่ายๆ โดยใช้ Amazon SageMaker, AWS Deep Learning AMI (DLAMI) ที่กำหนดค่าไว้ล่วงหน้าด้วย Neuron SDK หรือ Amazon Elastic Container Service (Amazon ECS) หรือ Amazon Elastic Kubernetes Service (Amazon EKS) สำหรับแอปพลิเคชัน ML ที่มีคอนเทนเนอร์

ประโยชน์

ค่าใช้จ่ายต่อการอนุมานน้อยลงถึง 70%

เมื่อใช้ Inf1 นักพัฒนาจะสามารถลดค่าติดตั้งใช้งาน ML ในการนำไปใช้งานในด้านการผลิตอย่างเห็นได้ชัด การผสานกันของค่าอินสแตนซ์ที่ต่ำและอัตราการโอนถ่ายข้อมูลที่สูงของอินสแตนซ์ Inf1 ทำให้ต้นทุนต่อการอนุมานน้อยลงถึง 70% เมื่อเทียบกับอินสแตนซ์ Amazon EC2

ความง่ายต่อการใช้งานและความสามารถในการเคลื่อนย้ายโค้ด

Neuron SDK ได้ผสานการทำงานร่วมกับเฟรมเวิร์ก ML เช่น TensorFlow, PyTorch และ MXNet นักพัฒนาสามารถใช้เวิร์กโฟลว์ ML เดียวกันและย้ายข้อมูลแอปพลิเคชันไปยังอินสแตนซ์ Inf1 ได้อย่างราบรื่นโดยมีการเปลี่ยนแปลงโค้ดเพียงเล็กน้อย ซึ่งให้อิสระในการใช้เฟรมเวิร์ก ML ตามความต้องการ แพลตฟอร์มการประมวลผลที่ตรงตามข้อกำหนดที่สุด และใช้ประโยชน์จากเทคโนโลยีล่าสุดโดยไม่จำเป็นต้องผูกมัดกับโซลูชันเฉพาะของผู้ให้บริการ

อัตราการโอนถ่ายข้อมูลสูงกว่าถึง 2.3 เท่า

อินสแตนซ์ Inf1 มีอัตราการโอนถ่ายข้อมูลสูงกว่าถึง 2.3 เท่าเมื่อเทียบกับอินสแตนซ์ Amazon EC2 ชิป AWS Inferentia ที่ขับเคลื่อนอินสแตนซ์ Inf1 ได้รับการปรับให้มีประสิทธิภาพเพื่อประสิทธิภาพการอนุมานสำหรับชุดข้อมูลแบบกลุ่มขนาดเล็ก ช่วยให้แอปพลิเคชันแบบเรียลไทม์เพิ่มอัตราการโอนถ่ายข้อมูลได้สูงสุดและตอบสนองความต้องการด้านเวลาแฝง

เวลาแฝงที่ต่ำอย่างมาก

ชิป AWS Inferentia ได้รับการติดตั้งหน่วยความจำบนชิปขนาดใหญ่ซึ่งช่วยให้แคชโมเดล ML ได้โดยตรงบนตัวชิปเอง คุณสามารถติดตั้งใช้งานโมเดลของคุณได้โดยใช้ความสามารถต่างๆ เช่น NeuronCore Pipeline จึงไม่จำเป็นต้องเข้าถึงทรัพยากรหน่วยความจำภายนอก เมื่อใช้อินสแตนซ์ Inf1 คุณสามารถติดตั้งใช้งานแอปพลิเคชันการอนุมานแบบเรียลไทม์ได้ในเวลาแฝงที่ไกล้เคียงกับเรียลไทม์โดยไม่มีผลกระทบต่อแบนด์วิดท์

รองรับโมเดล ML และประเภทข้อมูที่หลากหลาย

อินสแตนซ์ Inf1 รองรับสถาปัตยกรรมโมเดล ML ที่ใช้บ่อยได้หลายตัว เช่น SSD, VGG และ ResNext สำหรับการจดจำ/จัดหมวดหมู่ภาพ เช่นเดียวกับ Transformer และ BERT สำหรับ NLP นอกจากนี้ ยังสนับสนุนคลังข้อมูลโมเดล HuggingFace ใน Neuron เพื่อให้ความสามารถในการคอมไพล์และเรียกใช้การอนุมานโดยใช้โมเดลที่มีการฝึกฝนไว้ล่วงหน้ากับลูกค้า หรือการปรับแต่งเป็นพิเศษอย่างง่ายดายโดยการเปลี่ยนแปลงโค้ดเพียงบรรทัดเดียว ข้อมูลหลายประเภทรวมถึง BF16 และ FP16 ด้วยความแม่นยำแบบผสมผสานยังรองรับโมเดลและความต้องการด้านประสิทธิภาพหลากหลายรูปแบบอีกด้วย

คุณสมบัติ

ให้บริการโดย AWS Inferentia

AWS Inferentia คือชิป ML ที่ออกแบบและสร้างตามจุดประสงค์โดย AWS เพื่อส่งมอบประสิทธิภาพสูงที่มีค่าใช้จ่ายต่ำ ชิป AWS Inferentia แต่ละตัวประกอบไปด้วย NeuronCore รุ่นที่ 1 สี่ตัวและให้ประสิทธิภาพการทำงาน 128 tera ต่อวินาที (TOPS) และรองรับชนิดข้อมูล FP16 BF16 และ INT8 ชิป AWS Inferentia ยังประกอบด้วยหน่วยความจำบนชิปขนาดใหญ่ซึ่งสามารถใช้เพื่อแคชโมเดลที่มีขนาดใหญ่ได้ ซึ่งเป็นประโยชน์อย่างยิ่งโดยเฉพาะสำหรับโมเดลที่ต้องใช้การเข้าถึงหน่วยความจำบ่อยครั้ง

ติดตั้งใช้งานด้วยเฟรมเวิร์ก ML ยอดนิยมโดยใช้ AWS Neuron

AWS Neuron SDK ประกอบด้วยเครื่องมือคอมไพเลอร์ รันไทม์ไดรเวอร์ และเครื่องมือสร้างโปรไฟล์ โดยจะทำให้เกิดการติดตั้งใช้งานโมเดลโครงข่ายประสาทที่มีความซับซ้อน ซึ่งสร้างและฝึกอบรมในเฟรมเวิร์กยอดนิยม เช่น TensorFlow, PyTorch และ MXNet สามารถดำเนินการได้โดยใช้อินสแตนซ์ Inf1 เมื่อใช้ NeuronCore Pipeline คุณสามารถแบ่งโมเดลขนาดใหญ่เพื่อดำเนินการในชิป Inferentia หลายตัวโดยใช้การเชื่อมต่อระหว่างชิปไปยังชิปอีกตัวที่มีความเร็วสูง เพื่อส่งมอบอัตราการโอนถ่ายข้อมูลการอนุมานในระดับสูงและค่าใช้จ่ายในการอนุมานที่ต่ำลง

ระบบเครือข่ายและพื้นที่จัดเก็บข้อมูลประสิทธิภาพสูง

อินสแตนซ์ Inf1 ให้อัตราการโอนถ่ายข้อมูลเครือข่ายสูงสุด 100 Gbps สำหรับแอปพลิเคชันซึ่งต้องเข้าถึงเครือข่ายความเร็วสูง เทคโนโลยี Elastic Network Adapter (ENA) และ NVM Express (NVMe) รุ่นใหม่ช่วยให้อินสแตนซ์ Inf1 มีอัตราการโอนถ่ายข้อมูลสูง อินเทอร์เฟซแบบมีเวลาแฝงต่ำสำหรับระบบเครือข่าย และ Amazon Elastic Block Store (Amazon EBS)

สร้างบน AWS Nitro System

AWS Nitro System คือการรวบรวมบล็อกส่วนประกอบที่ครบถ้วนที่จะถ่ายข้อมูลฟังก์ชันการจำลองเสมือนแบบดั้งเดิมหลายฟังก์ชันไปยังฮาร์ดแวร์และซอฟต์แวร์เฉพาะ เพื่อมอบประสิทธิภาพสูง ความพร้อมใช้งานสูง และการรักษาความปลอดภัยระดับสูง ในขณะที่ลดค่าใช้จ่ายในการจำลองเสมือน

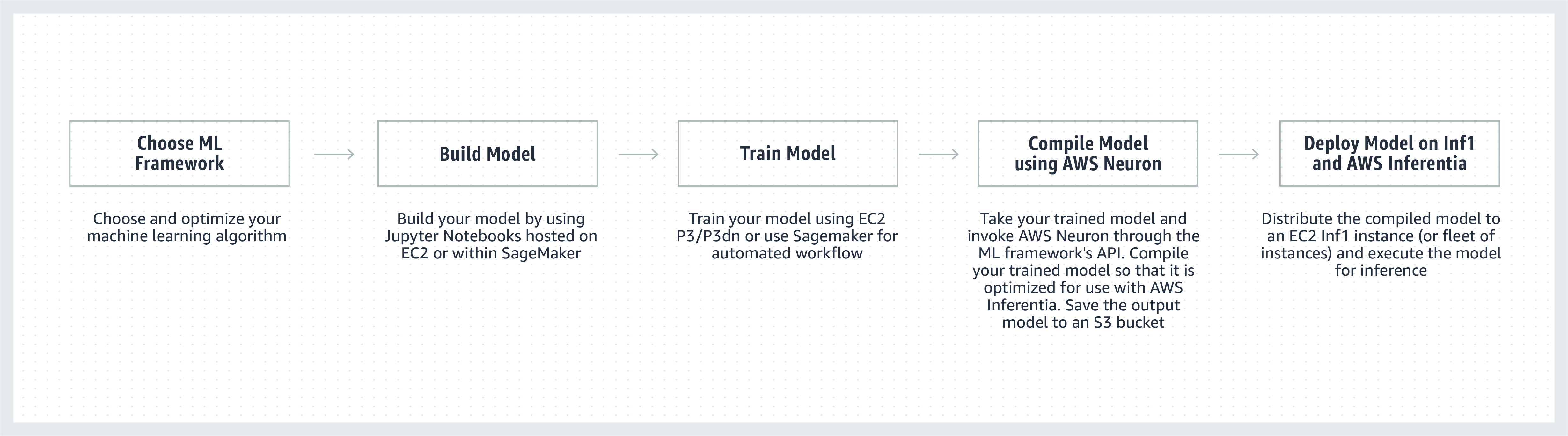

วิธีการทำงาน

คำชมเชยจากลูกค้า

“เราใช้งาน ML ในหลายๆ ส่วนของ Snapchat และการสำรวจนวัตกรรมใหม่ๆ ในด้านนี้ถือเป็นสิ่งสำคัญอันดับแรก เมื่อได้ทราบข่าวเกี่ยวกับ Inferentia เราจึงเริ่มร่วมงานกับ AWS เพื่อใช้อินสแตนซ์ Inf1/Inferentia ในการช่วยติดตั้งใช้งาน ML รวมถึงในด้านประสิทธิภาพและต้นทุน เราเริ่มต้นจากรูปแบบการแนะนำและคาดหวังว่าจะได้ใช้รูปแบบอื่นเพิ่มเติมกับอินสแตนซ์ Inf1 ในอนาคต”

Nima Khajehnouri รองประธานฝ่ายวิศวกรรมของ Snap Inc.

“แพลตฟอร์มการจัดการประสบการณ์ของลูกค้าแบบครบวงจร (Unified-CXM) ที่ขับเคลื่อนด้วย AI ของ Sprinklr ช่วยให้บริษัทต่างๆ สามารถรวบรวมและแปลความคิดเห็นของลูกค้าแบบเรียลไทม์ในช่องทางต่างๆ ให้เป็นข้อมูลเชิงลึกที่นำไปปฏิบัติได้ ส่งผลให้เกิดการแก้ไขปัญหาเชิงรุก การพัฒนาผลิตภัณฑ์ที่เพิ่มขึ้น การตลาดผ่านเนื้อหาที่ดีขึ้น การบริการลูกค้าที่ดีขึ้น และอื่นๆ อีกมากมาย เมื่อใช้ Amazon EC2 Inf1 เราสามารถเพิ่มประสิทธิภาพโมเดล NLP รูปแบบหนึ่งของเราได้เป็นอย่างมาก รวมถึงเพิ่มประสิทธิภาพของโมเดลคอมพิวเตอร์วิทัศน์รูปแบบหนึ่งของเราได้อีกด้วย เราหวังว่าจะใช้ Amazon EC2 Inf1 ต่อไปเพื่อให้บริการแก่ลูกค้าทั่วโลกของเราได้ดียิ่งขึ้น"

Vasant Srinivasan รองประธานอาวุโสฝ่ายวิศวกรรมผลิตภัณฑ์ของ Sprinklr

“Finch for Text ซึ่งเป็นผลิตภัณฑ์ NLP อันล้ำสมัยของเรา ช่วยให้ผู้ใช้สามารถแยก ขจัดความคลุมเครือ และทำให้เอนทิตีประเภทต่างๆ สมบูรณ์ยิ่งขึ้นในข้อความจำนวนมากได้ Finch for Text ต้องใช้ทรัพยากรการประมวลผลจำนวนมากเพื่อให้ลูกค้าของเราได้รับฟีดข้อมูลทั่วโลกที่สมบูรณ์ยิ่งขึ้นโดยมีเวลาแฝงที่ต่ำ ขณะนี้เราเลือกใช้อินสแตนซ์ Inf1 ของ AWS ในโมเดล PyTorch NLP, การแปล และการขจัดความคลุมเครือของเอนทิตี เราสามารถลดต้นทุนในการอนุมานได้มากกว่า 80% (มากกว่า GPU) โดยมีการเพิ่มประสิทธิภาพขั้นต่ำ ในขณะที่ยังคงความเร็วและประสิทธิภาพในการอนุมานของเราไว้ได้ การปรับปรุงนี้ช่วยให้ลูกค้าของเราสามารถปรับปรุงข้อความในภาษาฝรั่งเศส สเปน เยอรมัน และดัตช์ได้แบบเรียลไทม์บนฟีดข้อมูลการสตรีมและในระดับโลก ซึ่งถือเป็นสิ่งที่สำคัญสำหรับบริการทางการเงิน ผู้รวบรวมข้อมูล และลูกค้าภาครัฐของเรา”

Scott Lightner ประธานเจ้าหน้าที่ฝ่ายเทคโนโลยีของ Finch Computing

"เราแจ้งเตือนเหตุการณ์หลายประเภททั่วโลกในภาษาต่างๆ มากมาย ในรูปแบบที่หลากหลาย (ภาพ วิดีโอ เสียง เซ็นเซอร์ข้อความ หรือผสมผสานการแจ้งเตือนประเภทเหล่านี้ทั้งหมดเข้าด้วยกัน) จากแหล่งข้อมูลหลายแสนแห่ง การปรับให้เหมาะสมกับความเร็วและต้นทุนตามขนาดนั้นเป็นสิ่งสำคัญอย่างยิ่งสำหรับธุรกิจของเรา เมื่อใช้ AWS Inferentia เราสามารถลดเวลาแฝงของโมเดลและมีอัตราการโอนถ่ายข้อมูลดีขึ้นถึง 9 เท่าต่อดอลลาร์ ซึ่งทำให้เราสามารถเพิ่มความแม่นยำของโมเดลและเพิ่มขีดความสามารถของแพลตฟอร์มของเราได้โดยการปรับใช้โมเดล DL ที่ซับซ้อนมากขึ้นและประมวลผลข้อมูลในปริมาณมากขึ้น 5 เท่า ในขณะที่ควบคุมค่าใช้จ่ายของเราไว้ได้"

Alex Jaimes หัวหน้านักวิทยาศาสตร์และรองประธานอาวุโสด้าน AI ของ Dataminr

“Autodesk กำลังพัฒนาเทคโนโลยีการรู้คิดของผู้ช่วยเสมือนของเราที่ขับเคลื่อนโดย AI ที่มีชื่อว่า Autodesk Virtual Agent (AVA) โดยใช้ Inferentia ซึ่ง AVA ตอบคำถามลูกค้ากว่า 100,000 ข้อต่อเดือนด้วยการใช้ความเข้าใจภาษาธรรมชาติ (NLU) และเทคนิคดีปเลิร์นนิง (DL) ในการหาบริบท เจตนา และความหมายเบื้องหลังการสอบถาม จากการเริ่มนำร่องกับ Inferentia เราสามารถรับอัตราการโอนถ่ายข้อมูลได้สูงกว่า G4dn ถึง 4.9 เท่าสำหรับโมเดล NLU ของเรา และคาดหวังว่าจะเรียกใช้เวิร์กโหลดได้มากขึ้นในอินสแตนซ์ Inf1 ที่ใช้ Inferentia”

Binghui Ouyang, Sr. นักวิทยาศาสตร์ข้อมูลของ Autodesk

บริการของ Amazon ที่ใช้อินสแตนซ์ Amazon EC2 Inf1

Amazon Advertising ช่วยให้ธุรกิจทุกขนาดเชื่อมต่อกับลูกค้าในทุกขั้นตอนของเส้นทางการช็อปปิ้ง โฆษณาหลายล้านรายการ รวมถึงข้อความและรูปภาพ ได้รับการดูแล จัดประเภท และให้บริการเพื่อประสบการณ์ที่ดีที่สุดของลูกค้าในทุกๆ วัน

“สำหรับการประมวลผลโฆษณาแบบข้อความ เราติดตั้งใช้โมเดล BERT ที่ใช้ PyTorch ทั่วโลกบนอินสแตนซ์ Inf1 ที่ใช้ AWS Inferentia การเปลี่ยนไปใช้ Inferentia จาก GPU ช่วยให้เราลดต้นทุนลงได้ถึง 69% แต่ยังมีประสิทธิภาพเท่าเดิม การคอมไพล์และการทดสอบโมเดลของเราสำหรับ AWS Inferentia ใช้เวลาไม่เกิน 3 สัปดาห์ การใช้ Amazon SageMaker เพื่อติดตั้งใช้โมเดลของเรากับอินสแตนซ์ Inf1 ช่วยรับรองได้ว่าการติดตั้งใช้จริงของเราจะปรับขนาดได้และจัดการได้ง่าย เมื่อวิเคราะห์โมเดลที่คอมไพล์แล้ว ประสิทธิภาพของ AWS Inferentia นั้นน่าประทับใจมาก จนต้องรันการวัดประสิทธิภาพใหม่เพื่อให้แน่ใจว่าถูกต้อง! ในอนาคต เราวางแผนที่จะย้ายโมเดลการประมวลผลโฆษณาแบบรูปภาพไปยัง Inferentia เราได้ลองเปรียบเทียบดูแล้วพบว่ามีเวลาแฝงต่ำกว่า 30% และประหยัดค่าใช้จ่ายลง 71% เมื่อเทียบกับอินสแตนซ์ที่ใช้ GPU ที่เปรียบเทียบได้สำหรับรุ่นเหล่านี้”

Yashal Kanungo นักวิทยาศาสตร์ประยุกต์ของ Amazon Advertising

อ่านบล็อกข่าว »

"ระบบอัจฉริยะที่ใช้ AI และ ML ของ Amazon Alexa ซึ่งให้บริการโดย AWS พร้อมให้บริการบนอุปกรณ์มากกว่า 100 ล้านเครื่องแล้วในวันนี้ และคำสัญญาของเราที่มีต่อลูกค้าคือการทำให้ Alexa ฉลาดยิ่งขึ้น สนทนาได้ดียิ่งขึ้น พร้อมตอบคำถามมากขึ้น และมีชีวิตชีวายิ่งกว่าเดิม การทำให้คำสัญญานั้นเป็นจริงได้ต้องมีการปรับปรุงอย่างต่อเนื่องเกี่ยวกับระยะเวลาการตอบสนองและค่าใช้จ่ายในด้านโครงสร้างพื้นฐาน ML ซึ่งเป็นเหตุผลที่เราตื่นเต้นที่จะใช้ Amazon EC2 Inf1 เพื่อลดเวลาแฝงในการอนุมานและค่าใช้จ่ายต่อการอนุมานในการแปลงข้อความเป็นคำพูดของ Alexa Amazon EC2 Inf1 ช่วยให้เราสามารถให้การบริการที่ดียิ่งขึ้นกับลูกค้าหลายสิบล้านรายที่ใช้งาน Alexa ในแต่ละเดือน"

Tom Taylor รองประธานอาวุโสของ Amazon Alexa

“เราสร้างสรรค์นวัตกรรมอย่างต่อเนื่องเพื่อปรับปรุงประสบการณ์ของลูกค้าให้ดียิ่งขึ้น และเพื่อลดต้นทุนด้านโครงสร้างพื้นฐานของเรา การย้ายเวิร์กโหลดการตอบคำถามบนเว็บ (WBQA) ของเราจากอินสแตนซ์ P3 ที่ใช้ GPU ไปยังอินสแตนซ์ Inf1 ที่ใช้ AWS Inferentia ไม่เพียงช่วยให้เราลดต้นทุนการอนุมานได้ถึง 60% แต่ยังปรับปรุงเวลาแฝงจากต้นทางถึงปลายทางได้มากกว่า 40% ซึ่งช่วยให้ลูกค้าได้รับประสบการณ์ถามตอบกับ Alexa ที่ดีขึ้น การใช้ Amazon SageMaker สำหรับโมเดลที่ใช้ TensorFlow ทำให้กระบวนการสลับไปใช้อินสแตนซ์ Inf1 กลายเป็นเรื่องไม่ซับซ้อนและจัดการได้ง่าย ตอนนี้เราใช้อินสแตนซ์ Inf1 โดยรวมเพื่อเรียกใช้เวิร์กโหลด WBQA เหล่านี้ และปรับประสิทธิภาพให้เหมาะสมสำหรับ AWS Inferentia เพื่อลดต้นทุนและเวลาแฝงเพิ่มเติม”

Eric Lind วิศวกรพัฒนาซอฟต์แวร์ของ Alexa AI

“Amazon Prime Video ใช้โมเดล ML ของคอมพิวเตอร์วิชันเพื่อวิเคราะห์คุณภาพวิดีโอของการถ่ายทอดสดเพื่อให้มั่นใจได้ถึงประสบการณ์การรับชมที่ดีที่สุดสำหรับสมาชิก Prime Video เรานำโมเดล ML การจำแนกประเภทอิมเมจของเราไปใช้จริงบนอินสแตนซ์ Inf1 ของ EC2 และสังเกตเห็นการปรับปรุงประสิทธิภาพที่เพิ่มขึ้นถึง 4 เท่าและการประหยัดค่าใช้จ่ายได้สูงสุดถึง 40% ขณะนี้เราต้องการใช้ประโยชน์จากการประหยัดต้นทุนเหล่านี้เพื่อสร้างสรรค์สิ่งใหม่ๆ และสร้างโมเดลขั้นสูงซึ่งสามารถตรวจจับข้อบกพร่องที่ซับซ้อนมากขึ้นได้ เช่น ช่องว่างการซิงโครไนซ์ระหว่างไฟล์เสียงและวิดีโอเพื่อให้สมาชิก Prime Video ได้รับประสบการณ์การรับชมที่ดียิ่งขึ้น”

Victor Antonino สถาปนิกด้านโซลูชันของ Amazon Prime Video

“Amazon Rekognition เป็นแอปพลิเคชันวิเคราะห์รูปภาพและวิดีโอที่ใช้งานง่ายซึ่งช่วยให้ลูกค้าระบุวัตถุ ผู้คน ข้อความ และกิจกรรมได้ โดย Amazon Rekognition ต้องใช้โครงสร้างพื้นฐาน DL ประสิทธิภาพสูงที่สามารถวิเคราะห์รูปภาพและวิดีโอได้หลายพันล้านรายการสำหรับลูกค้าของเรา ด้วยอินสแตนซ์ Inf1 ที่ใช้ AWS Inferentia ทำให้การเรียกใช้โมเดล AWS Rekognition เช่น การแยกวัตถุ มีเวลาแฝงต่ำลง 8 เท่า และมีอัตราการโอนถ่ายข้อมูลเป็น 2 เท่า เมื่อเทียบกับการเรียกใช้โมเดลเหล่านี้ใน GPU จากผลลัพธ์นี้ ทำให้เราย้าย Amazon Rekognition ไปยัง Inf1 เพื่อช่วยให้ลูกค้าของเราได้รับผลลัพธ์ที่แม่นยำและรวดเร็วยิ่งขึ้น”

Rajneesh Singh, ผู้อำนวยการวิศวกรรม SW ของ Amazon Rekognition and Video

ราคา

* ราคาที่แสดงคือราคาสำหรับรีเจี้ยน AWS ของสหรัฐอเมริกาฝั่งตะวันออก (เวอร์จิเนียตอนเหนือ) ราคาสำหรับอินสแตนซ์แบบเหมาจ่ายเป็นระยะเวลา 1 ปีและ 3 ปีนั้นมีไว้สำหรับตัวเลือกการชำระเงิน "ค่าบริการล่วงหน้าบางส่วน" หรือ "ไม่มีค่าบริการล่วงหน้า" สำหรับอินสแตนซ์ที่ไม่มีตัวเลือกค่าบริการล่วงหน้าบางส่วน

Amazon EC2 Inf1 instance พร้อมให้บริการในรีเจี้ยน AWS สหรัฐอเมริกาฝั่งตะวันออก (เวอร์จิเนียเหนือ) และสหรัฐอเมริกาฝั่งตะวันตก (ออริกอน) ในรูปแบบของอินสแตนซ์ตามความต้องการ อินสแตนซ์แบบเหมาจ่าย หรืออินสแตนซ์สปอต

เริ่มต้นใช้งาน

การใช้ Amazon SageMaker

SageMaker ทำให้ง่ายต่อการคอมไพล์และการติดตั้งใช้จริงโมเดล ML ที่ผ่านการฝึกมาแล้วในระหว่างการใช้งานจริงบนอินสแตนซ์ Amazon Inf1 ดังนั้นคุณจึงสามารถเริ่มสร้างการคาดการณ์ได้แบบเรียลไทม์ด้วยเวลาแฝงที่ต่ำ AWS Neuron ซึ่งเป็นคอมไพเลอร์สำหรับ AWS Inferentia ได้รับการผสานการทำงานเข้ากับ Amazon SageMaker Neo เพื่อช่วยให้คุณคอมไพล์โมเดล ML ที่ผ่านการฝึกมาให้ทำงานอย่างเหมาะสมบนอินสแตนซ์ Inf1 ด้วย Amazon SageMaker คุณสามารถใช้งานโมเดลบนคลัสเตอร์ที่มีการปรับขยายอัตโนมัติของอินสแตนซ์ Inf1 ที่ครอบคลุมหลาย Availability Zone ได้อย่างง่ายดาย เพื่อมอบทั้งประสิทธิภาพการทำงานและความพร้อมใช้งานที่สูงของการอนุมานแบบเรียลไทม์ เรียนรู้วิธีการปรับใช้ Inf1 โดยใช้ SageMaker ด้วยตัวอย่างบน Github

การใช้ DLAMI

DLAMI มอบโครงสร้างพื้นฐานและเครื่องมือต่างๆ ให้กับผู้ปฏิบัติงานและนักวิจัย ML เพื่อเร่ง DL ในระบบคลาวด์ในทุกขนาด AWS Neuron SDK ได้รับการติดตั้งไว้ล่วงหน้าใน DLAMI เพื่อคอมไพล์และเรียกใช้โมเดล ML ของคุณอย่างเหมาะสมที่สุดบนอินสแตนซ์ Inf1 หากต้องการความช่วยเหลือในการเริ่มต้นใช้งานกระบวนการ ให้ไปที่คู่มือการเลือก AMI และทรัพยากร DL อื่นๆ ดูคู่มือการเริ่มต้นใช้งาน AWS DLAMI เพื่อเรียนรู้วิธีใช้งาน DLAMI ด้วย Neuron

การใช้ Deep Learning Containers

นักพัฒนาสามารถติดตั้งใช้จริงอินสแตนซ์ Inf1ได้แล้วใน Amazon EKS ซึ่งเป็นบริการ Kubernetes ที่มีการจัดการอย่างเต็มรูปแบบ รวมถึง Amazon ECS ซึ่งเป็นบริการควบคุมระบบคอนเทนเนอร์ที่มีการจัดการอย่างเต็มรูปแบบจาก Amazon เรียนรู้เพิ่มเติมเกี่ยวกับการเริ่มต้นใช้งานด้วย Inf1 บน Amazon EKS หรือด้วย Amazon ECS รายละเอียดเพิ่มเติมเกี่ยวกับการใช้งานคอนเทนเนอร์บนอินสแตนซ์ Inf1 มีอยู่ในหน้าบทแนะนำสอนการใช้งานเครื่องมือคอนเทนเนอร์ Neuron Neuron ยังมีแบบติดตั้งมาให้ล่วงหน้าใน AWS Deep Learning Containers อีกด้วย

บล็อกและบทความ

AWS Inferentia ช่วย Amazon Search ลดค่าใช้จ่ายการอนุมาน ML ถึง 85% ได้อย่างไร

โดย Joao Moura, Jason Carlson, Jaspreet Singh, Shaohui Xi, Shruti Koparkar, Haowei Sun, Weiqi Zhang, และ Zhuoqi Zhangs, 9/22/2022

โครงสร้างพื้นฐานแมชชีนเลิร์นนิงประสิทธิภาพสูงในราคาประหยัดช่วยเร่งสร้างนวัตกรรมในระบบคลาวด์ได้

โดย MIT Technology Review Insights, 01/11/2021

โดย Davide Galliteli และ Hasan Poonawala, 19/10/2021

แมชชีนเลิร์นนิงในระบบคลาวด์ช่วยให้ธุรกิจสร้างสรรค์นวัตกรรมได้

โดย MIT Technology Review Insights, 15/10/2021

โดย Alex Iankoulski, Joshua Correa, Mahadevan Balasubramaniam และ Sundar Ranganatha, 30/09/2021

โดย Fabio Nonato de Paula และ Mahadevan Balasubramaniam, 05/04/2021

โดย Binghui Ouyang, 07/04/2021

ตอนนี้งานส่วนใหญ่ใน Alexa ทำงานได้เร็วขึ้นและคุ้มค่ามากขึ้นบนอินสแตนซ์ Amazon EC2 Inf1

โดย Sébastien Stormacq, 11/12/2020

Amazon ECS รองรับ EC2 Inf1 instance แล้วในขณะนี้

โดย Julien Simon 14/08/2020

โดย Fabio Nonato De Paula และ Haichen Li 22/07/2020

Amazon EKS สนับสนุน EC2 Inf1 instance แล้วในขณะนี้

โดย Julien Simon 15/06/2020