Amazon Web Services ブログ

New – Amazon AppFlow のご紹介

Software as a service (SaaS) アプリケーションはお客様にとってますます重要になり、それを採用するお客様も急速に増えてきています。このソフトウェアの利用方法には多くの利点がありますが、1 つの課題は、データがさまざまな場所に点在していることです。データから有意義な洞察を得るには、それを分析する方法が必要ですが、データが複数のデータアイランドに分散している場合は困難な場合があります。

開発者は膨大な時間をかけてカスタム統合を行い、SaaS アプリケーションと AWS のサービスの間でデータを渡して分析できるようにしています。これには高額の費用がかかり、完了までに数か月を要する場合もあります。データ要件が変更されると、統合に複雑な変更を加える必要があり、費用もかかります。潤沢なエンジニアリングリソースがない企業は、アプリケーションからデータを手動でインポートおよびエクスポートすることになるかもしれません。これは時間がかかり、データ漏洩のリスクがあり、人為的ミスを招く可能性もあります。

本日、この問題を解決する Amazon AppFlow と呼ばれる新しいサービスを発表できることを嬉しく思います。Amazon AppFlow を使用すると、AWS のサービスと、Salesforce、Zendesk、ServiceNow などの SaaS アプリケーション間のデータフローを自動化できます。SaaS アプリケーション管理者、ビジネスアナリスト、および BI スペシャリストは、IT が統合プロジェクトを完了するのに数か月待つことなく、必要な統合のほとんどをすばやく実装できます。

SaaS アプリケーションから AWS のサービスへのデータフローを可能にするだけでなく、AWS のサービスから SaaS アプリケーションへのデータの送信も行えます。AWS ではセキュリティが最優先事項であるため、すべてのデータは転送時に暗号化されます。一部の SaaS アプリケーションは AWS PrivateLink と統合されています。これにより、セキュリティとプライバシーがさらに強化されます。AWS PrivateLink を使用して SaaS アプリケーションと AWS の間でデータの送受信が行われる場合、トラフィックはパブリックインターネットを使用せずに Amazon ネットワークに留まります。SaaS アプリケーションがサポートしている場合、Amazon AppFlow が自動的にこの接続を処理し、プライベートデータの転送を誰にとっても簡単にし、インターネットベースの攻撃による脅威と機密データ漏洩のリスクを最小限に抑えます。

データ転送をスケジュールに従って、ビジネスイベントに応じて、またはオンデマンドで実行するようにスケジュールできます。これにより、データの共有を迅速かつ柔軟に行うことができます。

この新しいサービスの力を示すために、簡単なフローの構築方法を示します。

筆者はイギリスとアイルランドでウェブコミュニティのオーガナイザー向けに Slack ワークスペースを運営しています。Slack は Amazon AppFlow でサポートされている SaaS アプリケーションの 1 つなので、その会話データの一部を S3 にインポートしてみます。データが S3 にインポートされたら、Amazon Athena を使用して分析を開始し、最終的に Amazon QuickSight を使用して視覚化データを作成できます。

開始するには、Amazon AppFlow コンソールに移動し、[Create Flow] ボタンをクリックします。

次のステップでは、[Flow name] と [Flow description] を入力します。またデータ暗号化にはいくつかのオプションがあります。デフォルトでは、すべてのデータは転送時に暗号化され、S3 の場合は、保存時にも暗号化されます。独自の暗号化キーを指定することもできますが、このデモでは、デフォルトで使用されるアカウントのキーを使用します。

このステップでは、リソースにタグ付けするオプションもあります。私は、アカウントのデモインフラストラクチャに Demo とタグ付けする習慣があります。これにより、削除できるリソースが簡単に分かります。

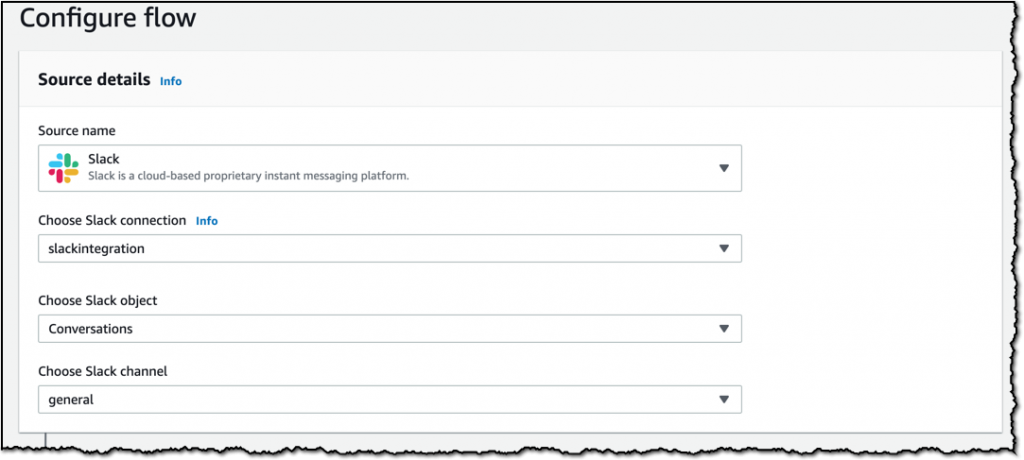

次のステップでは、データソースを選択します。[Slack] を選択してウィザードの手順を実行し、Slack ワークスペースとの接続を確立します。また、Slack ワークスペースからインポートするデータを選択することもできます。Slack の general チャネルで、[Conversations] オブジェクトを選択します。これにより、general チャネルに投稿されたメッセージがインポートされ、次に設定する宛先に送信されます。

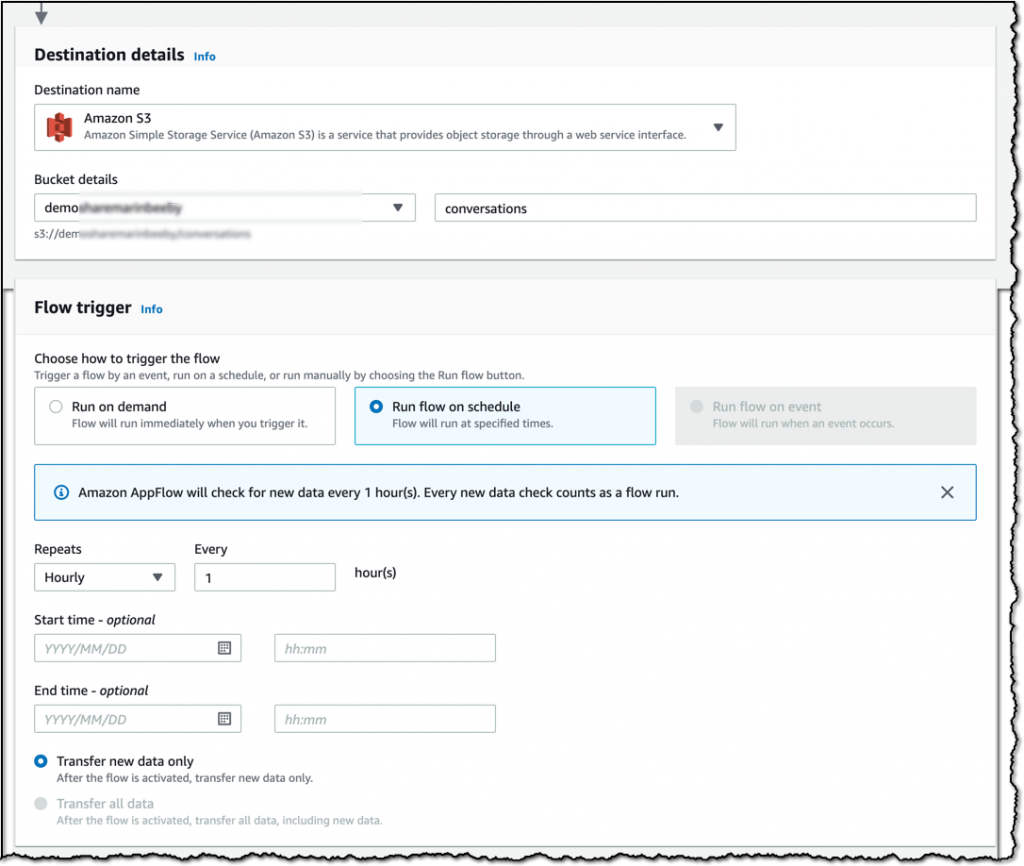

選択できる宛先はいくつかありますが、簡単にするために、データを S3 バケットに送信することにします。このステップでデータをフェッチする頻度も設定します。1 時間ごとにデータを取得したいので、[Run the flow on schedule] を選択し、必要な設定を行います。Slack はオンデマンドで、またはスケジュールに従ってトリガーできます。他のソースでは、Salesforce のリードの変換など、特定のイベントによってトリガーすることもできます。

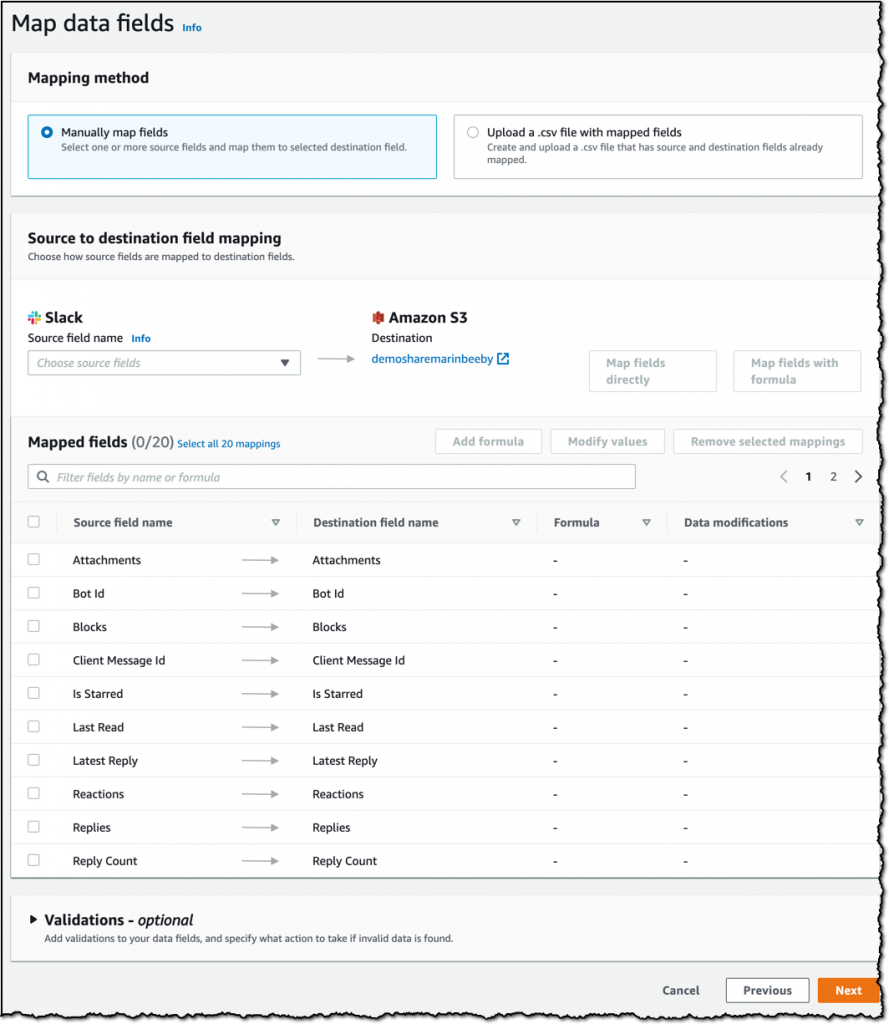

次のステップはデータフィールドをマッピングすることです。ここではデフォルトを使用しますが、これをカスタマイズしてフィールドを組み合わせるか、分析に必要な特定のフィールドのみを使用することもできます。

これでフローが作成され、アクティブ化しました。 1 時間ごとに自動的に実行され、新しいデータが S3 バケットに追加されます。

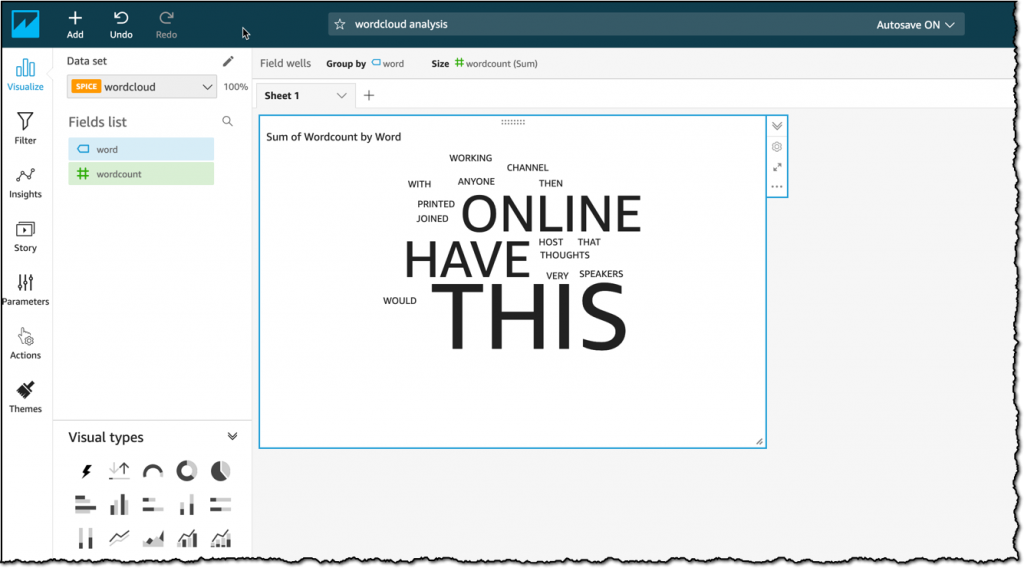

Amazon Athena や Amazon QuickSight の詳細については触れませんが、これらの AWS のサービスを使用してデータを S3 に保存し、Slack チャネルで使用する最も一般的な単語のワードクラウドを生成しています。

Athena が優れている点は、追加のデータウェアハウスを必要とせずに、S3 の暗号化されたデータに対して SQL クエリを直接実行できることです。下の画像でクエリの結果を見ることができます。これをダッシュボードとして組織内の誰とでも簡単に共有できるようになりました。

Amazon AppFlow が本日リリースされ、S3 および 13 の SaaS アプリケーションがデータソースとしてサポートされ、S3、Amazon Redshift、Salesforce、Snowflake を宛先に指定できます。サービスが発展するにつれ、数百のアプリケーションを追加する予定です。

このサービスは、サービスへの要求を満たすために自動的にスケールアップまたはスケールダウンします。また、1 つのフローで 100GB を転送できるため、データをバッチに分割する必要がありません。高可用性と弾力性を備えた設計になっているため、最も価値のあるデータの転送に Amazon AppFlow を信頼してご利用いただけます。

Amazon AppFlow は、本日より米国東部 (バージニア北部)、米国東部 (オハイオ)、米国西部 (北カリフォルニア)、米国西部 (オレゴン)、カナダ (中部)、アジアパシフィック (シンガポール)、アジアパシフィック (東京)、アジアパシフィック (シドニー)、アジアパシフィック (ソウル)、アジアパシフィック (ムンバイ)、欧州 (パリ)、欧州 (アイルランド)、欧州 (フランクフルト)、欧州 (ロンドン)、南米 (サンパウロ) でご利用いただけ、今後サービスを提供するリージョンを拡大する予定です。

新しいデータフロー体験をお楽しみください