さまざまな業界の企業が、ビジネスイノベーションを推進し、カスタマーエクスペリエンスを向上させ、プロセスを改善するために、人工知能 (AI) を活用した変革に注目しています。AI アプリケーションを強化する機械学習 (ML) モデルはますます複雑化しており、その結果、基礎となるコンピューティングインフラストラクチャのコストが増加しています。ML アプリケーションの開発と実行にかかるインフラストラクチャ支出の最大 90% は、多くの場合、推論に費やされます。お客様は、ML アプリケーションを本稼働環境にデプロイするための費用対効果の高いインフラストラクチャソリューションを求めています。

Amazon EC2 Inf1 インスタンスは、高パフォーマンスかつ低コストの ML 推論を提供します。同等の Amazon EC2 インスタンスと比較して、スループットが最大 2.3 倍高く、推論あたりのコストが最大 70% 削減されます。Inf1 インスタンスは ML 推論アプリケーションをサポートするためにゼロから構築されました。AWS が設計開発した高パフォーマンスの ML 推論チップである、AWS Inferentia チップを最大 16 個搭載しています。さらに、Inf1 インスタンスには、第 2 世代の Intel Xeon スケーラブルプロセッサと最大 100 Gbps のネットワークが搭載されており、高いスループットの推論が可能です。

お客様は、Inf1 インスタンスを使用して、検索、レコメンデーション、コンピュータービジョン、音声認識、自然言語処理 (NLP)、パーソナライゼーション、不正検出といった大規模な ML 推論アプリケーションを実行できます。

デベロッパーは、TensorFlow、PyTorch、MXNet などの一般的な ML フレームワークと統合されている AWS Neuron SDK を使用して、Inf1 インスタンスに ML モデルをデプロイできます。 デベロッパーは引き続き同じ ML ワークフローを使用し、最小限のコード変更で、かつ、ベンダー固有のソリューションに縛られることなく、シームレスにアプリケーションを Inf1 インスタンスに移行できます。

Amazon SageMaker、Neuron SDK で事前設定された AWS Deep Learning AMI (DLAMI)、Amazon Elastic Container Service (Amazon ECS) または Amazon Elastic Kubernetes Service (Amazon EKS) を使用して Inf1 インスタンスを簡単に使用開始できます。

メリット

推論作業あたり最大 70% のコスト削減

Inf1 を使用すると、デベロッパーは、ML の本稼働用デプロイコストを大幅に削減できます。Inf1 インスタンスの低いインスタンスコストと高いスループットの組み合わせにより、同等の Amazon EC2 インスタンスよりも推論あたり最大 70% のコストを削減できます。

使いやすさとコードの移植性

Neuron SDK は、TensorFlow、PyTorch、MXNet などの一般的な ML フレームワークと統合されています。デベロッパーは引き続き同じ ML ワークフローを使用し、最小限のコード変更でアプリケーションを Inf1 インスタンスにシームレスに移行できます。これにより、ベンダー固有のソリューションに縛られることなく、任意の ML フレームワーク、および要件に最適なコンピューティングプラットフォームを自由に使用し、最新のテクノロジーを活用することができます。

最大 2.3 倍のスループット

Inf1 インスタンスは、同等の Amazon EC2 インスタンスよりも最大 2.3 倍高いスループットを提供します。 Inf1 インスタンスを強化する AWS Inferentia チップは、小さなバッチサイズでの推論パフォーマンス向けに最適化されているため、リアルタイムアプリケーションでのスループットを最大化し、レイテンシー要件を満たすことができます。

極めて低いレイテンシー

AWS Inferentia チップには、ML モデルをチップ自体に直接キャッシュできる大容量のオンチップメモリが装備されています。NeuronCore Pipeline などの機能を使用してモデルをデプロイすると、外部のメモリリソースにアクセスする必要がなくなります。Inf1 インスタンスを使用すると、帯域幅に影響を与えることなく、ほぼリアルタイムのレイテンシーでリアルタイムの推論アプリケーションをデプロイできます。

さまざまな ML モデルとデータタイプのサポート

Inf1 インスタンスは、画像認識/分類のための SSD、VGG、ResNext や、NLP のための Transformer や BERT など、一般的に使用されている多くの ML モデルアーキテクチャをサポートしています。さらに、Neuron での HuggingFace モデルリポジトリのサポートにより、お客様は、コードを 1 行変更するだけで、事前トレーニング済みモデルや微調整済みモデルを使用して簡単に推論をコンパイルおよび実行できます。複合精度の BF16 および FP16 といった複数のデータ型もサポートし、幅広いモデルとパフォーマンスのニーズに対応しています。

特徴

AWS Inferentia の搭載

AWS Inferentia は AWS が専用に構築した ML チップで、高パフォーマンスかつ低コストを実現します。AWS Inferentia の各チップは 4 つの第 1 世代 NeuronCore を搭載し、最大 128 テラ演算/秒 (TOPS) のパフォーマンスと、FP16、BF16、INT8 データ型をサポートしています。AWS Inferentia チップは、大規模モデルのキャッシュに使用できる大量のオンチップメモリも備えています。これは、頻繁なメモリアクセスを必要とするモデルに特に役立ちます。

AWS Neuron を使用して一般的な ML フレームワークでデプロイする

AWS Neuron SDK は、コンパイラ、ランタイムドライバー、プロファイリングツールで構成されています。TensorFlow、PyTorch、MXNet などの一般的なフレームワークで作成およびトレーニングした複雑なニューラルネットモデルのデプロイを、Inf1 インスタンスを使用して実行できます。NeuronCore Pipeline を使用することで、高速の物理的なチップ間相互接続を使って、大規模モデルを分割して複数の Inferentia チップで実行することができ、高いスループットかつ低コストの推論を実現できます。

高パフォーマンスのネットワークとストレージ

Inf1 インスタンスは、高速ネットワークへのアクセスを必要とするアプリケーションに、最大 100 Gbps のネットワークスループットを提供します。次世代の Elastic Network Adapter (ENA) と NVM Express (NVMe) テクノロジーにより、Inf1 インスタンスではネットワーキングと Amazon Elastic Block Store (Amazon EBS) 向けに高スループットで低レイテンシーのインターフェイスを利用できます。

AWS Nitro System 上での構築

AWS Nitro System は構築ブロックを豊富に取り揃え、従来の仮想化機能の多くを専用のハードウェアとソフトウェアにオフロードして、仮想化のオーバーヘッドを削減しながら、高いパフォーマンス、可用性、セキュリティを実現します。

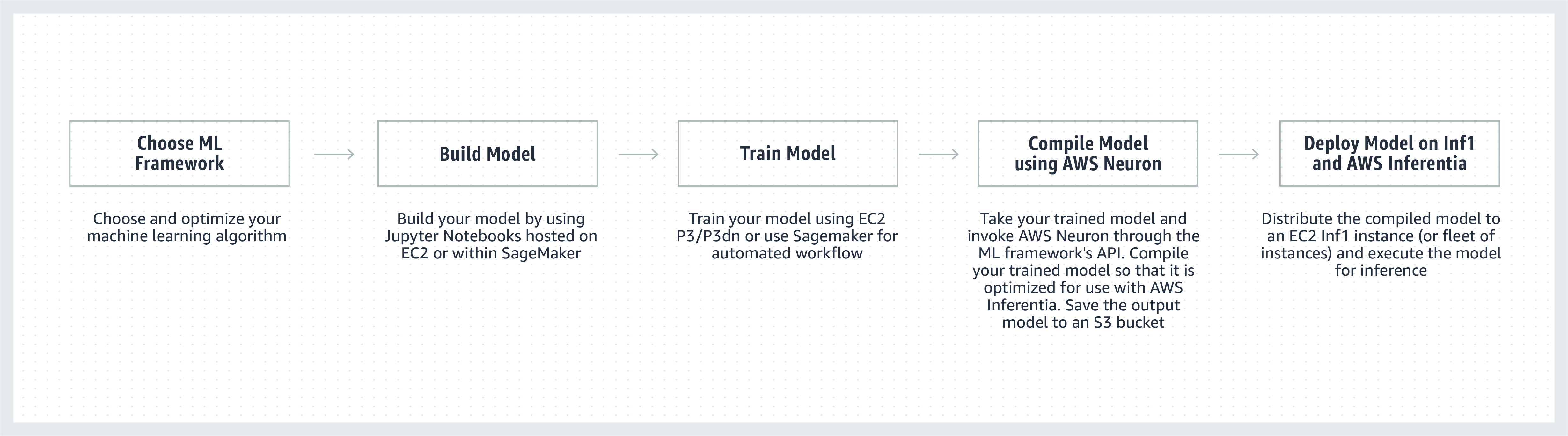

仕組み

お客様の声

2008 年にサンフランシスコで設立された Airbnb は、400 万人以上のホストが、世界のほぼすべての国で 9 億人以上のゲストを迎え入れているコミュニティマーケットプレイスです。

「Airbnb のコミュニティサポートプラットフォームは、世界中の何百万人ものゲストとホストからなるコミュニティに対して、インテリジェントでスケーラブル、かつ卓越したサービスエクスペリエンスを実現します。当社は、サポートチャットボットアプリケーションが使用する NLP モデルのパフォーマンスを向上させる方法を常に模索しています。AWS Inferentia 搭載の Amazon EC2 Inf1 インスタンスでは、PyTorch ベースの BERT モデルで、GPU ベースのインスタンスと比較して、2 倍のスループットの向上が見られました。将来的には、他のモデルやユースケースにも Inf1 インスタンスを活用したいと考えています」

Bo Zeng 氏、エンジニアリングマネージャー、Airbnb

「私たちは Snapchat の多くの側面において ML を組み込んでおり、この分野のイノベーションを探求することを重要な優先事項としています。Inferentia について聞いた後、AWS との連携を開始して Inf1/Inferentia インスタンスを採用し、パフォーマンスやコストなど、ML のデプロイを支援しました。私たちは推奨モデルから始めましたが、今後は Inf1 インスタンスでさらに多くのモデルを採用することを楽しみにしています」

Nima Khajehnouri 氏、エンジニアリング担当バイスプレジデント、Snap Inc.

「Sprinklr の AI を活用した統合カスタマーエクスペリエンス管理 (Unified-CXM) プラットフォームは、企業が複数のチャネルを通じたリアルタイムのカスタマーフィードバックを収集し、実用的なインサイトに変換できるようにします。これにより、積極的な問題解決、製品開発の強化、コンテンツマーケティングの改善、カスタマーサービスの向上などを実現します。Amazon EC2 Inf1 を使用することで、NLP モデルのパフォーマンスを大幅に向上させ、コンピュータビジョンモデルの 1 つのパフォーマンスを向上させることができました。今後も Amazon EC2 Inf1 を利用して、世界中のお客様により良いサービスを提供していきたいと思います」

Vasant Srinivasan 氏、プロダクトエンジニアリング担当シニアバイスプレジデント、Sprinklr

「当社の最先端の NLP 製品である Finch for Text は、膨大な量のテキストから複数タイプのエンティティを抽出、明確化、強化する能力をユーザーに提供します。Finch for Text は、グローバルなデータフィードで低レイテンシーのエンリッチメントをクライアントに提供するために、膨大なコンピューティングリソースを必要とします。現在、当社の PyTorch NLP、翻訳、およびエンティティ語義曖昧性解消回避モデルで、AWS Inf1 インスタンスを使用しています。推論スピードとパフォーマンスを維持しながら、最小限の最適化で推論コストを 80% 以上 (GPU の場合) 削減することができました。この改善により、当社のお客様は、ストリーミングデータフィード上で、世界規模でフランス語、スペイン語、ドイツ語、オランダ語のテキストをリアルタイムにエンリッチすることができます。これは、金融サービス、データアグリゲータ、公共部門のお客様にとって非常に重要なことです」

Scott Lightner 氏、最高技術責任者、Finch Computing

「当社は、世界中のさまざまな種類のイベントを、さまざまな言語、さまざまな形式 (画像、ビデオ、音声、テキストセンサー、これらすべての種類の組み合わせ) で数十万のソースから警告します。その規模を考えると、スピードとコストを最適化することは、当社のビジネスにとって絶対的に重要です。AWS Inferentia により、モデルのレイテンシーが短縮され、1 USD あたりのスループットが最大 9 倍向上しました。これにより、コストを抑えながら、より高度な DL モデルを導入し、5 倍のデータ量を処理することで、モデルの精度を向上させ、プラットフォーム機能を拡大することができました」

Alex Jaimes 氏、チーフサイエンティスト兼 AI 担当シニアバイスプレジデント、Dataminr

「Autodesk は、Inferentia を使用して、AI を活用した仮想アシスタントである Autodesk Virtual Agent (AVA) の認知テクノロジーを進歩させています。AVA は、自然言語理解 (NLU) と深層学習 (DL) の手法を適用して、問い合わせの背後にあるコンテキスト、意図、および意味を抽出することにより、お客様から毎月寄せられる 100,000 件以上の質問に回答しています。Inferentia のパイロット運用では、NLU モデルで G4dn よりも 4.9 倍高いスループットを得ることができました。Inferentia ベースの Inf1 インスタンスで多くのワークロードを実行できることを楽しみにしています」

Binghui Ouyang 氏、シニアデータサイエンティスト、Autodesk

Amazon EC2 Inf1 インスタンスを使用した Amazon サービス

Amazon Advertising は、あらゆる規模の企業が、ショッピングジャーニーのあらゆる段階でお客様とつながることを可能にします。テキストや画像を含む何百万もの広告が、最適なカスタマーエクスペリエンスを実現するために、毎日、管理、分類、配信されています。

「テキスト広告の処理では、PyTorch ベースの BERT モデルを AWS Inferentia ベースの Inf1 インスタンスにグローバルにデプロイしています。GPU から Inferentia に移行することで、同等のパフォーマンスで 69% のコスト削減を実現しました。AWS Inferentia 用のモデルのコンパイルとテストには、3 週間もかかりませんでした。Amazon SageMaker を使用してモデルを Inf1 インスタンスにデプロイすることで、デプロイのスケーラビリティと管理のしやすさが確保されました。コンパイルしたモデルを初めて分析したとき、AWS Inferentia でのパフォーマンスは非常に印象的で、実際にベンチマークを再実行してそれらが正しいこと確認しなければなりませんでした。 今後は、画像広告の処理モデルを Inferentia に移行していく予定です。これらのモデルでは、同等の GPU ベースのインスタンスと比較して、30% のレイテンシー低下と 71% のコスト削減がすでにベンチマークされています」

Yashal Kanungo、応用科学者、Amazon Advertising

ニュースブログを読む »

「AWS を基盤とした Amazon Alexa の AI と ML ベースのインテリジェンスは、現在 1 億台を超えるデバイスで利用できます。当社は、Alexa をよりスマートかつ能動的にするとともに、さらに多くの対話を可能にし、これまでよりも多くの喜びをもたらすものとなるようにするための努力を惜しまないことをお約束します。これを実現するには、応答時間と機械学習インフラストラクチャのコストを継続的に改善する必要があります。そのため、当社は、Amazon EC2 Inf1 を使用して、Alexa のテキスト読み上げ推論のレイテンシーや推論あたりのコストを削減できることに期待を寄せています。Amazon EC2 Inf1 を使用すれば、Alexa を毎月使用する何千万人ものお客様へのサービスをさらに改善することができます」

Tom Taylor、シニアバイスプレジデント、Amazon Alexa

「当社は、カスタマーエクスペリエンスをさらに向上させ、インフラストラクチャコストを削減するために、常に技術革新に取り組んでいます。ウェブベースの質問応答 (WBQA) ワークロードを GPU ベースの P3 インスタンスから AWS Inferentia ベースの Inf1 インスタンスに移行することで、推論コストを 60% 削減できただけでなく、エンドツーエンドのレイテンシーを 40% 以上改善し、Alexa を使ったお客様の Q&A エクスペリエンスの向上に貢献しています。TensorFlow ベースのモデルに Amazon SageMaker を使用することで、Inf1 インスタンスへの切り替えプロセスが簡単になり、管理しやすくなりました。現在、これらの WBQA ワークロードを実行するためにグローバルに Inf1 インスタンスを使用しており、コストとレイテンシーをさらに削減するために AWS Inferentia でパフォーマンスを最適化しています」

Eric Lind、ソフトウェア開発エンジニア、Alexa AI

「Amazon Prime Video では、ライブイベントの動画品質をコンピュータビジョンの機械学習モデルを使用して解析し、Prime Video 会員に最適な視聴者エクスペリエンスを提供します。EC2 Inf1 インスタンスに画像分類機械学習モデルをデプロイしたところ、パフォーマンスが 4 倍向上し、コストも最大で 40% 削減することができました。現在、これらのコスト削減を活用して、オーディオファイルと動画ファイル間の同期のずれなど、より複雑な不具合を検出できる高度なモデルを革新および構築し、Prime Video 会員にさらに強化した視聴者エクスペリエンスを提供したいと考えています」

Victor Antonino、ソリューションアーキテクト、Amazon Prime Video

「Amazon Rekognition は、お客様がオブジェクト、人、テキスト、アクティビティを識別するのに役立つ、シンプルで簡単な画像および動画分析アプリケーションです。Amazon Rekognition には、お客様のために毎日何十億もの画像や動画を分析できる高性能の DL インフラストラクチャが必要です。AWS Inferentia ベースの Inf1 インスタンスでは、オブジェクト分類などの Amazon Rekognition モデルを実行すると、GPU でこれらのモデルを実行する場合と比較して、レイテンシーが 8 倍低くなり、スループットが 2 倍になります。これらの結果に基づいて、Amazon Rekognition を Inf1 に移行し、お客様がより早く正確な結果を取得できるようにします」

Rajneesh Singh、ディレクター、SW エンジニアリング、Amazon Rekognition and Video

料金

* ここでは、米国東部 (バージニア北部) の AWS リージョンでご利用いただいた場合の料金を示しています。1 年間または 3 年間のリザーブドインスタンスの料金は、「一部前払い」オプション、あるいは一部前払いオプションのないインスタンスの「前払いなし」オプションに対応します。

Amazon EC2 Inf1 インスタンスは、米国東部 (バージニア北部)、米国西部 (オレゴン) の AWS リージョンにおいて、オンデマンドインスタンス、リザーブドインスタンス、またはスポットインスタンスとしてご利用いただけます。

開始方法

Amazon SageMaker の使用

Amazon SageMaker を使用すると、トレーニング済みの ML モデルを簡単にコンパイルして Amazon Inf1 インスタンスの本番環境にデプロイできるため、低レイテンシーでリアルタイム予測の生成を開始できます。AWS Inferentia 向けコンパイラの AWS Neuron は、Amazon SageMaker Neo と統合しており、トレーニング済みの ML モデルをコンパイルして、Inf1 インスタンスで最適に実行できます。Amazon SageMaker を使用すると、複数のアベイラビリティーゾーンに分散した Inf1 インスタンスの自動スケーリングクラスターでモデルを簡単に実行し、高いパフォーマンスと可用性の両方のリアルタイム推論を実現できます。Github のサンプルを使用して、Amazon SageMaker を Inf1 にデプロイする方法を学びましょう。

DLAMI を使用する

DLAMI では ML の専門家と研究者がクラウド上であらゆる規模の DL を加速させるためのインフラストラクチャとツールを提供しています。AWS Neuron SDK は DLAMI にあらかじめインストールされており、Inf1 インスタンスで ML モデルを最適にコンパイルして実行できます。使用開始のプロセスについての詳細は、AMI 選択ガイドやその他の DL リソースをご覧ください。Neuron で DLAMI を使用する方法については、AWS DLAMI の使用開始ガイドを参照してください。

Deep Learning Containers の使用

デベロッパーは、フルマネージド型 Kubernetes サービスである Amazon EKS と、Amazon のフルマネージド型コンテナオーケストレーションサービスである Amazon ECS に Inf1 インスタンスをデプロイできるようになりました。Amazon EKS または Amazon ECS での Inf1 の使用開始についての詳細はこちらをご覧ください。Inf1 インスタンスでのコンテナ実行についての詳細は、Neuron コンテナツールのチュートリアルのページを参照してください。Neuron は、AWS Deep Learning Containers にあらかじめインストールされた状態でも利用できます。

ブログと記事

Amazon Search が AWS Inferentia で ML 推論コストを 85% 削減した方法

Joao Moura、Jason Carlson、Jaspreet Singh、Shaohui Xi、Shruti Koparkar、Haowei Sun、Weiqi Zhang、Zhuoqi Zhangs、2022 年 9 月 22 日

高性能で低コストの機械学習インフラストラクチャがクラウドのイノベーションを加速

MIT Technology Review Insights、2021 年 11 月 1 日

Amazon SageMaker を使用したコンピュータビジョン推論に最適な AI アクセラレーターとモデルコンパイルを選択する

Davide Galliteli と Hasan Poonawala、2021 年 10 月 19 日

MIT Technology Review Insights、2021 年 10 月 15 日

AWS Inferentia を使用して Amazon EKS で 3,000 の深層学習モデルを 1 時間あたり 50 USD 未満で提供

by Alex Iankoulski、Joshua Correa、Mahadevan Balasubramaniam、Sundar Ranganatha、2021 年 9 月 30 日

AWS Inferentia ですぐに使用できる PyTorch 自然言語処理アプリケーションで 12 倍のスループットと最小のレイテンシーを実現

Fabio Nonato de Paula、Mahadevan Balasubramaniam、2021 年 5 月 4 日

AWS Inferentia を使用して、Autodesk Ava Chatbot の PyTorch NLP モデルのパフォーマンスを 4.9 倍向上させた方法

Binghui Ouyang、2021 年 4 月 7 日

Alexa の大部分をより高速で費用効果の高い Amazon EC2 Inf1 インスタンスで実行

Sébastien Stormacq、2020 年 11 月 12 日

Amazon SageMaker での Inf1 インスタンスの可用性により、高性能で費用対効果の高い機械学習推論の提供をお知らせ

Julien Simon、2020 年 4 月 22 日

Amazon ECS が EC2 Inf1 インスタンスのサポートを開始

Julien Simon、2020 年 8 月 14 日

AWS Inferentia ベースの Inf1 インスタンスに TensorFlow OpenPose をデプロイして、価格パフォーマンスを大幅に改善

Fabio Nonato De Paula および Haichen Li による投稿 (2020/7/22)

Amazon EKS が EC2 Inf1 インスタンスのサポートを開始

Julien Simon、2020 年 6 月 15 日

ブログ: Amazon EC2 アップデート – 高性能で費用対効果の高い推論のための AWS Inferentia チップを備えた Inf1 インスタンス

Jeff Barr、2019 年 3 月 12 日

オブジェクト検出モデルを大規模に実行するクラス最高のパフォーマンスを備えた AWS Inferentia が 11 の AWS リージョンで利用可能に

Gadi Hutt、2020 年 9 月 28 日