RLHF là gì?

Học tăng cường từ phản hồi của con người (RLHF) là một kỹ thuật máy học (ML) sử dụng phản hồi của con người để tối ưu hóa các mô hình ML, giúp tự học hiệu quả hơn. Các kỹ thuật học tăng cường (RL) đào tạo phần mềm để đưa ra quyết định tối đa hóa phần thưởng, giúp kết quả chính xác hơn. RLHF tích hợp phản hồi của con người trong chức năng phần thưởng, vì vậy, mô hình ML có thể thực hiện các nhiệm vụ phù hợp hơn với mục tiêu, mong muốn và nhu cầu của con người. RLHF được sử dụng trong các ứng dụng trí tuệ nhân tạo tạo sinh (AI tạo sinh), được gộp trong các mô hình ngôn ngữ lớn (LLM).

Tại sao RLHF quan trọng?

Trí tuệ nhân tạo (AI) có phạm vi ứng dụng rộng rãi, từ ô tô tự lái đến xử lý ngôn ngữ tự nhiên (NLP), dự báo thị trường chứng khoán và dịch vụ cá nhân hóa bán lẻ. Bất kể ứng dụng cụ thể nào, mục tiêu cuối cùng của AI đều là mô phỏng phản ứng, hành vi và ra quyết định của con người. Mô hình ML phải mã hóa đầu vào của con người dưới dạng dữ liệu đào tạo để AI mô phỏng giống con người hơn khi hoàn thành các tác vụ phức tạp.

RLHF là một kỹ thuật cụ thể được sử dụng trong việc đào tạo các hệ thống AI để có vẻ giống con người hơn, cùng với các kỹ thuật khác như học có giám sát và không có giám sát. Đầu tiên, câu trả lời của mô hình được so sánh với câu trả lời của con người. Sau đó, một người đánh giá chất lượng của các câu trả lời khác nhau từ máy, chấm điểm xem câu trả lời nào nghe có vẻ giống con người hơn. Điểm số có thể dựa trên các đặc điểm bẩm sinh của con người, chẳng hạn như tính thân thiện, mức độ phù hợp của bối cảnh và tâm trạng.

RLHF là kỹ thuật nổi bật trong việc hiểu ngôn ngữ tự nhiên nhưng cũng được sử dụng trên các ứng dụng AI tạo sinh khác.

Tìm hiểu về xử lý ngôn ngữ tự nhiên

Tìm hiểu về điểm khác biệt giữa học có giám sát và học không có giám sát

Nâng cao hiệu năng của AI

RLHF giúp mô hình ML chính xác hơn. Bạn có thể đào tạo một mô hình có thể đào tạo trên dữ liệu con người được tạo trước nhưng nếu có thêm các vòng phản hồi của con người sẽ giúp cải thiện đáng kể hiệu năng của mô hình so với trạng thái ban đầu.

Ví dụ: khi văn bản được dịch từ ngôn ngữ này sang ngôn ngữ khác, một mô hình có thể tạo ra văn bản chính xác về mặt kỹ thuật nhưng nghe có vẻ không tự nhiên đối với người đọc. Dịch giả chuyên nghiệp có thể dịch trước để làm tiêu chuẩn chấm điểm bản dịch do máy tạo ra và sau đó, có thể chấm điểm chất lượng cho một loạt các bản dịch do máy tạo ra. Việc bổ sung đào tạo thêm cho mô hình giúp mô hình tạo ra các bản dịch nghe có vẻ tự nhiên một cách hiệu quả hơn.

Đưa vào sử dụng các thông số đào tạo phức tạp

Trong một số trường hợp của AI tạo sinh, có thể khó đào tạo chính xác mô hình cho các thông số nhất định. Ví dụ: làm thế nào để xác định tâm trạng của một bản nhạc? Có thể có các thông số kỹ thuật như âm điệu và nhịp độ cho biết một tâm trạng nhất định nhưng tinh thần của một tác phẩm âm nhạc có tính chủ quan hơn và được xác định kém rõ ràng hơn so với trường hợp chỉ xét một loạt các kỹ thuật chuyên môn. Thay vào đó, bạn có thể đưa ra hướng dẫn của con người, trong đó các nhà soạn nhạc tạo ra các tác phẩm buồn và sau đó, bạn có thể dán nhãn các tác phẩm do máy tạo ra theo mức độ buồn của tác phẩm. Điều này giúp máy học các thông số này nhanh hơn nhiều.

Nâng cao sự hài lòng của người dùng

Mặc dù mô hình ML có thể chính xác nhưng có thể không giống con người. Do đó, cần có RL để hướng mô hình hướng tới câu trả lời phù hợp nhất, hấp dẫn nhất cho người dùng con người.

Ví dụ: nếu bạn hỏi về thời tiết bên ngoài, chatbot có thể trả lời, “Trời 30 độ C, có mây và độ ẩm cao” hoặc “Nhiệt độ vào lúc này là khoảng 30 độ C. Trời nhiều mây và ẩm ướt, vì vậy, không khí có vẻ đặc quánh hơn!” Mặc dù cả hai câu trả lời đều cung cấp thông tin giống nhau nhưng câu trả lời thứ hai nghe có vẻ tự nhiên hơn và cung cấp nhiều bối cảnh hơn.

Khi người dùng đánh giá câu trả lời của mô hình họ thích hơn, bạn có thể sử dụng RLHF để thu thập phản hồi của con người và cải thiện mô hình sao cho phục vụ người thật ở mức tốt nhất.

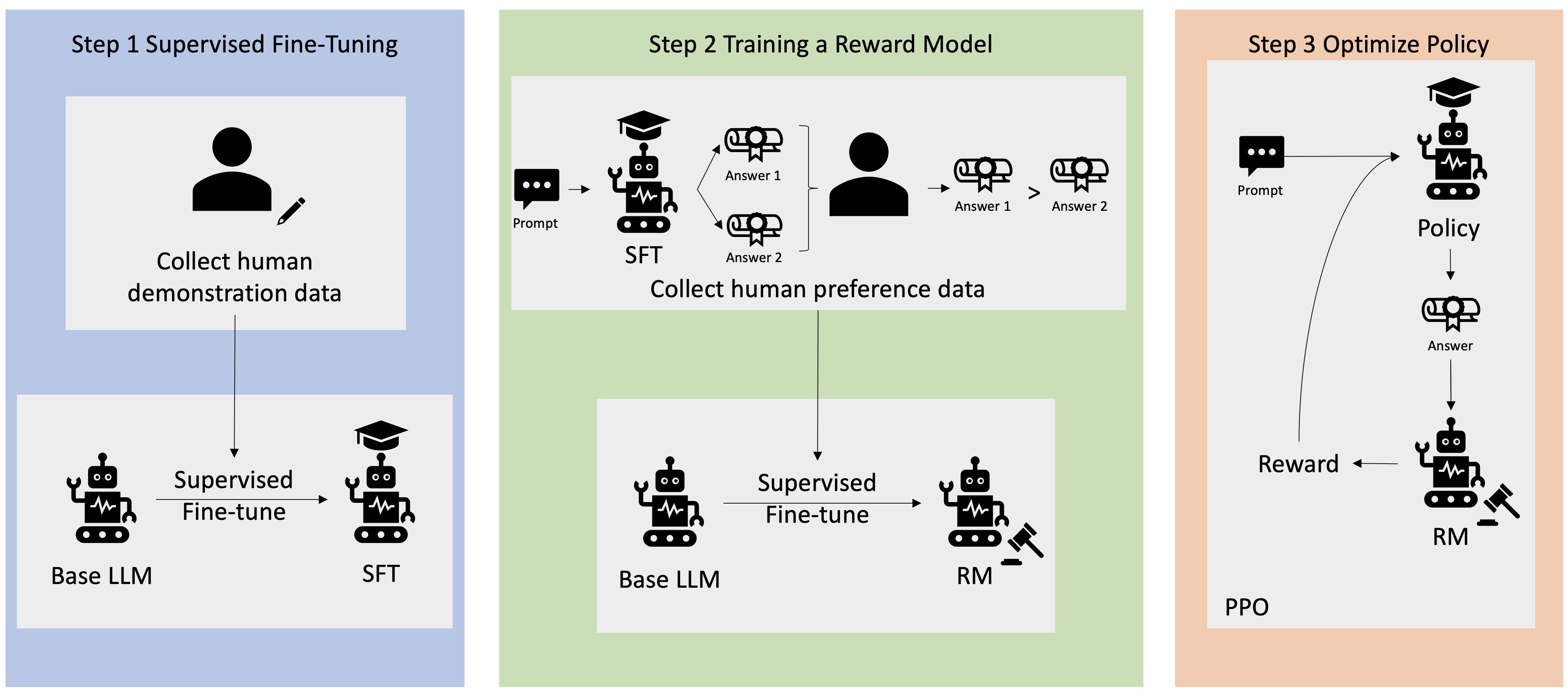

RLHF hoạt động như thế nào?

RLHF được thực hiện trong bốn giai đoạn trước khi mô hình được coi là sẵn sàng. Ở đây, chúng tôi lấy ví dụ về mô hình ngôn ngữ là một chatbot dựa trên cơ sở kiến thức nội bộ của công ty. Mô hình này sử dụng RLHF để tinh chỉnh.

Chúng tôi chỉ cung cấp thông tin tổng quan về quá trình học tập. Quá trình đào tạo mô hình và tinh chỉnh chính sách của mô hình cho RLHF có mức độ phức tạp toán học đáng kể. Tuy nhiên, các quy trình phức tạp được xác định rõ trong RLHF và thường có các thuật toán được tạo sẵn chỉ cần đầu vào riêng của bạn.

Thu thập dữ liệu

Trước khi thực hiện các tác vụ ML với mô hình ngôn ngữ, một tập hợp các lời nhắc và câu trả lời do con người tạo ra được tạo cho dữ liệu đào tạo. Tập hợp này được sử dụng sau trong quá trình đào tạo của mô hình.

Ví dụ: lời nhắc có thể là:

- “Bộ phận nhân sự tại Boston ở địa điểm nào?”

- “Quy trình phê duyệt cho các bài đăng trên mạng xã hội là gì?”

- “Báo cáo quý 1 cho thấy điều gì về doanh số so với các báo cáo hàng quý trước đó?”

Sau đó, một nhân viên tri thức trong công ty trả lời những câu hỏi này bằng những câu trả lời chính xác, tự nhiên.

Tinh chỉnh có giám sát của mô hình ngôn ngữ

Bạn có thể sử dụng mô hình thương mại được đào tạo trước làm mô hình cơ sở cho RLHF. Bạn có thể tinh chỉnh mô hình theo cơ sở kiến thức nội bộ của công ty bằng cách sử dụng các kỹ thuật như tạo tăng cường truy xuất (RAG). Khi mô hình được tinh chỉnh, bạn so sánh câu trả lời của mô hình với các lời nhắc đã xác định trước với các câu trả lời của con người được thu thập trong bước trước đó. Các kỹ thuật toán học có thể tính mức độ tương đồng giữa cả hai.

Ví dụ: các câu trả lời do máy tạo có thể được gán điểm từ 0 đến 1, trong đó 1 là chính xác nhất và 0 là ít chính xác nhất. Với những điểm số này, mô hình hiện có một chính sách được thiết kế để tạo các câu trả lời có điểm gần hơn với câu trả lời của con người. Chính sách này tạo thành cơ sở của tất cả các quyết định trong tương lai cho mô hình đó.

Xây dựng một mô hình phần thưởng riêng biệt

Cốt lõi của RLHF là đào tạo một mô hình phần thưởng AI riêng biệt dựa trên câu trả lời của con người và sau đó sử dụng mô hình này như một chức năng phần thưởng để tối ưu hóa chính sách thông qua RL. Với một tập hợp nhiều câu trả lời từ mô hình trả lời cùng một lời nhắc, con người có thể chỉ ra tùy chọn của họ liên quan đến chất lượng của từng câu trả lời. Bạn sử dụng các tùy chọn xếp hạng câu trả lời này để xây dựng mô hình phần thưởng tự động ước tính mức điểm một người sẽ chấm cho phản hồi lời nhắc cụ thể bất kỳ.

Tối ưu hóa mô hình ngôn ngữ với mô hình dựa trên phần thưởng

Sau đó, mô hình ngôn ngữ sử dụng mô hình phần thưởng để tự động tinh chỉnh chính sách trước khi trả lời lời nhắc. Thông qua mô hình phần thưởng, mô hình ngôn ngữ đánh giá nội bộ một loạt các câu trả lời và sau đó chọn câu trả lời có nhiều khả năng mang lại phần thưởng lớn nhất. Điều này có nghĩa là câu trả lời đó đáp ứng tùy chọn của con người một cách tối ưu hóa hơn.

Hình ảnh sau đây cho thấy tổng quan về quá trình học tập RLHF.

RLHF được sử dụng như thế nào trong lĩnh vực AI tạo sinh?

RLHF được công nhận là kỹ thuật tiêu chuẩn trong ngành để đảm bảo LLM tạo ra nội dung trung thực, không có hại và hữu ích. Tuy nhiên, giao tiếp của con người là một quá trình chủ quan, sáng tạo và mức độ hữu ích của đầu ra LLM bị ảnh hưởng sâu sắc bởi các giá trị và tùy chọn của con người. Mỗi mô hình được đào tạo có chút khác biệt và sử dụng các bộ trả lời khác nhau của con người, do đó, đầu ra sẽ khác nhau ngay cả giữa các LLM cạnh tranh. Mức độ liên quan đến các giá trị của con người của mỗi mô hình hoàn toàn phụ thuộc vào người tạo.

Các ứng dụng của RLHF vượt qua giới hạn của LLM sang các loại AI tạo sinh khác. Dưới đây là một số ví dụ:

- Có thể sử dụng RLHF trong tạo hình ảnh AI: ví dụ như đo mức độ chân thực, tính chuyên môn hoặc tâm trạng của tác phẩm nghệ thuật

- Trong sáng tác nhạc, RLHF có thể hỗ trợ tạo ra tác phẩm âm nhạc phù hợp với tâm trạng nhất định và nhạc nền cho các hoạt động

- Có thể sử dụng RLHF trong trợ lý giọng nói, hướng dẫn bằng giọng nói để trở nên thân thiện, riêng tư và đáng tin cậy hơn

AWS có thể giúp đáp ứng các yêu cầu về RLHF của bạn như thế nào?

Amazon SageMaker Ground Truth cung cấp bộ khả năng có con người tham gia vào quy trình toàn diện nhất để tích hợp câu trả lời của con người trong suốt vòng đời ML nhằm cải thiện độ chính xác và mức độ phù hợp của mô hình. Bạn có thể hoàn thành nhiều tác vụ khác nhau có con người tham gia vào quy trình, từ tạo và chú thích dữ liệu đến tạo mô hình phần thưởng, đánh giá mô hình và tùy chỉnh thông qua dịch vụ tự phục vụ hoặc dịch vụ được AWS quản lý.

SageMaker Ground Truth bao gồm một chú thích dữ liệu cho các khả năng RLHF. Bạn có thể đưa ra câu trả lời trực tiếp và hướng dẫn về đầu ra do mô hình tạo ra bằng cách xếp hạng, phân loại hoặc thực hiện cả hai tác vụ cho các câu trả lời của mô hình cho kết quả RL. Dữ liệu được gọi là dữ liệu so sánh và xếp hạng hoàn toàn là một mô hình phần thưởng hoặc chức năng phần thưởng, sau đó được sử dụng để đào tạo mô hình. Bạn có thể sử dụng dữ liệu so sánh và xếp hạng để tùy chỉnh mô hình hiện có cho trường hợp sử dụng của mình hoặc để tinh chỉnh mô hình do bạn xây dựng từ đầu.

Bắt đầu sử dụng kỹ thuật RLHF trên AWS bằng cách tạo tài khoản ngay hôm nay.

Các bước tiếp theo trên AWS