Amazon Web Services ブログ

AWS Inferentia を搭載した Inf1インスタンスが東京リージョンで Amazon SageMaker に対応しました

みなさん、こんにちは。アマゾン ウェブ サービス ジャパン、シニアエバンジェリストの亀田です。

AWS Inferentiaを搭載した Inf1インスタンスが東京リージョンにおいて、SageMaker で利用可能になりましたのでお知らせいたします。

AWS Inferentia と Inf1 インスタンスとは?

一般的に機械学習のビジネス利用は、データ準備、学習と推論の 3 つのフェーズに分かれます。このうち学習環境は高価な GPU を搭載した専用 Amazon EC2インスタンスが用いられるケースが多くありその金額が課題となりえます。Amazon SageMaker を使うと高価な学習用インスタンスは、学習が終了した時点で学習用インスタンスを自動で停止させることで無駄な課金を抑えることができ、さらに、Managed Spot Training 機能を使うことで、スポットインスタンスをベースとした安価な学習を行うことが可能です。その学習の結果として推論モデルが生成され、さらに API が生成され商用環境に組み込まれることとなります。

概して、推論環境は高価な GPU 搭載インスタンスが必要な学習環境よりそのコストは安いものとなりますが、一時的かつ反復的に行われる学習環境とことなり、常時起動が前提となることが多く、そのコストは時間とともに積みあがります。さらに、ビジネスが順調に成長した場合、学習環境は中央集権型で構築されるのに対して、推論環境は多くの環境に組み込まれそのコストが課題となっていきます。

AWS Inferentia はこの課題を解決するために AWS が開発した高パフォーマンスの機械学習推論チップです。高性能の推論を提供し、推論の総コストを削減し、デベロッパーが機械学習をビジネスアプリケーションに簡単に統合できるように設計されています。また、Inferentia のワークロードのパフォーマンスを最適化するのに役立つコンパイラ、ランタイム、およびプロファイリングツールから構成される AWS Neuron ソフトウェア開発キット (SDK) は、AWS Inferentia ベースの 環境で TensorFlow、PyTorch、および MXNet などの一般的なフレームワークで作成およびトレーニングされた複雑なニューラルネットモデルを実現します。推論の高速化によるコスト削減は、Neuron Cores と呼ばれる Inferentia のプロセッシングコアにより実現されます。コアはオンチップメモリに格納され、帯域幅によって制限されないモデルに高速でアクセスすることが可能です。

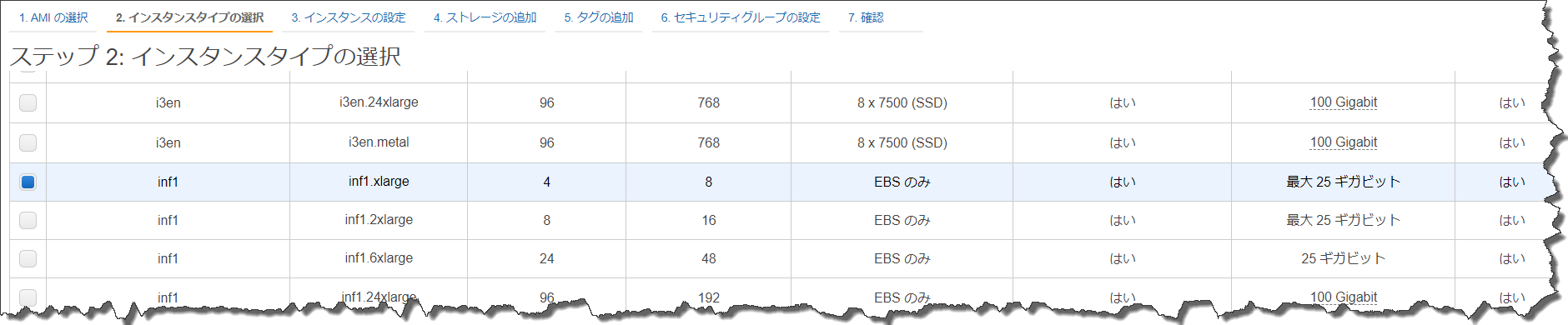

そして、この Inferentia チップを搭載したEC2 インスタンスが AWS Inf1 インスタンスになります。単一のチップで最大 128 TOPS (1 秒あたり数兆回の操作) のパフォーマンスをサポートし、EC2 Inf1 インスタンスごとに最大 16 個の Inferentia チップを有することができます。

Inf1インスタンスは EC2、または、Amazon Elastic Kubernetes Service (EKS) の Amazon EC2 ノードを使用して デプロイすることができます。

そして、今回のアップデートにより東京リージョンにおいて、SageMaker で Inf1 インスタンスが利用可能となりました。すでに SageMaker をご利用いただいている方は、既存の推論エンドポイントのインスタンスを Inf1 に変更することも可能です。

料金や詳細などはこちらからご確認ください。

– シニアエバンジェリスト 亀田;