Amazon Web Services ブログ

AWS Japan の新卒が Kiro でマネコン上の操作を支援する Chrome 拡張機能をチーム開発してみた!

みなさん、こんにちは! 本ブログは Kiroweeeeeeek ( X: #kiroweeeeeeek) の第 […]

Amazon Elastic VMware Service と VMware HCX を活用して、AWS への VMware 移行を加速する

EVS の利点の 1 つとして VMware by Broadcom が提供する強力な移行ツールキットである VMware Cloud Foundation Operations HCX (HCX) との統合が挙げられます。HCX は IP アドレスやネットワーク設定を維持したまま、オンプレミス環境とクラウド環境間でのシームレスなワークロードの移動を実現し、移行に伴う複雑さを軽減します。組織は移行における一般的な課題を克服し、クラウド導入を加速させることができます。本ブログ記事では EVS と HCX を使用してワークロードを AWS に移行する際の接続オプション、設計上の考慮事項、ベストプラクティスについて解説します。ワークロード移行にプライベート接続とパブリック接続のどちらを利用するかは、EVS の初期デプロイ時に行う一度限りの決定事項となります。実装を開始する前にこれらのオプションを理解しておくことが重要です。

グラフデータを使用した Network Digital Twin と Agentic AI を活用した被疑箇所の特定

本記事は 2025 年 8 月 18 日に公開された Beyond Correlation: Finding […]

Octus が Amazon OpenSearch Service へのゼロダウンタイム移行でインフラストラクチャコストを 85% 削減した方法

データ量が指数関数的に増加し続ける中、ミッションクリティカルなワークロードが求める高いパフォーマンスと信頼性を維持しながら、検索インフラストラクチャのコストを最適化するプレッシャーが高まっています。多くの企業は、運用オーバーヘッドが大きく、効率的なスケーリングを制限する複雑で高コストな検索システムを管理しています。検索システム間の移行が必要な場合、この課題はさらに深刻になります。従来、移行には大幅なダウンタイム、複雑なデータ同期、ビジネス運用への大きな影響が伴います。エンタープライズアプリケーションは、カスタマーエクスペリエンス、ビジネスインテリジェンス、運用継続性に影響を与えるサービス中断を許容できません。移行戦略は、移行プロセス全体を通じてゼロダウンタイムを維持し、完全なデータ整合性を確保しながら、コスト最適化と運用改善を実現する必要があります。

2013年に設立された Octus(旧 Reorg)は、世界をリードするバイサイド企業、投資銀行、法律事務所、アドバイザリー企業向けの重要なクレジットインテリジェンスおよびデータプロバイダーです。比類のない人間の専門知識を実績のあるテクノロジー、データ、AI ツールで補完することで、Octus は金融業界全体で決定的なアクションを促す強力なインサイトを提供しています。

この記事では、Octus が Elastic Cloud で実行していた Elasticsearch ワークロードを Amazon OpenSearch Service に移行した方法を紹介します。複数のシステムを管理する状態から、OpenSearch Service を活用したコスト効率の高いソリューションへの移行の道のりをたどります。また、移行を成功させたアーキテクチャの選択と実装戦略を共有します。その結果、移行中もサービスの可用性を中断することなく、パフォーマンスの向上とコスト効率の改善を実現しました。

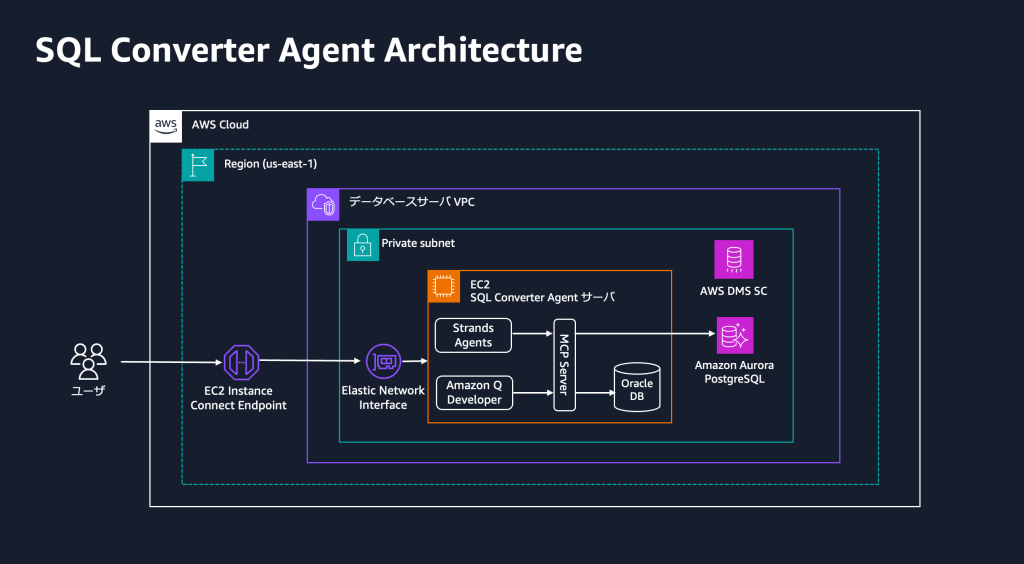

Oracle Database から Amazon Aurora PostgreSQL への移行を加速する生成 AI エージェント

本ブログは三菱電機ビルソリューションズ株式会社様と Amazon Web Services Japan 合同会 […]

Kiro における負債にならない Spec ファイルの扱い方

Kiro の Spec ファイルは「仕様駆動開発」を構成する要素です。Spec ファイルにより仕様を起点として設計・実装を進めることができ、仕様と実装の同期を保ちながら開発を進めることができます。このように Spec ファイルは Kiro の中核をなす要素なのですが、適切に扱わないと負債になってしまう可能性があります。本記事では、「Spec ファイルの切り方」「Spec ファイルの更新方法」「Spec ファイルの共有方法」の 3 つの視点から、負債にならないための工夫をお伝えします。

AWS re:Invent 2025 広告・マーケティングテクノロジーのためのガイド

本記事は 2025 年 11 月 20 日に公開された Anthony Hayes による “Your gui […]

SAPモダンオブザーバビリティフレームワーク:PowerConnectとDynatraceによる監視課題の解決策

モダンなSAP環境では、ビジネスプロセスが単一システムの枠を超えて拡張されるにつれ、高度な監視機能が求められています。組織は現在、SAP Cloud ERP、SAP Business Technology Platform(BTP)、AWSサービス、および様々なクラウドソリューションを含む相互接続されたプラットフォームを管理しています。この複雑性には、システム監視に対する新しいアプローチが必要です。SoftwareOne PowerConnect for SAP Solutionsは、SAPエコシステム全体にわたる広範なカバレッジを提供することで、これらの課題に対処します。そのオブザーバビリティフレームワークは、OpenTelemetry標準を通じて、システム固有の監視を実用的なインテリジェンスに変換し、プロアクティブなパフォーマンス管理とリアルタイムの運用インサイトを可能にします。

複数の組織にわたる AWS 請求とコストを一元管理するための新しい AWS Billing Transfer

2025 年 11 月 19 日、Billing Transfer の一般提供についてお知らせします。これは、 […]

Container Network Observability を使用して、EKS クラスター全体のネットワークパフォーマンスとトラフィックをモニタリング

組織は、マイクロサービスを導入して段階的に革新し、ビジネス価値をより早く提供することで、Kubernetes […]