Amazon Web Services ブログ

AWS for Advertising & Marketing : 目的に応じたサービス、ソリューション、パートナーにより、お客様の業界改革を支援します

この記事は、Introducing AWS for Advertising & Marketing: […]

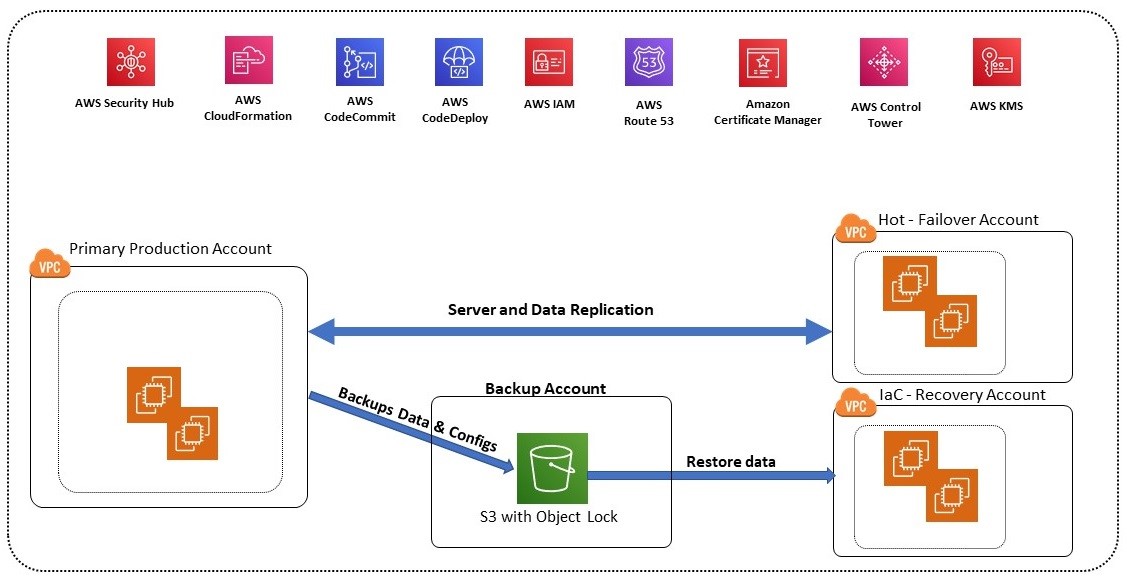

公益企業が Infrastructure as Code によってランサムウェアやその他の災害から復旧する方法

この記事は、「 How energy and utility companies can recover fr […]

AWS Resilience Hub を使ったRTOとRPOの検証と改善

“Everything fails, all the time (故障しないものは無い)” とは、Amazon […]

AWS Glue と Amazon Redshift を活用し、消費財企業が様々な POS データからインサイトを得る

COVID-19 パンデミックによって生じた混乱から産業は回復しつつありますが、消費財(Cconsumer P […]

Amazon OpenSearch Service のインフラストラクチャ障害におけるシャードへの影響

本投稿は AWS Big Data Blog に投稿された Impact of Infrastructure […]

週刊AWS – 2022/12/19週

みなさん、こんにちは。ソリューションアーキテクトの下佐粉です。 今週も週刊AWSをお届けします。 すっかり年の […]

今から始める CCoE、3 つの環境条件と 3 つの心構えとは

昨今、クラウドがビジネスにもたらす経済的価値を追求し、会社や組織全体としてこれを享受するための施策を立案/推進 […]

AWS Systems Manager Automation と CloudWatch アラームで、ディスク容量不足によるパッチ適用の失敗を回避する

全ての組織はパッチを適用してシステム群を最新の状態に保つ必要がある一方、パッチ適用がビジネスやワークロードに影 […]

SAP Private Link Service を使用して SAP BTP サービスと AWS サービスを接続する方法

Zalando Payments GmbH (ZPS)、Georgia Pacific、HP などのお客様は、 […]

コスト配分モデルを用いた組織内のコスト配分の実現

みなさん、こんにちは。カスタマーソリューションマネージャー (CSM) の北川です。今回は AWS コストの最 […]