Amazon Web Services ブログ

Category: AWS Glue

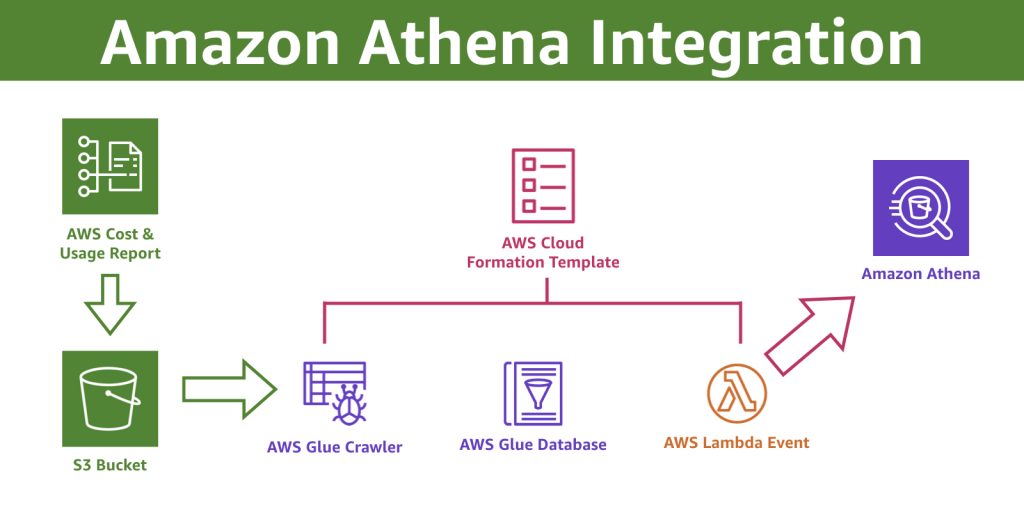

Amazon Athena を使用して AWS Cost and Usage Report をクエリする

AWS Cost and Usage Report には、お客様のコストと使用状況に関する包括的な情報が含まれ […]

Amazon SageMaker、AWS Glue DataBrew、SAP S/4HANAで継続学習型機械学習パイプラインを構築する

機械学習は、デジタルトランスフォーメーションの中核的な役割を担うようになってきています。企業が大規模なパターン […]

小売業におけるアダプティブ分析: 顧客の行動とエンゲージメントに影響を与える

小売業界において、日常業務におけるデータの重要性に異論のある方はいないでしょう。バッチレポートから意思決定支援 […]

小売業のオペレーションを効率化する 7 つのスマートストア戦略

小売業界では、消費者行動の劇的な変化、商品構成の大幅な変更、オンライン注文の大幅な増加に取り組んでいますが、革 […]

Amazon Athena と AWS CloudTrail を使用したAWS Config Rules 利用料の見積もり

AWS Config は、AWSリソースがあるべき設定状態に準拠しているかを監査するサービスです。記録された […]

AWS Glue カスタムブループリントを使ってデータ統合パイプライン開発を簡単にする

本記事はAmazon Web Services, big data architect である Noritak […]

[AWS Black Belt Online Seminar] 猫でもわかる、AWS Glue ETLパフォーマンス・チューニング 資料公開

「猫でもわかる、AWS Glue ETLパフォーマンス・チューニング」 の AWS Black Belt On […]

テラバイト級のデータを Google BigQuery 用 AWS Glue Connector を使って Google Cloud から Amazon S3 へ素早く移行

本記事は Amazon Web Services, Senior Analytics Specialist S […]

AWS Glue パーティションインデックスを使用したクエリパフォーマンスの向上

本記事はAmazon Web Services, Senior Big Data Architect である […]

データメッシュで作る消費財企業向けモダンデータレイクのアーキテクチャ

COVID-19 パンデミック以来、世界中でオンラインショッピングと消費者向け直販(Direct To Con […]