Amazon Web Services ブログ

Category: Database

寄稿:パナソニック インフォメーションシステムズ での Oracle Database@AWS 検証レポート – 閉域接続・バックアップ・Data Guard・監視構成の検証

本稿は、パナソニック インフォメーションシステムズ社による「Oracle Database@AWS 検証レポー […]

Aurora DSQL での Auto Analyze:マルチリージョンデータベースにおけるマネージドオプティマイザー統計

本記事は 2026/02/04に投稿された Auto Analyze in Aurora DSQL: Mana […]

AWS Weekly Roundup: Amazon Bedrock の Claude Opus 4.6、AWS ビルダー ID による Apple でのサインインなど (2026 年 2 月 9 日)

2026 年 2 月 2 日週に行われた注目のリリースとアップデートをご紹介します。これらはすべて、AWS で […]

Amazon RDS for SQL Server で CPU を最適化する設定

この投稿では、新規および既存の Amazon RDS インスタンスの両方において、パフォーマンスを維持しながらライセンス費用を削減する可能性がある CPU 最適化機能の実装方法を、パフォーマンスベンチマーク結果とコストへの影響とともに説明します。

Amazon RDS for SQL Server インスタンスのデータベース名の可視性制御

この投稿では、可視性レベルでのテナント分離を実装し、各テナントが自身のリソースにはアクセスできる一方で、他の顧客のデータベース名は参照できないようにする方法を紹介します。

AWS Lambda と Amazon DynamoDB を使用したクロスアカウントストリーム処理の簡素化

本記事は 2026 年 02 月 09 日 に公開された “Simplify cross-acco […]

Terraform の新機能: Amazon DynamoDB のグローバルセカンダリインデックスのドリフトを管理する

Amazon DynamoDB のグローバルセカンダリインデックス (GSI) のキャパシティを Terraf […]

【寄稿】CO2 排出量可視・削減サービス「e-dash」化を支えるサーバーレスアーキテクチャと IaC 戦略

こんにちは、AWS ソリューションアーキテクトの松本 敢大です。 本日は、三井物産発の環境系スタートアップである e-dash 株式会社様が提供する CO2 排出量可視化・削減サービスプラットフォーム「e-dash」のシステム構築事例をご紹介します。e-dash 株式会社 プロダクト開発部部長の佐藤様、プロダクト開発部の伊藤様、竹内様に、AWS を活用したモダンなアプリケーション開発の取り組みについてお話を伺いました。

AI を活用したゲーム制作: 静的なコンセプトからインタラクティブなプロトタイプへ

AI を活用することで、ゲーム開発の初期段階でコンセプトをインタラクティブにし、数分でプレイ可能なプロトタイプを作成できます。AWS re:Invent 2025 で紹介する Agentic Arcade は、マルチエージェントオーケストレーション、プログラマティックアセット生成、セマンティック検索を組み合わせ、開発サイクルの早い段階で創造的な方向性を探索し検証する方法を示します。

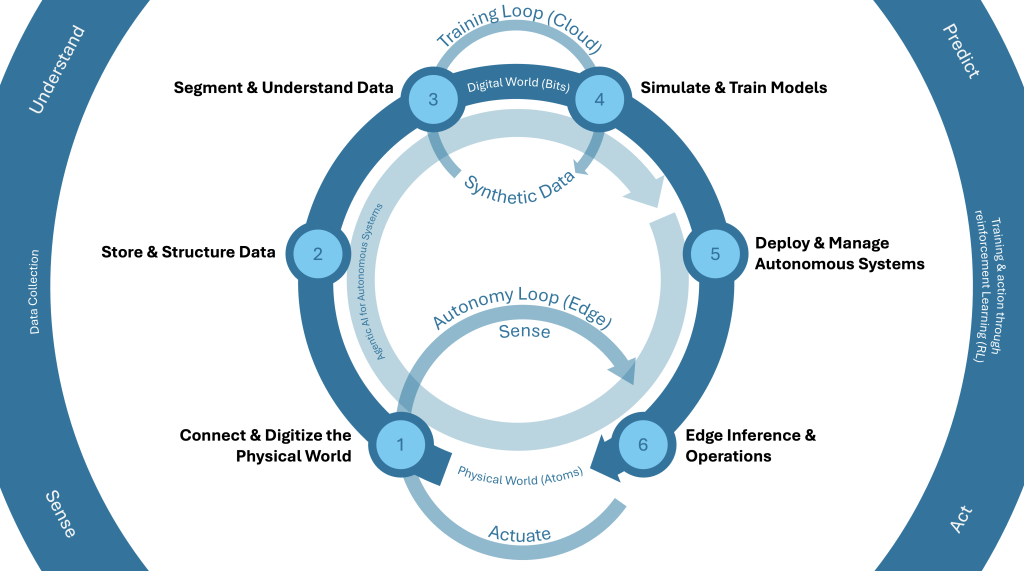

フィジカル AI: 自律型インテリジェンスに向けた次なる基盤を築く

AWS の Physical AI フレームワークは、デジタル世界と物理世界を橋渡しする自律システムを構築するための包括的なアプローチです。物理世界の接続とデジタル化、データの保存と構造化、データのセグメント化と理解、シミュレーションとトレーニング、デプロイと管理、エッジ推論と運用の 6 つの相互接続された機能を通じて、継続的な学習サイクルを作り出し、自律型経済への移行を支援します。