Category: Amazon EC2

進行中 ー Amazon EC2 Elastic GPUs

私は過去にGPUベースのコンピューティングのメリットについて書いてきました。最近では最大16個のGPUを搭載したP2インスタンスのリリースがありました。過去に指摘したように、GPUは驚異的なパワーとスケールを提供し、同時に結果を得るまでの時間と全体的な計算コストを削減する可能性があります。

今日、私たちが取り組んでいる新しいGPUベースの機能について少しお話したいと思います。 もう少しすると既存のEC2インスタンスタイプにグラフィックアクセラレーションを追加することができるようになります。 G2またはP2インスタンスを使用する場合、インスタンスサイズによってGPUの数が決まります。 これは多くの種類のアプリケーションでうまく機能しますが、他の数多くのアプリケーションでも、より新しい、より柔軟なモデルを利用する準備が整ったと考えています。

Amazon EC2 Elastic GPUs

発表されたAmazon EC2 Elastic GPUは、それぞれ異なる長所を提供します。アプリケーションに最適なEC2インスタンスのタイプとサイズを選択でき、また、インスタンスを起動する際にElastic GPUの使用を指定し、4種類のサイズから選択できます。

| Name | GPU Memory |

| eg1.medium | 1 GiB |

| eg1.large | 2 GiB |

| eg1.xlarge | 4 GiB |

| eg1.2xlarge | 8 GiB |

Elastic GPUをM4、C4、およびX1インスタンスで使用できるようになります。 現在、新しいインスタンスを起動するときに新しく作成されたEBSボリュームを設定する機能がありますが、 Elastic GPUについても同様に起動設定の際に希望のサイズを指定したり、実行中のインスタンスを停止、起動することにより変更が可能です。

OpenGLで始める

Amazonに最適化したOpenGLライブラリは、自動的にElastic GPUを検出して使用します。 OpenGLのWindowsのサポートから始め、その後、Amazon Linux AMIやOpenGLの他のバージョンのサポートを追加する予定です。 また、DirectXやVulkanなど他の3D APIのサポートも検討しています(興味があるかどうかをお知らせください)。 既存のMicrosoft Windows AMIのリビジョンにAmazonに最適化したOpenGLライブラリを追加します。

OpenGLはレンダリングには最適ですが、レンダリングされたものはどうやって見ますか? 素晴らしい質問です! 1つの選択肢は、レンダリングされたコンテンツをHTML5と互換性のあるブラウザやデバイスにストリーミングするために、NICE Desktop Cloud Visualization(今年初めに買収 – Amazon Web Services to Acquire NICE)を使用することです。 これには、最近のバージョンのFirefoxとChrome、あらゆる種類の携帯電話とタブレットが含まれます。

このハードウェアとソフトウェアのユニークな組み合わせは、あらゆる種類の3Dビジュアリゼーションやテクニカルコンピューティングアプリケーションの為に素晴らしいホストになると私は信じています。 既に2つのお客様よりフィードバックを共有して頂いております。

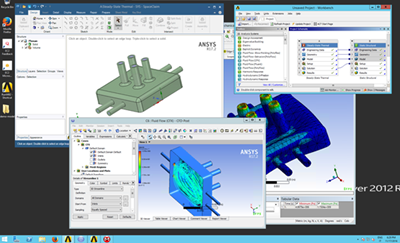

ANSYSの Ray Milhem (VP of Enterprise Solutions & Cloud) のコメント:

ANSYS Enterprise Cloud は、AWSに最適化された仮想シミュレーションデータセンターを提供します。お客様が革新的な製品設計をできるエンドツーエンドのエンジニアリングシミュレーションプロセスをサポートする上で非常に重要である豊富なインタラクティブグラフィックスエクスペリエンスを提供します。Elastic GPUにより、ANSYSは顧客が求める価格と性能に適したサイズにてこのエクスペリエンスをより簡単に提供することができます。私たちはANSYSアプリケーションがElastic GPU上で動作することを認証し、お客様がクラウド上でより効率的に革新を行うことを可能にします。

ANSYS Enterprise Cloud は、AWSに最適化された仮想シミュレーションデータセンターを提供します。お客様が革新的な製品設計をできるエンドツーエンドのエンジニアリングシミュレーションプロセスをサポートする上で非常に重要である豊富なインタラクティブグラフィックスエクスペリエンスを提供します。Elastic GPUにより、ANSYSは顧客が求める価格と性能に適したサイズにてこのエクスペリエンスをより簡単に提供することができます。私たちはANSYSアプリケーションがElastic GPU上で動作することを認証し、お客様がクラウド上でより効率的に革新を行うことを可能にします。

Siemens PLMの Bob Haubrock (VP of NX Product Management) からもコメントを頂いています:

Elastic GPUは、クラウドにおけるCAD(Computer Aided Design)のゲームチェンジャーです。Elastic GPUを使用することで、プロフェッショナルグレードのグラフィックスを使用して Siemens PLM NX をAmazon EC2上で実行できるようになり、AWSが提供する柔軟性、セキュリティ、グローバルスケールを活用できます。 Siemens PLMは、EC2 Elastic GPUプラットフォームでのNXを認証し、お客様の設計とエンジニアリングの革新の境界を広げるお手伝いをすることに興奮しています。

Elastic GPUは、クラウドにおけるCAD(Computer Aided Design)のゲームチェンジャーです。Elastic GPUを使用することで、プロフェッショナルグレードのグラフィックスを使用して Siemens PLM NX をAmazon EC2上で実行できるようになり、AWSが提供する柔軟性、セキュリティ、グローバルスケールを活用できます。 Siemens PLMは、EC2 Elastic GPUプラットフォームでのNXを認証し、お客様の設計とエンジニアリングの革新の境界を広げるお手伝いをすることに興奮しています。

新たな認証プログラム

ソフトウェアベンダーや開発者のアプリケーションがElastic GPUやGPUベースのサービスをフルに活用できるよう、本日、AWS Graphics Certification Programを開始します。 このプログラムは、サポートされているインスタンスとGPUタイプの組み合わせにおいてアプリケーションを迅速かつ自動的にテストするためのクレジットとツールを提供します。

Stay Tuned

いつもの通り、利用可能になりましたら、すぐに追加の情報を共有します!

開発者プレビュー ー EC2 Instances (F1) with Programmable Hardware

カスタムハードウェアベースのソリューションへの興味深いルートの1つとして、フィールドプログラマブルゲートアレイ(FPGA)が知られています。 単一の機能を念頭に置いて設計され、実装するために配線された専用チップとは対照的に、FPGAはより柔軟性があります。 これは、PCボード上のソケットに差し込まれた後、フィールドでプログラムすることができます。 各FPGAには、固定された有限個の単純な論理ゲートが含まれています。 FPGAをプログラミングするということは、論理機能(AND、OR、XORなど)または記憶素子(フリップフロップおよびシフトレジスタ)を単純に接続していく事となります。 本質的にシリアル(いくつかのパラレル要素)で、固定サイズの命令とデータパス(通常32または64ビット)を持つCPUとは異なり、FPGAは多くのオペレーションを並列に実行するようにプログラムでき、 ほとんどすべてのデータ幅、データ大小を操作できます。

カスタムハードウェアベースのソリューションへの興味深いルートの1つとして、フィールドプログラマブルゲートアレイ(FPGA)が知られています。 単一の機能を念頭に置いて設計され、実装するために配線された専用チップとは対照的に、FPGAはより柔軟性があります。 これは、PCボード上のソケットに差し込まれた後、フィールドでプログラムすることができます。 各FPGAには、固定された有限個の単純な論理ゲートが含まれています。 FPGAをプログラミングするということは、論理機能(AND、OR、XORなど)または記憶素子(フリップフロップおよびシフトレジスタ)を単純に接続していく事となります。 本質的にシリアル(いくつかのパラレル要素)で、固定サイズの命令とデータパス(通常32または64ビット)を持つCPUとは異なり、FPGAは多くのオペレーションを並列に実行するようにプログラムでき、 ほとんどすべてのデータ幅、データ大小を操作できます。

今日、新しいF1インスタンスの開発者向けプレビューを開始します。 あなた自身のためにアプリケーションとサービスを構築するだけでなく、 AWS Marketplaceで販売して再利用するためにパッケージ化することができます。 すべてをまとめることで、かつてはFPGA駆動アプリケーション利用の前提条件であった資本集約かつ時間のかかるステップをすべて避けることができ、 他のソフトウェアに使用されているビジネスモデルと同様にする事ができます。 あなた自身のロジックを設計し、クラウドベースのツールを使ってそれをシミュレートして検証し、それを数日で市場に出すことができます。

- Xilinx UltraScale+ VU9P (16 nm製造プロセス)

- 288bit幅のバスをもった64 GiBのECC機能付きメモリを搭載 (4つのDDR4 channels)

- CPUへの専有PCIe x16インターフェースをサポート

- 約2.5億のロジックエレメント

- 約6,800のDigital Signal Processing (DSP) エンジン

- デバッグ用仮想JTAGインターフェース

複数のFPGAを搭載したインスタンスの場合、専用のPCIeファブリックを使用すると、FPGAが同じメモリアドレス空間を共有し、各方向に最大12 GbpsのPCIeファブリックを介して相互に通信できます。 インスタンス内のFPGAは、低レイテンシ、高帯域幅通信用の400 Gbps双方向リングへのアクセスを共有します(この高度な機能を利用するには独自のプロトコルを定義する必要があります)。

FPGA開発プロセス

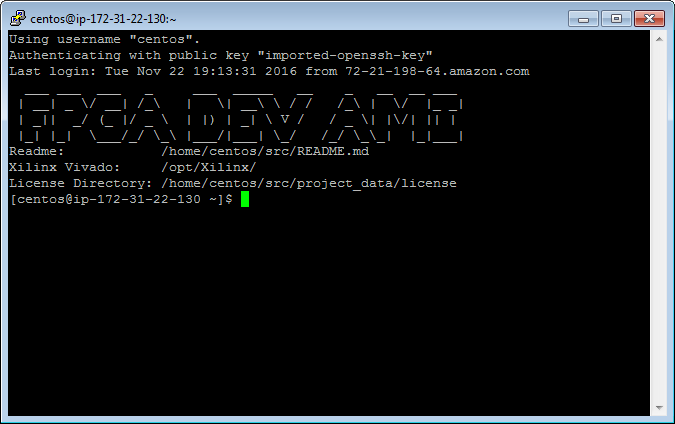

開発者プレビューの一環として、FPGA開発者のAMIも利用可能です。 このAMIは開発およびシミュレーション用で、メモリ最適化インスタンスまたはコンピューティング最適化インスタンスで起動し、F1インスタンスを使用して最終的なデバッグおよびテストを行うことができます。

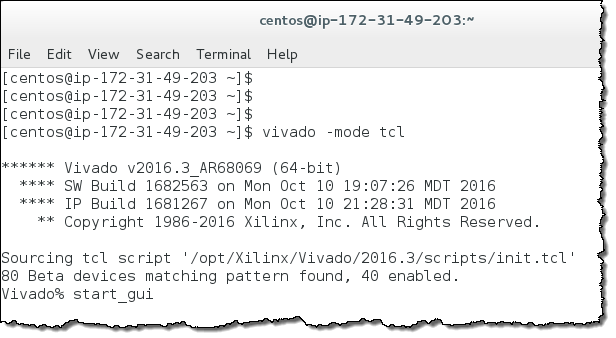

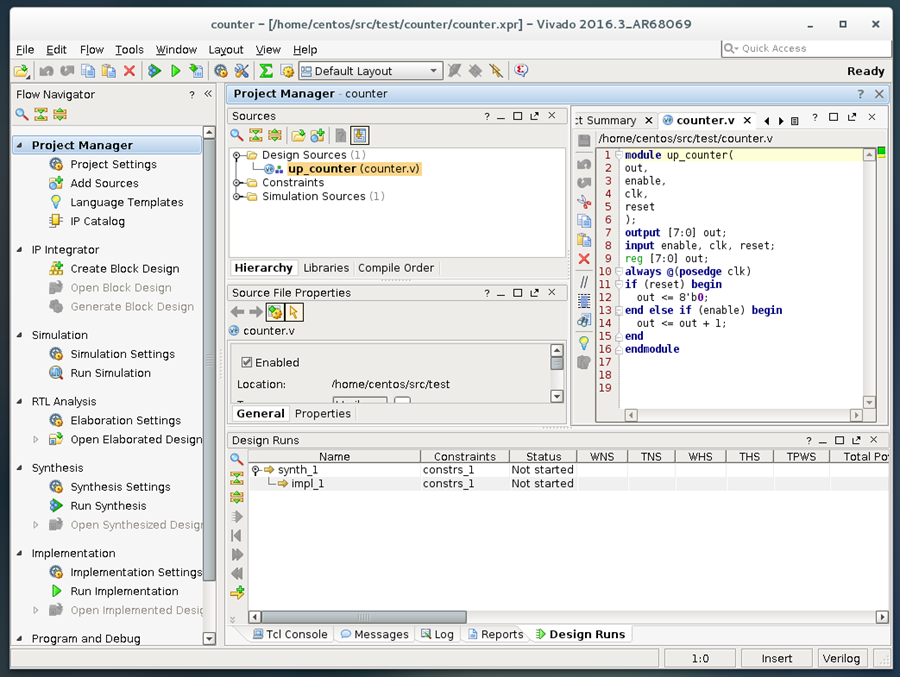

このAMIには、無料でAWS Cloudで使用できる一連の開発ツールが含まれています。 VHDLまたはVerilogを使用してFPGAコードを作成し、 Xilinx Vivado Design Suiteのツールを使用してコンパイル、シミュレート、および検証を行います(サードパーティシミュレータ、高級言語コンパイラ、グラフィカルプログラミングツール、およびFPGA IP librariesも使用できます)。

単純な8ビットカウンタのVerilogコードは次のとおりです。

module up_counter(out, enable, clk, reset);

output [7:0] out;

input enable, clk, reset;

reg [7:0] out;

always @(posedge clk)

if (reset) begin

out <= 8'b0;

end else if (enable) begin

out <= out + 1;

end

endmodule

これらの言語は、しばしばCのような構文を使用して記述されていますが(その為コードのスタイライズを使用しています)、既存のコードを使用してFPGAで再コンパイルできることを意味している訳ではありません。 代わりに、FPGAプログラミングモデルの理解を深め、ブール代数を学び、伝播遅延やクロックエッジなどを学び始める必要があります。 これを基盤として、お客様の環境でのFPGA利用を考え始めることができます。これがあなたにとってレイヤーが低すぎる場合は、OpenCLを含む多くの既存のHigh Level Synthesisツールを使用してFPGAをプログラミングすることができます。

インスタンスを起動した後、ログインしてパッケージをインストールし、ライセンスマネージャをセットアップしてVivadoツールを実行できるようにしました。 それから、デスクトップにRDP接続し、ターミナルウィンドウを開き、GUIモードでVivadoを起動しました:

サンプルプロジェクト(counter.xpr)を開き、FPGAをどのように設計し、プログラムするかを見てみました。

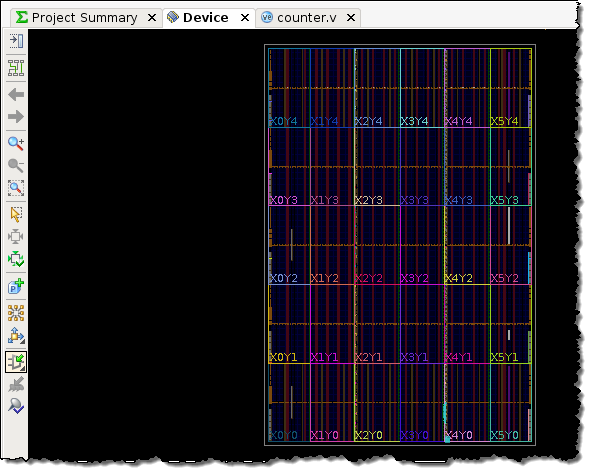

少しの調査の後、私は最初のFPGAを合成しました(この時点では興味がある要素をクリックしたにすぎず、私は初心者でさえありません)。

ここから、自分のデザインをテストし、Amazon FPGA Image(AFI)としてパッケージ化し、それを自分のアプリケーションに使用したり、AWS Marketplaceにリストすることができます。 数週間以内にこれらのことをすべて行う方法を示せるようにしたいと思っています。

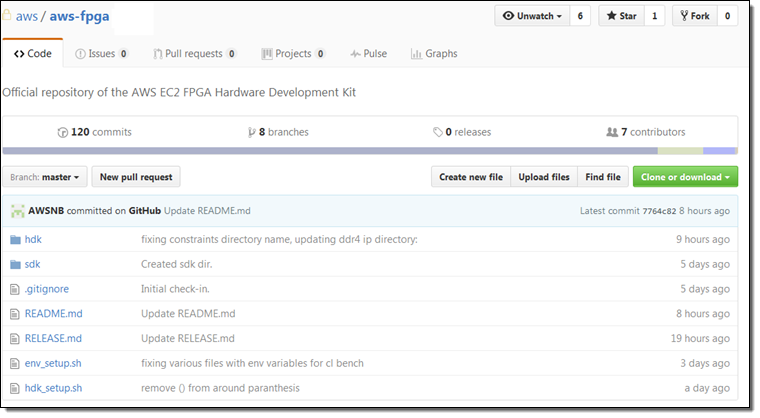

F1ハードウェア開発キット

私がF1インスタンスについて学んだ後、最初の質問の1つは、FPGA、CPU、およびメインメモリ間におけるインターフェイスの関係でした。 F1ハードウェア開発キット(HDK)には、ホストからFPGA、FPGAからメモリ、FPGAからFPGAを含む複数の通信方式用に事前設定されたI / Oインターフェイスとサンプルアプリケーションが含まれています。 また、コンパイルスクリプト、リファレンス例、およびフィールド内デバッグツールセットも含まれています。

最後に

ここで重要な点は、F1インスタンス、クラウドベースの開発ツール、およびFPGAによるアプリケーションの販売が可能であること、その組み合わせがユニークで強力であることです。 AWSのすべてのユーザは、FPGAモデルのパワーと柔軟性を利用できるようになりました。私は、これがまったく新しいタイプのアプリケーションやビジネスに影響を与えると確信しています。

今日から始められます

先に述べたように、本日より米国東部(バージニア北部)リージョン(2017年の早期にインスタンスが一般公開された後、複数の地域に展開する予定です)にて開発者プレビューを開始します。以前にFPGAのプログラミング経験がある、もしくは始めることに興味がある場合は、今すぐサインアップしてください。

EC2インスタンスタイプのアップデート – T2, R4, F1, Elastic GPUs, I3, C5

今朝早くに、AWSのCEOであるAndy Jassyが次のアップデートとなるEC2インスタンスのロードマップを発表しました。私たちは高I/O、コンピューティング最適化、メモリ最適化インスタンスの性能を向上させるとともに、FPGAベースのコンピューティングを含めたハードウェアアクセラレーションの領域にも進出します。この投稿では本日の発表をまとめるとともに、追加情報を含むそのほかの投稿たちへのリンクを示します。

これらの新しいインスタンスを計画するにあたって、お客さまが直面している問題やEC2で実行しようとしているワークロードについて十分に理解するために、私たちは非常に多くの時間を費やしました。お客さまの反応はさまざまでしたが、頻繁に言及されていたのはインメモリ分析、マルチメディア処理、機械学習(最新のAVX-512命令を用いたもの)、そして大規模でストレージ集積型のERP(Enterprise Resource Planning)アプリケーションなどでした。

次のインスタンス群が本日から利用可能です。

新しいF1インスタンス – F1インスタンスによって、Field-Programmable Gate ArrayまたはFPGAとして知られる、革新的なプログラマブルハードウェアを使用することができます。コードを記述してFPGA上で実行することにより、多くのゲノム分析、地震分析、財務リスク分析、ビッグデータ検索、そして暗号アルゴリズムなどの多くの処理を最大30倍高速化することができます。また本日、F1インスタンスの開発者プレビューおよびハードウェア開発キットをリリースしただけでなく、お客様がFPGAによるアプリケーションやサービスを構築して、AWSマーケットプレイスで販売することもできるようになりました。詳細については開発者プレビュー ー EC2 Instances (F1) with Programmable Hardwareをご覧ください。

新しいR4インスタンス – R4インスタンスは、昨今のメモリインテンシブなビジネスインテリジェンス、インメモリキャッシング、そしてデータベースアプリケーションのために設計されており、最大488GiBのメモリを搭載しています。R4インスタンスは大きなL3キャッシュと高速なメモリスピードにより、R3インスタンスより高い性能を発揮します。ネットワークの観点では、プレイスメントグループで使用した場合に、12Gbpsの専有EBS帯域幅に加えて、ENAによる最大20Gbpsのネットワーク帯域幅をサポートします。インスタンスは6つのサイズがあり、最大64個のvCPUと488GiBのメモリを選択できます。詳細については次世代のメモリ最適化EC2インスタンス(R4)をご覧ください。

拡張されたT2インスタンス – T2インスタンスはCPUの最大出力を定常的に使わないタイプのワークロードで、大きなパフォーマンスを発揮します。お客さまはT2インスタンスを、アプリケーションサーバやWebサーバ、開発環境、継続的インテグレーションサーバ、そして小規模のデータベースといった、さまざまなワークロードで利用されます。私たちはt2.xlarge(16GiBメモリ)とt2.2xlarge(32GiBメモリ)の2つを新たに加えます。既存のT2インスタンスと同様、新しいサイズも十分なベースラインパフォーマンス(既存のインスタンスに比べて最大4倍)に加えて、コンピューティングパワーが必要なときに全コアをバーストさせることができます。詳細については、新しいT2.XlargeとT2.2Xlargeインスタンスをご覧ください。

そして以下のインスタンス群については準備中です。

新しいElastic GPUs – まもなく既存のEC2インスタンスに対して、1GiBから最大8GiBのGPUメモリと、それに見合うコンピューティングパワーを持った、高パフォーマンスのグラフィックアクセラレーション機能を追加できるようになります。Amazonにより最適化されたOpenGLライブラリは、自動でElastic GPUsを検知します。この新たなEC2インスタンスのプレビューを発表するのに合わせて、AWS Graphic Certification Programを提供します。詳細については進行中 – Amazon EC2 Elastic GPUsをご覧ください。

新しいI3インスタンス – I3インスタンスは、Solid State Driveをベースとして高速で低レイテンシの不揮発性メモリ(Non Volatile Memory Express: NVMe)を搭載しています。4KBブロックサイズに対する最大330万のランダムIOPSと、最大16GB/秒のディスクスループットがあります。このインスタンスは、多くのI/Oインテンシブなリレーショナル&NoSQLデータベース、トランザクション処理、分析ワークロードで要求される水準を満たすように設計されています。I3インスタンスには6つのサイズがあり、最大64個のvCPUと488GiBのメモリ、そして15.2TBのストレージ(ERPアプリケーションに最適です)を選択できます。ストレージに保存されたすべてのデータは、保存時に暗号化されます。また新しいElastic Network Adapter(ENA)もサポートしています。

新しいC5インスタンス – C5インスタンスは、インテルの新しいXeon “Skylake” プロセッサをベースとしており、ほかのすべてのEC2インスタンスよりも高速な処理を行うことができます。Broadwellの後継として、SkylakeはAVX-512をサポートしているため、高度な浮動小数点演算を必要とする機械学習、マルチメデイア処理、科学計算、そして金融業務などに適しています。C5インスタンスには6つのサイズがあり、最大72個のvCPUと144GiBのメモリを選択できます。ネットワークの観点では、ENAをサポートするとともに、デフォルトでEBS最適化となっています。

原文: EC2 Instance Type Update – T2, R4, F1, Elastic GPUs, I3, C5(翻訳: SA 志村)

次世代のメモリ最適化EC2インスタンス(R4)

インメモリプロセッシングには大きな需要があります。日ごとに大きくなるワークロードと、世代を経るごとにパワーを増すCPUのおかげもあり、高性能のビジネスインテリジェンス、分析、データマイニング、そしてレイテンシに敏感なその他のワークロードにおいて、データセットを丸ごとメモリに載せることが、前提条件となりつつあります。分散キャッシングとバッチ処理ワークロードもまた、大量のメモリに素早くアクセスできることの恩恵を受けるでしょう。

私たちは本日、次世代のメモリ最適化EC2インスタンスをリリースします。大きなL3キャッシュと高速なメモリを搭載することで、既存のR3インスタンスより高い性能を発揮します。ネットワークの観点では、プレイスメントグループで使用した場合に、1Gbpsの専有EBS帯域幅に加えて、ENAによる最大20Gbpsのネットワーク帯域幅をサポートします。

R4インスタンスには以下の特徴があります。

- インテル Xeon E5-2686 v4 “Broadwell” プロセッサ(2.3GHz)

- DDR4メモリ

- ハードウェア仮想化(HVM)のみ

ラインナップは次の通りです。

| モデル | vCPUs | メモリ(GiB) | ネットワークパフォーマンス |

| r4.large | 2 | 15.25 | 最大10 Gigabit |

| r4.xlarge | 4 | 30.5 | 最大10 Gigabit |

| r4.2xlarge | 8 | 61 | 最大10 Gigabit |

| r4.4xlarge | 16 | 122 | 最大10 Gigabit |

| r4.8xlarge | 32 | 244 | 10 Gigabit |

| r4.16xlarge | 64 | 488 | 20 Gigabit |

R4インスタンスはオンデマンドインスタンスとリザーブドインスタンスの形で、米国東部(バージニア北部)、米国東部(オハイオ)、米国西部(オレゴン)、米国西部(北カリフォルニア)、欧州(アイルランド)、欧州(フランクフルト)、アジアパシフィック(シドニー)、中国(北京)、そしてAWS GovCloud (US) リージョンにおいて利用可能です。詳細はEC2の料金ページをご覧ください。

原文:New – Next Generation (R4) Memory-Optimized EC2 Instances(翻訳:SA 志村)

EC2 値下げ (C4、M4、そしてT2インスタンスで) 東京リージョンも!

2016年12月1日からEC2の価格を下げるアナウンスをできることを非常に嬉しく思っています。これで皆さんの年末シーズンがすこし楽しくなることでしょう!我々の技術に対する投資と、規模と長年のキャパシティ管理の経験に基いて、コストを抑えることができることになりましたので、皆さんにお伝えします。

我々は、オンデマンド、リザーブドインスタンス (標準もコンバーチブルも)、そして専有ホストの価格を、C4、M4、そしてT2インスタンスにおいて、最大25%の値下げを致します。値下げは全てのAWSリージョンで適応されます。以下に一例としてLinuxタイプのオンデマンドインスタンス料金を示します(全リージョンで値下げは行われます):

- C4 – アメリカ東部(北部バージニア)とEU(アイルランド)とアジア太平洋(東京)で最大5%削減、アジア太平洋(ムンバイ)とアジア太平洋(シンガポール)では最大20%削減

- M4 – アメリカ東部(北部バージニア)とEU(アイルランド)とEU(フランクフルト)で最大10%削減、アジア太平洋(東京)では最大20%削減、アジア太平洋(シンガポール)では最大25%削減

- T2 – アメリカ東部(北部バージニア)では最大10%削減、アジア太平洋(東京)で最大20%削減、アジア太平洋(シンガポール)では最大25%削減

※訳注: オンデマンドとリザーブドインスタンス、またリージョンやプラットフォーム(Linux、RHEL、SUSE、Windows等)によって値下げ率は異なります。価格が据え置きとなっているリザーブドインスタンスタイプもありますので、詳細は料金表を確認ください。

いつものことですが、オンデマンド価格でこの値下げの利益を得るために、皆さんがすべきことは何もありません。もし請求アラートや、新しくなった予算機能を使っているなら、閾値を適切に引き下げることを検討した方が良いかもしれません。

— Jeff

追伸 – 私の計算では、これが我々の53回目の値下げとなります。

原文: EC2 Price Reduction (C4, M4, and T2 Instances) (翻訳: SA岩永)

※訳注: 原文には東京リージョンへの言及が特別にありませんが、今回の値下げは全てのリージョンが対象のため、東京リージョンの価格変更情報も追記しています。

C2 の汎用 SSD (gp2) ボリュームの新しいバーストバランスメトリックス

AWS ユーザーの多くが、2014 年の中半期にリリースした汎用 SSD (gp2) EBS ボリュームを使用して素晴らしい成果を得ています (詳しくは New SSD-Backed Elastic Block Storage をご覧ください。ご自分のワークロードでどのタイプのボリュームを使用すべきか決めかねている場合は、幅広い種類のデータベース、開発とテスト、ブートボリュームのワークロードにわたり価格とパフォーマンスのバランスが取れている gp2 をお勧めします。このボリュームタイプで興味深いポイントの 1 つはバースト機能です。gp2 のバースト機能は AWS の顧客ベースを観察し、実社会におけるワークロードの I/O パターンに合わせて設計されました。AWS のデータサイエンティスト達は、ボリューム I/O は非常にバースト性が高く短時間で急上昇し、バースト間には十分なアイドル時間があることに気付きました。予測不可能でバースト性を持つトラフィックの性質が gp2 バーストバケットを設計した理由です。小さなボリュームでも 3000 IOPS までのバーストを可能にするほか、アイドル時間中または低レベルで I/O を実行している場合にバーストバケットを補充できるようにすることができます。バーストバケットの設計はすべての gp2 ユーザーに一貫性のある予測可能なパフォーマンスを提供します。実際には gp2 ボリュームが完全にバーストバケットを消耗することは非常に少なく、ユーザーは使用パターンをトラッキングし必要に応じて調整できるようになりました。さまざまなボリュームタイプのパフォーマンス最適化と、ベンチマークと実際のワークロードの違いに関するドキュメントはすでに提供済みです (詳しくは I/O Characteristics をご覧ください)。最初のブログ投稿で説明したように、バーストクレジットは設定済み GB/秒ごとに 3 倍の割合で蓄積し、読み取りまたは書き込み 1 回ごとに 1 つ使用されるようになっています。各ボリュームは 540 万クレジットまで蓄積することができ、ボリュームごとに 3,000 クレジット/秒の割合で使用することができます。使用を開始するには希望するサイズの gp2 ボリュームを作成し、アプリケーションを起動します。ボリュームの I/O は可能な限り迅速かつ効率的に作業を進めます。

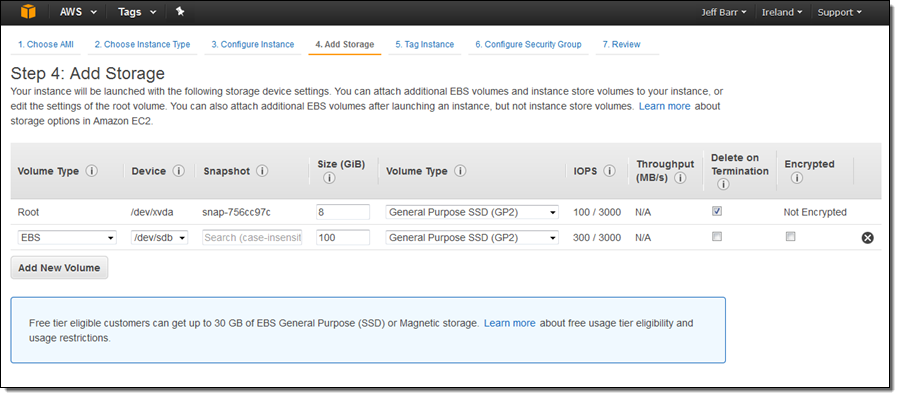

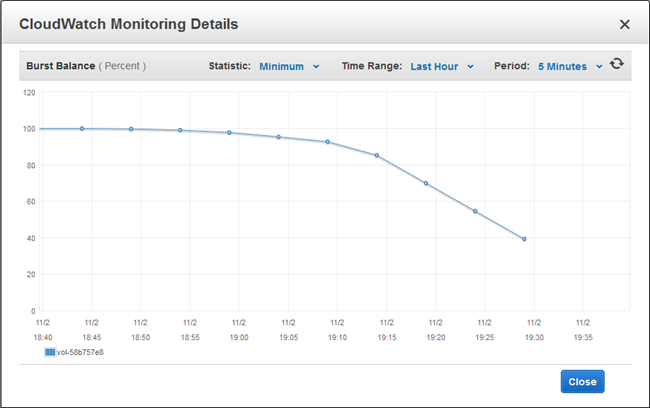

新しいメトリックスは本日よりご利用いただけます。バーストバランスメトリックスは各汎用 (SSD) ボリュームで使用可能です。このメトリックスは CloudWatch コンソールで確認することができます。残りが少なくなるとアラームを発信するように設定することも可能です。このメトリックスはパーセントで表示されます。つまり 100% はボリュームが蓄積できるクレジット最大数に到達していることを意味します。この例では c4.8xlarge インスタンスを起動し 100 GB ボリュームをアタッチしました。

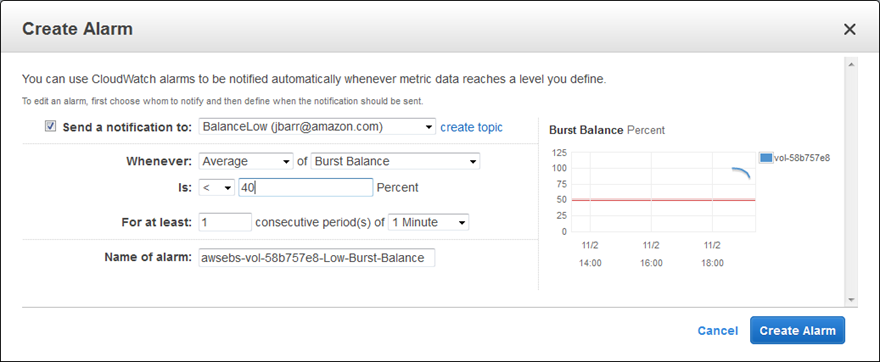

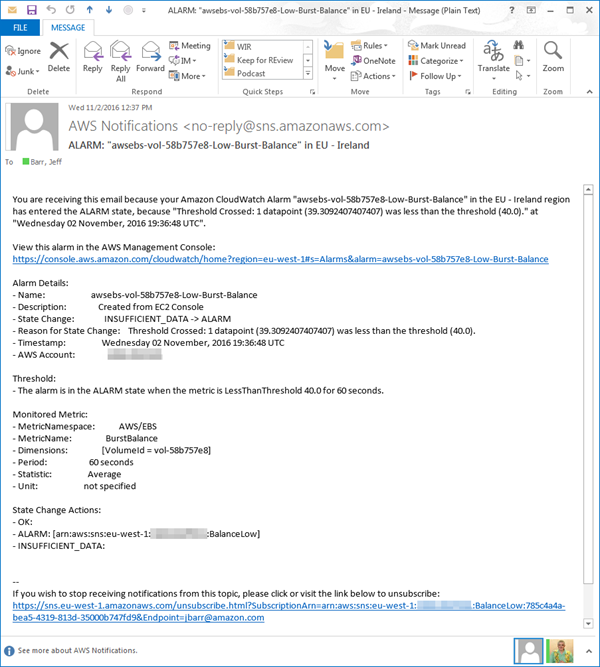

次にボリュームのバーストバランスが 40% 以下になった場合に通知を送信するよう、アラームを作成します (実際にはこの数値を大幅に下げることをお勧めしますが、バランスを低下させるには結構な時間がかかるので、ここではこの数値で設定しました)。

SNS サブスクリプションを確認し fio を実行してロードを生成します。

$ sudo fio --filename=/dev/sdb --rw=randread --bs=16k --runtime=2400 --time_based=1 \

--iodepth=32 --ioengine=libaio --direct=1 --name=gp2-16kb-burst-bucket-testバランスが低下していくのを観察します。

予想通り通知メールが届きました。

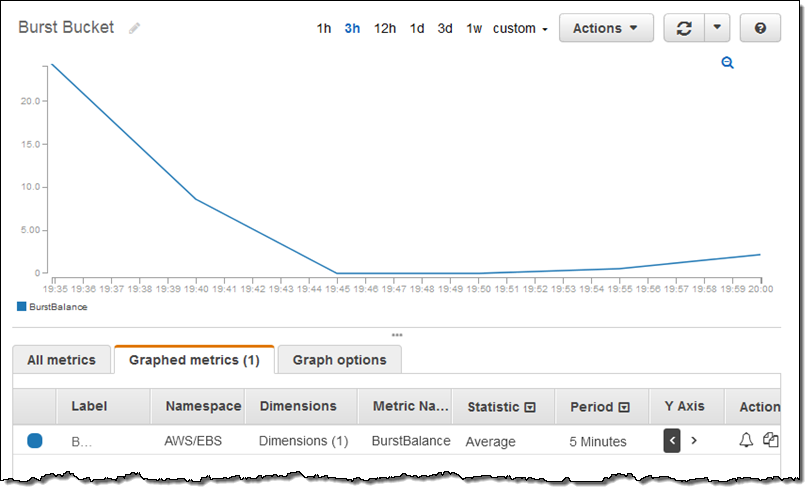

本稼働の状況ではボリュームのサイズを上昇させたり、アプリケーションの I/O の動作を細かく設定したり、バーストバケットをうまく活用していることをメモすることもできます。テスト終了後はランチを取りながらバーストバランスが上昇するのを観察しました (今回は更新済みの CloudWatch コンソールを使用しました)。

稀ではありますが、バーストバケットの消耗が予想以上に早いという場合は、gp2 ボリュームのサイズを上げてパフォーマンスを高めるか、99.9% の確率で一貫性を持つプロビジョンドパフォーマンスを提供するプロビジョンド IOPS SSD (io1) ボリュームに移行することもできます。

今すぐ利用可能

この機能は今すぐすべての AWS 商用リージョンでご利用いただけます。追加費用はありません。CloudWatch アラームには通常の料金が適用されます。

— Jeff;

PS – このようなシステムを構築してみたいという開発者、開発マネージャー、プロダクトマネージャーの方は EBS Jobs ページをご覧ください。クラウドおよびオンプレミスワークロード用の新しい Amazon Linux Container Image

The Amazon Linux AMI は、EC2 上で実行しているアプリケーションにセキュアで安定した、高パフォーマンスの実行環境を提供します。リモートアクセスが制限され (ルートログインや必須の SSH キーペアがない)、重要でないパッケージがほとんどインストールされていない AMI は、優れたセキュリティプロフィールを誇ります。

The Amazon Linux AMI は、EC2 上で実行しているアプリケーションにセキュアで安定した、高パフォーマンスの実行環境を提供します。リモートアクセスが制限され (ルートログインや必須の SSH キーペアがない)、重要でないパッケージがほとんどインストールされていない AMI は、優れたセキュリティプロフィールを誇ります。

たくさんの顧客から、この Linux イメージをオンプレミスで、特に開発ワークロードやテストワークロードの中で使用したいというリクエストがありました。

クラウドとオンプレミスでの使用に適した Amazon Linux Container Image の提供開始を今日発表することができ、光栄です。イメージは EC2 コンテナレジストリから入手できます (アクセス方法については、イメージの入手をお読みください)。AMI と同じソースコード、同じパッケージで構築されているため、コンテナの導入がスムーズに実行できます。そのままで使用することも、独自のイメージを作成するための土台として使用することもできます。

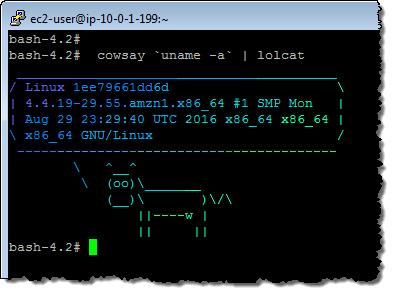

それを試してみるため、私は、作成したばかりの EC2 インスタンスを起動し、Docker をインストールし、新しいイメージを入手して実行してみました。その後、cowsay と lolcat (と依存関係) をインストールし、上記のイメージを作成しました。

このイメージの詳細については、Amazon Linux Container Image をお読みください。

このイメージは、Amazon EC2 Container Service で使用することもできます。詳細については、Amazon ECR イメージを Amazon ECS で使用するをお読みください。

— Jeff;

新しいユーティリティ – すべてのリージョンで長いリソース ID 形式にオプトイン

今年はじめに公開したブログ「長い形式の EC2 リソース ID が利用可能に」で、移行期間は 2016 年 12 月の初旬までと説明しました。この期間中はリージョンやユーザーベースで新しいリソース形式にオプトインすることができます。移行を完了すると、新たに作成したリソースの文字列には 17 文字が使用されるようになります。次の大切な日付を忘れないようにしてください。

- 11 月 – 11 月 1 日より

describe-id-formatコマンドを使用して希望のリージョンのカットオーバー期限を確認できるようになります。 - 12 月 – 12 月 5 日から 12 月 16 日の間、各 AWS リージョンにおいて 17 文字の文字列をデフォルトで使用するように設定します。

ご利用されているコードやツールが新しい形式に対応できるように、できる限り早急にオプトインすることをお勧めします。

オプトイン、オプトアウト、またはステータスチェックに使用できる長い形式の ID コンバーターツールをリリースしました。すでに AWS Command Line Interface (CLI) をインストールしている場合は、スクリプトをダウンロードすればこれを実行することができます。

$ wget https://raw.githubusercontent.com/awslabs/ec2-migrate-longer-id/master/migratelongerids.py

$ chmod +x migratelongerids.py

次に実施可能な操作をいくつかご紹介します。

アカウントのステータスを確認:

$ ./migratelongerids.py --statusアカウント、IAM ロール、IAM ユーザーを長い形式の ID に変換:

$ ./migratelongerids.py短い形式の ID に戻す:

$ ./migratelongerids.py --revert現在のユーザー/ロールを変換:

$ ./migratelongerids.py --convertselfこのユーティリティに関する詳細については「README」ファイルをご覧ください。長い形式の ID への移行に関する詳細情報は「EC2 のよくある質問」をご覧ください。

— Jeff;

Amazon EC2 で Windows Server 2016 を実行

Amazon Elastic Compute Cloud (EC2) で Windows Server 2016 を実行できるようになりました。このバージョンの Windows Server にはいくつもの新機能が搭載されています。これには Docker や Windows コンテナのサポートも含まれています。本日より、すべての AWS リージョンで次の 4 つの形式をご利用いただけます。

- Windows Server 2016 Datacenter のデスクトップ環境 – Windows Server のメインストリームバージョンはセキュリティとスケーラビリティを考慮して設計されています。従来のアプリケーションはもちろんのこと、クラウドネイティブのアプリケーションにも対応しています。Windows Server 2016 に関する詳細は「The Ultimate Guide to Windows Server 2016」 (登録必須) をご覧ください。

- Windows Server 2016 の Nano Server – 最小構成のインストールで導入するクラウドネイティブは適度なディスク容量を使用し、アプリやサービス実行に使用するシステムリソース (メモリ、ストレージ、CPU) をより多く残し、データセンターバージョンよりも迅速に起動することができます。コードやアプリケーションを移行する場合の詳細情報については「Moving to Nano Server」をご覧ください。Nano Server にはデスクトップ UI が含まれていないので、PowerShell または WMI を使用してリモートから管理する必要があります。手順については「Windows Server 2016 の Nano Server インスタンスに接続するには」をご覧ください。

- Windows Server 2016 のコンテナ – Windows Server 2016 の Windows コンテナと Docker をインストールしています。

- Windows Server 2016 の SQL Server 2016 – Windows Server 2016 の SQL Server 2016 をインストールしています。

EC2 で実行する Windows Server 2016 の注意事項については次をご覧ください。

- メモリ – Microsoft は Windows Server で少なくても 2GiB のメモリを確保することを推奨しています。EC2 インスタンスタイプを確認してご自分のアプリケーションに最適なタイプを探してください。

- 料金 – Windows EC2 料金表の基本価格が適用されます。オンデマンドやスポットインスタンスを起動しリザーブドインスタンスを購入することができます。

- ライセンス – AWS で自分のライセンスを使用 (Microsoft のライセンス条項を適用) することができます。

- SSM エージェント – EC2Config の代わりに SSM エージェントのアップグレードバージョンを使用しています。詳しくはユーザーガイドをご覧ください。

コンテナ使用の実例

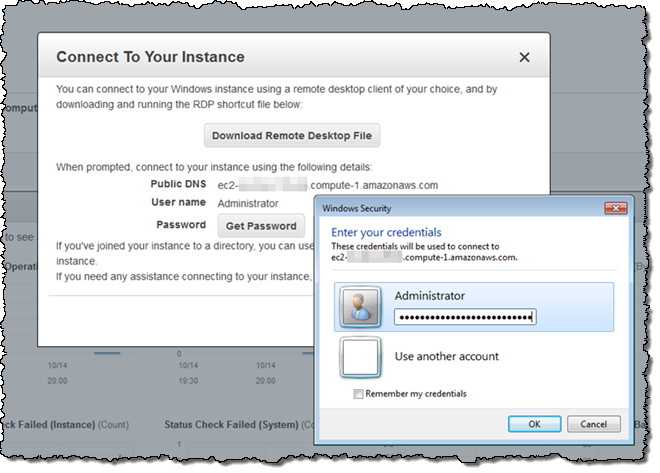

Windows Server 2016 のコンテナ AMI を起動し、いつものようにログインします。

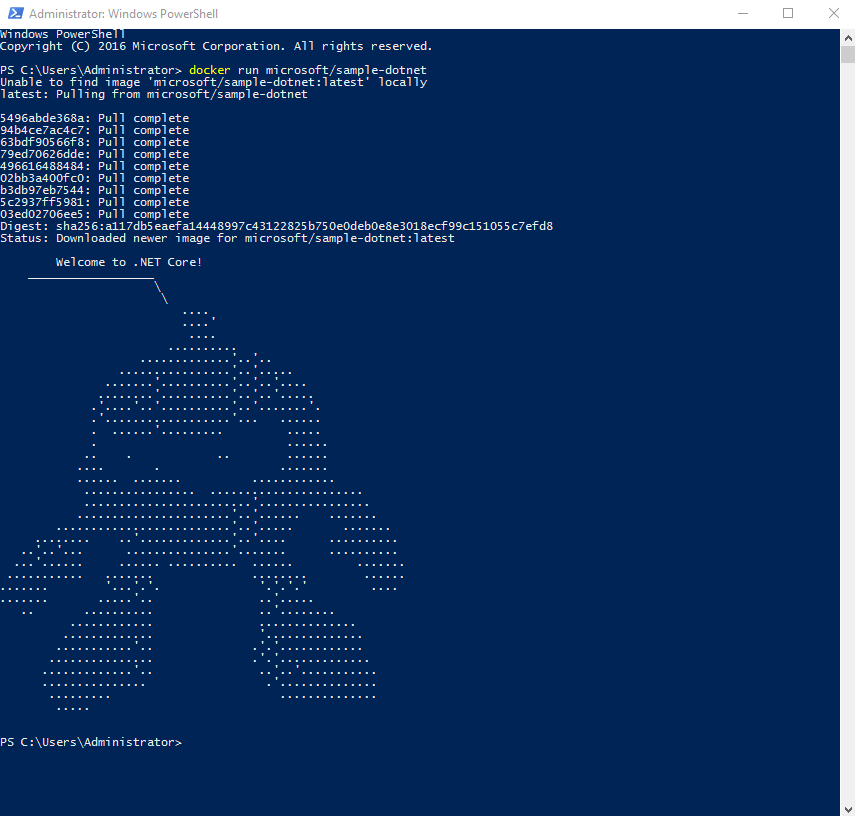

PowerShell を開き次のコマンドを実行します。 docker run microsoft/sample-dotnet . Docker がイメージをダウンロードして起動します。次が表示されます。

AWS は 2016 年末までに Windows コンテナを Amazon ECS に追加する予定です。詳しくはこちらから登録してください。

今すぐ始める

今日から EC2 で Windows Server 2016 を使用することができます。ぜひお試しください。皆様からのご感想をお待ちしています。

— Jeff;

X1 インスタンスの更新 – X1.16xlarge + リージョンの追加

今年初旬に AWS は x1.32xlarge インスタンスをリリースしました。約 2 TiB の容量を備えるこのインスタンスタイプは、メモリに大きな負担をかけるビッグデータ、キャッシュ、分析などのワークロードに最適です。AWS のお客様は SAP HANA インメモリデータベース、大規模な Apache Spark や Hadoop ジョブ、様々なタイプのハイパフォーマンスコンピューティング (HPC) ワークロードを実行しています。

そしてこの度、AWS は X1 インスタンスタイプの更新を 2 つリリースしました。

- 新しいインスタンスのサイズ – x1.16xlarge インスタンスの新しいサイズはフットプリントが小さいワークロードの実行を可能にします。

- 新しいリージョン – X1 インスタンスの利用が可能なリージョンを 3 つ追加しました。これでリージョン数は合計 10 になりました。

新しいインスタンスのサイズ

新しい x1.16xlarge の仕様は次のとおりです。

- プロセッサ: 2 x Intel™ Xeon E7 8880 v3 (Haswell) 2.3 GHz – 32 cores / 64 vCPUs で実行

- メモリ: Single Device Data Correction (SDDC+1) 使用の 976 GiB

- インスタンスストレージ: 1,920 GB SSD

- ネットワーク帯域幅: 10 Gbps

- 専用の EBS 帯域幅: 5 Gbps (追加料金なしで EBS の最適化)

x1.32xlarge のように、このインスタンスは Turbo Boost 2.0 (最大 3.1 GHz)、AVX 2.0、AES-NI、TSX-NI をサポートします。こうしたインスタンスは、オンデマンドインスタンス、スポットインスタンスまたは専有インスタンスとしてご利用いただけます。また、リザーブドインスタンスや Dedicated Host の予約を購入することもできます。

新しいリージョン

X1 インスタンスの両サイズは次のリージョンで利用可能です。

- US East (Northern Virginia)

- US West (Oregon)

- Europe (Ireland)

- Europe (Frankfurt)

- Asia Pacific (Tokyo)

- Asia Pacific (Singapore)

- Asia Pacific (Sydney)

- Asia Pacific (Mumbai) – New

- AWS GovCloud (US) – New

- Asia Pacific (Seoul) – New

— Jeff;